Wie man LLMs lokal betreibt: Vollständiger 2025 Leitfaden für selbst gehostete AI-Modelle

Die AI Die Revolution findet statt, aber Sie müssen Ihre sensiblen Daten nicht an Cloud-Dienste senden oder monatliche Abonnementgebühren zahlen, um davon zu profitieren. Wenn Sie große Sprachmodelle lokal auf Ihrem eigenen Computer ausführen, haben Sie die vollständige Kontrolle über Ihre KI-Interaktionen und können gleichzeitig den absoluten Datenschutz wahren und die laufenden Kosten vermeiden.

In diesem umfassenden Leitfaden erfahren Sie alles, was Sie brauchen, um llms lokal auszuführen, von der Auswahl der richtigen Tools und Modelle bis zur Optimierung der Leistung Ihrer Hardware. Egal, ob Sie ein Entwickler sind, der Unterstützung bei der Programmierung sucht, ein Unternehmen Schutz sensiblen Daten oder einem KI-Enthusiasten, der einen Offline-Zugriff wünscht, bieten lokale llms zwingende Vorteile gegenüber cloudbasierten Alternativen.

Wir stellen Ihnen die besten Tools für 2025 vor und zeigen Ihnen, welche Hardware-Anforderungen Sie erfüllen müssen, um die Bank, und Schritt-für-Schritt-Anleitungen, mit denen Sie Ihren ersten lokalen llm in wenigen Minuten zum Laufen bringen. Am Ende werden Sie verstehen, wie Sie die Leistung modernster Sprachmodelle nutzen können, ohne Ihre Privatsphäre oder Ihr Budget zu gefährden.

Was Sie lernen werden

- Was bedeutet “LLM lokal durchführen” und wie funktioniert es?

- Die Vorteile von selbst gehosteter KI gegenüber KI in der Cloud

- Die besten Werkzeuge von 2025 (LM Studio, Ollama, GPT4All, Jan, llamafile, llama.cpp)

- Hardwareanforderungen für Modelle von 2B bis 70B+ Parameter

- Wie Sie Ihr erstes Modell installieren und betreiben

- Wie man einen sicheren lokalen API-Server erstellt

- Praktische Anwendungsfälle für persönliche und geschäftliche Arbeitsabläufe

- Leistungstipps, Fehlersuche und Kostenvergleiche

Einführung in große Sprachmodelle

Große Sprachmodelle (LLMs) sind revolutionär künstliche Intelligenz Systeme, die die Interaktion mit Technologien verändern und die menschliche Sprache mit beispielloser Raffinesse verstehen, generieren und manipulieren können. Durch das Training auf riesigen Textdatensätzen liefern diese bahnbrechenden großen Sprachmodelle kohärente, kontextbewusste Antworten, die Ihre Arbeitsabläufe revolutionieren und sie für eine unglaubliche Bandbreite von Anwendungen unverzichtbar machen, von Chatbots und virtuellen Assistenten bis hin zu Sprachübersetzung, Textzusammenfassung und kreativer Inhaltserstellung, die Nutzer begeistert und zu Ergebnissen führt.

Die lokale Ausführung großer Sprachmodelle auf Ihrem eigenen Computer bietet außergewöhnliche Vorteile, mit denen Cloud-Dienste einfach nicht mithalten können. Wenn Sie LLMs lokal ausführen, behalten Sie die vollständige Kontrolle über Ihre sensiblen Daten und stellen sicher, dass vertrauliche Informationen niemals Ihr Gerät verlassen - ein Ansatz, bei dem der Datenschutz im Vordergrund steht und der Vertrauen schafft. Diese leistungsstarke Strategie erhöht nicht nur die Sicherheit und den Seelenfrieden, sondern beseitigt auch die Abhängigkeit von externen Anbietern und reduziert die wiederkehrenden Abonnementgebühren auf Null. Infolgedessen entscheiden sich clevere Einzelpersonen und vorausschauende Unternehmen dafür, LLMs lokal zu betreiben und die volle Leistungsfähigkeit dieser Modelle für alles von der Geschäftsautomatisierung bis hin zur persönlichen Produktivität zu nutzen, ohne Abstriche bei der Sicherheit zu machen oder laufende Kosten zu verursachen.

Ganz gleich, ob Sie mit modernsten Modellen experimentieren, benutzerdefinierte KI-gestützte Tools entwickeln, die Ihren Erfolg skalieren, oder ob Sie einfach nur ein privates und blitzschnelles KI-Erlebnis suchen: Durch die lokale Ausführung von LLMs haben Sie die Fähigkeiten modernster Sprachmodelle direkt in der Hand und können so schneller innovieren, sicher bleiben und außergewöhnliche Ergebnisse liefern.

Was bedeutet es, LLMs vor Ort durchzuführen?

Die lokale Ausführung großer Sprachmodelle bedeutet, dass Sie anspruchsvolle KI-Modelle direkt auf Ihrem eigenen Computer oder Ihrer lokalen Maschine betreiben, anstatt sich auf Cloud-Dienste wie ChatGPT, Claude oder Gemini zu verlassen. Wenn Sie llm lokal ausführen, findet der gesamte Inferenzprozess auf Ihrer eigenen Hardware statt, ohne dass Daten über das Internet an externe Server übertragen werden.

Zu den wichtigsten Vorteilen von local llms gehören der vollständige Datenschutz, keine Abonnementkosten nach der Ersteinrichtung und Offline-Funktionen, die ohne Internetverbindung funktionieren. Ihre sensiblen Daten verlassen nie Ihr Gerät. Das macht die lokale Inferenz besonders wertvoll für Unternehmen, die mit vertraulichen Informationen arbeiten, für Entwickler, die an geschütztem Code arbeiten, oder für Einzelpersonen, die sich um den Datenschutz sorgen.

Im Gegensatz zu Cloud-basierten KI-Diensten, die API-Schlüssel erfordern und pro Anfrage abrechnen, können Sie lokale Modelle unbegrenzt nutzen, sobald Sie das Modell von Repositories oder Quellen wie GitHub oder Hugging Face herunterladen und die Modelldatei auf Ihrem Computer speichern. Dadurch entstehen vorhersehbare Kosten und Sie müssen sich keine Sorgen machen, dass API-Tarifgrenzen oder Serviceausfälle Ihren Arbeitsablauf beeinträchtigen.

Ein praktischer Vergleich verdeutlicht den Unterschied: Bei der Verwendung von ChatGPT werden Ihre Fragen zur Verarbeitung an die Server von OpenAI weitergeleitet, bevor sie beantwortet werden. Bei einer lokalen KI wie Llama 3.2, die auf Ihrem Rechner läuft, geschieht alles auf Ihrer Consumer-Hardware. Während Cloud-Dienste Bequemlichkeit und hochmoderne Modelle bieten, bietet die lokale KI Privatsphäre, Kontrolle und Kostentransparenz, was viele Nutzer als sehr überzeugend empfinden.

Zu den weit verbreiteten Irrtümern gehört der Glaube, dass die lokale Ausführung von llms teure GPU-Hardware oder komplexe technische Einrichtungen erfordert. Moderne Tools wie LM Studio und GPT4All haben den Prozess erheblich vereinfacht, und viele kleinere Modelle laufen effektiv auf Standard-Desktop-Computern mit ausreichend RAM.

Einrichten einer lokalen Umgebung

Der Einstieg in lokale llms beginnt damit, dass Sie Ihren Computer in ein leistungsstarkes KI-Kraftpaket verwandeln, das Ihnen eine außergewöhnliche Leistung direkt zur Verfügung stellt. Der erste Schritt besteht darin, sicherzustellen, dass Ihr Betriebssystem, egal ob Windows, macOS oder Linux, die perfekte Grundlage für die innovativen Tools bildet, die Sie nutzen werden, wie LM Studio, Ollama oder GPT4All. Jede dieser bahnbrechenden Plattformen bietet einen optimierten, benutzerfreundlichen Ansatz für die Verwaltung und Interaktion mit lokalen Modellen und macht fortschrittliche KI für jeden zugänglich, auch für diejenigen, die ihre ersten Schritte in die aufregende Welt der KI machen. Welt der künstlichen Intelligenz.

Als Nächstes sollten Sie das Potenzial Ihrer Hardware ausschöpfen, um unglaubliche Leistungssteigerungen zu erzielen. Während viele kleinere Modelle auf Standard-Desktops oder -Laptops beeindruckende Ergebnisse liefern, können Sie mit einer modernen CPU, ausreichendem Arbeitsspeicher und idealerweise einem dedizierten Grafikprozessor auch größere, anspruchsvollere Modelle mit bemerkenswerter Laufruhe ausführen. Wenn Sie sicherstellen, dass Ihr System die Mindestanforderungen für das von Ihnen gewählte Tool und Modell erfüllt, können Sie sich auf unvergleichliche KI-Fähigkeiten einstellen.

Sobald Ihre Hardware und Ihr Betriebssystem perfekt aufeinander abgestimmt sind, können Sie das von Ihnen bevorzugte Tool installieren und der Entwicklung zuschauen. LM Studio zum Beispiel bietet eine intuitive grafische Oberfläche, die die Modellverwaltung mühelos vereinfacht, während Ollama eine Befehlszeilenfunktion bietet, die Entwicklern eine erweiterte Kontrolle ermöglicht. Nach der Installation können Sie kompatible Modelle direkt auf Ihrem lokalen Rechner durchsuchen, herunterladen und ausführen, so dass Sie die volle Kontrolle über Ihre KI-Erfahrung haben.

Durch die sorgfältige Auswahl des richtigen Tools und die fachmännische Konfiguration Ihrer Umgebung sind Sie mit allem ausgestattet, was Sie benötigen, um llms lokal auszuführen und das volle Potenzial der neuesten KI-Entwicklungen zu nutzen. Sie erhalten nicht nur lokale KI-Funktionen, sondern auch völlige Unabhängigkeit, verbesserten Datenschutz und eine blitzschnelle Leistung, die Ihre Arbeit mit künstlicher Intelligenz grundlegend verändert.

Schnellstart: Die besten Tools für die lokale Durchführung von LLMs im Jahr 2025

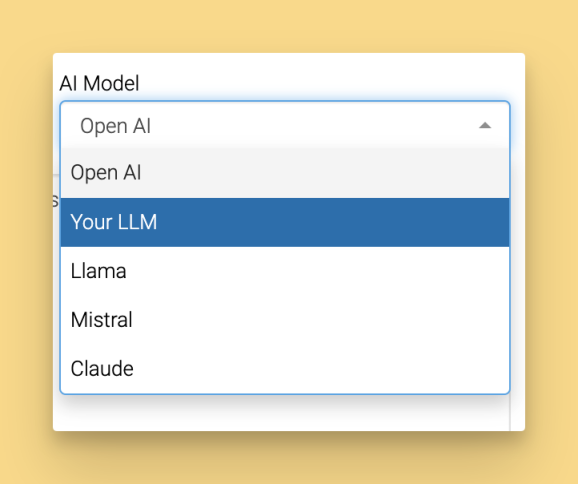

Die Landschaft der Tools für die lokale Ausführung von Llms hat sich dramatisch entwickelt und bietet benutzerfreundliche Optionen, die die meisten technischen Barrieren beseitigen. Im Folgenden finden Sie die fünf wichtigsten Plattformen, die Nutzern aller Qualifikationsniveaus die lokale Ausführung von Modellen ermöglichen, einschließlich des Zugangs zu beliebten Modellen wie Llama und DeepSeek R1 für die lokale Nutzung:

LM Studio zeichnet sich durch seine intuitive grafische Oberfläche und den integrierten Modellbrowser als einsteigerfreundlichste Option aus. Herunterladen von lmstudio.ai und genießen Sie nahtlose Modellverwaltung unter Windows 11, macOS Ventura+ und Ubuntu 22.04+.

GPT4All konzentriert sich auf KI, die den Schutz der Privatsphäre in den Vordergrund stellt, und bietet mit seiner LocalDocs-Funktion hervorragende Funktionen für den Dokumenten-Chat. Erhältlich unter gpt4all.io für alle gängigen Betriebssysteme, bietet es einen kuratierten Modellmarktplatz mit über 50 kompatiblen Modellen.

Jan bietet eine Open-Source-Alternative zu ChatGPT mit erweiterbarer Architektur und hybriden lokalen/cloud-Funktionen. Starten Sie unter jan.ai mit Unterstützung für benutzerdefinierte Erweiterungen und Remote-API-Integration.

Ollama ist das bevorzugte Kommandozeilentool für Entwickler und bietet eine einfache Modellverwaltung und eine hervorragende API-Integration. Die Installation von Ollama ist unkompliziert: Laden Sie das Installationsprogramm für Ihr Betriebssystem herunter, führen Sie es aus und folgen Sie den Anweisungen, um die Installation abzuschließen. Sobald Sie Ollama installiert haben, können Sie das Kommandozeilentool verwenden, um Modelle zu verwalten und auszuführen. Eine wichtige Funktion ist der Pull-Befehl, mit dem Sie bestimmte Modelle direkt über das Terminal herunterladen oder aktualisieren können, um sie sofort zu verwenden.

llamafile liefert portable AI in Form von ausführbaren Dateien, die ohne Installation überall ausgeführt werden können. Perfekt für schnelle Tests oder Einsatzszenarien, bei denen eine minimale Einrichtung entscheidend ist.

Für absolute Anfänger bietet LM Studio mit seiner visuellen Oberfläche und der automatischen GPU-Beschleunigung die reibungsloseste Einführungserfahrung. Entwickler bevorzugen Ollama in der Regel wegen seiner Flexibilität und Integrationsmöglichkeiten in bestehende Entwicklungs-Workflows.

Diese Tools sind so konzipiert, dass sie sowohl Anfängern als auch fortgeschrittenen Nutzern eine benutzerfreundliche Erfahrung bieten.

Hardware-Anforderungen für lokale LLMs

Wenn Sie die Hardwareanforderungen kennen, können Sie geeignete Modelle für Ihr System auswählen und realistische Leistungserwartungen festlegen. Die gute Nachricht ist, dass moderne lokale llms auf einer breiten Palette von Hardwarekonfigurationen funktionieren, von einfachen Laptops bis hin zu High-End-Workstations.

Zu den Mindestanforderungen für den Betrieb kleinerer Modelle gehören 16 GB RAM, eine moderne CPU wie Intel i5-8400 oder AMD Ryzen 5 2600 und mindestens 50 GB verfügbarer Speicherplatz. Mit diesen Spezifikationen lassen sich Modelle mit bis zu 7B-Parametern mit einer für die meisten Anwendungsfälle akzeptablen Leistung betreiben.

Zu den empfohlenen Spezifikationen für eine optimale Leistung gehören eine NVIDIA RTX 4060 mit 8 GB Video-RAM, 32 GB System-RAM und 100 GB+ Speicher für mehrere Modelle. Diese Konfiguration bietet eine reibungslose Inferenz für größere Modelle und ermöglicht die gleichzeitige Ausführung mehrerer Modelle.

Die Speicheranforderungen variieren je nach Modellgröße: kleinere Modelle wie Phi-3-mini benötigen 2-4 GB, während größere Modelle wie Llama 3.1 70B je nach Quantisierung 40-80 GB benötigen. Wenn Sie nur über begrenzte Ressourcen verfügen, sollten Sie das kleinste verfügbare Modell herunterladen, z. B. Gemma 2B Instruct, um den Speicherbedarf zu minimieren. Planen Sie 50-100 GB ein, wenn Sie mit mehreren Modellen unterschiedlicher Größe experimentieren wollen.

Hier ist ein Leistungsvergleich, der die Token pro Sekunde für verschiedene Hardwarekonfigurationen zeigt:

Hardware-Konfiguration | Phi-3-mini (3B) | Lama 3.1 8B | Mistral 7B | Code Llama 34B |

|---|---|---|---|---|

Nur CPU (16GB RAM) | 8-12 Token/Sek. | 4-6 Token/Sek. | 3-5 Token/Sek. | Nicht empfohlen |

RTX 4060 (8GB VRAM) | 45-60 Token/Sek. | 25-35 Token/Sek. | 30-40 Token/Sek. | 8-12 Token/Sek. |

RTX 4090 (24GB VRAM) | 80-120 Token/Sek. | 60-80 Token/Sek. | 70-90 Token/Sek. | 35-45 Token/Sek. |

Apple M2 Pro (32GB) | 35-50 Token/Sek. | 20-30 Token/Sek. | 25-35 Token/Sek. | 15-20 Token/Sek. |

Die GPU-Beschleunigung verbessert die Leistung erheblich, aber die reine CPU-Inferenz bleibt für kleinere Modelle praktikabel, wenn keine GPU-Ressourcen verfügbar sind. Die optimale Leistung ergibt sich aus der Anpassung der Modellgröße an den verfügbaren Video-RAM oder System-RAM.

Die besten Open-Source-Modelle für den lokalen Einsatz

Die Auswahl des richtigen Modells hängt von Ihren Hardwarekapazitäten, den geplanten Anwendungsfällen und den Qualitätsanforderungen ab. Open-Source-Modelle haben ein beeindruckendes Qualitätsniveau erreicht und sind dennoch für den lokalen Einsatz zugänglich. Die wachsende Zahl von Open-Source-LLM-Projekten wie Ollama und llama.cpp unterstreicht die Stärke der von der Community betriebenen Entwicklung und die zunehmende Verfügbarkeit von Modellen, die von führenden KI-Organisationen veröffentlicht werden.

Kleine Modelle (unter 8 GB) bieten eine hervorragende Effizienz für grundlegende Aufgaben:

- Phi-3-mini (3,8B-Parameter) bietet starke Argumentationsfähigkeiten in einem kompakten 2,3GB-Paket, ideal für Szenarien mit begrenztem Speicherplatz

- Gemma 2B bietet Googles Trainingsqualität in einer ultraleichten 1,4 GB großen Modelldatei

- Llama 3.2 3B bietet Metas neueste Architektur-Optimierungen mit ausgewogener Leistung und Effizienz

Die mittleren Modelle (8-16 GB) bieten das beste Gleichgewicht zwischen Leistungsfähigkeit und Ressourcenbedarf:

- Llama 3.1 8B dient als Goldstandard für allgemeine Aufgaben mit starker Argumentation und Codegenerierung

- Mistral 7B zeichnet sich dadurch aus, dass er Anweisungen genau befolgt und komplexe Denkaufgaben bewältigt

- DeepSeek-Coder 6.7B ist spezialisiert auf die Codegenerierung mit Unterstützung für mehr als 80 Programmiersprachen

Große Modelle (16 GB und mehr) bieten maximale Möglichkeiten für Benutzer mit ausreichender Hardware:

- Llama 3.1 70B bietet eine Leistung der GPT-4-Klasse für komplexe Schlussfolgerungen und Analyseaufgaben

- Code Llama 34B bietet außergewöhnliche Unterstützung bei der Programmierung mit einem tiefen Verständnis von Software-Engineering-Konzepten

Alle Modelle sind über Hugging Face mit Modell-IDs wie “microsoft/Phi-3-mini-4k-instruct” oder “meta-llama/Meta-Llama-3.1-8B-Instruct” erhältlich. Leistungsvergleiche zeigen, dass Modelle mit 8B-Parametern in der Regel für die meisten Nutzer das beste Preis-Leistungs-Verhältnis bieten, da sie 85-90% größere Modellfunktionen bieten und gleichzeitig deutlich weniger Ressourcen benötigen.

LM Studio: Der einfachste Weg zum Start

LM Studio revolutioniert die Zugänglichkeit der lokalen KI, indem es eine benutzerfreundliche grafische Schnittstelle bietet, die die technische Komplexität abstrahiert. LM Studio und ähnliche Werkzeuge bieten Benutzerschnittstellen, einschließlich grafischer und webbasierter Optionen, die die Modellverwaltung und Interaktion vereinfachen. LM Studio bietet auch eine praktische Web ui, die es den Benutzern ermöglicht, Modelle direkt von ihrem Browser aus zu verwalten und mit ihnen zu interagieren. Dies macht es zum idealen Ausgangspunkt für Benutzer, die llms zum ersten Mal lokal ausführen.

Beginnen Sie mit dem Herunterladen von LM Studio von lmstudio.ai und befolgen Sie den unkomplizierten Installationsprozess für Ihr Betriebssystem. Das Installationsprogramm konfiguriert die GPU-Beschleunigung automatisch, wenn kompatible Hardware erkannt wird, wodurch die manuelle Treiberkonfiguration entfällt. Nach der Installation starten Sie LM Studio, um auf die Hauptschnittstelle zuzugreifen und die verfügbaren Modelle zu erkunden.

Die Hauptschnittstelle besteht aus drei Hauptbereichen: Entdecken zum Durchsuchen der verfügbaren Modelle, Meine Modelle zum Verwalten der heruntergeladenen Modelle und Chat zum Interagieren mit geladenen Modellen. Auf der Registerkarte "Entdecken" können Sie mit der Suchleiste schnell bestimmte Modelle finden, die Ihren Anforderungen entsprechen. Die integrierte Modellbibliothek enthält hochwertige Open-Source-Modelle mit klaren Beschreibungen und Hardwareanforderungen.

Die Einrichtung der Chat-Schnittstelle umfasst das Laden eines heruntergeladenen Modells und die Einstellung von Generierungsparametern wie Temperatur und Kontextlänge. Die Schnittstelle bietet intuitive Schieberegler und Erklärungen für jede Einstellung, so dass das Experimentieren auch für technisch nicht versierte Benutzer möglich ist.

Für Entwickler enthält LM Studio einen lokalen API-Server, der OpenAI-kompatible Endpunkte bereitstellt. Aktivieren Sie diese Funktion in den Einstellungen, um lokale Modelle in bestehende Anwendungen zu integrieren, die das API-Format von OpenAI unterstützen.

Installieren Sie Ihr erstes Modell in LM Studio

Navigieren Sie zur Registerkarte Entdecken, wo Sie eine durchsuchbare Bibliothek kompatibler Modelle finden. Suchen Sie nach “llama-3.2-3b-instruct”, um das effiziente 3B-Parameter-Modell von Meta zu finden, das auch auf bescheidener Hardware funktioniert.

Klicken Sie auf die Schaltfläche "Download", um den Vorgang zu starten. LM Studio zeigt Fortschrittsindikatoren an, die die Downloadgeschwindigkeit und die geschätzte Fertigstellungszeit anzeigen. Der Download-Manager geht mit Unterbrechungen sorgfältig um und setzt den Download teilweise fort, sobald die Netzwerkverbindung wiederhergestellt ist.

Sobald der Download abgeschlossen ist, erscheint das Modell in Ihrem Bereich Meine Modelle. Die heruntergeladenen Modelldateien werden verwaltet und gespeichert, um den Zugriff und das Laden zu erleichtern. Klicken Sie auf , um das Modell in den Speicher zu laden, was in der Regel 10-30 Sekunden dauert, je nach Modellgröße und Speichergeschwindigkeit. Die Benutzeroberfläche zeigt die Speichernutzung an und bestätigt, wenn das Modell für die Interaktion bereit ist.

Testen Sie Ihre Installation mit Beispielaufforderungen wie “Erklären Sie Quantencomputing in einfachen Worten” oder “Schreiben Sie eine Python-Funktion zur Berechnung von Fibonacci-Zahlen”. Das Modell sollte innerhalb von Sekunden reagieren und die erfolgreiche Einrichtung bestätigen.

Zur allgemeinen Fehlerbehebung bei Download-Fehlern gehören die Überprüfung des verfügbaren Festplattenspeichers, die Überprüfung der Stabilität der Internetverbindung und die Sicherstellung, dass Ihre Firewall den Netzwerkzugriff von LM Studio zulässt. Die eingebauten Protokolle liefern detaillierte Fehlerinformationen zur Lösung von Problemen.

GPT4All: Lokale KI mit Fokus auf Datenschutz

GPT4All legt großen Wert auf Datenschutz und Benutzerfreundlichkeit und ist damit eine ausgezeichnete Wahl für Benutzer, die Wert auf Datensicherheit legen. Die Anwendung läuft komplett offline, sobald die Modelle heruntergeladen sind, so dass Ihre Gespräche Ihr Gerät nie verlassen.

Laden Sie GPT4All von gpt4all.io herunter und installieren Sie es auf Windows, macOS oder Linux. Bei der Installation wird automatisch ein Einstiegsmodell heruntergeladen, um die sofortige Funktionalität zu gewährleisten. Der erste Start präsentiert eine saubere Oberfläche mit klarer Navigation zwischen Chat, Modellen und Einstellungen. Nach der Installation können Sie die Modelle auffordern, Text für eine Vielzahl von Aufgaben zu generieren, z. B. Fragen zu beantworten oder Inhalte zu erstellen.

Der Modellmarktplatz bietet über 50 kuratierte Modelle mit detaillierten Beschreibungen, Hardwareanforderungen und Nutzerbewertungen. Die Modelle sind nach Größe und Fachgebiet kategorisiert und helfen den Benutzern bei der Auswahl geeigneter Optionen für ihre Anwendungsfälle und Hardware-Einschränkungen.

Die Einrichtung der GPU-Beschleunigung variiert je nach Plattform, umfasst aber im Allgemeinen die Installation von CUDA-Treibern für NVIDIA-Grafikkarten oder die Sicherstellung der Metal-Unterstützung unter macOS. Das Einstellungsfeld bietet klare Anweisungen und eine automatische Erkennung kompatibler Hardwarekonfigurationen.

LocalDocs für den Dokumenten-Chat einrichten

LocalDocs ist die herausragende Funktion von GPT4All und ermöglicht private Konversationen mit Ihren persönlichen Dokumenten, ohne dass Inhalte auf externe Server hochgeladen werden müssen. Diese Funktionalität verwandelt lokale llms in leistungsstarke Recherche- und Analysetools.

Greifen Sie über die entsprechende Registerkarte auf LocalDocs zu und fügen Sie lokale Ordner mit PDFs, Textdateien, Markdown-Dokumenten oder Code-Repositories hinzu. Das System unterstützt gängige Formate wie .pdf, .txt, .md, .docx und Quellcode-Dateien.

Der Indizierungsprozess analysiert den Inhalt der Dokumente, um durchsuchbare Einbettungen zu erstellen, die lokal auf Ihrem Gerät gespeichert werden. Die Indizierungszeit hängt vom Dokumentenvolumen ab, verarbeitet aber in der Regel Hunderte von Seiten innerhalb von Minuten. Fortschrittsanzeigen zeigen den Abschlussstatus und die geschätzte verbleibende Zeit an.

Beispiele für Abfragen von indizierten Dokumenten sind “Fassen Sie die wichtigsten Ergebnisse meiner Forschungsarbeiten zusammen” oder “Welche Codierungsmuster treten in meinen Projekten am häufigsten auf?”. Das System ruft relevante Dokumentabschnitte ab, bevor es Antworten generiert, und liefert fundierte Antworten mit Quellenangaben. Zitate.

Zu den Vorteilen für den Datenschutz gehört die vollständige Offline-Verarbeitung ohne Datenübertragung an externe Dienste. Ihre Dokumente verbleiben während des gesamten Prozesses auf Ihrem lokalen Rechner, wodurch sich LocalDocs für vertrauliche Geschäftsdokumente oder persönliche Forschungsunterlagen eignet.

Jan: Open Source ChatGPT Alternative

Jan positioniert sich als umfassende Open-Source-Alternative zu kommerziellen KI-Chatdiensten und bietet vertraute Schnittstellen mit der Flexibilität der Open-Source-Entwicklung. Die Plattform unterstützt sowohl lokale Inferenz als auch hybride Cloud-Integration für maximale Flexibilität.

Installation von jan.ai erfordert die Überprüfung der Systemanforderungen, einschließlich ausreichendem RAM und Speicherplatz. Das Installationsprogramm erkennt automatisch die Hardware-Fähigkeiten und schlägt optimale Konfigurationseinstellungen für Ihr spezifisches Setup vor.

Der Rundgang durch die Benutzeroberfläche zeigt ein von ChatGPT inspiriertes Design mit modernen UI-Elementen und intuitiver Navigation. Der Gesprächsverlauf, der Modellwechsel und der Zugriff auf die Einstellungen folgen vertrauten Mustern, die die Lernkurve für Nutzer, die von kommerziellen Diensten umsteigen, reduzieren.

Modellimportfunktionen ermöglichen die Übernahme von Modellen aus anderen Tools wie LM Studio oder Ollama, wodurch redundante Downloads vermieden werden. Jan unterstützt den Import jedes kompatiblen großen Sprachmodells zur lokalen oder hybriden Verwendung. Das System erkennt automatisch kompatible Modellformate und konvertiert sie bei Bedarf für eine optimale Leistung.

Der Erweiterungsmarktplatz fügt Funktionen durch von der Community entwickelte Plugins hinzu, die Bereiche wie erweiterte Modellverwaltung, spezielle Chat-Modi und die Integration mit externen Tools und Diensten abdecken.

Die Remote-API-Integration ermöglicht hybride Bereitstellungen, bei denen einige Anfragen lokale Modelle nutzen, während andere je nach Komplexität oder Leistungsanforderungen auf Cloud-Dienste zurückgreifen. Mit diesem Ansatz werden die Kosten optimiert und gleichzeitig lokale Funktionen für sensible Aufgaben beibehalten.

Ollama: Entwicklerfreundliches Kommandozeilen-Tool

Ollama zeichnet sich als Kommandozeilen-Tool aus, das speziell für Entwickler entwickelt wurde, die programmatische Steuerung und Integrationsmöglichkeiten bevorzugen. Seine einfache, aber leistungsstarke Schnittstelle macht die Modellverwaltung und -bereitstellung für technische Benutzer unkompliziert.

Die Installation variiert je nach Betriebssystem, verwendet aber in der Regel Paketmanager wie Homebrew unter macOS (brew install ollama), apt unter Ubuntu (sudo apt install ollama) oder winget unter Windows (winget install ollama). Diese Methoden gewährleisten eine ordnungsgemäße Verwaltung von Abhängigkeiten und Systemintegration.

Nach der Installation können die Benutzer mit Ollama über spezielle Terminalbefehle zum Herunterladen, Ausführen und Verwalten von Modellen interagieren, so dass es einfach ist, vollständig über die Befehlszeile zu arbeiten.

Wesentliche Befehle ermöglichen eine umfassende Verwaltung des Lebenszyklus von Modellen:

- ollama pull llama3.1:8b lädt Modelle aus der offiziellen Bibliothek herunter

- ollama run llama3.1:8b startet interaktive Chat-Sitzungen mit bestimmten Modellen

- ollama list zeigt alle installierten Modelle mit Größen und Änderungsdaten an

- ollama rm model-name entfernt Modelle, um Speicherplatz freizugeben

Ollama kann als lokaler Server oder lokaler Inferenzserver konfiguriert werden, so dass Sie Modelle lokal hosten und für die Integration in andere Anwendungen bereitstellen können. Diese Konfiguration ermöglicht eine einfache Anpassung, verbesserte Leistung und nahtlose Unterstützung bei der Fehlerbehebung.

Die Erstellung benutzerdefinierter Modelle über Modelfile ermöglicht die Feinabstimmung von Modellverhalten, Systemaufforderungen und Parametern. Dieser textbasierte Konfigurationsansatz lässt sich gut in die Versionskontrolle und Automatisierungsworkflows integrieren.

Die Integration mit Entwicklungstools umfasst Plugins für gängige IDEs wie VS Code, die die Codegenerierung und -analyse direkt in Entwicklungsumgebungen ermöglichen. Das standardisierte API-Format vereinfacht die Integration mit bestehenden Anwendungen und Diensten.

Mehrere Modelle mit Ollama ausführen

Die Architektur von Ollama unterstützt die gleichzeitige Ausführung von Modellen, so dass verschiedene Modelle gleichzeitig spezielle Aufgaben erfüllen können. Diese Fähigkeit ermöglicht ausgefeilte Arbeitsabläufe, bei denen kleinere Modelle grundlegende Aufgaben erledigen, während größere Modelle komplexe Überlegungen anstellen.

Der Wechsel zwischen den Modellen erfordert eine einfache Befehlssyntax wie ollama run mistral:7b gefolgt von ollama run codellama:7b in separaten Terminalsitzungen. Jedes Modell unterhält einen eigenen Gesprächskontext und eine eigene Speicherzuweisung.

Die Speicherverwaltung übernimmt automatisch die Ressourcenzuweisung auf der Grundlage der verfügbaren Systemressourcen und der Modellanforderungen. Das System gibt Warnungen aus, wenn Speicherbeschränkungen die Leistung beeinträchtigen könnten, und schlägt Optimierungsstrategien vor.

Der über ollama serve eingerichtete API-Server stellt Modelle über HTTP-Endpunkte bereit, die mit dem OpenAI-Format kompatibel sind. Dies ermöglicht eine nahtlose Integration mit Anwendungen, die für Cloud-KI-Dienste entwickelt wurden und vollständig auf einer lokalen Infrastruktur laufen.

Die Docker-Bereitstellung erleichtert Produktionsumgebungen durch offizielle Ollama-Container. Der containerisierte Ansatz gewährleistet ein konsistentes Verhalten in Entwicklungs-, Staging- und Produktionsumgebungen und vereinfacht gleichzeitig die Verwaltung von Abhängigkeiten.

Erweiterte Werkzeuge: llama.cpp und llamafile

Fortgeschrittene Benutzer, die ein Maximum an Kontrolle und Leistungsoptimierung anstreben, profitieren von Tools auf niedrigerer Ebene wie llama.cpp und llamafile. Um Modelle mit llama.cpp auszuführen, müssen Benutzer eine gguf-Modelldatei herunterladen, die das erforderliche Format für die lokale Bereitstellung ist. Diese Tools bieten mehr Komfort als Flexibilität und Effizienz und sind daher ideal für Produktionsanwendungen und spezielle Anforderungen.

Die Entscheidung zwischen benutzerfreundlichen Anwendungen und fortgeschrittenen Tools hängt von den jeweiligen Bedürfnissen ab. Entscheiden Sie sich für fortgeschrittene Tools, wenn Sie benutzerdefinierte Kompilierungsoptionen, spezielle Hardwareunterstützung oder die Integration in größere Systeme benötigen, bei denen eine vollständige Kontrolle über die Inferenzmaschine erforderlich ist. Benutzer können auch fein abgestimmte Modelle für bestimmte Aufgaben oder Bereiche ausführen und so eine optimale, auf ihre Anforderungen zugeschnittene Leistung erzielen.

Die Kompilierung von llama.cpp mit GPU-Unterstützung erfordert die Konfiguration von Build-Systemen für bestimmte Hardware-Ziele. Die CUDA-Unterstützung erfordert die Installation von NVIDIA-Treibern und -Toolkits, die Metal-Unterstützung funktioniert automatisch unter macOS mit Apple Silicon, und OpenCL bietet eine breitere GPU-Kompatibilität über alle Hersteller hinweg.

Die Leistungsoptimierung durch fortschrittliche Tools umfasst benutzerdefinierte Quantisierungsschemata, Optimierungen der Speicherzuordnung und spezielle Aufmerksamkeitsimplementierungen. Diese Optimierungen können die Ableitungsgeschwindigkeit erheblich verbessern und den Speicherbedarf im Vergleich zu Allzwecklösungen verringern.

Die ausführbaren Dateien von llamafile ermöglichen den portablen Einsatz von KI, indem sie Modelle und Inferenzmaschinen in einzelne Dateien packen, die ohne Installation ausgeführt werden können. Dieser Ansatz vereinfacht Einsatzszenarien, bei denen herkömmliche Installationsprozesse nicht machbar oder wünschenswert sind.

Zu den mit fortschrittlichen Tools verfügbaren Modellquantisierungsverfahren gehören 4-Bit-, 8-Bit- und gemischtpräzise Formate, die die Modellgröße reduzieren und gleichzeitig die meiste Leistung beibehalten. Benutzer können mit verschiedenen Quantisierungsschemata experimentieren, um ein optimales Gleichgewicht für ihre spezifischen Anwendungsfälle zu finden.

Erstellen eines lokalen API-Servers

Ein lokaler API-Server ist die ultimative Integrationslösung für Ihr llm-Modell. Er bietet nahtlose Konnektivität mit anderen Anwendungen, während Sie die vollständige Kontrolle über Ihre Daten und Infrastruktur behalten. Sowohl LM Studio als auch Ollama bieten leistungsstarke, unkomplizierte Bereitstellungsoptionen, die Ihnen Funktionen auf Unternehmensniveau direkt in die Hand geben, ganz gleich, ob Sie intuitive grafische Oberflächen oder eine präzise Befehlszeile bevorzugen.

Für die ersten Schritte wählen Sie Ihre bevorzugte Bereitstellungsstrategie, LM Studio oder Ollama, und installieren sie in Ihrer Infrastruktur. Nach der Bereitstellung laden Sie das llm-Modell herunter, das perfekt zu Ihren Hardwarekapazitäten und Geschäftsanforderungen passt und eine optimale Ressourcennutzung gewährleistet. Konfigurieren Sie kritische Leistungsparameter wie die Kontextlänge und schalten Sie die GPU-Beschleunigungsfunktionen frei, wenn Ihr System dies unterstützt, um die Hochleistungsergebnisse zu erzielen, die Ihre Anwendungen erfordern.

Der Start Ihres lokalen API-Servers könnte nicht einfacher sein: LM Studio ermöglicht die Serveraktivierung über eine intuitive Einstellungsoberfläche, während Ollama eine terminalbasierte Steuerung für maximale betriebliche Flexibilität bietet. Ihr API-Server arbeitet an einem dedizierten Port und ist bereit, Anfragen von Ihren Anwendungen zu verarbeiten und generierte Textantworten mit Zuverlässigkeit und Geschwindigkeit auf Unternehmensniveau zu liefern.

Wenn Ihr lokaler API-Server betriebsbereit ist, haben Sie die Freiheit, benutzerdefinierte Chatbots zu erstellen, komplexe Arbeitsabläufe zu automatisieren und fortschrittliche Sprachfunktionen direkt in Ihr Software-Ökosystem zu integrieren - und das alles unter Wahrung vollständiger Datensicherheit und mit der Gewissheit, dass Ihr llm-Modell vollständig innerhalb Ihrer kontrollierten Umgebung funktioniert. Dies ist mehr als nur eine technische Einrichtung; es ist Ihr Tor zu skalierbaren, sicheren und hochentwickelten Sprachverarbeitungsfunktionen.

Sichern Ihres lokalen LLM mit einem API-Schlüssel

Die Sicherung des Zugriffs auf Ihren lokalen Llm ist nicht nur unerlässlich, sondern die Grundlage, die Ihre KI-Implementierung von einer potenziellen Schwachstelle in eine Festung der kontrollierten Innovation verwandelt. Wenn Sie mehrere Anwendungen oder Benutzer miteinander verbinden, wird die Implementierung eines API-Schlüsselsystems zu einer spielverändernden Strategie, die sicherstellt, dass nur autorisierte Anfragen die Leistung Ihres Modells freischalten können, während der unbefugte Zugriff in Schach gehalten wird.

Ändern Sie Ihr Sicherheitskonzept, indem Sie für jede Anwendung oder jeden Benutzer eindeutige API-Schlüssel generieren, mit denen Sie die Fähigkeiten Ihres lokalen llm nutzen können. Speichern Sie diese digitalen Schlüssel wie kostbare Güter in Umgebungsvariablen oder verschlüsselten Konfigurationsdateien und verhindern Sie so eine versehentliche Offenlegung, die Ihren Wettbewerbsvorteil gefährden könnte. Konfigurieren Sie Ihren lokalen API-Server so, dass er bei jeder einzelnen Anfrage eine Validierung des API-Schlüssels verlangt, und schaffen Sie so eine undurchdringliche Barriere, die unbefugte Zugriffsversuche blockiert, bevor sie überhaupt an Ihre Tür klopfen können.

Verbessern Sie Ihre Sicherheitsstrategie, indem Sie Ihre API-Schlüssel regelmäßig austauschen, um das Risiko eines möglichen Verstoßes zu verringern, und ergreifen Sie entschlossene Maßnahmen, um nicht mehr benötigte oder möglicherweise kompromittierte Schlüssel zu sperren. Mit diesen branchenführenden Praktiken behalten Sie nicht nur die Kontrolle, sondern erlangen die vollständige Herrschaft über Ihren lokalen llm und schützen sowohl Ihr wertvolles Modell als auch alle von ihm verarbeiteten sensiblen Daten mit kompromissloser Präzision.

Praktische Anwendungen und Anwendungsfälle

Die lokale Ausführung von llms ermöglicht zahlreiche praktische Anwendungen in beruflichen und privaten Kontexten. Die Kombination aus Datenschutz, unbegrenzter Nutzung und Offline-Funktionen eröffnet Möglichkeiten, die Cloud-Dienste nicht bieten können.

Codegenerierung und Fehlersuche sind die wichtigsten Anwendungsfälle für lokale KI. Modelle wie DeepSeek-Coder und Code Llama zeichnen sich durch das Verstehen von Programmierkontexten, das Generieren von Standardcode, das Erklären komplexer Algorithmen und das Vorschlagen von Fehlerkorrekturen in über 80 Programmiersprachen aus.

Die Arbeitsabläufe zur Erstellung von Inhalten profitieren von den unbegrenzten Generierungsmöglichkeiten der lokalen Modelle. Blogbeiträge, E-Mails, Marketing Texte und Inhalte für soziale Medien können iterativ ohne API-Kosten oder Tarifbeschränkungen erstellt werden. Die Möglichkeit zur Feinabstimmung lokaler Modelle auf bestimmte Schreibstile fügt Personalisierung mit Cloud-Diensten unmöglich.

Datenanalyse- und Zusammenfassungsaufgaben nutzen die Fähigkeit lokaler Modelle, sensible Informationen ohne externe Übertragung zu verarbeiten. Finanzberichte, juristische Dokumente, medizinische Unterlagen und geschützte Forschungsergebnisse können unter Wahrung der Vertraulichkeit analysiert werden.

Sprachübersetzung ohne externe Dienste bietet Datenschutz für sensible Kommunikation und unterstützt Dutzende von Sprachpaaren. Lokale Modelle erledigen die Übersetzung technischer Dokumentation, mehrsprachigen Kundensupport und internationale Geschäftskommunikation vollständig offline.

Zu den Beispielen aus der Praxis gehören Anwaltskanzleien, die lokale Modelle für die Dokumentenanalyse einsetzen, Softwareunternehmen, die KI-gestützte Programmierassistenten implementieren, und Autoren von Inhalten, die personalisierte Schreibwerkzeuge entwickeln. Jede dieser Lösungen wird lokal auf der Hardware des Nutzers ausgeführt, wodurch Datenschutz und Kontrolle gewährleistet sind. Diese Anwendungen zeigen die Vielseitigkeit und den praktischen Wert des lokalen KI-Einsatzes.

Leistungsoptimierung und Fehlerbehebung

Die Maximierung der Leistung lokaler LMS erfordert ein Verständnis der Systemressourcen, der Modelleigenschaften und der Optimierungstechniken. Die richtige Konfiguration kann die Reaktionszeiten drastisch verbessern und größere Modelle auf bescheidener Hardware ermöglichen.

Die Einrichtung der GPU-Beschleunigung ist je nach Hersteller unterschiedlich, umfasst aber im Allgemeinen die Installation der entsprechenden Treiber und die Konfiguration der Software zur Erkennung der verfügbaren Hardware. NVIDIA-Benutzer müssen das CUDA-Toolkit installieren, während AMD-Benutzer ROCm auf unterstützten Linux-Distributionen einrichten müssen.

Die Modellquantisierung reduziert den Speicherbedarf, indem Modellparameter mit geringerer Präzision gespeichert werden. Durch die 4-Bit-Quantisierung wird die Modellgröße in der Regel um 75% reduziert, während die Qualität von 95%+ beibehalten wird, wodurch große Modelle auf Consumer-Hardware mit begrenztem Video-Ram zugänglich werden.

Häufige Fehlermeldungen und ihre Lösungen sind:

- “CUDA hat keinen Speicher mehr”: Verringern Sie die Modellgröße, schließen Sie andere Anwendungen, oder aktivieren Sie die CPU-Auslastung

- “Modell laden fehlgeschlagen”: Überprüfen Sie die Integrität der Modelldatei und ausreichend Speicherplatz

- “Langsame Inferenzgeschwindigkeit”: Überprüfen Sie die Einstellungen für die GPU-Beschleunigung und ziehen Sie die Modellquantisierung in Betracht.

Die Ressourcenüberwachung während der Inferenz hilft, Engpässe zu erkennen und Konfigurationen zu optimieren. Task Manager unter Windows, Activity Monitor unter macOS oder htop unter Linux zeigen die CPU-Auslastung, Speichernutzung und GPU-Aktivitätsmuster während der Modellausführung auf.

Die Einstellung der Temperatur und der Sampling-Parameter wirkt sich auf die Qualität und die Geschwindigkeit der Ausgabe aus. Niedrigere Temperaturen führen zu konsistenteren Ergebnissen, während höhere Werte die Kreativität steigern. Top-k- und Top-p-Sampling-Parameter sorgen für ein Gleichgewicht zwischen Reaktionsvielfalt und Kohärenz.

Die Optimierung der Kontextlänge sorgt für ein Gleichgewicht zwischen Speichernutzung und Konversationsfähigkeit. Längere Kontexte ermöglichen anspruchsvollere Interaktionen, erfordern aber proportional mehr Speicher. Die meisten Anwendungsfälle funktionieren gut mit 2048-4096 Token-Kontexten.

Bewährte Praktiken für die lokale LLM-Einrichtung

Um den größtmöglichen Nutzen aus Ihrem lokalen llm zu ziehen, benötigen Sie eine erfolgreiche Strategie, die sowohl Spitzenleistung als auch kugelsichere Sicherheit bietet. Beginnen Sie mit der Auswahl des perfekten Modells für Ihre individuellen Anforderungen. Informieren Sie sich eingehend über Modellparameter, Größenspezifikationen und gezielte Anwendungen, um die ideale Lösung für Ihre Hardware-Funktionen und spezifischen Anwendungsfälle zu finden.

Optimieren Sie Ihr Setup, indem Sie kritische Modellparameter wie die Kontextlänge feinabstimmen und die GPU-Beschleunigung aktivieren, wo immer dies möglich ist, um ein spielveränderndes Leistungsniveau zu erreichen. Stellen Sie sicher, dass Ihr Betriebssystem einwandfrei mit den von Ihnen gewählten Tools und llm-Modellen kompatibel ist, und halten Sie Ihr gesamtes System und Ihren Software-Stack auf dem neuesten Stand, um die neuesten bahnbrechenden Funktionen und modernsten Sicherheitsverbesserungen nutzen zu können.

Bleiben Sie Engpässen einen Schritt voraus, indem Sie Ihre Systemressourcen aktiv überwachen und die RAM- und GPU-Auslastung verfolgen, um Leistungsblockaden zu vermeiden, insbesondere bei der Bereitstellung größerer Modelle oder der parallelen Ausführung mehrerer Modelle. Transformieren Sie Ihren Arbeitsablauf mit intuitiven grafischen Oberflächen wie LM Studio oder GPT4All für eine mühelose Benutzererfahrung, die die Modellverwaltung und Einstellungsoptimierung unglaublich einfach macht.

Schützen Sie das Wichtigste, bewahren Sie sensible Daten immer in Ihrer lokalen Umgebung auf und riskieren Sie nicht, dass vertrauliche Informationen über Internetkanäle übertragen werden. Testen und bewerten Sie fortlaufend verschiedene Modelle, um sicherzustellen, dass Sie die optimale Lösung für Ihre spezifische Anwendung nutzen, und nutzen Sie die Flexibilität zur Feinabstimmung oder zum Wechsel zu neuen Modellen, wenn Ihre Anforderungen wachsen und sich weiterentwickeln.

Durch die Implementierung dieser bewährten Best Practices schaffen Sie eine lokale llm-Umgebung, die sicher, blitzschnell und präzise kalibriert ist, um herausragende Ergebnisse zu liefern, die Ihre individuellen Anforderungen übertreffen und außergewöhnliche Ergebnisse erzielen.

Kostenanalyse: Lokale vs. Cloud-KI-Dienste

Das Verständnis der Wirtschaftlichkeit von lokalen und Cloud-KI-Diensten hilft, fundierte Entscheidungen über Infrastrukturinvestitionen zu treffen. Die Analyse umfasst Vorab-Hardwarekosten, laufende Ausgaben und Break-even-Berechnungen auf der Grundlage von Nutzungsmustern.

Die Anfangsinvestitionen in Hardware für leistungsfähige lokale KI-Systeme reichen von $800-1.500 für mittlere Konfigurationen bis zu $3.000-5.000 für High-End-Systeme. Diese Kosten umfassen moderne CPUs, ausreichenden Arbeitsspeicher, leistungsfähige Grafikprozessoren und angemessenen Speicherplatz für mehrere Modelle.

Die monatlichen Abonnementkosten für Cloud-KI-Dienste variieren stark: ChatGPT Plus kostet $20/Monat, Claude Pro kostet $20/Monat, und die API-Nutzung kann je nach Volumen zwischen $10-500+ monatlich liegen. Enterprise-Pläne übersteigen oft $100/Monat pro Nutzer.

Eine Break-even-Analyse zeigt, dass moderate bis starke Nutzer ihre Hardware-Investitionen in der Regel innerhalb von 6-18 Monaten wieder hereinholen. Benutzer, die sensible Daten verarbeiten oder eine 24/7-Verfügbarkeit benötigen, rechtfertigen häufig eine lokale Infrastruktur unabhängig von reinen Kostenüberlegungen.

Die Energiekosten für den Betrieb lokaler Modelle erhöhen die Stromrechnung kontinuierlich um etwa $30-100 pro Monat, je nach Effizienz der Hardware und den Tarifen der örtlichen Stromversorger. Moderne Grafikprozessoren verfügen über Energieverwaltungsfunktionen, die den Verbrauch während der Leerlaufzeiten reduzieren.

Berechnungen der Gesamtbetriebskosten über einen Zeitraum von 2 bis 3 Jahren begünstigen im Allgemeinen lokale Lösungen für:

- Nutzer mit mäßigem bis starkem AI-Nutzungsverhalten

- Organisationen, die den Datenschutz einhalten müssen

- Anwendungen, die eine garantierte Verfügbarkeit erfordern

- Teams, die unbegrenzte Experimentiermöglichkeiten wünschen

Cloud-Dienste bleiben wirtschaftlich für:

- Gelegenheitsnutzer mit geringem monatlichem Volumen

- Teams, die Zugang zu hochmodernen Modellen benötigen

- Organisationen ohne IT-Infrastruktur-Know-how

- Anwendungen, die nahtlos skalierbar sein müssen

Bei dieser Entscheidung spielen oft nicht-finanzielle Faktoren eine Rolle, wie z. B. Anforderungen an den Datenschutz, Datenhoheit, Zuverlässigkeit der Internetverbindung und organisatorische Kontrollpräferenzen, die trotz höherer Anfangskosten den Ausschlag für eine lokale Bereitstellung geben.

Lokale große Sprachmodelle stellen einen grundlegenden Wandel hin zu einer demokratisierten, privaten und kostengünstigen KI-Bereitstellung dar. Da die Modelle immer effizienter und die Tools immer benutzerfreundlicher werden, sinkt die Einstiegshürde weiter, während sich die Möglichkeiten rasch erweitern.

Ganz gleich, ob Sie als Entwickler Unterstützung bei der Programmierung suchen, als Unternehmen sensible Daten schützen oder als Enthusiast die Möglichkeiten der KI erforschen wollen, die lokale Ausführung von llms bietet Ihnen eine beispiellose Kontrolle über Ihre KI-Erfahrung. Beginnen Sie mit benutzerfreundlichen Tools wie LM Studio oder GPT4All, experimentieren Sie mit verschiedenen Modellen, um das ideale Gleichgewicht zwischen Fähigkeiten und Leistung zu finden, und erweitern Sie Ihr Setup schrittweise, wenn sich die Anforderungen ändern.

Die Zukunft der künstlichen Intelligenz gehört nicht nur in riesige Rechenzentren, sondern auf Ihre eigene Hardware, unter Ihrer vollständigen Kontrolle. Laden Sie noch heute Ihr erstes lokales Modell herunter und erleben Sie die Freiheit der selbst gehosteten künstlichen Intelligenz.

Einführung in die lokale KI

Lokale KI revolutioniert die Art und Weise, wie Einzelpersonen und Unternehmen künstliche Intelligenz nutzen, indem sie die volle Leistung großer Sprachmodelle direkt auf Ihren eigenen Computer bringt. Anstatt von Cloud-basierten Diensten abhängig zu sein, bedeutet die lokale Ausführung von llms, dass die gesamte Verarbeitung auf Ihrem Gerät stattfindet, wodurch Sie die vollständige Kontrolle über die Modellparameter und den Umgang mit Ihren sensiblen Daten erhalten. Dieser Ansatz verbessert nicht nur den Datenschutz, da Ihre Daten Ihren Rechner nie verlassen, sondern verkürzt auch die Latenzzeit, so dass die Antworten schneller und zuverlässiger sind als je zuvor.

Mit lokaler KI können Sie große Sprachmodelle auf Ihre individuellen Bedürfnisse abstimmen, egal ob Sie sie für bestimmte Aufgaben optimieren oder mit verschiedenen Konfigurationen experimentieren wollen. Die lokale Ausführung von llms ermöglicht Ihnen die Anpassung von Modellen, die Verwaltung von Updates und die Bereitstellung von Lösungen, die perfekt auf Ihre Arbeitsabläufe zugeschnitten sind - und das alles bei absoluter Sicherheit Ihrer Daten. Da immer mehr Anwender den Wert der lokalen Bereitstellung entdecken, wächst das Ökosystem der Tools und Modelle rasant an, so dass es einfacher denn je ist, die Fähigkeiten der hochmodernen großen Sprachmodelle llms direkt auf dem eigenen Computer zu nutzen.

Erste Schritte mit lokalen LLMs

Der Start Ihrer lokalen LLM-Reise war noch nie so einfach wie heute - dank bahnbrechender Tools und einem wachsenden Ökosystem leistungsstarker Modelle, die Ihnen zur Verfügung stehen. Beginnen Sie mit der Auswahl einer Plattform wie LM Studio oder Ollama, die beide entwickelt wurden, um den Prozess der Ausführung von LLMs direkt auf Ihrem Rechner zu vereinfachen und zu rationalisieren. Diese Lösungen bieten benutzerfreundliche, auf Ihre Präferenzen zugeschnittene Erfahrungen - LM Studio mit seiner intuitiven grafischen Oberfläche und Ollama mit seinem effizienten Kommandozeilenansatz - so dass Sie den Arbeitsablauf wählen können, der perfekt zu Ihrem technischen Komfort passt.

Nach der Installation Ihrer bevorzugten Plattform können Sie die integrierte Suchfunktion nutzen, um mühelos verfügbare Modelle aus vertrauenswürdigen Repositories wie Hugging Face zu durchsuchen. Laden Sie die von Ihnen gewählte Modelldatei direkt auf Ihr lokales System herunter, wobei die Hardwarekompatibilität garantiert ist. Nach der Konfiguration können Sie den lokalen Inferenzserver aktivieren, so dass Sie entweder über die grafische Oberfläche oder über die Befehlszeile mit Ihrem Modell arbeiten können. Diese leistungsstarke Einrichtung bietet Ihnen die Flexibilität, mit mehreren Modellen zu experimentieren, Ihr lokales LLM-Ökosystem effizient zu verwalten und alle Vorteile der lokalen Verarbeitung zu nutzen, ohne von einer externen Cloud-Infrastruktur abhängig zu sein.

Einrichten des lokalen Inferenzservers

Ein lokaler Inferenzserver ist das entscheidende Rückgrat für den lokalen Betrieb von llms und ermöglicht Ihnen die Bereitstellung, Verwaltung und Interaktion mit den von Ihnen gewählten Modellen in einer äußerst effizienten und sicheren Umgebung. Revolutionäre Tools wie LM Studio und Ollama machen die Einrichtung eines lokalen Inferenzservers unglaublich einfach - selbst Benutzer, die völlig neu im Bereich der künstlichen Intelligenz sind, können leistungsstarke Ergebnisse erzielen. Um dieses Potenzial freizusetzen, wählen Sie einfach die gewünschte Modelldatei aus und konfigurieren Sie wichtige Parameter wie die Kontextlänge, und aktivieren Sie, falls verfügbar, die GPU-Beschleunigung für explosive Leistungssteigerungen.

Ollama bietet fortschrittliche Funktionen wie die GPU-Beschleunigung, die die Modellinferenz auf kompatibler Hardware dramatisch beschleunigen kann - und Ihren Workflow völlig verändert. Sie erhalten die vollständige Kontrolle, indem Sie den genauen Port für Ihren Inferenzserver angeben und ihn mühelos über die Web-UI zugänglich machen oder nahtlos in andere Anwendungen integrieren, um maximale Flexibilität zu erreichen. LM Studio bietet eine ebenso rationalisierte Einrichtung, die es Ihnen ermöglicht, Modelle und Servereinstellungen über eine intuitive, benutzerfreundliche Schnittstelle zu verwalten. Wenn Ihr lokaler Inferenzserver betriebsbereit ist, verfügen Sie über eine leistungsstarke, völlig private Umgebung, um llms lokal auszuführen und die vollen, uneingeschränkten Möglichkeiten der von Ihnen gewählten Modelle zu nutzen.

Lokale Ausführung von LLMs mit gängigen Tools

Die Wahl des richtigen Tools ist der Schlüssel zu einer nahtlosen Erfahrung, wenn Sie llms lokal ausführen. LM Studio, Ollama und GPT4All gehören zu den vertrauenswürdigsten Lösungen und bieten jeweils einzigartige Funktionen, die auf Ihre speziellen Arbeitsabläufe zugeschnitten sind. LM Studio unterstützt Sie mit seiner intuitiven grafischen Oberfläche, die es Ihnen mühelos ermöglicht, mehrere Modelle zu verwalten, nahtlos zwischen ihnen zu wechseln und die Einstellungen zu optimieren, um optimale Ergebnisse zu erzielen, die für Ihre Projekte wichtig sind. Für diejenigen, die sich in Terminalumgebungen wohlfühlen, bietet Ollama eine robuste Kommandozeilenfunktion, die Ihre fortschrittlichen Workflows unterstützt und sich nahtlos in Ihr Entwicklungssystem integriert.

GPT4All ist eine weitere leistungsstarke Wahl in Ihrem Toolkit. Es unterstützt eine breite Palette von Modellen - darunter beliebte Optionen wie Mistral 7B - und bietet Ihnen gleichzeitig eine optimierte Schnittstelle für die Interaktion mit Ihrer lokalen KI. Diese Plattformen führen nicht nur Modelle aus, sondern ermöglichen Ihnen auch die mühelose Einrichtung von API-Servern, die eine nahtlose Integration mit Ihren bestehenden Anwendungen und Diensten ermöglichen. Ganz gleich, ob Sie mehrere Modelle verwalten, mit der Feinabstimmung experimentieren oder gerade erst mit der lokalen KI beginnen, diese Plattformen bieten Ihnen die Flexibilität und Leistung, die Sie benötigen, um das Potenzial Ihrer lokalen KI zu maximieren.

Erstellen eines lokalen API-Servers

Die Einrichtung eines lokalen API-Servers ist die ultimative Neuerung für jeden, der die Integration großer Sprachmodelle in Anwendungen und Arbeitsabläufe revolutionieren möchte! Mit leistungsstarken Tools wie LM Studio und Ollama wird die Erstellung Ihres persönlichen lokalen API-Servers unglaublich einfach: Geben Sie einfach die von Ihnen gewählte Modelldatei an, legen Sie Ihren sicheren API-Schlüssel für maximalen Schutz fest und konfigurieren Sie den Server so, dass er an Ihrem bevorzugten Port läuft. Diese innovative Einrichtung ermöglicht Ihnen den Zugriff auf Ihre Modelle über eine intuitive Weboberfläche oder programmgesteuert über den API-Server, wodurch sich unbegrenzte praktische Anwendungen ergeben, die Ihre Arbeitsweise verändern.

Ollama bietet eine nahtlose Integration von API-Servern, so dass Sie Ihr lokales LMS mühelos mit anderen Tools und Plattformen verbinden können, um ein Maximum an Effizienz zu erreichen. LM Studio bietet ebenso beeindruckende Funktionen, die es Ihnen ermöglichen, Ihren lokalen API-Server über eine benutzerfreundliche Oberfläche zu verwalten, die Ihnen die vollständige Kontrolle gibt. Durch die Erstellung Ihres eigenen lokalen API-Servers erhalten Sie eine unvergleichliche Flexibilität, um Modelle in realen Szenarien einzusetzen, komplexe Aufgaben zu automatisieren und maßgeschneiderte Lösungen zu erstellen, die perfekt auf Ihre Bedürfnisse zugeschnitten sind - und das alles, während Ihre wertvollen Daten vollkommen sicher und unter Ihrer absoluten Kontrolle bleiben. Ganz gleich, ob Sie bahnbrechende Anwendungen entwickeln oder bestehende Arbeitsabläufe verbessern, ein lokaler API-Server ist Ihr Schlüssel, um das außergewöhnliche Potenzial Ihrer lokalen KI-Infrastruktur zu erschließen.