LLMをローカルで動かす方法:セルフホストAIモデル完全ガイド2025

について AI 革命は起きているが、その恩恵を受けるために機密データをクラウド・サービスに送ったり、月額利用料を支払ったりする必要はない。大規模な言語モデルを自分のコンピューター上でローカルに実行することで、絶対的なプライバシーを維持しつつ、継続的なコストを排除しながら、AIとのやり取りを完全にコントロールすることができます。.

この包括的なガイドでは、適切なツールやモデルの選択から、ハードウェアのパフォーマンスの最適化まで、llms をローカルで実行するために必要なすべてを紹介します。コーディングの支援を求める開発者であろうと、ビジネスにおける 保護 機密性の高いデータ、あるいはオフラインでのアクセスを望むAI愛好家にとって、ローカルのLLMSはクラウドベースの代替案よりも魅力的な利点がある。.

2025年に向けての最適なツール、ハードウエアの必要条件、そして、2025年に向けて、ハードウエアを壊さないようにするために必要なことを説明する。 銀行, また、ステップバイステップのチュートリアルで、最初のローカルLLMを数分で実行できるようになります。最後には、プライバシーや予算を犠牲にすることなく、最先端の言語モデルのパワーを活用する方法を理解できるでしょう。.

何を学ぶか

- LLMの現地運営」の意味と仕組み

- セルフホストAIとクラウドAIのメリット

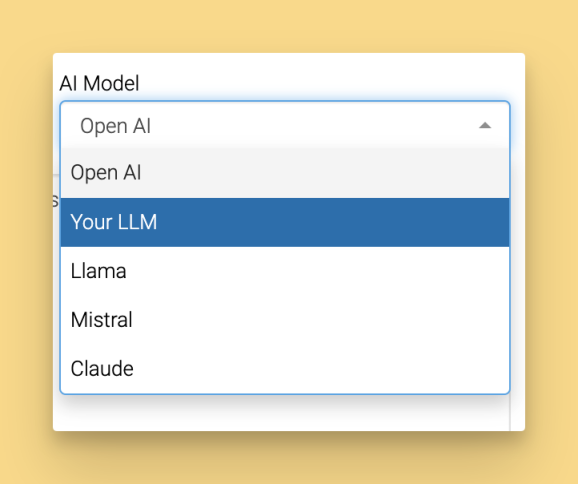

- 2025年のベストツール (LM Studio, Ollama, GPT4All, Jan, llamafile, llama.cpp)

- 2Bから70B+パラメータまでのモデルのハードウェア要件

- 最初のモデルのインストールと実行方法

- 安全なローカルAPIサーバーの作成方法

- 個人とビジネスのワークフローにおける実際の使用例

- 性能のヒント、トラブルシューティング、コスト比較

大規模言語モデル入門

大規模言語モデル(LLM)は革命的だ 人工知能 前例のない精巧さで人間の言語を理解し、生成し、操作するように設計されています。膨大なテキストデータセットで学習することで、これらのゲームチェンジャーとなる大規模な言語モデルは、ワークフローに革命をもたらす首尾一貫した、コンテキストを意識した応答を提供します。チャットボットやバーチャルアシスタントから、言語翻訳、テキストの要約、ユーザーを喜ばせ、結果を導くクリエイティブなコンテンツ生成まで、驚くほど幅広いアプリケーションに絶対不可欠です。.

大規模な言語モデルを自分のコンピュータでローカルに実行することで、クラウドサービスにはない優れた利点が得られます。LLMをローカルで実行する場合、機密データを完全に管理することができ、機密情報がお客様のデバイスから離れることはありません。この強力な戦略は、セキュリティと安心感を高めるだけでなく、外部プロバイダーへの依存をなくし、定期的なサブスクリプション料金をゼロにします。その結果、賢明な個人や先進的な組織は、LLMをローカルで運用することを選択し、セキュリティを犠牲にしたり、継続的なコストを消費したりすることなく、ビジネスの自動化から個人の生産性向上まで、これらのモデルのフルパワーを活用しています。.

最先端モデルの実験に情熱を注いでいる方、成功を拡大するカスタムAIツールの構築に情熱を注いでいる方、よりプライベートで高速なAIエクスペリエンスを求めている方など、LLMをローカルで実行することで、最先端の言語モデルの能力を直接手にすることができます。.

LLMを現地で運営するとはどういうことか?

大規模な言語モデルをローカルで動作させるということは、ChatGPTやClaude、Geminiのようなクラウドサービスに依存するのではなく、高度なAIモデルを自分のコンピュータやローカルマシンで直接操作することを意味します。ローカルでllmを実行すると、推論プロセス全体が自分のハードウェア上で行われ、データはインターネット経由で外部のサーバーに送信されません。.

ローカル推論の主な利点は、完全なデータプライバシー、初期設定後のサブスクリプション費用ゼロ、インターネット接続なしで動作するオフライン機能などです。機密データがデバイスから離れることがないため、ローカル推論は、機密情報を扱う企業、独自のコードに取り組む開発者、プライバシーを気にする個人にとって特に価値のあるものとなります。.

APIキーを必要とし、リクエストごとに課金されるクラウドベースのAIサービスとは異なり、ローカルモデルは、GitHubやHugging Faceなどのリポジトリやソースからモデルをダウンロードし、モデルファイルをコンピュータに保存すれば、無制限に使用することができます。これにより、予測可能なコストが生まれ、ワークフローに影響を与えるAPIレート制限やサービス停止の懸念がなくなります。.

ChatGPTを使用する場合、あなたの質問はOpenAIのサーバーで処理され、返答が返されます。Llama 3.2のようなローカルlimがあなたのマシンで動作している場合、すべてはあなたのコンシューマーハードウェア上で起こります。クラウドサービスは利便性と最先端のモデルを提供しますが、ローカルaiはプライバシー、コントロール、コストの予測可能性を提供します。.

よくある誤解として、llms をローカルで動かすには高価な GPU ハードウェアや複雑な技術設定が必要だというものがあります。LM StudioやGPT4Allのような最新のツールは、プロセスを大幅に簡素化し、多くの小規模なモデルは、十分なRAMを備えた標準的なデスクトップコンピュータで効果的に動作します。.

ローカル環境の設定

ローカルの llms を使い始めるには、お使いのコンピュータを、卓越したパフォーマンスを指先で実現するパワフルな AI パワーハウスに変身させることから始めます。最初のステップは、Windows、macOS、Linux などのオペレーティングシステムが、LM Studio、Ollama、GPT4All などの最先端ツールの完璧な基盤となることを確認することです。これらのゲームチェンジャー・プラットフォームはそれぞれ、ローカル・モデルの管理とインタラクションに合理的でユーザーフレンドリーなアプローチを提供し、エキサイティングなAIへの最初の一歩を踏み出そうとしている人でも、誰でも高度なAIにアクセスできるようにします。 人工知能の世界.

次に、ハードウェアのポテンシャルを最大限に引き出して、驚異的なパフォーマンス向上を実現したい。多くの小型モデルは標準的なデスクトップやラップトップで印象的な結果をもたらしますが、最新のCPU、十分なRAM、そして理想的には専用GPUがあれば、エクスペリエンスがさらに向上し、より大規模で洗練されたモデルを驚くほどスムーズに実行できるようになります。お使いのシステムが、選択したツールやモデルの最低要件を満たしていることを確認することで、比類のないAI能力を発揮できるようになります。.

ハードウェアとオペレーティングシステムが完璧に調整されたら、お好みのツールをインストールし、魔法が起こるのを見ることができます。例えば、LM Studioは、直感的なグラフィカル・インターフェースを提供し、モデル管理を容易にします。一方、Ollamaは、高度なコントロールを開発者に与えるコマンドライン体験を提供します。インストール後は、ローカルマシン上で互換性のあるモデルを直接ブラウズ、ダウンロード、実行することができ、AI体験を完全にコントロールすることができます。.

適切なツールを慎重に選択し、環境を専門的に設定することで、llmsをローカルで実行し、AIの最新の進歩をフルに活用するために必要なすべてのものが装備されます。ローカルのAI機能を得るだけでなく、完全な独立性、強化されたプライバシー、そして人工知能を使った作業方法を変革する電光石火のパフォーマンスを得ることができます。.

クイック・スタート2025年にLLMを現地で運営するためのベストツール

ローカルでllmsを実行するためのツールの状況は劇的に成熟し、ほとんどの技術的な障壁を取り除くユーザーフレンドリーなオプションを提供しています。ここでは、LlamaやDeepSeek R1のような人気モデルをローカルで使用するためのアクセスなど、あらゆるスキルレベルのユーザーがローカルでモデルを実行することを可能にする上位5つのプラットフォームを紹介します:

LM Studioは、直感的なグラフィカル・インターフェースと内蔵のモデル・ブラウザにより、最も初心者に優しいオプションとして優れています。ダウンロード lmstudio.ai また、Windows 11、macOS Ventura+、Ubuntu 22.04+でシームレスなモデル管理をお楽しみいただけます。.

GPT4Allは、LocalDocs機能を通じて優れたドキュメントチャット機能を備えたプライバシー第一のAIに焦点を当てています。gpt4all.ioですべての主要なオペレーティングシステムで利用可能で、50以上の互換性のあるモデルでキュレートされたモデルマーケットプレイスを提供しています。.

Janは、拡張可能なアーキテクチャとローカル/クラウドのハイブリッド機能を備えたChatGPTに代わるオープンソースを提供します。まずは ジャンアイ カスタム拡張機能とリモートAPI統合をサポートしています。.

Ollamaは、開発者に好まれるコマンドラインツールとして、シンプルなモデル管理と優れたAPI統合を提供します。Ollamaのインストールは簡単です。お使いのオペレーティング・システムに合ったインストーラーをダウンロードして実行し、画面の指示に従ってセットアップを完了します。Ollamaをインストールしたら、コマンドラインツールを使ってモデルを管理・実行することができます。主な機能として pull コマンドがあり、ターミナルから直接特定のモデルをダウンロードまたはアップデートし、すぐに使用することができます。.

llamafile は、インストールなしでどこでも実行できる単一ファイルの実行ファイルを通して、ポータブルな AI を提供します。最小限のセットアップが重要な、迅速なテストや配備シナリオに最適です。.

全くの初心者の場合、LM Studioはそのビジュアル・インターフェースと自動GPUアクセラレーションにより、最もスムーズなオンボード・エクスペリエンスを提供します。開発者は一般的に、その柔軟性と既存の開発ワークフローとの統合機能からOllamaを好む。.

これらのツールは、初心者にも上級者にも使いやすいように設計されている。.

ローカルLLMのハードウェア要件

ハードウェアの要件を理解することは、システムに適切なモデルを選択し、現実的な期待性能を設定するのに役立ちます。良いニュースは、最新のローカルLLMは、控えめなラップトップからハイエンドのワークステーションまで、幅広いハードウェア構成で動作することです。.

小さいモデルを動かすための最小スペックは、16GB RAM、インテルi5-8400やAMD Ryzen 5 2600のような最新のCPU、少なくとも50GBの利用可能なストレージです。これらのスペックは、ほとんどのユースケースで許容可能なパフォーマンスで7Bパラメータまでのモデルを処理します。.

最適なパフォーマンスを実現するために推奨されるスペックは、NVIDIA RTX 4060に8GBのビデオRAM、32GBのシステムRAM、そして複数モデル用の100GB以上のストレージです。この構成は、より大きなモデルに対してスムーズな推論を提供し、複数のモデルを同時に実行することを可能にします。.

Phi-3-miniのような小さいモデルは2-4GB、Llama 3.1 70Bのような大きいモデルは量子化によって40-80GB必要です。リソースが限られている場合は、Gemma 2B Instructのような最小のモデルをダウンロードし、ストレージとメモリの使用量を最小限に抑えるとよいでしょう。サイズの異なる複数のモデルを試してみたい場合は、50-100GBの計画を立ててください。.

異なるハードウェア構成での1秒あたりのトークンを示すパフォーマンス比較です:

ハードウェア構成 | ファイ3ミニ(3B) | ラマ 3.1 8B | ミストラル 7B | コードラマ34B |

|---|---|---|---|---|

CPUのみ(16GB RAM) | 8~12トークン/秒 | 4~6トークン/秒 | 3~5トークン/秒 | 推奨しない |

RTX 4060 (8GB VRAM) | 45~60トークン/秒 | 25~35トークン/秒 | 30~40トークン/秒 | 8~12トークン/秒 |

RTX 4090 (24GB VRAM) | 80~120トークン/秒 | 60~80トークン/秒 | 70~90トークン/秒 | 35~45トークン/秒 |

アップルM2プロ(32GB) | 35~50トークン/秒 | 20~30トークン/秒 | 25~35トークン/秒 | 15~20トークン/秒 |

GPUアクセラレーションはパフォーマンスを大幅に向上させますが、GPUリソースが利用できない場合、CPUのみの推論はより小さなモデルでも実行可能です。最適なパフォーマンスは、モデルのサイズを利用可能なビデオラムまたはシステムRAMに合わせることで得られます。.

ローカルで運用するのに最適なオープンソースモデル

適切なモデルの選択は、ハードウェアの能力、使用目的、品質要件によって異なります。オープンソースのモデルは、ローカルのデプロイメントにアクセス可能でありながら、素晴らしい品質レベルに達しています。Ollamaやllama.cppのようなオープンソースのllmプロジェクトが成長している状況は、コミュニティ主導の開発の強さと、主要なAI組織がリリースしたモデルの利用可能性が高まっていることを浮き彫りにしています。.

小型モデル(8GB以下)は、基本的な作業で優れた効率を発揮する:

- Phi-3-mini(パラメータ3.8B)は、コンパクトな2.3GBのパッケージで強力な推論機能を提供し、限られた容量のシナリオに最適です。

- Gemma 2BはGoogleのトレーニングクオリティを1.4GBの超軽量モデルファイルで実現

- Llama 3.2 3Bは、パフォーマンスと効率のバランスが取れたメタの最新アーキテクチャの最適化を提供する。

ミディアムモデル(8~16GB)は、能力とリソース要件のバランスが最も取れている:

- Llama 3.1 8Bは、強力な推論とコード生成で汎用タスクのゴールドスタンダードとして機能する

- ミストラル7Bは、指示に正確に従うことと、複雑な推論タスクを処理することに優れている。

- DeepSeek-Coder 6.7Bは、80以上のプログラミング言語をサポートするコード生成に特化しています。

大容量モデル(16GB以上)は、十分なハードウェアを持つユーザーに最大限の能力を提供する:

- Llama 3.1 70Bは、複雑な推論・分析タスクにGPT-4クラスの性能を提供

- Code Llama 34Bは、ソフトウェアエンジニアリングの概念を深く理解した上で、卓越したコーディング支援を提供します。

すべてのモデルは、“microsoft/Phi-3-mini-4k-instruct ”または “meta-llama/Meta-Llama-3.1-8B-Instruct ”のようなモデルIDで、Hugging Faceから入手可能です。パフォーマンス・ベンチマークによると、8Bパラメータ・モデルは通常、ほとんどのユーザーにとって最高の価値を提供し、85-90%の大型モデル機能を提供しながら、必要なリソースは大幅に少ない。.

LMスタジオ最も簡単な始め方

LM Studio は、 ユーザーフレンドリーなグラフィカルインタフェースを提供し、 技術的な複雑さを抽象化することで、 ローカル Ai アクセシビリティに革命をもたらします。LM Studio と同様のツールは、 グラフィカルおよび Web ベースのオプションを含むユーザインタフェースを提供し、 モデルの管理とインタラクションを簡素化します。また、LM Studio は便利な ウェブ uiにより、ユーザーはブラウザから直接モデルを管理し、操作することができます。このため、llmsをローカルで動かすのが初めてのユーザーにとって、理想的なスタート地点となります。.

まず、LM Studioを以下からダウンロードします。 lmstudio.ai をインストールし、お使いのオペレーティング・システム用の簡単なインストール・プロセスに従います。互換性のあるハードウェアが検出されると、インストーラが自動的に GPU アクセラレーションを設定するため、手動でドライバを設定する必要はありません。インストール後、LM Studio を起動してメインインターフェイスにアクセスし、利用可能なモデルの検索を開始します。.

メイン・インターフェースには3つの主要セクションがあります:利用可能なモデルを閲覧するためのDiscover、ダウンロードしたモデルを管理するためのMy Models、そしてロードされたモデルと対話するためのChatです。Discoverタブでは、検索バーを使って、要件に基づいた特定のモデルを素早く見つけることができます。内蔵モデル・ライブラリには、明確な説明とハードウェア要件を備えた高品質のオープンソース・モデルが集められています。.

チャット・インターフェースを設定するには、ダウンロードしたモデルを読み込み、温度やコンテキストの長さなどの生成パラメータを調整する。インターフェイスは、直感的なスライダーと各設定の説明を提供し、技術的な知識がないユーザーでも実験ができるようになっている。.

開発者のために、LM Studio には OpenAI 互換のエンドポイントを公開するローカル API サーバーが含まれています。設定でこの機能を有効にすると、OpenAIのAPIフォーマットをサポートする既存のアプリケーションとローカルモデルを統合することができます。.

LM Studioに最初のモデルをインストールする

Discoverタブに移動すると、互換性のあるモデルの検索可能なライブラリがあります。llama-3.2-3b-instruct “を検索すると、Metaの効率的な3Bパラメータモデルが見つかります。.

ダウンロードボタンをクリックして処理を開始します。LM Studio は、ダウンロード速度や完了予定時間を示すプログレスインジケータを表示します。ダウンロードマネージャは、ネットワーク接続が回復したときに部分的なダウンロードを再開するなど、中断を優雅に処理します。.

ダウンロードが完了すると、マイモデルセクションにモデルが表示されます。ダウンロードされたモデルファイルは、簡単にアクセスしてロードできるように管理・保存されます。クリックするとメモリにロードされます。モデルのサイズとストレージの速度によりますが、通常10~30秒かかります。インターフェイスにはメモリ使用量が表示され、モデルがインタラクション可能な状態になったことを確認できます。.

量子コンピューティングを簡単に説明してください」や「フィボナッチ数を計算するPython関数を書いてください」などのサンプルプロンプトでインストールをテストしてください。モデルは数秒以内に応答し、セットアップが成功したことを確認します。.

ダウンロードに失敗した場合の一般的なトラブルシューティングには、使用可能なディスク容量の確認、インターネット接続の安定性の確認、ファイアウォールによる LM Studio ネットワークへのアクセスの許可などがあります。内蔵のログには、問題を解決するための詳細なエラー情報が記録されています。.

GPT4All:プライバシー重視のローカルAI

GPT4Allはプライバシーと使いやすさを重視しており、データセキュリティを優先するユーザーにとって最適な選択肢です。このアプリケーションは、モデルがダウンロードされると完全にオフラインで実行されるため、会話がデバイスから離れることはありません。.

gpt4all.ioからGPT4Allをダウンロードし、Windows、macOS、Linuxにインストールしてください。インストールプロセスで自動的にスターターモデルがダウンロードされ、すぐに機能するようになります。最初に起動すると、チャット、モデル、設定間の明確なナビゲーションを備えたクリーンなインターフェイスが表示されます。インストール後、質問に対する回答やコンテンツの作成など、様々なタスクに対してテキストを生成するようモデルを促すことができる。.

モデルマーケットプレイスでは、50以上の厳選されたモデルを、詳細な説明、ハードウェア要件、ユーザー評価とともに提供しています。モデルはサイズや専門分野ごとに分類されており、ユーザーが使用ケースやハードウェアの制約に合わせて適切なオプションを選択できるようになっています。.

GPUアクセラレーションのセットアップはプラットフォームによって異なりますが、一般的にはNVIDIAグラフィックカード用のCUDAドライバのインストールや、macOSのMetalサポートの確保が含まれます。設定パネルは、明確な指示と互換性のあるハードウェア構成の自動検出を提供します。.

ドキュメントチャット用LocalDocsのセットアップ

LocalDocsはGPT4Allの目玉機能で、外部サーバーにコンテンツをアップロードすることなく、個人的なドキュメントでプライベートな会話を可能にします。この機能により、ローカル・ドキュメントを強力なリサーチ・分析ツールに変えることができます。.

専用タブからLocalDocsにアクセスし、PDF、テキストファイル、マークダウンドキュメント、コードリポジトリを含むローカルフォルダを追加します。システムは、.pdf、.txt、.md、.docx、ソースコードファイルなどの一般的なフォーマットをサポートしています。.

インデックス作成プロセスは、ドキュメントの内容を分析し、お使いのデバイスにローカルに保存された検索可能な埋め込みデータを作成します。インデックス作成にかかる時間はドキュメントの量によって異なりますが、通常は数百ページを数分以内に処理します。進捗状況インジケータは、完了ステータスと推定残り時間を表示します。.

インデックス化された文書に対するクエリの例としては、「私の研究論文から得られた主な知見を要約してください」や「私のプロジェクトで最も頻繁に現れるコーディングパターンは何ですか」などがあります。システムは、回答を生成する前に、関連する文書のセクションを検索し、ソースのある根拠のある回答を提供します。 引用.

プライバシー上の利点として、外部サービスへのデータ転送を伴わない完全なオフライン処理が挙げられます。LocalDocsは、機密性の高いビジネス文書や個人的な研究資料に適しています。.

Jan: オープンソース ChatGPT 代替案

Janは、商用AIチャットサービスに代わる包括的なオープンソースとして位置づけられ、オープンソース開発の柔軟性を備えた使い慣れたインターフェースを提供します。このプラットフォームは、最大限の柔軟性を実現するために、ローカル推論とハイブリッドクラウド統合の両方をサポートしています。.

設置場所 ジャンアイ を使用するには、十分なRAMとストレージ容量を含むシステム要件を確認する必要があります。インストーラは自動的にハードウェアの能力を検出し、特定のセットアップに最適な構成設定を提案します。.

インターフェイスツアーでは、モダンなUI要素と直感的なナビゲーションを備えたChatGPTにインスパイアされたデザインをご覧いただけます。会話履歴、機種の切り替え、設定へのアクセスは使い慣れたパターンに従っているため、商用サービスから移行するユーザーの学習曲線が少なくなっています。.

モデルのインポート機能により、LM StudioやOllamaのような他のツールからモデルを持ち込むことができ、冗長なダウンロードを避けることができます。Janは、ローカルまたはハイブリッドで使用するために、互換性のある大規模な言語モデルのインポートをサポートしています。システムは自動的に互換性のあるモデル形式を検出し、最適なパフォーマンスのために必要に応じて変換します。.

拡張機能マーケットプレイスは、コミュニティが開発したプラグインを通じて機能を追加するもので、モデル管理の強化、特殊なチャットモード、外部ツールやサービスとの統合などの分野をカバーしている。.

リモートAPI統合は、一部のリクエストはローカルモデルを使用し、他のリクエストは複雑さやパフォーマンス要件に基づいてクラウドサービスを活用するというハイブリッドな展開を可能にする。このアプローチは、機密性の高いタスクのローカル機能を維持しながら、コストを最適化する。.

Ollama: 開発者に優しいコマンドラインツール

Ollamaは、プログラムによる制御と統合機能を好む開発者のために特別に設計されたコマンドラインツールとして優れています。そのシンプルかつパワフルなインターフェースは、技術的なユーザーにとってモデルの管理とデプロイを簡単にします。.

インストールはオペレーティング・システムによって異なるが、通常、macOSのHomebrew(brew install ollama)、Ubuntuのapt(sudo apt install ollama)、Windowsのwinget(winget install ollama)などのパッケージ・マネージャーを使用する。これらの方法は、適切な依存関係管理とシステム統合を保証する。.

インストール後、ユーザーはモデルのダウンロード、実行、管理のための特定のターミナルコマンドを通してOllamaと対話することができ、コマンドラインから完全に操作することが容易になります。.

必須コマンドは、包括的なモデルライフサイクル管理を提供します:

- ollama pull llama3.1:8bは公式ライブラリからモデルをダウンロードします。

- ollama run llama3.1:8bは指定されたモデルとの対話型チャットセッションを開始する。

- ollamaリストには、インストールされているすべてのモデルが、サイズと変更日とともに表示されます。

- ollama rm model-nameはモデルを削除してストレージスペースを空ける。

Ollamaはローカルサーバーまたはローカル推論サーバーとして設定することができ、他のアプリケーションと統合するためにローカルでモデルをホストし、提供することができます。この設定により、簡単なカスタマイズ、パフォーマンスの向上、シームレスなトラブルシューティングのサポートが可能になります。.

Modelfileを通じてカスタムモデルを作成することで、モデルの動作、システムプロンプト、パラメータを微調整することができます。このテキストベースの設定手法は、バージョン管理や自動化ワークフローとうまく統合されます。.

開発ツールとの統合には、VS Codeのような一般的なIDE用のプラグインが含まれ、開発環境内で直接コード生成と解析を行うことができる。標準化されたAPIフォーマットは、既存のアプリケーションやサービスとの統合を簡素化します。.

Ollamaで複数のモデルを実行する

Ollamaのアーキテクチャはモデルの同時実行をサポートしており、異なるモデルが同時に特殊なタスクに対応することができます。この機能により、より小さなモデルが基本的なタスクを処理し、より大きなモデルが複雑な推論に取り組むという、洗練されたワークフローが可能になります。.

モデルを切り替えるには、ollama run mistral:7bとollama run codellama:7bのような単純なコマンド構文を別々のターミナル・セッションで実行する必要がある。各モデルは独立した会話コンテキストとメモリ割り当てを維持する。.

メモリ管理は、利用可能なシステムリソースとモデル要件に基づいてリソースの割り当てを自動的に処理します。メモリ制約がパフォーマンスに影響を与える可能性がある場合、システムは警告を表示し、最適化戦略を提案します。.

ollama serveを通じてAPIサーバーをセットアップすることで、OpenAIのフォーマットと互換性のあるHTTPエンドポイントを介してモデルを公開します。これにより、クラウドAIサービス用に設計されたアプリケーションとシームレスに統合することができ、完全にローカルインフラ上で動作します。.

Dockerデプロイメントにより、Ollama公式コンテナを通じて本番環境を容易にします。コンテナ化されたアプローチにより、開発環境、ステージング環境、本番環境で一貫した動作が保証され、依存関係の管理も簡素化されます。.

高度なツール: llama.cpp と llamafile

最大限のコントロールとパフォーマンスの最適化を求める上級ユーザーには、llama.cpp や llamafile のような低レベルのツールが有効です。llama.cppでモデルを実行するためには、ユーザーはggufモデルファイルをダウンロードする必要があります。これらのツールは、柔軟性と効率性のために利便性を犠牲にしているため、本番展開や特殊な要件に最適です。.

ユーザーフレンドリーなアプリケーションと高度なツールのどちらを選ぶかは、特定のニーズによって決まる。カスタムコンパイルオプション、特殊なハードウェアサポート、推論エンジンの完全な制御が必要な大規模システムへの統合が必要な場合は、高度なツールを選択する。また、ユーザーは、特定のタスクやドメインのためにファインチューニングされたモデルを実行し、要件に合わせた最適なパフォーマンスを達成することができます。.

GPUをサポートするllama.cppをコンパイルするには、特定のハードウェアターゲット用にビルドシステムを設定する必要があります。CUDAのサポートにはNVIDIAドライバとツールキットのインストールが必要で、MetalのサポートはApple SiliconがあればmacOS上で自動的に動作し、OpenCLはベンダー間でより幅広いGPU互換性を提供します。.

高度なツールによるパフォーマンスの最適化には、カスタム量子化スキーム、メモリマッピングの最適化、特殊な注意の実装などが含まれる。これらの最適化により、汎用ソリューションと比較して推論速度を大幅に向上させ、メモリ要件を削減することができます。.

llamafile実行ファイルは、モデルと推論エンジンを単一のファイルにパッケージ化し、インストールなしで実行することで、ポータブルなAIデプロイメントを提供します。このアプローチは、従来のインストールプロセスが実行不可能であったり、望ましいものでなかったりする場合のデプロイシナリオを簡素化します。.

高度なツールで利用可能なモデル量子化技術には、4ビット、8ビット、および混合精度フォーマットがあり、性能をほとんど維持したままモデルサイズを縮小することができます。ユーザーは、さまざまな量子化スキームを試して、特定のユースケースに最適なバランスを見つけることができます。.

ローカルAPIサーバーの作成

ローカルの API サーバは、llm モデルに究極の統合ソリューションを提供し、データやインフラストラクチャを完全に制御しながら、他のアプリケーションとのシームレスな接続を実現します。LM Studio と Ollama は、直感的なグラフィカル・インターフェースやコマンドラインの正確さを問わず、エンタープライズグレードの機能を直接利用できる、強力でわかりやすい導入オプションを提供します。.

開始するには、LM Studio または Ollama のいずれかを選択し、インフラストラクチャにインストールします。一度デプロイされると、ハードウェア機能とビジネス要件に完全に一致する llm モデルをダウンロードし、最適なリソース利用を保証します。コンテキストの長さなどの重要なパフォーマンス・パラメータを設定し、システムがサポートしている場合は GPU アクセラレーション機能をアンロックして、アプリケーションが要求するハイパフォーマンスな結果を提供します。.

ローカル API サーバの起動は、これ以上ないほどシンプルです:LM Studio では直感的な設定インターフェイスでサーバーのアクティベーションが可能であり、Ollama ではターミナルベースのコントロールで柔軟な運用が可能です。API サーバーは専用ポートで動作し、アプリケーションからのリクエストを処理し、生成されたテキストレスポンスをエンタープライズレベルの信頼性とスピードで提供します。.

ローカルAPIサーバーの運用により、カスタムチャットボットの構築、複雑なワークフローの自動化、高度な言語機能のソフトウェアエコシステムへの直接統合を自由に行うことができます。これは単なる技術的なセットアップではなく、スケーラブルで安全かつ洗練された言語処理機能へのゲートウェイなのです。.

APIキーでローカルLLMを保護する

ローカルのLLMへのアクセスを保護することは不可欠であるだけでなく、AIの導入を潜在的な脆弱性から制御されたイノベーションの要塞へと変える基盤でもあります。複数のアプリケーションやユーザーを接続する場合、apiキーシステムを実装することは、ゲームを変える戦略となり、許可されたリクエストのみがモデルのパワーを解き放つことができるようにする一方で、無許可のアクセスを抑えることができます。.

アプリケーションやユーザーごとに一意の API キーを生成し、ローカルの llm の機能を活用することで、セキュリティのアプローチを変革します。これらのデジタルキーを貴重な資産のように環境変数や暗号化された設定ファイルに保存し、競争上の優位性を損なうような偶発的な漏洩を防ぎます。ローカルapiサーバを構成し、リクエストのたびにapiキーの検証を要求することで、ドアをノックされる前に不正アクセスをブロックするバリアを構築します。.

apiキーを定期的にローテーションすることで、潜在的な侵害のリスクを削減し、不要になったキーや侵害された可能性のあるキーを失効させる決定的なアクションを取ることで、セキュリティ戦略を強化します。業界をリードするこれらのプラクティスを採用することで、単にコントロールを維持するだけでなく、ローカルの llm に対する完全な優位性を確立し、貴重なモデルと、妥協のない精度で処理されるすべての機密データの両方を保護することができます。.

実用例と使用例

llmsをローカルで実行することで、仕事でもプライベートでも数多くの実用的なアプリケーションが可能になる。プライバシー、無制限の使用、オフライン機能の組み合わせは、クラウドサービスでは提供できない可能性を開く。.

コード生成とデバッグは、ローカルAIの主要なユースケースである。DeepSeek-CoderやCode Llamaのようなモデルは、プログラミング・コンテキストの理解、定型コードの生成、複雑なアルゴリズムの説明、80以上のプログラミング言語にわたるバグ修正の提案に優れています。.

コンテンツ作成ワークフローは、ローカルモデルの無制限の生成機能から恩恵を受ける。ブログ記事、Eメール、, マーケティング コピーやソーシャルメディアコンテンツは、APIコストや料金制限なしで反復的に生成できる。特定の文体についてローカルモデルを微調整する機能により、次のことが追加されます。 パーソナル化 クラウドサービスでは不可能だ。.

データ分析および要約タスクは、外部への送信なしに機密情報を処理するローカルモデルの能力を活用します。財務報告書、法律文書、医療記録、独自の調査などを、完全な機密性を保ちながら分析することができます。.

外部サービスを利用しない言語翻訳は、数十の言語ペアをサポートしながら、機密性の高い通信にプライバシーを提供します。ローカルモデルでは、技術文書翻訳、多言語カスタマーサポート、国際的なビジネスコミュニケーションを完全にオフラインで処理します。.

実際の例としては、文書分析にローカルモデルを使用する法律事務所、AIを搭載したコーディングアシスタントを実装するソフトウェア会社、パーソナライズされたライティングツールを開発するコンテンツクリエイターなどがある。これらのソリューションはいずれもユーザーのハードウェア上でローカルに実行され、プライバシーと制御を保証している。これらのアプリケーションは、ローカルai展開の多用途性と実用的価値を実証している。.

パフォーマンスの最適化とトラブルシューティング

ローカルllmsのパフォーマンスを最大化するには、システムリソース、モデルの特性、最適化テクニックを理解する必要があります。適切な設定を行うことで、レスポンスタイムを劇的に改善し、控えめなハードウェアでより大きなモデルを実現することができます。.

GPUアクセラレーションのセットアップはベンダーによって異なりますが、一般的には、適切なドライバをインストールし、利用可能なハードウェアを認識するようにソフトウェアを設定します。NVIDIAユーザーはCUDAツールキットのインストールが必要ですが、AMDユーザーはサポートされているLinuxディストリビューションでROCmのセットアップが必要です。.

モデルの量子化により、モデル・パラメータを低精度レベルで保存することで、メモリ要件が削減されます。4ビット量子化により、通常、95%+の品質を維持したまま、モデルサイズを75%削減することができ、ビデオラムに制限のある民生用ハードウェアで大きなモデルにアクセスできるようになります。.

よくあるエラーメッセージとその解決策は以下の通り:

- “CUDAのメモリ不足”:モデルサイズを小さくする、他のアプリケーションを終了する、またはCPUオフロードを有効にする

- “「モデルの読み込みに失敗しました:モデルファイルの整合性と十分なディスク容量を確認してください。

- “「推論速度が遅いGPUアクセラレーション設定をチェックし、モデルの量子化を検討する

推論中のリソース監視は、ボトルネックの特定と構成の最適化に役立ちます。Windowsのタスクマネージャ、macOSのアクティビティモニタ、Linuxのhtopは、モデル実行中のCPU使用率、メモリ使用率、GPUアクティビティパターンを明らかにします。.

温度とサンプリングパラメーターの調整は、出力品質と速度に影響する。低い温度はより一貫性のある出力を生み出し、高い値は創造性を高める。Top-kおよびTop-pサンプリング・パラメーターは、レスポンスの多様性と一貫性のバランスをとる。.

コンテキストの長さの最適化は、メモリ使用量と会話能力のバランスをとる。長いコンテキストはより洗練された対話を可能にするが、それに比例してより多くのメモリを必要とする。ほとんどのユースケースは2048-4096トークンコンテキストでうまく機能します。.

ローカルLLMセットアップのベストプラクティス

ローカルのllmから最大限の価値を引き出すには、最高のパフォーマンスと弾丸のようなセキュリティの両方を提供する勝利の戦略が必要です。まずは、お客様独自のニーズに最適なモデルを選択することから始めましょう。モデル・パラメータ、サイズ仕様、ターゲット・アプリケーションを深く掘り下げ、お客様のハードウェア機能と特定のユースケース要件に理想的にマッチするモデルを発見してください。.

コンテキストの長さなどの重要なモデル・パラメータを微調整し、可能な限りGPUアクセラレーションを有効化することで、ゲームを変えるパフォーマンス・レベルを達成し、セットアップを強化します。オペレーティング・システムが、選択したツールおよびllmモデルと完璧な互換性を提供することを確認し、システムおよびソフトウェア・スタック全体を最新の状態に保ち、最新の画期的な機能と最先端のセキュリティ強化を活用します。.

システムリソースをアクティブに監視し、RAM と GPU の使用率を追跡することで、ボトルネックに先回りして、特に大規模なモデルを展開する場合や複数のモデルを並行して実行する場合に、パフォーマンスの障害を防ぎます。LM Studio や GPT4All のような直感的なグラフィカル・インターフェイスを使用してワークフローを変革することで、モデル管理や設定の最適化を驚くほど簡単に行うことができます。.

最も重要なものを保護し、機密データを常にローカル環境内に保持し、インターネットチャネルを介して機密情報を送信するリスクを回避します。特定のアプリケーションに最適なソリューションを活用するために、さまざまなモデルを継続的にテスト・評価し、要件の成長と進化に合わせて微調整や新しいモデルへの移行ができる柔軟性を備えています。.

これらの実績あるベストプラクティスを導入することで、セキュアで光速、かつ正確に調整されたローカルなllm環境を構築し、お客様独自の要件を上回る優れた結果を提供し、卓越した成果を促進します。.

コスト分析:ローカルAIサービスとクラウドAIサービス

ローカルAIサービスとクラウドAIサービスの経済性を理解することは、インフラ投資に関する十分な情報に基づいた意思決定に役立ちます。分析には、ハードウェアの初期費用、継続的な費用、使用パターンに基づく損益分岐点の計算が含まれる。.

有能なローカルAIシステムのハードウェアへの先行投資は、ミッドレンジの構成で$800-1,500、ハイエンドのセットアップで$3,000-5,000です。これらのコストには、最新のCPU、十分なRAM、高性能GPU、複数モデル用の十分なストレージが含まれる。.

クラウドAIサービスの月額利用料は様々です:ChatGPT Plusは$20/月、Claude Proは$20/月、API利用はボリュームに応じて$10-500/月以上です。企業向けプランでは、1ユーザーあたり月額$100を超えることが多い。.

損益分岐点分析によると、中規模から大規模のユーザーは、通常6~18ヶ月以内にハードウェア投資を回収できることが明らかになった。機密データを処理するユーザーや、24時間365日の可用性を必要とするユーザーは、純粋なコストとは関係なく、ローカルのインフラを正当化することが多い。.

ローカルモデルを継続的に稼動させるためのエネルギーコストは、ハードウェアの効率や地域の光熱費にもよりますが、電気代に毎月約$30~100追加されます。最新のGPUには、アイドル時の消費電力を削減する電源管理機能が搭載されています。.

2~3年間の総所有コスト計算では、一般的にローカル・ソリューションが有利である:

- AIの利用パターンが中程度から多いユーザー

- データプライバシー・コンプライアンスを必要とする組織

- 可用性の保証が必要なアプリケーション

- 無制限の実験能力を求めるチーム

クラウドサービスは依然として経済的である:

- 月間の使用量が少ない、たまにしか使用しないユーザー

- 最先端モデルへのアクセスを必要とするチーム

- ITインフラの専門知識を持たない組織

- シームレスなスケーリング機能を必要とするアプリケーション

この決定には多くの場合、プライバシーの要件を含む非金融的要因が含まれる、, データ主権, インターネット接続の信頼性、組織的な統制の好みなど、初期費用は高くつくものの、ローカル展開のほうにバランスが傾く。.

ローカルの大規模言語モデルは、民主化された、プライベートでコスト効率の高いAI導入への基本的なシフトを象徴している。モデルがより効率的になり、ツールがよりユーザーフレンドリーになるにつれて、能力が急速に拡大する一方で、参入障壁は下がり続けている。.

コーディング支援を求める開発者、機密データを保護するビジネス、AIの可能性を探求する愛好家のいずれであっても、llmsをローカルで実行することで、AIエクスペリエンスをかつてないほどコントロールすることができます。LM StudioやGPT4Allのようなユーザーフレンドリーなツールから始め、さまざまなモデルを試して理想的な機能とパフォーマンスのバランスを見つけ、ニーズの変化に応じて徐々にセットアップを拡張していきましょう。.

AIの未来は、巨大なデータセンターだけでなく、あなた自身のハードウェア上で、あなたの完全なコントロール下にあります。今すぐ最初のローカルモデルをダウンロードして、セルフホスト型人工知能の自由を体験してください。.

ローカルAI入門

ローカルAIは、大規模な言語モデルのフルパワーを自分のコンピュータに直接取り込むことで、個人や組織が人工知能を活用する方法に革命をもたらします。クラウドベースのサービスに依存する代わりに、llmsをローカルで実行することは、すべての処理があなたのデバイス上で行われることを意味し、モデルのパラメータや機密データの取り扱い方法を完全に制御することができます。このアプローチは、あなたのデータがあなたのマシンから離れることがないため、プライバシーが強化されるだけでなく、待ち時間が短縮され、応答がこれまで以上に速く、信頼できるものになります。.

ローカル AI を使用することで、特定のタスクに最適化したり、さまざまな設定を試してみたりと、独自のニーズに合わせて大規模な言語モデルを微調整することができます。llms をローカルで実行することで、モデルのカスタマイズ、アップデートの管理、ワークフローに合わせたソリューションの展開が可能になります。より多くのユーザがローカル展開の価値を発見するにつれて、ツールやモデルのエコシステムは急速に拡大し続け、最先端の大規模言語モデルllmsの能力を自分のコンピュータで活用することがこれまで以上に簡単になりました。.

ローカルLLMを始める

ゲームチェンジャー的なツールや、指先一つでパワフルなモデルのエコシステムが広がっているおかげで、ローカルLLMの旅はかつてないほど身近なものになりました。まず、LM Studio や Ollama のようなプラットフォームを選択することから始めましょう。LM Studio は、お客様のマシン上で直接 LLM を実行するプロセスを簡素化し、効率化します。これらのソリューションは、直感的なグラフィカル・インターフェイスを備えたLM Studioや、効率的なコマンドライン・アプローチを備えたOllamaなど、ユーザーの好みに合わせたユーザーフレンドリーなエクスペリエンスを提供するため、技術的に快適なワークフローを選択することができます。.

お好みのプラットフォームをインストールした後、統合された検索機能を活用して、Hugging Faceのような信頼できるリポジトリから利用可能なモデルを簡単に閲覧できます。選択したモデル・ファイルをそのままローカル・セットアップにダウンロードし、ハードウェアの互換性を保証します。一度設定すれば、ローカルの推論サーバーをアクティブにすることができ、グラフィカル・インターフェースまたはコマンドライン操作のいずれかを通じてモデルと対話することができます。この強力なセットアップにより、複数のモデルで実験したり、ローカルのLLMエコシステムを効率的に管理したり、外部のクラウドインフラストラクチャに依存することなくローカル処理の完全なメリットを享受したりする柔軟性が実現します。.

ローカル推論サーバーのセットアップ

ローカル推論サーバは、ローカルで llms を動作させるための画期的なバックボーンであり、選択したモデルを劇的に効率的かつセキュアな環境でデプロイ、管理、操作できるようにします。LM Studio や Ollama のような画期的なツールにより、ローカル推論サーバーのセットアップが驚くほど合理化され、AI を全く知らないユーザーでも強力な結果を得ることができます。このポテンシャルを引き出すには、目的のモデルファイルを選択し、コンテキストの長さなどの重要なパラメータを設定し、利用可能な場合は GPU アクセラレーションを有効にして、爆発的なパフォーマンス向上を実現するだけです。.

OllamaはGPUアクセラレーションなどの高度な機能を提供し、互換性のあるハードウェア上でモデル推論を劇的に高速化し、ワークフローを完全に変革します。推論サーバーのポートを正確に指定することで、Web ui から簡単にアクセスできたり、他のアプリケーションとシームレスに統合できたりと、柔軟性を最大限に高めることができます。LM Studio のセットアップも同様に合理化されており、直感的でユーザーフレンドリーなインターフェイスでモデルやサーバーの設定を管理することができます。ローカルの推論サーバを運用することで、ローカルで llms を実行し、選択したモデルの制限のない能力をフルに活用するための、パワフルで完全にプライベートな環境を指揮することができます。.

一般的なツールを使ってローカルでLLMを実行する

適切なツールを選択することが、llms をローカルで実行する際のシームレスなエクスペリエンスを実現する鍵です。LM Studio、Ollama、GPT4All は、最も信頼されているソリューションのひとつであり、それぞれワークフローのニーズに合わせて設計された独自の機能を備えています。LM Studio は、直感的なグラフィカル・インターフェースにより、複数のモデルの管理、モデル間のシームレスな切り替え、プロジェクトに最適な結果を得るための設定の微調整を簡単に行うことができます。Ollamaは、高度なワークフローをサポートし、開発エコシステムと完璧に統合する堅牢なコマンドライン・エクスペリエンスを提供します。.

GPT4Allは、Mistral 7Bのような一般的なオプションを含む広範なモデルをサポートし、ローカルAIと対話するための合理的なインターフェースを提供します。これらのプラットフォームは、単にモデルを実行するだけでなく、apiサーバーを簡単にセットアップできるようにし、既存のアプリケーションやサービスとのシームレスな統合を可能にします。複数のモデルを管理している場合でも、微調整を試している場合でも、ローカルのLLMSを使い始めたばかりの場合でも、これらのプラットフォームは、ローカルAIの可能性を最大限に引き出すために必要な柔軟性とパワーを提供します。.

ローカルAPIサーバーの作成

アプリケーションやワークフローへの大規模な言語モデルの統合に革命を起こしたい人にとって、ローカル API サーバーの設定は究極の変革です!LM Studio や Ollama のような強力なツールを使えば、自分専用のローカル api サーバを作成することが驚くほど簡単になります。選択したモデルファイルを指定し、最大限の保護のためにセキュアな api キーを設定し、希望のポートで動作するようにサーバを設定するだけです。この最先端のセットアップにより、直感的なWeb UIやapiサーバーを介したプログラムによってモデルにアクセスすることができ、作業方法を変える無限の実用的なアプリケーションを解き放つことができます。.

Ollama はシームレスな api サーバー統合を提供し、ローカルの llms を他のツールやプラットフォームと簡単に接続することができます。LM Studio も同様に素晴らしい機能を提供し、美しいユーザーフレンドリーなインターフェイスでローカルの api サーバを管理することができます。独自のローカル api サーバを作成することで、比類のない柔軟性を得ることができ、モデルを実際のシナリオに展開したり、複雑なタスクを自動化したり、ニーズにぴったり合ったカスタムソリューションを構築したりすることができます。画期的なアプリケーションを開発する場合でも、既存のワークフローを強化する場合でも、ローカルapiサーバーは、ローカルaiインフラストラクチャの並外れた可能性を引き出す鍵となります。.