كيفية تشغيل النماذج ذاتية الاستضافة محلياً: الدليل الكامل لعام 2025 لنماذج الذكاء الاصطناعي المستضافة ذاتيًا

إن الذكاء الاصطناعي تحدث ثورة، ولكنك لست بحاجة إلى إرسال بياناتك الحساسة إلى الخدمات السحابية أو دفع رسوم اشتراك شهرية للاستفادة منها. يمنحك تشغيل النماذج اللغوية الكبيرة محلياً على حاسوبك الخاص تحكماً كاملاً في تفاعلاتك مع الذكاء الاصطناعي مع الحفاظ على الخصوصية المطلقة والتخلص من التكاليف المستمرة.

في هذا الدليل الشامل، ستكتشف في هذا الدليل الشامل كل ما تحتاجه لتشغيل برمجيات llms محلياً، بدءاً من اختيار الأدوات والنماذج المناسبة إلى تحسين الأداء على أجهزتك. سواء كنت مطورًا يسعى للحصول على مساعدة في البرمجة، أو كنت مطورًا في مجال الحماية البيانات الحساسة، أو من عشاق الذكاء الاصطناعي الذين يرغبون في الوصول إليها دون اتصال بالإنترنت، فإن نظم إدارة المحتوى المحلية توفر مزايا مقنعة مقارنةً بالبدائل المستندة إلى السحابة.

سنستعرض أفضل الأدوات لعام 2025، ومتطلبات الأجهزة التي لن تكسر البنك, والبرامج التعليمية المفصلة خطوة بخطوة لتشغيل أول برنامج لغوي محلي لك في دقائق. بحلول النهاية، ستفهم كيفية تسخير قوة أحدث النماذج اللغوية دون المساس بخصوصيتك أو ميزانيتك.

ما ستتعلمه

- ما المقصود بـ “تشغيل LLMs محلياً” وكيف يعمل

- مزايا الذكاء الاصطناعي المستضاف ذاتيًا مقابل الذكاء الاصطناعي السحابي

- أفضل الأدوات لعام 2025 (LM Studio، Ollama، GPT4All، Jan، llamafile، llama.cpp)

- متطلبات الأجهزة للموديلات من 2B إلى 70B+ معلمات

- كيفية تثبيت النموذج الأول وتشغيله

- كيفية إنشاء خادم API محلي آمن

- حالات الاستخدام الواقعية لسير العمل الشخصي والتجاري

- نصائح حول الأداء واستكشاف الأخطاء وإصلاحها ومقارنات التكلفة

مقدمة في النماذج اللغوية الكبيرة

النماذج اللغوية الكبيرة (LLMs) ثورية الذكاء الاصطناعي أنظمة تُغيّر طريقة تفاعلك مع التكنولوجيا، وهي مصممة لفهم اللغة البشرية وتوليدها ومعالجتها بتطور غير مسبوق. من خلال التدريب على مجموعات بيانات هائلة من النصوص، تقدم هذه النماذج اللغوية الكبيرة التي تغير قواعد اللعبة استجابات متماسكة ومدركة للسياق تُحدث ثورة في سير عملك، مما يجعلها ضرورية للغاية لمجموعة مذهلة من التطبيقات، بدءًا من روبوتات الدردشة الآلية والمساعدين الافتراضيين إلى الترجمة اللغوية وتلخيص النصوص وتوليد المحتوى الإبداعي الذي يسعد المستخدمين ويحقق النتائج.

يوفر تشغيل نماذج اللغات الكبيرة محلياً على جهاز الكمبيوتر الخاص بك مزايا استثنائية لا يمكن للخدمات السحابية أن تضاهيها. عندما تقوم بتشغيل نماذج اللغات الكبيرة محلياً، فإنك تحافظ على تحكمك الكامل في بياناتك الحساسة، مما يضمن عدم خروج المعلومات السرية من جهازك أبداً، وهو نهج الخصوصية أولاً الذي يبني الثقة. لا تعزز هذه الاستراتيجية الفعّالة الأمان وراحة البال فحسب، بل إنها تلغي أيضاً الاعتماد على مقدمي الخدمات الخارجيين وتخفض رسوم الاشتراك المتكررة إلى الصفر. نتيجةً لذلك، يختار الأفراد الأذكياء والمؤسسات ذات التفكير المستقبلي تشغيل أجهزة LLM محلياً، والاستفادة من القوة الكاملة لهذه النماذج في كل شيء بدءاً من أتمتة الأعمال إلى الإنتاجية الشخصية، دون التضحية بالأمان أو التضحية بالتكاليف المستمرة.

سواءً كنت شغوفاً بتجربة النماذج المتطورة، أو بناء أدوات مخصصة مدعومة بالذكاء الاصطناعي لتوسيع نطاق نجاحك، أو ببساطة تسعى إلى تجربة ذكاء اصطناعي أكثر خصوصية وسرعة في التنفيذ، فإن تشغيل نماذج LLMs محلياً يضع قدرات أحدث النماذج اللغوية بين يديك مباشرة، مما يمكّنك من الابتكار بشكل أسرع، والبقاء آمناً، وتقديم نتائج استثنائية.

ماذا يعني تشغيل LLMs محلياً؟

يعني تشغيل النماذج اللغوية الكبيرة محلياً تشغيل نماذج الذكاء الاصطناعي المتطورة مباشرةً على حاسوبك أو جهازك المحلي بدلاً من الاعتماد على الخدمات السحابية مثل ChatGPT أو Claude أو Gemini. عند تشغيل llm محليًا، تحدث عملية الاستدلال بأكملها على أجهزتك الخاصة، دون نقل البيانات عبر الإنترنت إلى خوادم خارجية.

تشمل المزايا الأساسية لبرامج الاستدلال المحلية خصوصية البيانات الكاملة، وعدم وجود تكاليف اشتراك بعد الإعداد الأولي، ووظيفة عدم الاتصال بالإنترنت التي تعمل دون اتصال بالإنترنت. لا تغادر بياناتك الحساسة جهازك أبدًا، مما يجعل الاستدلال المحلي ذا قيمة خاصة للشركات التي تتعامل مع المعلومات السرية أو المطورين الذين يعملون على كود الملكية أو الأفراد المهتمين بالخصوصية.

على عكس خدمات الذكاء الاصطناعي المستندة إلى السحابة التي تتطلب مفاتيح واجهة برمجة التطبيقات (API) وتتقاضى رسومًا مقابل كل طلب، توفر النماذج المحلية استخدامًا غير محدود بمجرد تنزيل النموذج من مستودعات أو مصادر مثل GitHub أو Hugging Face وحفظ ملف النموذج على جهاز الكمبيوتر الخاص بك. يؤدي هذا إلى تكاليف يمكن التنبؤ بها ويزيل المخاوف بشأن حدود معدل واجهة برمجة التطبيقات أو انقطاع الخدمة الذي يؤثر على سير عملك.

توضّح المقارنة العملية الفرق: عند استخدام ChatGPT، تنتقل أسئلتك إلى خوادم OpenAI للمعالجة قبل إعادة الردود. أما عند استخدام الذكاء الاصطناعي المحلي مثل Llama 3.2 الذي يعمل على جهازك، فإن كل شيء يحدث على أجهزتك الاستهلاكية. في حين أن الخدمات السحابية توفر الراحة والنماذج المتطورة، فإن الذكاء الاصطناعي المحلي يوفر الخصوصية والتحكم وإمكانية التنبؤ بالتكلفة التي يجدها العديد من المستخدمين مقنعة.

تشمل المفاهيم الخاطئة الشائعة الاعتقاد بأن تشغيل llms محلياً يتطلب أجهزة باهظة الثمن لوحدة معالجة الرسومات أو إعدادات تقنية معقدة. لقد سهّلت الأدوات الحديثة مثل LM Studio و GPT4All العملية بشكل كبير، وتعمل العديد من النماذج الأصغر حجماً بفعالية على أجهزة كمبيوتر مكتبية قياسية بذاكرة وصول عشوائي كافية.

إعداد بيئة محلية

يبدأ الشروع في استخدام برمجيات llms المحلية بتحويل جهاز الكمبيوتر الخاص بك إلى قوة ذكاء اصطناعي قوية توفر أداءً استثنائياً في متناول يدك. تتمثل الخطوة الأولى في ضمان أن يصبح نظام التشغيل الخاص بك، سواءً كان ويندوز أو ماك أو لينكس، الأساس المثالي للأدوات المتطورة التي ستستفيد منها، مثل LM Studio أو Ollama أو GPT4All. تقدم كل من هذه المنصات التي تغير قواعد اللعبة نهجًا مبسطًا وسهل الاستخدام لإدارة النماذج المحلية والتفاعل معها، مما يجعل الذكاء الاصطناعي المتقدم في متناول الجميع، حتى أولئك الذين يخطون خطواتهم الأولى في هذا المجال المثير عالم الذكاء الاصطناعي.

بعد ذلك، ستحتاج بعد ذلك إلى زيادة إمكانات أجهزتك إلى أقصى حد لتحقيق مكاسب مذهلة في الأداء. في حين أن العديد من النماذج الأصغر تقدم نتائج مبهرة على أجهزة الكمبيوتر المكتبية أو المحمولة القياسية، فإن امتلاك وحدة معالجة مركزية حديثة، وذاكرة وصول عشوائي كافية، ووحدة معالجة رسومات مخصصة، من الناحية المثالية، سيزيد من تجربتك ويتيح لك تشغيل نماذج أكبر وأكثر تطوراً بسلاسة ملحوظة. من خلال التأكد من أن نظامك يفي بالحد الأدنى من المتطلبات للأداة والنموذج الذي اخترته، فإنك بذلك تهيئ نفسك لقدرات ذكاء اصطناعي لا مثيل لها.

بمجرد أن تتوافق أجهزتك ونظام التشغيل بشكل مثالي، يمكنك تثبيت أداتك المفضلة ومشاهدة السحر يحدث. يوفر LM Studio، على سبيل المثال، واجهة رسومية بديهية تجعل إدارة النماذج بسيطة دون عناء، بينما يوفر Ollama تجربة سطر أوامر تمكّن المطورين من التحكم المتقدم. بعد التثبيت، ستتمتع بحرية تصفح النماذج المتوافقة وتنزيلها وتشغيلها مباشرةً على جهازك المحلي، مما يمنحك تحكمًا كاملاً في تجربة الذكاء الاصطناعي.

من خلال اختيار الأداة المناسبة بعناية والتأكد من تهيئة بيئتك بخبرة عالية، ستكون مجهزاً بكل ما تحتاجه لتشغيل برمجيات الذكاء الاصطناعي محلياً والاستفادة من القوة الكاملة لأحدث التطورات في مجال الذكاء الاصطناعي. لن تحصل فقط على إمكانات الذكاء الاصطناعي المحلية، بل ستحصل على استقلالية تامة وخصوصية محسّنة وأداء فائق السرعة يغيّر طريقة عملك مع الذكاء الاصطناعي.

بداية سريعة: أفضل الأدوات لتشغيل الآليات المحلية في عام 2025

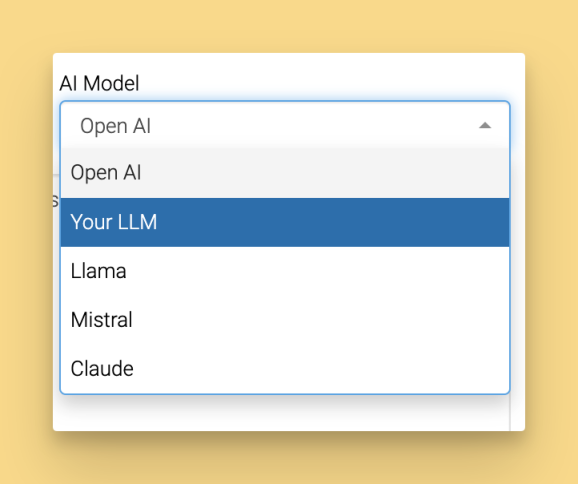

لقد نضج مشهد أدوات تشغيل النماذج المحلية بشكل كبير، مما يوفر خيارات سهلة الاستخدام تزيل معظم الحواجز التقنية. فيما يلي أهم خمس منصات تجعل تشغيل النماذج محلياً في متناول المستخدمين على جميع مستويات المهارة، بما في ذلك الوصول إلى النماذج الشائعة مثل Llama و DeepSeek R1 للاستخدام المحلي:

يتفوق LM Studio باعتباره الخيار الأكثر ملاءمة للمبتدئين بفضل واجهته الرسومية البديهية ومتصفح النماذج المدمج. التنزيل من lmstudio.ai والاستمتاع بإدارة سلسة للنموذج عبر نظام ويندوز 11، و+ماك فينتورا +، و+Ubuntu 22.04.

يركّز GPT4All على الذكاء الاصطناعي الذي يركّز على الخصوصية أولاً مع إمكانات ممتازة للدردشة مع المستندات من خلال ميزة LocalDocs. وهو متاح على gpt4all.io لجميع أنظمة التشغيل الرئيسية، ويوفر سوقاً للنماذج المنسقة مع أكثر من 50 نموذجاً متوافقاً.

يوفّر Jan بديلاً مفتوح المصدر لـ ChatGPT مع بنية قابلة للتوسعة وقدرات محلية/سحابية هجينة. ابدأ العمل على جان.آي مع دعم الامتدادات المخصصة وتكامل واجهة برمجة التطبيقات عن بُعد.

يعمل Ollama كأداة سطر الأوامر المفضلة للمطورين، حيث يوفر إدارة بسيطة للنماذج وتكامل ممتاز لواجهة برمجة التطبيقات. تثبيت Ollama سهل ومباشر: قم بتنزيل وتشغيل أداة التثبيت لنظام التشغيل الخاص بك، ثم اتبع التعليمات لإكمال الإعداد. بمجرد تثبيت أولاما، يمكنك استخدام أداة سطر الأوامر لإدارة النماذج وتشغيلها. الميزة الرئيسية هي أمر السحب، الذي يسمح لك بتنزيل أو تحديث نماذج محددة مباشرةً من المنصة للاستخدام الفوري.

يوفر ملف llamafile ذكاءً اصطناعيًا محمولاً من خلال ملفات تنفيذية أحادية الملف تعمل في أي مكان دون تثبيت. مثالي للاختبار السريع أو سيناريوهات النشر حيث يكون الحد الأدنى من الإعداد أمرًا بالغ الأهمية.

بالنسبة للمبتدئين تمامًا، يوفر LM Studio تجربة الاستخدام الأكثر سلاسة من خلال واجهته المرئية والتسريع التلقائي لوحدة معالجة الرسومات. ويفضل المطورون عادةً Ollama لمرونته وقدراته على التكامل مع مهام سير عمل التطوير الحالية.

تم تصميم هذه الأدوات لتوفير تجربة سهلة الاستخدام للمستخدمين المبتدئين والمتقدمين على حد سواء.

متطلبات الأجهزة لأجهزة LLM المحلية

يساعدك فهم متطلبات الأجهزة على اختيار النماذج المناسبة لنظامك وتحديد توقعات أداء واقعية. والخبر السار هو أن أنظمة الإعلام الآلي المحلية الحديثة تعمل على مجموعة واسعة من تكوينات الأجهزة، بدءاً من أجهزة الكمبيوتر المحمولة المتواضعة إلى محطات العمل المتطورة.

تتضمن المواصفات الدنيا لتشغيل الطرازات الأصغر حجمًا 16 جيجابايت من ذاكرة الوصول العشوائي، ووحدة معالجة مركزية حديثة مثل Intel i5-8400 أو AMD Ryzen 5 2600، وذاكرة تخزين متاحة بسعة 50 جيجابايت على الأقل. تتعامل هذه المواصفات مع النماذج التي تصل سعتها إلى 7 مليار مع أداء مقبول لمعظم حالات الاستخدام.

تشتمل المواصفات الموصى بها لتحقيق الأداء الأمثل على NVIDIA RTX 4060 مع ذاكرة وصول عشوائي للفيديو بسعة 8 جيجابايت، وذاكرة وصول عشوائي للنظام بسعة 32 جيجابايت، وذاكرة تخزين تزيد عن 100 جيجابايت لنماذج متعددة. يوفر هذا التكوين استنتاجًا سلسًا للنماذج الأكبر حجمًا ويتيح تشغيل نماذج متعددة في وقت واحد.

تختلف متطلبات التخزين حسب حجم النموذج: النماذج الأصغر مثل Phi-3-mini تتطلب 2-4 جيجابايت، بينما النماذج الأكبر مثل Llama 3.1 70B تحتاج إلى 40-80 جيجابايت حسب التكميم. إذا كانت لديك موارد محدودة، فقد ترغب في تنزيل أصغر النماذج المتاحة، مثل Gemma 2B Instruct، لتقليل استخدام التخزين والذاكرة. خطط لـ 50-100 جيجابايت إذا كنت تريد تجربة نماذج متعددة بأحجام مختلفة.

إليك مقارنة أداء تُظهر الرموز المميزة في الثانية لتكوينات أجهزة مختلفة:

تكوين الأجهزة | فاي-3-ميني (3ب) | لاما 3.1 8ب 3.1 | ميسترال 7ب | كود لاما 34 ب |

|---|---|---|---|---|

وحدة المعالجة المركزية فقط (ذاكرة وصول عشوائي (RAM) سعة 16 جيجابايت) | 8-12 رمزاً/ثانية | 4-6 رموز/ثانية | 3-5 رموز/ثانية | غير موصى به |

RTX 4060 (8 جيجابايت فيرام) | 45-60 رمزاً/ثانية | 25-35 توكن/ثانية | 30-40 رمزاً/ثانية | 8-12 رمزاً/ثانية |

RTX 4090 (24 جيجابايت فيرام) | 80-120 توكن/ثانية | 60-80 توكن/ثانية | 70-90 رمزاً/ثانية | 35-45 رمزاً/ثانية |

أبل M2 برو (32 جيجابايت) | 35-50 رمزاً/ثانية | 20-30 رمزاً/ثانية | 25-35 توكن/ثانية | 15-20 رمزاً/ثانية |

يعمل تسريع وحدة معالجة الرسومات على تحسين الأداء بشكل ملحوظ، لكن الاستدلال بوحدة المعالجة المركزية فقط يظل قابلاً للتطبيق في النماذج الأصغر حجمًا عند عدم توفر موارد وحدة معالجة الرسومات. يأتي الأداء الأمثل من مطابقة حجم النموذج مع حجم ذاكرة الوصول العشوائي للفيديو أو ذاكرة الوصول العشوائي للنظام المتوفرة لديك.

أفضل النماذج مفتوحة المصدر للتشغيل محلياً

يعتمد اختيار النموذج المناسب على قدرات أجهزتك وحالات الاستخدام المقصودة ومتطلبات الجودة. وقد وصلت النماذج مفتوحة المصدر إلى مستويات جودة مثيرة للإعجاب مع بقائها متاحة للنشر المحلي. يسلط المشهد المتنامي لمشاريع برمجيات الذكاء الاصطناعي مفتوحة المصدر، مثل Ollama و llama.cpp، الضوء على قوة التطوير الذي يحركه المجتمع وتزايد توافر النماذج التي تصدرها مؤسسات الذكاء الاصطناعي الرائدة.

توفر الموديلات الصغيرة (أقل من 8 جيجابايت) كفاءة ممتازة للمهام الأساسية:

- يوفر Phi-3-mini (معلمات 3.8B) قدرات تفكير قوية في حزمة مدمجة بسعة 2.3 جيجابايت، وهو مثالي لسيناريوهات ذاكرة الوصول العشوائي المحدودة

- يوفر Gemma 2B جودة تدريب Google في ملف نموذجي خفيف الوزن للغاية بسعة 1.4 جيجابايت

- يوفر Llama 3.2 3B أحدث تحسينات بنية Meta بأداء وكفاءة متوازنين

تحقق النماذج المتوسطة (8-16 جيجابايت) أفضل توازن بين القدرات ومتطلبات الموارد:

- يُستخدم Llama 3.1 8B كمعيار ذهبي للمهام ذات الأغراض العامة مع التفكير المنطقي القوي وتوليد التعليمات البرمجية

- يتفوق Mistral 7B في اتباع التعليمات بدقة والتعامل مع مهام التفكير المعقدة

- يتخصص DeepSeek-Coder 6.7B في توليد الأكواد البرمجية مع دعم أكثر من 80 لغة برمجة

توفر الموديلات الكبيرة (16 جيجابايت فأكثر) أقصى قدرة للمستخدمين الذين لديهم أجهزة كافية:

- يقدم Llama 3.1 70B أداءً من فئة GPT-4 لمهام التفكير والتحليل المعقدة

- يقدم Code Llama 34B مساعدة استثنائية في البرمجة مع فهم عميق لمفاهيم هندسة البرمجيات

جميع النماذج متوفرة من خلال Hugging Face بمعرفات نموذجية مثل “microsoft/Phi-3-mini-4-ink-instruct” أو “meta-llama/Meta-Llama-3.1-8B-Instruct”. تُظهر معايير الأداء أن نماذج المعلمة 8B عادةً ما توفر أفضل قيمة مقترحة لمعظم المستخدمين، حيث تقدم 85-90% من قدرة النموذج الأكبر مع طلب موارد أقل بكثير.

استوديو LM: أسهل طريقة للبدء

يُحدِث LM Studio ثورة في إمكانية الوصول إلى الذكاء الاصطناعي المحلي من خلال توفير واجهة رسومية سهلة الاستخدام تلخص التعقيدات التقنية. يوفر LM Studio والأدوات المماثلة واجهات مستخدم، بما في ذلك الخيارات الرسومية والخيارات القائمة على الويب، التي تبسط إدارة النماذج والتفاعل معها. كما يوفر LM Studio أيضًا الويب ui، مما يسمح للمستخدمين بإدارة النماذج والتفاعل معها مباشرةً من متصفحهم. وهذا يجعلها نقطة الانطلاق المثالية للمستخدمين الجدد في تشغيل llms محليًا.

ابدأ بتنزيل LM Studio من lmstudio.ai واتباع عملية التثبيت المباشرة لنظام التشغيل الخاص بك. يقوم المثبت تلقائيًا بتكوين تسريع وحدة معالجة الرسومات تلقائيًا عند اكتشاف أجهزة متوافقة، مما يلغي التكوين اليدوي لبرنامج التشغيل. بعد التثبيت، قم بتشغيل LM Studio للوصول إلى الواجهة الرئيسية والبدء في استكشاف النماذج المتاحة.

تقدم الواجهة الرئيسية ثلاثة أقسام رئيسية: Discover لتصفح النماذج المتاحة، وMy Models لإدارة النماذج التي تم تنزيلها، وChat للتفاعل مع النماذج المحملة. في علامة التبويب "اكتشف"، استخدم شريط البحث للعثور بسرعة على نماذج محددة بناءً على متطلباتك. تنظم مكتبة النماذج المدمجة نماذج مفتوحة المصدر عالية الجودة مع أوصاف واضحة ومتطلبات الأجهزة.

يتضمن إعداد واجهة المحادثة تحميل نموذج تم تنزيله وضبط معلمات التوليد مثل درجة الحرارة وطول السياق. توفر الواجهة منزلقات وتفسيرات بديهية لكل إعداد، مما يجعل التجربة في متناول المستخدمين غير التقنيين.

بالنسبة للمطورين، يتضمن LM Studio خادم واجهة برمجة تطبيقات محلي يعرض نقاط نهاية متوافقة مع OpenAI. قم بتمكين هذه الميزة في الإعدادات لدمج النماذج المحلية مع التطبيقات الحالية التي تدعم تنسيق OpenAI's API.

تثبيت نموذجك الأول في استوديو LM Studio

انتقل إلى علامة التبويب “اكتشف” حيث ستجد مكتبة قابلة للبحث عن النماذج المتوافقة. ابحث عن "llama-3.2-3b-instruct" للعثور على نموذج معلمة 3B الفعال من Meta الذي يعمل بشكل جيد على الأجهزة المتواضعة.

انقر على زر التنزيل لبدء العملية. يعرض LM Studio مؤشرات التقدم التي توضح سرعة التنزيل والوقت المقدر للانتهاء. يعالج مدير التنزيل الانقطاعات بأمانة، ويستأنف التنزيلات الجزئية عند عودة الاتصال بالشبكة.

بمجرد اكتمال التنزيل، يظهر النموذج في قسم النماذج الخاصة بي. تتم إدارة ملفات النماذج التي تم تنزيلها وتخزينها لسهولة الوصول إليها وتحميلها. انقر لتحميلها في الذاكرة، وهو ما يستغرق عادةً من 10 إلى 30 ثانية حسب حجم النموذج وسرعة التخزين. تعرض الواجهة استخدام الذاكرة وتؤكد عندما يكون النموذج جاهزاً للتفاعل.

اختبر التثبيت باستخدام عينة من المطالبات مثل “اشرح الحوسبة الكمية بمصطلحات بسيطة” أو “اكتب دالة بايثون لحساب أرقام فيبوناتشي”. يجب أن يستجيب النموذج في غضون ثوانٍ، مما يؤكد نجاح الإعداد.

يتضمن استكشاف الأخطاء وإصلاحها الشائعة في حالات فشل التنزيل التحقق من مساحة القرص المتاحة، والتحقق من استقرار الاتصال بالإنترنت، والتأكد من أن جدار الحماية الخاص بك يسمح بالوصول إلى شبكة LM Studio. توفر السجلات المدمجة معلومات مفصلة عن الأخطاء لحل المشكلات.

GPT4All: ذكاء اصطناعي محلي يركز على الخصوصية

يركّز GPT4All على الخصوصية وسهولة الاستخدام، مما يجعله خياراً ممتازاً للمستخدمين الذين يعطون الأولوية لأمن البيانات. يعمل التطبيق بشكل كامل دون اتصال بالإنترنت بمجرد تنزيل النماذج، مما يضمن عدم مغادرة محادثاتك لجهازك أبداً.

حمِّل GPT4All من gpt4all.io وقم بتحميل GPT4All من gpt4all.io وثبِّته على ويندوز أو ماك أو لينكس. تُنزل عملية التثبيت تلقائيًا نموذجًا مبدئيًا لضمان التشغيل الفوري. يقدم التشغيل الأول واجهة نظيفة مع تنقل واضح بين الدردشة والنماذج والإعدادات. بعد التثبيت، يمكنك مطالبة النماذج بإنشاء نص لمجموعة متنوعة من المهام، مثل الإجابة عن الأسئلة أو إنشاء محتوى.

يقدم سوق الطرازات أكثر من 50 نموذجاً منسقاً مع أوصاف مفصلة ومتطلبات الأجهزة وتقييمات المستخدمين. يتم تصنيف النماذج حسب الحجم والتخصص، مما يساعد المستخدمين على تحديد الخيارات المناسبة لحالات الاستخدام وقيود الأجهزة.

يختلف إعداد تسريع وحدة معالجة الرسومات حسب النظام الأساسي، ولكنه يتضمن بشكل عام تثبيت برامج تشغيل CUDA لبطاقات رسومات NVIDIA أو ضمان دعم Metal على نظام macOS. توفر لوحة الإعدادات تعليمات واضحة واكتشافًا تلقائيًا لتكوينات الأجهزة المتوافقة.

إعداد LocalDocs لمحادثة المستندات

تُمثّل LocalDocs الميزة البارزة في GPT4All، حيث تتيح إجراء محادثات خاصة مع مستنداتك الشخصية دون تحميل المحتوى على خوادم خارجية. تحوّل هذه الخاصية رسائل الجوال المحلية إلى أدوات بحث وتحليل قوية.

قم بالوصول إلى LocalDocs من خلال علامة التبويب المخصصة وأضف مجلدات محلية تحتوي على ملفات PDF أو ملفات نصية أو مستندات تخفيض السعر أو مستودعات التعليمات البرمجية. ويدعم النظام التنسيقات الشائعة بما في ذلك ملفات .pdf و .txt و .md و .docx وملفات التعليمات البرمجية المصدرية.

تقوم عملية الفهرسة بتحليل محتويات المستند لإنشاء تضمينات قابلة للبحث مخزنة محلياً على جهازك. يعتمد وقت الفهرسة على حجم المستند ولكن عادةً ما تعالج مئات الصفحات في غضون دقائق. تعرض مؤشرات التقدم حالة الإكمال والوقت المقدر المتبقي.

قد تشمل أمثلة الاستعلامات ضد المستندات المفهرسة “تلخيص النتائج الرئيسية من أوراقي البحثية” أو “ما هي أنماط الترميز التي تظهر بشكل متكرر في مشاريعي؟ يقوم النظام باسترجاع أقسام المستندات ذات الصلة قبل توليد الإجابات، مما يوفر إجابات مستندة إلى المصدر الاستشهادات.

تشمل مزايا الخصوصية المعالجة الكاملة دون اتصال بالإنترنت دون نقل البيانات إلى خدمات خارجية. تظل مستنداتك على جهازك المحلي طوال العملية بأكملها، مما يجعل LocalDocs مناسبًا لمستندات العمل السرية أو المواد البحثية الشخصية.

جان: بديل ChatGPT مفتوح المصدر للدردشة عبر الإنترنت

تضع منصة Jan نفسها كبديل شامل مفتوح المصدر لخدمات الدردشة بالذكاء الاصطناعي التجارية، حيث تقدم واجهات مألوفة مع مرونة التطوير مفتوح المصدر. تدعم المنصة كلاً من الاستدلال المحلي والتكامل السحابي الهجين لتحقيق أقصى قدر من المرونة.

التثبيت من جان.آي يتطلب التحقق من متطلبات النظام بما في ذلك ذاكرة الوصول العشوائي ومساحة التخزين الكافية. يكتشف المثبت تلقائياً قدرات الأجهزة ويقترح إعدادات التكوين المثلى للإعدادات الخاصة بك.

تكشف جولة في الواجهة عن تصميم مستوحى من ChatGPT مع عناصر واجهة مستخدم حديثة وتصفح بديهي. يتبع سجل المحادثات، وتبديل النماذج، والوصول إلى الإعدادات أنماطاً مألوفة تقلل من منحنيات التعلم للمستخدمين الذين ينتقلون من الخدمات التجارية.

تسمح إمكانيات استيراد النماذج بجلب النماذج من أدوات أخرى مثل LM Studio أو Ollama، مما يجنبك التنزيلات الزائدة عن الحاجة. يدعم Jan استيراد أي نموذج لغة كبيرة متوافقة للاستخدام المحلي أو المختلط. يقوم النظام تلقائيًا باكتشاف تنسيقات النماذج المتوافقة وتحويلها حسب الحاجة لتحقيق الأداء الأمثل.

تضيف سوق الإضافات وظائف من خلال الإضافات التي طورها المجتمع والتي تغطي مجالات مثل إدارة النماذج المحسّنة، وأوضاع الدردشة المتخصصة، والتكامل مع الأدوات والخدمات الخارجية.

يتيح تكامل واجهة برمجة التطبيقات عن بُعد عمليات النشر المختلطة حيث تستخدم بعض الطلبات النماذج المحلية بينما يستفيد البعض الآخر من الخدمات السحابية بناءً على متطلبات التعقيد أو الأداء. يعمل هذا النهج على تحسين التكاليف مع الحفاظ على القدرات المحلية للمهام الحساسة.

أولاما: أداة سطر أوامر صديقة للمطورين

تتفوق Ollama كأداة سطر أوامر مصممة خصيصًا للمطورين الذين يفضلون التحكم البرمجي وقدرات التكامل. تجعل واجهتها البسيطة والفعالة في نفس الوقت إدارة النماذج ونشرها مباشرةً للمستخدمين التقنيين.

يختلف التثبيت حسب نظام التشغيل، ولكنه عادةً ما يستخدم مديري الحزم مثل Homebrew على نظام ماك (brew install ollama)، أو apt على أوبونتو (sudo apt install ollama)، أو winget على ويندوز (winget install ollama). تضمن هذه الطرق الإدارة السليمة للتبعية وتكامل النظام.

بعد التثبيت، يمكن للمستخدمين التفاعل مع Ollama من خلال أوامر طرفية محددة لتنزيل النماذج وتشغيلها وإدارتها، مما يسهل تشغيلها بالكامل من سطر الأوامر.

توفر الأوامر الأساسية إدارة شاملة لدورة حياة النموذج:

- سحب ollama llama3.1:8b تنزيل نماذج من المكتبة الرسمية

- تشغيل ollama llama3.1:8b يبدأ جلسات الدردشة التفاعلية مع النماذج المحددة

- تعرض قائمة ollama جميع الموديلات المثبتة مع المقاسات وتواريخ التعديل

- ollama rm model-name يزيل النماذج لتحرير مساحة تخزين

يمكن تهيئة Ollama كخادم محلي أو خادم استدلال محلي، مما يسمح لك باستضافة النماذج وخدمتها محليًا للتكامل مع التطبيقات الأخرى. يتيح هذا الإعداد سهولة التخصيص وتحسين الأداء والدعم السلس لاستكشاف الأخطاء وإصلاحها.

يتيح إنشاء نماذج مخصصة من خلال Modelfile إمكانية ضبط سلوك النموذج ومطالبات النظام والمعلمات. يتكامل نهج التكوين المستند إلى النص هذا بشكل جيد مع التحكم في الإصدار وسير عمل الأتمتة.

ويتضمن التكامل مع أدوات التطوير مكونات إضافية لبرامج IDEs الشائعة مثل VS Code، مما يتيح إنشاء التعليمات البرمجية وتحليلها مباشرةً داخل بيئات التطوير. يعمل تنسيق واجهة برمجة التطبيقات (API) الموحد على تبسيط التكامل مع التطبيقات والخدمات الحالية.

تشغيل نماذج متعددة مع أولاما

تدعم بنية Ollama التنفيذ المتزامن للنماذج، مما يسمح للنماذج المختلفة بخدمة المهام المتخصصة في وقت واحد. تتيح هذه القدرة تدفقات عمل متطورة حيث تتعامل النماذج الأصغر مع المهام الأساسية بينما تعالج النماذج الأكبر حجماً المهام المعقدة.

يتطلب التبديل بين النماذج بناء جملة أوامر بسيطة مثل ollama run mistral:7b متبوعًا ب ollama run codellama:7b في جلسات طرفية منفصلة. يحتفظ كل نموذج بسياق محادثة وتخصيص ذاكرة مستقل.

تتعامل إدارة الذاكرة تلقائيًا مع تخصيص الموارد بناءً على موارد النظام المتاحة ومتطلبات النموذج. يوفر النظام تحذيرات عندما تؤثر قيود الذاكرة على الأداء ويقترح استراتيجيات التحسين.

يعرض إعداد خادم واجهة برمجة التطبيقات من خلال خدمة ollama النماذج عبر نقاط نهاية HTTP المتوافقة مع تنسيق OpenAI. يتيح ذلك إمكانية التكامل السلس مع التطبيقات المصممة لخدمات الذكاء الاصطناعي السحابي، والتي تعمل بالكامل على البنية التحتية المحلية.

يعمل نشر Docker على تسهيل بيئات الإنتاج من خلال حاويات Ollama الرسمية. يضمن نهج الحاويات سلوكًا متسقًا عبر بيئات التطوير والتدريج والإنتاج مع تبسيط إدارة التبعية.

الأدوات المتقدمة: llama.cpp و llamafile

يستفيد المستخدمون المتقدمون الذين يسعون إلى تحقيق أقصى قدر من التحكم وتحسين الأداء من أدوات المستوى الأدنى مثل llama.cpp و llamafile. لتشغيل النماذج باستخدام llama.cpp، يحتاج المستخدمون إلى تنزيل ملف نموذج gguf، وهو التنسيق المطلوب للنشر المحلي. تضحي هذه الأدوات بالملاءمة من أجل المرونة والكفاءة، مما يجعلها مثالية لعمليات النشر الإنتاجية والمتطلبات المتخصصة.

يعتمد القرار بين التطبيقات سهلة الاستخدام والأدوات المتقدمة على احتياجات محددة. اختر الأدوات المتقدمة عند الحاجة إلى خيارات تجميع مخصصة، أو دعم أجهزة متخصصة، أو الاندماج في أنظمة أكبر حيث يكون التحكم الكامل في محرك الاستدلال ضروريًا. كما يمكن للمستخدمين أيضًا تشغيل نماذج مضبوطة بدقة لمهام أو مجالات محددة، مما يحقق الأداء الأمثل المصمم خصيصًا لمتطلباتهم.

يتضمن تجميع llama.cpp مع دعم وحدة معالجة الرسومات تكوين أنظمة بناء لأهداف أجهزة محددة. يتطلب دعم CUDA تثبيت برامج تشغيل NVIDIA ومجموعة أدوات، ويعمل دعم Metal تلقائيًا على نظام macOS مع Apple Silicon، ويوفر OpenCL توافقًا أوسع لوحدة معالجة الرسومات عبر البائعين.

ويشمل تحسين الأداء من خلال الأدوات المتقدمة مخططات التكميم المخصصة، وتحسينات تخطيط الذاكرة، وتطبيقات الانتباه المتخصصة. يمكن لهذه التحسينات تحسين سرعة الاستدلال بشكل كبير وتقليل متطلبات الذاكرة مقارنةً بحلول الأغراض العامة.

توفر الملفات التنفيذية llamafile نشرًا محمولاً للذكاء الاصطناعي من خلال تجميع النماذج ومحركات الاستدلال في ملفات فردية تعمل دون تثبيت. يعمل هذا النهج على تبسيط سيناريوهات النشر حيث لا تكون عمليات التثبيت التقليدية ممكنة أو مرغوبة.

تتضمن تقنيات تكميم النماذج المتوفرة من خلال الأدوات المتقدمة تنسيقات 4 بت و8 بت وتنسيقات الدقة المختلطة التي تقلل من حجم النموذج مع الحفاظ على معظم الأداء. يمكن للمستخدمين تجربة مخططات تكميم مختلفة للعثور على التوازنات المثلى لحالات الاستخدام الخاصة بهم.

إنشاء خادم API محلي

يوفر خادم واجهة برمجة التطبيقات المحلية الحل الأمثل للتكامل لنموذج إدارة التعلم الآلي الخاص بك، مما يوفر اتصالاً سلسًا مع التطبيقات الأخرى مع الحفاظ على التحكم الكامل في بياناتك وبنيتك التحتية. يوفر كل من LM Studio و Ollama خيارات نشر قوية ومباشرة تضع قدرات على مستوى المؤسسات بين يديك مباشرة، سواء كنت تفضل الواجهات الرسومية البديهية أو دقة سطر الأوامر.

البدء يعني اختيار استراتيجية النشر المفضلة لديك، LM Studio أو Ollama، وتثبيتها على بنيتك التحتية. بمجرد التثبيت، ستقوم بتنزيل نموذج إل إم إم الذي يتوافق تمامًا مع قدرات أجهزتك ومتطلبات عملك، مما يضمن الاستخدام الأمثل للموارد. قم بتكوين معلمات الأداء الحرجة مثل طول السياق وإلغاء قفل إمكانات تسريع وحدة معالجة الرسومات عندما يدعمها نظامك، مما يوفر النتائج عالية الأداء التي تتطلبها تطبيقاتك.

لا يمكن أن يكون تشغيل خادم واجهة برمجة التطبيقات المحلي الخاص بك أبسط من ذلك: يوفر LM Studio تنشيط الخادم من خلال واجهة إعدادات سهلة الاستخدام، بينما يوفر Ollama تحكمًا قائمًا على المحطة الطرفية لتحقيق أقصى قدر من المرونة التشغيلية. يعمل خادم واجهة برمجة التطبيقات الخاص بك على منفذ مخصص، وهو جاهز لمعالجة الطلبات من تطبيقاتك وتقديم استجابات نصية تم إنشاؤها بموثوقية وسرعة على مستوى المؤسسة.

من خلال تشغيل خادم واجهة برمجة التطبيقات المحلي الخاص بك، ستحصل على حرية إنشاء روبوتات دردشة مخصصة، وأتمتة مهام سير العمل المعقدة، ودمج القدرات اللغوية المتقدمة مباشرةً في نظامك البرمجي، كل ذلك مع الحفاظ على أمان البيانات الكامل وضمان عمل نموذج إدارة التعلم الآلي بالكامل داخل بيئتك الخاضعة للرقابة. هذا أكثر من مجرد إعداد تقني؛ إنه بوابتك إلى إمكانات معالجة لغوية قابلة للتطوير وآمنة ومتطورة.

تأمين LLM المحلي الخاص بك باستخدام مفتاح واجهة برمجة التطبيقات (API)

لا يعد تأمين الوصول إلى إدارة علاقات العملاء المحلية أمرًا ضروريًا فحسب، بل هو الأساس الذي يحول نشر الذكاء الاصطناعي الخاص بك من نقطة ضعف محتملة إلى حصن من الابتكار الخاضع للرقابة. عندما تربط عدة تطبيقات أو مستخدمين متعددين، يصبح تطبيق نظام مفتاح واجهة برمجة التطبيقات هو استراتيجيتك التي تغير قواعد اللعبة، مما يضمن أن الطلبات المصرح بها فقط هي التي يمكنها فتح قوة نموذجك مع إبعاد الوصول غير المصرح به.

قم بتحويل نهج الأمان الخاص بك عن طريق إنشاء مفاتيح واجهة برمجة تطبيقات فريدة لكل تطبيق أو مستخدم من شأنها تسخير قدرات إدارة علاقات العملاء المحلية. قم بتخزين هذه المفاتيح الرقمية مثل الأصول الثمينة في متغيرات البيئة أو ملفات التكوين المشفرة، مما يمنع أي انكشاف غير مقصود قد يعرض ميزتك التنافسية للخطر. قم بتكوين خادم واجهة برمجة التطبيقات المحلي الخاص بك للمطالبة بالتحقق من صحة مفتاح واجهة برمجة التطبيقات في كل طلب، مما ينشئ حاجزاً منيعاً يمنع محاولات الوصول غير المصرح بها قبل أن يتمكنوا حتى من طرق بابك.

ارتقِ باستراتيجية الأمان الخاصة بك عن طريق تدوير مفاتيح واجهة برمجة التطبيقات بانتظام لتقليل مخاطر أي اختراق محتمل، واتخاذ إجراءات حاسمة لإلغاء المفاتيح التي لم تعد هناك حاجة إليها أو التي ربما تكون قد تعرضت للاختراق. من خلال تبنّي هذه الممارسات الرائدة في هذا المجال، فإنك لا تحافظ على السيطرة فحسب، بل تؤسس هيمنة كاملة على إدارة واجهة برمجة التطبيقات المحلية الخاصة بك، وتحمي كلاً من نموذجك القيّم وكل جزء من البيانات الحساسة التي يعالجها بدقة لا هوادة فيها.

التطبيقات العملية وحالات الاستخدام

يتيح تشغيل llms محلياً العديد من التطبيقات العملية في السياقات المهنية والشخصية. يتيح الجمع بين الخصوصية والاستخدام غير المحدود والقدرات غير المتصلة بالإنترنت إمكانيات لا يمكن للخدمات السحابية توفيرها.

يمثل توليد التعليمات البرمجية وتصحيح الأخطاء حالات الاستخدام الأساسية للذكاء الاصطناعي المحلي. تتفوق نماذج مثل DeepSeek-Coder و Code Llama في فهم سياقات البرمجة، وتوليد التعليمات البرمجية المتداولة، وشرح الخوارزميات المعقدة، واقتراح إصلاحات الأخطاء عبر أكثر من 80 لغة برمجة.

تستفيد مهام سير عمل إنشاء المحتوى من إمكانيات الإنشاء غير المحدودة للنماذج المحلية. منشورات المدونات ورسائل البريد الإلكتروني, التسويق يمكن إنشاء النسخ ومحتوى الوسائط الاجتماعية بشكل متكرر دون تكاليف واجهة برمجة التطبيقات أو حدود للأسعار. تضيف القدرة على ضبط النماذج المحلية على أنماط كتابة معينة التخصيص مستحيل مع الخدمات السحابية.

تستفيد مهام تحليل البيانات وتلخيصها من قدرة النماذج المحلية على معالجة المعلومات الحساسة دون نقل خارجي. يمكن تحليل التقارير المالية، والوثائق القانونية، والسجلات الطبية، والأبحاث المسجلة الملكية مع الحفاظ على السرية التامة.

توفر الترجمة اللغوية بدون خدمات خارجية الخصوصية للاتصالات الحساسة مع دعم عشرات الأزواج اللغوية. تتعامل النماذج المحلية مع ترجمة الوثائق الفنية، ودعم العملاء متعدد اللغات، والاتصالات التجارية الدولية دون اتصال بالإنترنت بالكامل.

ومن الأمثلة الواقعية على ذلك شركات المحاماة التي تستخدم نماذج محلية لتحليل المستندات، وشركات البرمجيات التي تطبق مساعدي الترميز المدعومين بالذكاء الاصطناعي، ومنشئي المحتوى الذين يطورون أدوات كتابة مخصصة. يعمل كل من هذه الحلول محلياً على أجهزة المستخدم، مما يضمن الخصوصية والتحكم. توضح هذه التطبيقات تعدد الاستخدامات والقيمة العملية لنشر الذكاء الاصطناعي المحلي.

تحسين الأداء واستكشاف الأعطال وإصلاحها

يتطلب تعظيم الأداء إلى أقصى حد ممكن من برمجيات llms المحلية فهم موارد النظام وخصائص النموذج وتقنيات التحسين. يمكن أن يؤدي التكوين المناسب إلى تحسين أوقات الاستجابة بشكل كبير وتمكين نماذج أكبر على أجهزة متواضعة.

يختلف إعداد تسريع وحدة معالجة الرسومات حسب البائع، ولكنه يتضمن بشكل عام تثبيت برامج التشغيل المناسبة وتهيئة البرنامج للتعرف على الأجهزة المتاحة. يحتاج مستخدمو NVIDIA إلى تثبيت مجموعة أدوات CUDA، بينما يحتاج مستخدمو AMD إلى إعداد ROCm على توزيعات Linux المدعومة.

يقلل تكميم النموذج من متطلبات الذاكرة عن طريق تخزين معلمات النموذج بمستويات دقة أقل. يقلل تكميم 4 بت عادةً من حجم النموذج بمقدار 75% مع الحفاظ على جودة 95%+، مما يجعل النماذج الكبيرة متاحة على الأجهزة الاستهلاكية ذات ذاكرة الوصول العشوائي المحدودة للفيديو.

تتضمن رسائل الخطأ الشائعة وحلولها ما يلي:

- “نفاد ذاكرة CUDA”: تقليل حجم النموذج، أو إغلاق التطبيقات الأخرى، أو تمكين إلغاء تحميل وحدة المعالجة المركزية

- “فشل تحميل النموذج”: تحقق من سلامة ملف النموذج ومساحة كافية على القرص

- “سرعة الاستدلال البطيئة”: التحقق من إعدادات تسريع وحدة معالجة الرسومات والنظر في تكميم النموذج

تساعد مراقبة الموارد أثناء الاستدلال على تحديد الاختناقات وتحسين التكوينات. يكشف مدير المهام على نظام ويندوز أو مراقب النشاط على نظام ماك أو htop على نظام لينكس عن استخدام وحدة المعالجة المركزية واستخدام الذاكرة وأنماط نشاط وحدة معالجة الرسومات أثناء تنفيذ النموذج.

تؤثر تعديلات معلمات درجة الحرارة وأخذ العينات على جودة المخرجات وسرعتها. تنتج درجات الحرارة المنخفضة مخرجات أكثر اتساقًا، بينما تزيد القيم الأعلى من الإبداع. توازن معلمات أخذ العينات من أعلى-ك وأعلى-ب بين تنوع الاستجابة والتماسك.

يوازن تحسين طول السياق بين استخدام الذاكرة وقدرة المحادثة. تتيح السياقات الأطول تفاعلات أكثر تعقيدًا ولكنها تتطلب ذاكرة أكبر نسبيًا. تعمل معظم حالات الاستخدام بشكل جيد مع سياقات الرموز الرمزية 2048-4096.

أفضل الممارسات لإعداد LLM المحلي

للاستفادة من القيمة القصوى من جهازك المحلي من نوع llm، فأنت بحاجة إلى استراتيجية رابحة توفر أعلى أداء وأمانًا منيعًا. ابدأ باختيار الطراز المثالي لاحتياجاتك الفريدة، وتعمّق في معلمات الطراز ومواصفات الحجم والتطبيقات المستهدفة لاكتشاف التطابق المثالي لقدرات أجهزتك ومتطلبات حالة الاستخدام المحددة.

اشحن إعداداتك بشكل فائق من خلال ضبط معلمات النماذج المهمة مثل طول السياق وتفعيل تسريع وحدة معالجة الرسومات حيثما أمكن لتحقيق مستويات أداء مغيرة للعبة. احرص على أن يوفر نظام التشغيل الخاص بك توافقًا لا تشوبه شائبة مع الأدوات ونماذج إدارة المحتوى التي اخترتها، مع الحفاظ على تحديث نظامك بالكامل ومجموعة البرامج الخاصة بك للاستفادة من أحدث الميزات المتطورة والتحسينات الأمنية المتطورة.

استبق الاختناقات من خلال المراقبة الفعالة لموارد نظامك وتتبع استخدام ذاكرة الوصول العشوائي ووحدة معالجة الرسومات لمنع حدوث عوائق في الأداء، خاصةً عند نشر نماذج أكبر أو تشغيل نماذج متعددة بالتوازي. حوِّل سير عملك باستخدام واجهات رسومية بديهية مثل LM Studio أو GPT4All للحصول على تجربة مستخدم سهلة تجعل إدارة النماذج وتحسين الإعدادات بسيطة للغاية.

حماية ما هو أكثر أهمية، والحفاظ دائماً على البيانات الحساسة داخل بيئتك المحلية وعدم المخاطرة بنقل المعلومات السرية عبر قنوات الإنترنت. اختبر النماذج المختلفة وقيّمها باستمرار لضمان الاستفادة من الحل الأمثل لتطبيقك المحدد، وتبنَّ المرونة اللازمة لضبط النماذج الجديدة أو الانتقال إلى نماذج جديدة مع نمو متطلباتك وتطورها.

من خلال تنفيذ أفضل الممارسات التي أثبتت جدواها، ستتمكن من إنشاء بيئة إدارة علاقات العملاء المحلية الآمنة والسريعة والمضبوطة بدقة لتقديم نتائج متميزة تتجاوز متطلباتك الفريدة وتحقق نتائج استثنائية.

تحليل التكلفة: خدمات الذكاء الاصطناعي المحلية مقابل خدمات الذكاء الاصطناعي السحابية

يساعد فهم اقتصاديات خدمات الذكاء الاصطناعي المحلية مقابل خدمات الذكاء الاصطناعي السحابية على اتخاذ قرارات مستنيرة بشأن استثمارات البنية التحتية. يتضمن التحليل التكاليف الأولية للأجهزة، والمصروفات الجارية، وحسابات التعادل بناءً على أنماط الاستخدام.

يتراوح الاستثمار الأولي في الأجهزة لأنظمة الذكاء الاصطناعي المحلية القادرة من $800-1,500 للتكوينات متوسطة المدى إلى $3,000-5,000 للإعدادات المتطورة. تتضمن هذه التكاليف وحدات معالجة مركزية حديثة، وذاكرة وصول عشوائي كافية، ووحدات معالجة رسومات قادرة على العمل ووحدات تخزين كافية لنماذج متعددة.

تتفاوت تكاليف الاشتراك الشهري لخدمات الذكاء الاصطناعي السحابي بشكل كبير: تبلغ تكلفة اشتراك ChatGPT Plus 1 تيرابايت 4 تيرابايت شهرياً، بينما تبلغ تكلفة اشتراك Claude Pro 1 تيرابايت 4 تيرابايت شهرياً، ويمكن أن تتراوح تكلفة استخدام واجهة برمجة التطبيقات من 1 تيرابايت 4 تيرابايت 10-500 تيرابايت شهرياً حسب الحجم. وغالباً ما تتجاوز خطط المؤسسات $100T شهرياً لكل مستخدم.

ويكشف تحليل نقطة التعادل أن المستخدمين المعتدلين إلى الثقيلين يستردون عادةً استثماراتهم في الأجهزة في غضون 6-18 شهرًا. وغالباً ما يبرر المستخدمون الذين يعالجون بيانات حساسة أو يحتاجون إلى توافرها على مدار الساعة طوال أيام الأسبوع وجود بنية تحتية محلية بغض النظر عن اعتبارات التكلفة البحتة.

تضيف تكاليف الطاقة لتشغيل النماذج المحلية بشكل مستمر ما يقرب من $30-100 شهريًا إلى فواتير الكهرباء، اعتمادًا على كفاءة الأجهزة وأسعار المرافق المحلية. تتضمن وحدات معالجة الرسومات الحديثة ميزات إدارة الطاقة التي تقلل من الاستهلاك أثناء فترات الخمول.

إن حسابات التكلفة الإجمالية للملكية على مدى 2-3 سنوات تفضل بشكل عام الحلول المحلية من أجل:

- المستخدمون ذوو أنماط الاستخدام المعتدلة إلى الكثيفة للذكاء الاصطناعي

- المؤسسات التي تتطلب الامتثال لخصوصية البيانات

- التطبيقات التي تحتاج إلى توافر مضمون

- الفرق التي ترغب في إمكانية تجريب غير محدودة

تظل الخدمات السحابية اقتصادية بالنسبة لـ

- مستخدمون من حين لآخر مع الحد الأدنى من الحجم الشهري

- الفرق التي تتطلب الوصول إلى أحدث النماذج المتطورة

- المنظمات التي ليس لديها خبرة في البنية التحتية لتكنولوجيا المعلومات

- التطبيقات التي تحتاج إلى إمكانات تحجيم سلسة

غالباً ما ينطوي القرار على عوامل غير مالية بما في ذلك متطلبات الخصوصية, سيادة البيانات, وموثوقية الاتصال بالإنترنت، وتفضيلات التحكم التنظيمي التي ترجح كفة الميزان نحو النشر المحلي على الرغم من ارتفاع التكاليف الأولية.

تمثل النماذج اللغوية المحلية الكبيرة تحولاً جوهرياً نحو نشر الذكاء الاصطناعي بشكل ديمقراطي وخاص وفعال من حيث التكلفة. مع زيادة كفاءة النماذج وزيادة سهولة استخدام الأدوات، يستمر حاجز الدخول في الانخفاض بينما تتوسع القدرات بسرعة.

سواء كنت مطورًا يسعى للحصول على مساعدة في البرمجة، أو شركة تحمي بيانات حساسة، أو متحمسًا يستكشف إمكانيات الذكاء الاصطناعي، فإن تشغيل llms محليًا يوفر لك تحكمًا غير مسبوق في تجربة الذكاء الاصطناعي الخاصة بك. ابدأ بأدوات سهلة الاستخدام مثل LM Studio أو GPT4All، وجرّب نماذج مختلفة للعثور على التوازن المثالي بين القدرات والأداء، ثم وسّع إعدادك تدريجياً مع تطور الاحتياجات.

لا ينتمي مستقبل الذكاء الاصطناعي إلى مراكز البيانات الضخمة فحسب، بل إلى أجهزتك الخاصة، وتحت سيطرتك الكاملة. نزِّل نموذجك المحلي الأول اليوم واختبر حرية الذكاء الاصطناعي المستضاف ذاتياً.

مقدمة في الذكاء الاصطناعي المحلي

يعمل الذكاء الاصطناعي المحلي على إحداث ثورة في طريقة تسخير الأفراد والمؤسسات للذكاء الاصطناعي من خلال جلب القوة الكاملة لنماذج اللغات الكبيرة مباشرةً إلى جهاز الكمبيوتر الخاص بك. فبدلاً من الاعتماد على الخدمات المستندة إلى السحابة، فإن تشغيل llms محلياً يعني أن جميع عمليات المعالجة تتم على جهازك، مما يمنحك تحكماً كاملاً في معلمات النموذج وكيفية التعامل مع بياناتك الحساسة. لا يقتصر هذا النهج على تعزيز الخصوصية - نظراً لأن بياناتك لا تغادر جهازك أبداً - ولكنه يقلل أيضاً من زمن الاستجابة، مما يجعل الاستجابات أسرع وأكثر موثوقية من أي وقت مضى.

باستخدام الذكاء الاصطناعي المحلي، يمكنك ضبط النماذج اللغوية الكبيرة لتناسب احتياجاتك الفريدة، سواء كنت تقوم بتحسينها لمهام محددة أو تجربة تكوينات مختلفة. يُمكّنك تشغيل llms محليًا من تخصيص النماذج وإدارة التحديثات ونشر الحلول المصممة بشكل مثالي لسير عملك، كل ذلك مع الحفاظ على أمان معلوماتك بشكل كامل. مع اكتشاف المزيد من المستخدمين للقيمة المتغيرة للعبة النشر المحلي، يستمر النظام البيئي للأدوات والنماذج في التوسع بسرعة، مما يجعل من الأسهل من أي وقت مضى تسخير قدرات أحدث نماذج اللغات الكبيرة llms على جهاز الكمبيوتر الخاص بك مباشرةً.

الشروع في العمل مع دكاترة القانون المحليين

لم يكن إطلاق رحلتك المحلية في مجال إدارة التعلم الآلي المحلية أكثر سهولة من الآن - بفضل الأدوات التي تغير قواعد اللعبة والنظام البيئي المتوسع للنماذج القوية في متناول يدك. ابدأ باختيار منصة مثل LM Studio أو Ollama، وكلاهما مصمم لتبسيط وتسهيل عملية تشغيل LLMs مباشرةً على جهازك. يقدم هذان الحلان تجارب سهلة الاستخدام مصممة خصيصًا لتناسب تفضيلاتك - LM Studio بواجهته الرسومية البديهية و Ollama بنهج سطر الأوامر الفعال - حتى تتمكن من اختيار سير العمل الذي يتناسب تمامًا مع منطقة راحتك التقنية.

بعد تثبيت النظام الأساسي المفضل لديك، استفد من وظيفة البحث المدمجة لتصفح النماذج المتاحة من مستودعات موثوقة مثل Hugging Face دون عناء. قم بتحميل ملف النموذج الذي اخترته مباشرةً إلى إعدادك المحلي، مع ضمان توافق الأجهزة المضمنة مباشرةً. بمجرد التهيئة، يمكنك تنشيط خادم الاستدلال المحلي، مما يمكّنك من التفاعل مع نموذجك من خلال الواجهة الرسومية أو عمليات سطر الأوامر. يوفر هذا الإعداد القوي المرونة اللازمة لتجربة نماذج متعددة، وإدارة نظام LLM المحلي الخاص بك بكفاءة، والاستمتاع بالمزايا الكاملة للمعالجة المحلية دون أي اعتماد على البنية التحتية السحابية الخارجية.

إعداد خادم الاستدلال المحلي

خادم الاستدلال المحلي هو العمود الفقري الذي يغير قواعد اللعبة لتشغيل برمجيات الذكاء الاصطناعي محليًا، مما يمكّنك من نشر النماذج التي اخترتها وإدارتها والتفاعل معها في بيئة فعالة وآمنة بشكل كبير. أدوات ثورية مثل LM Studio و Ollama تجعل إعداد خادم استدلال محلي مبسطًا بشكل لا يصدق - حتى المستخدمين الجدد تمامًا في مجال الذكاء الاصطناعي يمكنهم تحقيق نتائج قوية. لإطلاق العنان لهذه الإمكانات، ما عليك سوى تحديد ملف النموذج الذي تريده وتهيئة المعلمات الأساسية مثل طول السياق، وعند توفرها، قم بتمكين تسريع وحدة معالجة الرسومات لتحقيق مكاسب هائلة في الأداء.

يوفر Ollama ميزات متقدمة مثل تسريع وحدة معالجة الرسومات، والتي يمكنها تسريع الاستدلال على النماذج بشكل كبير على الأجهزة المتوافقة - مما يحول سير عملك بالكامل. يمكنك الحصول على تحكم كامل من خلال تحديد المنفذ الدقيق لخادم الاستدلال الخاص بك، مما يجعل الوصول إليه بسهولة عبر واجهة مستخدم الويب أو التكامل بسلاسة مع التطبيقات الأخرى لتحقيق أقصى قدر من المرونة. يوفر لك LM Studio إعدادًا مبسطًا بنفس القدر، مما يمكّنك من إدارة النماذج وإعدادات الخادم من خلال واجهة سهلة الاستخدام وبديهية. مع تشغيل خادم الاستدلال المحلي الخاص بك، ستتمكن من التحكم في بيئة قوية وخاصّة تمامًا لتشغيل برمجيات إدارة النظم المحلية والاستفادة من القدرات الكاملة وغير المقيدة للنماذج التي اخترتها.

تشغيل LLMs محلياً باستخدام الأدوات الشائعة

إن اختيار الأداة المناسبة هو المفتاح لفتح تجربة سلسة عند تشغيل llms محليًا. يُعتبر كل من LM Studio و Ollama و GPT4All من بين أكثر الحلول الموثوق بها، حيث يقدم كل منها إمكانيات فريدة مصممة لتناسب احتياجات سير عملك الخاصة. يمكّنك LM Studio من خلال واجهته الرسومية البديهية، مما يجعل من السهل عليك إدارة نماذج متعددة والتبديل بينها بسلاسة وضبط الإعدادات لتحقيق أفضل النتائج التي تهم مشاريعك. بالنسبة لأولئك الذين يزدهرون في البيئات الطرفية، يوفر لك Ollama تجربة سطر أوامر قوية تدعم سير عملك المتقدم وتتكامل بشكل لا تشوبه شائبة مع نظام التطوير الخاص بك.

يُمثّل GPT4All خياراً قوياً آخر في مجموعة أدواتك، حيث يدعم مجموعة واسعة من النماذج - بما في ذلك الخيارات الشائعة مثل Mistral 7B - بينما يُقدّم لك واجهة مبسّطة للتفاعل مع واجهة برمجة التطبيقات المحلية الخاصة بك. لا تقوم هذه المنصات بتشغيل النماذج فحسب، بل تمكّنك من إعداد خوادم واجهة برمجة التطبيقات دون عناء، مما يتيح التكامل السلس مع تطبيقاتك وخدماتك الحالية. سواءً كنت تدير نماذج متعددة، أو تقوم بتجربة الضبط الدقيق، أو بدأت للتو رحلتك مع أنظمة إدارة العلاقات مع الشركات المحلية، فإن هذه المنصات توفر المرونة والقوة التي تحتاجها لزيادة إمكانات الذكاء الاصطناعي المحلي لديك.

إنشاء خادم API محلي

إن إعداد خادم واجهة برمجة تطبيقات محلي هو أفضل وسيلة لتغيير قواعد اللعبة لأي شخص يتطلع إلى إحداث ثورة في تكامل نماذج اللغات الكبيرة في التطبيقات وسير العمل! باستخدام أدوات قوية مثل LM Studio و Ollama، يصبح إنشاء خادم واجهة برمجة التطبيقات المحلي المخصص لك أمرًا بسيطًا للغاية: ما عليك سوى تحديد ملف النموذج الذي اخترته، وتعيين مفتاح واجهة برمجة التطبيقات الآمن للحصول على أقصى قدر من الحماية، وتهيئة الخادم ليعمل على المنفذ المفضل لديك. يمكّنك هذا الإعداد المتطور من الوصول إلى نماذجك من خلال واجهة مستخدم ويب بديهية أو برمجيًا عبر خادم واجهة برمجة التطبيقات، مما يفتح لك تطبيقات عملية غير محدودة تُغيّر طريقة عملك.

يوفر Ollama تكاملاً سلسًا مع خادم واجهة برمجة التطبيقات مباشرةً من الصندوق، مما يجعل من السهل توصيل برمجياتك المحلية بأدوات ومنصات أخرى لتحقيق أقصى قدر من الكفاءة. يوفر LM Studio إمكانات رائعة بنفس القدر، مما يتيح لك إدارة خادم واجهة برمجة التطبيقات المحلي الخاص بك من خلال واجهة سهلة الاستخدام بشكل جميل تجعلك تتحكم بشكل كامل. من خلال إنشاء خادم واجهة برمجة التطبيقات المحلي الخاص بك، يمكنك الحصول على مرونة لا مثيل لها لنشر النماذج في سيناريوهات العالم الحقيقي، وأتمتة المهام المعقدة، وبناء حلول مخصصة تناسب احتياجاتك تمامًا - كل ذلك مع الحفاظ على بياناتك القيمة آمنة تمامًا وتحت سيطرتك المطلقة. سواءً كنت تقوم بتطوير تطبيقات رائدة أو تحسين سير العمل الحالي، فإن خادم واجهة برمجة التطبيقات المحلي هو مفتاحك لإطلاق العنان للإمكانات الاستثنائية للبنية التحتية المحلية للذكاء الاصطناعي.