Czym jest MCP w sztucznej inteligencji?

To, co powinieneś wiedzieć o Model Context Protocol, to budowanie “wieży Babylon” LLM.

LLM samo w sobie jest głupie. Jak możemy inteligentnie połączyć interfejsy API? Czy możemy to skalować?

Model Context Protocol (MCP) to warstwa pomiędzy usługą a narzędziami. Jest to standard, który upraszcza sposób, w jaki duże modele językowe (LLM) uzyskują dostęp do różnych źródeł danych. Opracowany przez Anthropic, MCP rozwiązuje problem złożonych integracji poprzez znormalizowaną komunikację, dzięki czemu rozwój sztucznej inteligencji jest szybszy i płynniejszy dzięki wykorzystaniu narzędzi opartych na sztucznej inteligencji. Dodatkowo, MCP został zaprojektowany w celu zwiększenia funkcjonalności i integracji nowej generacji narzędzi AI, wskazując na znaczny postęp w możliwościach języków programowania i zestawach narzędzi programistycznych. W tym artykule omówiono, czym jest MCP, jakie są jego zalety i jak go wdrożyć.

Wyobraź sobie, że masz robota do malowania, rozmyślania i tworzenia historii. Twoje API zostało zaktualizowane. Nie możesz już malować. MCP usunie wysiłki związane z integracją. W tym miejscu InvestGlass kieruje teraz swoimi badaniami.

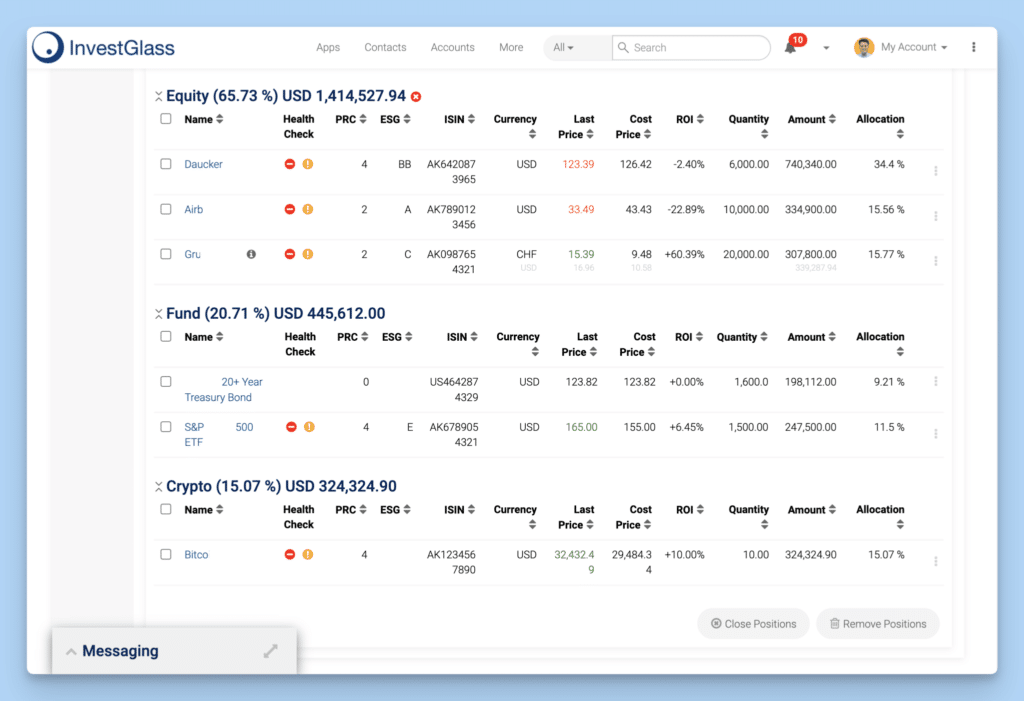

InvestGlass oferuje szwajcarski CRM i portal klienta dostosowany do potrzeb banków, doradców finansowych i firm fintech, wyposażony w narzędzia do automatyzacji onboardingu, KYC, zarządzania portfelem i komunikacji. Usprawnia zgodność z przepisami i zaangażowanie klientów, zapewniając jednocześnie prywatność danych dzięki opcjom hostingu lokalnego i w chmurze.

Kluczowe wnioski - MCP to API dla LLMS - i przyszłość InvestGlass

- Protokół MCP (Model Context Protocol) standaryzuje dostarczanie kontekstu dla dużych modeli językowych, ułatwiając płynną integrację i skracając czas opracowywania aplikacji AI.

- Architektura klient-serwer MCP usprawnia komunikację między aplikacjami AI i źródłami danych, znacznie upraszczając integrację i zwiększając interoperacyjność.

- Przyjęcie MCP poprawia wydajność pracy programistów, eliminując niestandardowe potrzeby integracji, oferując elastyczność w środowiskach programistycznych i umożliwiając skupienie się na innowacjach.

Zrozumienie protokołu MCP (Model Context Protocol)

Model Context Protocol (MCP) służy jako transformacyjny punkt odniesienia w rozwoju systemów sztucznej inteligencji, oferując coś więcej niż tylko konwencjonalną normę techniczną. Ustanowiony przez Anthropic, MCP tworzy jednolitość w zakresie dostarczania kontekstu do dużych modeli językowych, promując łatwą integrację między systemami sztucznej inteligencji i różnymi źródłami danych. Umożliwiając bezpośrednie łączenie modeli sztucznej inteligencji z różnymi klientami i zasobami, protokół ten skutecznie konsoliduje interakcje i znacznie skraca czas rozwoju. MCP działa jak port USB-C, służąc jako ustandaryzowany interfejs do łączenia modeli AI z różnymi źródłami danych i narzędziami, zwiększając interoperacyjność i wydajność. Deweloperzy chętnie korzystają z MCP ze względu na obietnicę uwolnienia pełnego potencjału sztucznej inteligencji przy jednoczesnym usunięciu tradycyjnych przeszkód napotykanych podczas rozwoju.

Zasadniczo MCP istnieje jako otwarty protokół, który organizuje płynną komunikację między aplikacjami AI i różnymi źródłami danych poprzez regulowane ramy wymiany wiadomości i strukturyzacji wiadomości. Postęp ten nie tylko promuje kompatybilność, ale także usprawnia procedurę integracji - uwalniając programistów od zajmowania się fragmentarycznymi integracjami, dzięki czemu mogą poświęcić swoje wysiłki na tworzenie pionierskich narzędzi.

Przyjęcie MCP wyposaża deweloperów w solidnie skalowalne platformy zaprojektowane do zarządzania złożonością w przyszłości. sztuczna inteligencja systemy - zakotwiczając je mocno w oczekiwaniu na nadchodzący rozwój technologii.

LLM będą bardziej wydajne - Antropic buduje standard i zalecamy ostrożność, ponieważ nie jest to jeszcze ustalony standard.

Podstawowe koncepcje MCP

Model Context Protocol (MCP) składa się z dwóch głównych elementów: serwerów i klientów w ramach MCP. Rolą serwera MCP jest ułatwianie żądań, przyznawanie dostępu do różnych zewnętrznych narzędzi lub źródeł danych w razie potrzeby, podczas gdy funkcja klienta MCP polega na pozyskiwaniu zasobów i obsłudze zadań przetwarzania danych. Ten podział na architekturę klient-serwer odgrywa kluczową rolę w tworzeniu standardowych kanałów dla aplikacji AI do komunikacji z różnymi dostawcami danych, promując usprawnioną integrację i minimalizując zależność od niestandardowych rozwiązań.

W sercu swojego działania MCP wykorzystuje warstwę protokołu odpowiedzialną za regulowanie działań, takich jak strukturyzacja wiadomości i kojarzenie zapytań z ich odpowiednimi odpowiedziami. Przyjmując JSON-RPC 2.0 do celów przesyłania wiadomości, gwarantuje uporządkowaną komunikację, która jest zgodna z ustalonymi formatami. Podczas początkowej fazy negocjacji klienci muszą przekazać obsługiwaną wersję protokołu do serwera, który następnie odpowiednio odpowiada, umożliwiając dostosowaną interakcję w oparciu o możliwości zdefiniowane w tej wersji.

MCP zwiększa wszechstronność dostosowaną do różnych wymagań programistycznych, dostarczając zestawy SDK (Software Development Kit), które są kompatybilne z różnymi środowiskami programistycznymi. Dzięki temu jednolitemu podejściu nie tylko usprawnia sposób zarządzania rozproszonymi źródłami danych, ale także wzmacnia proces budowy skomplikowanych przepływów pracy, znacząco przyczyniając się do poprawy wydajności usług wśród przedsięwzięć AI, jednocześnie ustanawiając się jako niezawodny dostawca zasobów.

Czy sztuczna inteligencja Manis to prawdziwy strzał w dziesiątkę, czy tylko przereklamowana automatyzacja?

Manis AI to wiele godzin pracy - bez MCP będzie to bardzo trudne do utrzymania. Korzyści z MCP są dość proste. Połączenie wszystkich serwerów MCP będzie wielkim postępem.

Przyjęcie MCP przynosi znaczną korzyść w postaci wyeliminowania wymogu odrębnej integracji różnych usług AI. Protokół komunikacyjny MCP jest znormalizowany, promując większą interoperacyjność i umożliwiając szybszy, bardziej usprawniony proces integracji dla różnych platform AI. Taka poprawa interoperacyjności okazuje się szczególnie cenna w nowoczesnych środowiskach programistycznych, w których maksymalizacja wydajności czasowej i wykorzystania zasobów ma kluczowe znaczenie.

MCP zapewnia deweloperom znaczną elastyczność. Mogą oni wykorzystywać swoje preferowane języki programowania i stosy technologiczne podczas wdrażania tego protokołu, zapewniając, że mogą skutecznie stosować swoją obecną wiedzę i narzędzia.

Łącznie korzyści te prowadzą do znacznej poprawy przepływu pracy związanego z projektami deweloperskimi, sprzyjając płynniejszym operacjom i wyższym poziomom produktywności. Włączając MCP do swoich procesów, deweloperzy zyskują możliwość skupienia się na kreatywnych innowacjach i rozwiązywaniu złożonych problemów bez przeszkód związanych z integracją.

Jak działa MCP?

MCP wykorzystuje model klient-serwer, który usprawnia sposób, w jaki aplikacje dostarczają kontekst i narzędzia do znaczących modeli językowych (LLM). W tych ramach klienci MCP obsługują zadania żądania zasobów i przetwarzania danych. Z drugiej strony, serwery MCP służą jako moderatorzy, nadzorując te żądania i udzielając dostępu do zewnętrznych narzędzi lub źródeł danych. Struktura ta ułatwia integrację i zmniejsza zależność od rozwiązań dostosowanych do indywidualnych potrzeb, pozwalając programistom skoncentrować się na opracowywaniu najnowocześniejszych aplikacji AI.

Aby połączyć swoje dane z instrumentami sztucznej inteligencji w ramach MCP, programiści mogą udostępniać swoje dane za pośrednictwem serwerów MCP lub tworzyć dedykowanych klientów MCP. Metodologia ta znacznie łagodzi zawiłości związane z włączaniem szeregu usług AI, zapewniając płynne interakcje między systemami AI i bazami danych. Zastosowanie MCP pomaga w tworzeniu spójnych i skutecznych systemów sztucznej inteligencji, które są w stanie zaspokoić współczesne potrzeby w zakresie rozwoju sztucznej inteligencji, zwłaszcza w przypadku rozproszonych zespołów pracujących w różnych lokalizacjach.

Typy wiadomości w MCPww

MCP zarządza różnymi typami komunikatów w celu ułatwienia komunikacji między klientami i serwerami. Podstawowe typy komunikatów w MCP obejmują żądania, wyniki, błędy i powiadomienia. Żądania są inicjowane przez klientów MCP i wymagają odpowiedzi, aby wskazać pomyślne przetwarzanie. Wyniki reprezentują pomyślne odpowiedzi na żądania, potwierdzając, że żądana operacja została zakończona.

Z drugiej strony, błędy oznaczają nieudane żądanie, wskazując, że operacja nie mogła zostać zakończona. Powiadomienia są zaprojektowane jako jednokierunkowa komunikacja, która nie wymaga odpowiedzi, zapewniając aktualizacje statusu bez oczekiwania odpowiedzi.

Jasne zdefiniowanie typów komunikatów i wdrożenie ich strukturyzacji zapewnia niezawodną i uporządkowaną komunikację między aplikacjami AI i źródłami danych, zwiększając wydajność systemu.

Mechanizmy transportowe - wszystko zależy od protokołu

MCP umożliwia wymianę danych za pośrednictwem kilku protokołów transportowych, dostosowanych do potrzeb różnych ustawień programistycznych. Działając lokalnie, MCP wykorzystuje stdio do nieskomplikowanej komunikacji międzyprocesowej. Z kolei w scenariuszach obejmujących rozproszone zespoły, MCP zaleca korzystanie z protokołu HTTP w połączeniu ze zdarzeniami wysyłanymi przez serwer (SSE), aby ułatwić natychmiastową transmisję danych między różnymi systemami zewnętrznymi.

We wszystkich formach komunikacji w ramach MCP stosowany jest format wiadomości JSON-RPC 2.0, aby zagwarantować ustrukturyzowaną i jednolitą metodę wymiany danych, która dobrze pasuje do wielu kontekstów programowania. Przyjęcie tych zróżnicowanych mechanizmów transportowych zapewnia MCP elastyczność wymaganą do wydajnego stosowania w różnych środowiskach rozwojowych - od indywidualnych testów lokalnych po rozległe integracje systemów rozproszonych.

Konfiguracja serwerów MCP

Ustanowienie serwerów protokołu kontekstu modelu wymaga ustawienia zmiennych środowiskowych w celu wyznaczenia konfiguracji i zainicjowania serwera za pomocą polecenia hype. Chociaż można włączyć serwery MCP za pośrednictwem interfejsu użytkownika, podejście to jest zwykle odradzane, ponieważ może wprowadzać złożoność. W przypadku dodawania serwera za pośrednictwem interfejsu użytkownika należy wykonać odświeżenie, aby uzyskać dostęp do dostępnych narzędzi.

Deweloperzy rozpoczynający konfigurację własnych serwerów MCP mają do dyspozycji wiele przykładowych serwerów, które służą jako punkty startowe. Oczekuje się, że zestawy narzędzi dostosowane do wdrażania zdalnych serwerów MCP na poziomie produkcyjnym będą dostępne w odpowiednim czasie.

Format pliku konfiguracyjnego

Pliki konfiguracyjne MCP wykorzystują format JSON, który obsługuje zagnieżdżone obiekty i tablice, umożliwiając przedstawienie skomplikowanych ustawień. Ta systematyczna metodologia gwarantuje, że konfiguracje są dostępne do odczytu i interpretacji przez ludzi, a jednocześnie są kompatybilne z analizą maszynową, upraszczając w ten sposób proces nadzorowania i dostosowywania ustawień przez programistów.

Lokalizacje wdrożenia

Aby osiągnąć najlepszą wydajność, ważne jest, aby pliki konfiguracyjne MCP znajdowały się w katalogach, do których serwer ma łatwy dostęp. Takie umiejscowienie pozwala serwerowi na efektywne wykorzystanie tych konfiguracji, co skutkuje większą stabilnością operacje i ulepszone wydajność.

Kluczowe jest umieszczenie tych plików w katalogach dostosowanych do konkretnych scenariuszy, aby zapewnić ich prawidłowe wykorzystanie, zwłaszcza podczas integracji różnych narzędzi AI z każdym źródłem danych.

Integracja MCP z InvestGlass AI

Włączenie MCP do InvestGlass Systemy AI zapewniają programistom możliwość ustanowienia chronionych, dwukierunkowych połączeń między źródłami danych a instrumentami AI. Starsze systemy tworzą bariery dla zaawansowanych modeli sztucznej inteligencji, zamykając je w silosach informacyjnych i uniemożliwiając płynny dostęp do kluczowych danych. W ten sposób usprawnia przepływ pracy i usuwa bariery między repozytoriami danych, wspierając ujednolicone środowisko do wdrażania rozwiązań AI. Standardy ustanowione przez MCP dla interakcji i wymiany informacji zmniejszają złożoność procesów integracji, ułatwiając płynne interakcje między zewnętrznymi punktami danych a aplikacjami opartymi na sztucznej inteligencji.

MCP jest korzystne niezależnie od tego, czy dana osoba jest zaangażowana we wszechstronność InvestGlass Pomocnicy AI lub tworzenie wieloplatformowego oprogramowania AI. Poprawia to jakość integracji i efektywne wykorzystanie różnych zestawów informacji. W rezultacie nie tylko zwiększa to wydajność operacji, ale także toruje drogę nowatorskim metodologiom kreatywnego stosowania sztucznej inteligencji.

Korzystanie z Claude Desktop z MCP

Rozpoczęcie korzystania z Claude Desktop wraz z MCP wymaga najpierw nabycia aplikacji desktopowej i dostosowania pliku claude_desktop_config.json. Zasadniczym krokiem po instalacji jest dostosowanie tego pliku konfiguracyjnego do określonych wymagań integracji. Następnie Claude Desktop ma możliwość utworzenia graficznej reprezentacji z węzłami i krawędziami oznaczającymi połączenia po uzyskaniu autoryzacji dostępu.

Zadanie rozpoznania statusu serwera jest proste dzięki wykorzystaniu interfejsu dostarczanego przez Claude Desktop, który wyświetla zarówno połączone serwery, jak i ich dostępne zasoby. Ta konfiguracja wzmacnia pozycję programistów, umożliwiając im efektywne wykorzystanie protokołu MCP (Model Context Protocol) w celu ustanowienia łączności między modelami AI, pomagając w ten sposób w rozwoju aplikacji AI.

Tworzenie niestandardowych integracji

MCP SDK ułatwia tworzenie płynnych niestandardowych integracji w ramach MCP, oferując wsparcie dla Python i TypeScript. Dzięki temu deweloperzy mogą z łatwością wykorzystywać możliwości MCP w wybranych przez siebie środowiskach programistycznych, usprawniając proces tworzenia dostosowanych rozwiązań.

Bezpieczeństwo i obsługa błędów w MCP

Utrzymanie silnego bezpieczeństwa i skutecznego zarządzania błędami jest kluczem do sprawnego funkcjonowania MCP. Aby zwiększyć bezpieczeństwo, stosowane są protokoły uwierzytelniania w celu potwierdzenia tożsamości użytkownika przed zezwoleniem na dostęp do zasobów. Kluczowe jest sprawdzanie źródła każdego połączenia i oczyszczanie przychodzących wiadomości w celu wyeliminowania potencjalnych słabych punktów. Przyjęcie rygorystycznych zasad bezpieczeństwa i kompleksowej obsługi błędów zapewnia niezawodne działanie, jednocześnie chroniąc poufne dane przed jakimkolwiek zagrożonym źródłem danych.

W przypadku wystąpienia błędów w MCP, istnieje określony proces ich propagacji, który pomaga w prawidłowym rozwiązaniu bez znaczącego zakłócania przepływów komunikacyjnych. Istnieje zestaw standardowych kodów błędów, tworzących jednolitą metodę rozpoznawania i rozwiązywania pojawiających się problemów. Ta ustandaryzowana procedura ułatwia szybkie rozwiązywanie problemów przy jednoczesnym zachowaniu wierności procesu komunikacji.

Zapewnienie bezpieczeństwa danych

MCP wykorzystuje metody szyfrowania do zabezpieczania danych w tranzycie, gwarantując, że poufne informacje pozostają chronione. W przypadku komunikacji obejmującej dane zdalne, szyfrowanie TLS stanowi silną barierę bezpieczeństwa.

Ochrona szczegółowych informacji podczas transmisji ma kluczowe znaczenie dla zachowania integralności źródła danych i udaremnienia wszelkich potencjalnych naruszeń bezpieczeństwa.

Znormalizowane kody błędów

Protokół MCP wykorzystuje zestaw predefiniowanych kodów błędów zaprojektowanych do jednolitego rozwiązywania problemów i utrzymywania spójnej obsługi błędów. Pozwala również na tworzenie niestandardowych kodów błędów, które wykraczają poza standardowy wybór, zapewniając możliwość zarządzania błędami specyficznymi dla aplikacji. To ustandaryzowane podejście do zgłaszania błędów zapewnia niezawodność i wydajność systemu.

Rzeczywiste zastosowania MCP

MCP rozwiązuje powszechne problemy związane z rozwojem sztucznej inteligencji, w tym rozproszone łącza danych i odizolowane niestandardowe kieszenie integracyjne. Dzięki zastosowaniu MCP deweloperzy są w stanie tworzyć bardziej inteligentne i rozszerzalne aplikacje AI. Podmioty takie jak Block i Apollo skutecznie zintegrowały MCP w swoich systemach, pokazując jego skuteczność w zwiększaniu wydajności operacyjnej, jednocześnie podkreślając wymierne korzyści wynikające z zastosowania tego protokołu.

Praktyczne przykłady serwerów MCP wprowadzonych w życie przez Anthropic, podmioty zewnętrzne i szerszą społeczność podkreślają zarówno ich zdolność adaptacji, jak i potencjał. Przypadki te dają jasny obraz tego, jak wykorzystanie MCP może uprościć rozwój sztucznej inteligencji, jednocześnie zwiększając wydajność aplikacji AI w wielu sektorach.

Aplikacje oparte na sztucznej inteligencji

Aplikacje, w których priorytetem jest sztuczna inteligencja, w tym asystenci sztucznej inteligencji i zintegrowane środowiska programistyczne (IDE), mogą wykorzystywać MCP do poprawy funkcjonalności i usprawnienia procesów. Integracja asystentów aplikacji AI ogólnego przeznaczenia z różnymi aplikacjami zwiększa rozpoznawalność kontekstu i poprawia wrażenia użytkownika. Oczywiście planujemy połączyć InvestGlass z tymi nowymi koncepcjami, ale najpierw chcemy zatwierdzić standard.

Wieloplatformowe aplikacje wykorzystujące MCP są w stanie standaryzować funkcje AI, co zwiększa ich ogólne możliwości.

Skalowalne usługi AI

MCP ułatwia zaawansowane przetwarzanie rozproszone, co ma kluczowe znaczenie dla skutecznego nadzorowania przepływów pracy AI w miarę zwiększania skali systemów. Architektura MCP zapewnia niezbędną elastyczność i kompatybilność do eskalacji usług AI na różnych platformach. Wyobraź sobie, że możesz połączyć wszystkie fintechy jednym kliknięciem - i bez dodatkowych kosztów utrzymywać relacje między oprogramowaniem!

Standaryzowana metodologia wykorzystywana przez MCP gwarantuje usprawnione wdrażanie i administrowanie złożonymi modelami podczas zarządzania rozproszonym przetwarzaniem AI.

Rozwiązywanie problemów i debugowanie serwerów MCP

Różne narzędzia zaprojektowane dla różnych poziomów rozwiązywania problemów ułatwiają diagnozowanie i naprawianie problemów z serwerami MCP. Na przykład MCP Inspector oferuje natychmiastowy wgląd w wydajność serwera, ułatwiając szybkie rozwiązywanie problemów.

Analiza zasobów serwera w czasie rzeczywistym i szablony podpowiedzi tego narzędzia znacznie poprawiają możliwość skutecznego nadzorowania serwerów MCP.

Rejestrowanie i diagnostyka

Protokół kontekstu modelu opiera się na znormalizowanym sposobie obsługi dzienników, diagnostyki i ogólnej integralności systemu, zapewniając, że serwery mogą bezpiecznie łączyć się ze źródłami danych i narzędziami. Aby framework MCP mógł szybko identyfikować i naprawiać problemy, każdy serwer mcp musi wdrożyć solidne praktyki logowania. Na przykład przekierowanie logów do standardowego błędu służy jako niezawodna metoda zapobiegania wszelkim niezamierzonym zakłóceniom operacji protokołu, zachowując w ten sposób ogólną stabilność serwerów protokołu kontekstu modelu.

Przyjęcie prawidłowych konfiguracji dziennika usprawnia procedury rozwiązywania problemów i utrzymuje niezawodność całego protokołu kontekstowego. Pomaga to zagwarantować, że aplikacje LLM, klienci i inne narzędzia mogą zachować płynną integrację. Z kolei ta praktyka pomaga zminimalizować zakłócenia w źródłach danych i narzędziach, umożliwiając programistom i firmom rozpoczęcie tworzenia rozwiązań z zapewnieniem, że kontekst pozostaje nienaruszony i chroniony.

Dlaczego warto korzystać z MCP Inspector?

MCP Inspector wyróżnia się jako niezbędne narzędzie do kontroli i walidacji wydajności serwerów protokołu kontekstu modelu. Działając jako komponent otwartego protokołu, wzmacnia przekonanie, że MCP jest znormalizowanym i przejrzystym systemem zaprojektowanym w celu zachęcenia do szerszego zaangażowania w rozwój. Dzięki MCP Inspector administratorzy i programiści mogą szybko monitorować połączenia serwerów, sprawdzać ich spójność kontekstową i potwierdzać, że każdy plik lub źródło danych zaangażowane w proces działa bezbłędnie.

Ta płynna integracja funkcji diagnostycznych wspiera środowisko współpracy między serwerami, klientami i źródłami danych, zachowując podstawowy kontekst modelu. Oferując uproszczone, ale potężne środki do łączenia się i analizowania wewnętrznego działania MCP, MCP Inspector usprawnia wszystko, od ogólnej inspekcji po dogłębną diagnostykę, pomagając użytkownikom utrzymać optymalną wydajność we wszystkich aplikacjach i narzędziach LLM.

Wkład w MCP

Wkład w MCP, czyli Model Context Protocol, stanowi kluczową część tego otwartego standardu i pokazuje ducha protokołu napędzanego przez społeczność. Ponieważ MCP został zaprojektowany w celu ułatwienia płynnej integracji ze źródłami danych i narzędziami, opinie i współpraca społeczności są nieocenione dla jego rozwoju i trwałego znaczenia.

Programiści, architekci systemów i entuzjaści są zachęcani do dzielenia się swoimi spostrzeżeniami poprzez rozwiązywanie istniejących problemów, dodawanie ulepszeń dokumentacji lub sugerowanie nowych funkcji, które wspierają misję MCP jako znormalizowanego sposobu orkiestracji interakcji między serwerami, klientami i kontekstem. Niezależnie od tego, czy wiąże się to z udoskonalaniem podpowiedzi, ulepszaniem metod obsługi dzienników, czy też odkrywaniem nowych podejść do dwukierunkowego procesu wymiany danych, każdy wkład popycha protokół kontekstu modelu do przodu. W ten sposób członkowie społeczności nie tylko rozwijają ten otwarty protokół, ale także pomagają utorować drogę dla bardziej niezawodnych i przyjaznych dla użytkownika aplikacji LLM.

Wkład społeczności

Aktywne zaangażowanie szerszej społeczności jest podstawą zapewnienia, że Model Context Protocol (MCP) spełnia zmieniające się potrzeby i konsekwentnie zapewnia znormalizowane środki łączenia źródeł danych i narzędzi. Wnosząc poprawki błędów, dodatkową dokumentację lub nowe funkcje, członkowie społeczności pomagają udoskonalić sposób działania serwerów MCP, wymiany danych plików i dostosowania do wymagań klientów.

Informacje zwrotne z różnych środowisk - czy to poprzez kwestie GitHub, fora społecznościowe, czy dyskusje na temat tego, jak najlepiej wykorzystać zaawansowane aplikacje LLM - są nieocenione dla początkowego budowania i ciągłego udoskonalania protokołu kontekstowego. Dzielenie się bezpośrednimi doświadczeniami, wiedzą na temat kodowania lub nowo odkrytymi technikami jeszcze bardziej umacnia pozycję MCP jako otwartej struktury protokołu, która obejmuje wspólne postępy. Dzięki takiemu integracyjnemu podejściu, projekt MCP czerpie korzyści ze zbiorowej inteligencji, ostatecznie dostarczając bardziej wydajną diagnostykę, wzbogacone śledzenie dziennika i udoskonalone narzędzia zdolne do obsługi szerokiego spektrum aplikacji.

Kanały wsparcia i informacji zwrotnej

Pytania dotyczące wkładu w MCP można kierować na forum społeczności. Platforma ta umożliwia deweloperom uzyskanie pomocy od innych kolegów i specjalistów w tej dziedzinie. Oferowanie informacji zwrotnych odgrywa istotną rolę w ewolucji procesu rozwoju, ponieważ umożliwia uczestnikom pomoc w ulepszaniu protokołu.

Zaleca się, aby użytkownicy przedstawiali swoje sugestie i pomysły dotyczące nowych funkcji, angażując się w dialogi społecznościowe i wykorzystując uznane ścieżki.

Czekasz na Godo? Czekasz na otwarty standard?

Podsumowując, Model Context Protocol (MCP) oferuje znormalizowany sposób łączenia się aplikacji LLM ze źródłami danych i narzędziami - od repozytoriów treści i baz danych po serwery aplikacji hosta - za pośrednictwem dwukierunkowego systemu połączeń. Korzystanie z serwerów i klientów MCP w ramach otwartego standardu znacznie zmniejsza fragmentację integracji. Ten protokół kontekstowy umożliwia zaawansowanym modelom wysyłanie zapytań, przetwarzanie i interakcję z dowolnym nowym źródłem danych w standardowym protokole, poprawiając sposób, w jaki narzędzia biznesowe wykorzystują narzędzia oparte na sztucznej inteligencji.

Ponieważ MCP zaspokaja potrzebę bezpiecznych i płynnych połączeń klienckich, programiści mogą polegać na wkładzie i kodzie projektu open-source w celu ulepszenia tego uniwersalnego standardu. MCP wspiera znormalizowane środowisko, w którym narzędzia mogą budować zaawansowane rozwiązania bez obaw dzięki zarządzaniu dziennikami, podpowiedziom i dostępowi do plików w czasie rzeczywistym. Eliminując powtarzające się, fragmentaryczne integracje, serwery protokołu kontekstowego modelu upraszczają sposób spełniania wymagań źródła danych przy jednoczesnym zachowaniu szyfrowania TLS i bezpieczeństwa narzędzi biznesowych.

Z InvestGlass Monitorując implementację opartą na MCP, zawsze będziesz mieć dostęp do wskazówek ekspertów w zakresie przetwarzania i udoskonalania połączeń we wszystkich źródłach danych. Będziemy śledzić każdy krok, zapewniając znalezienie najlepszej ścieżki rozwoju w ramach tego otwartego protokołu. Wykorzystując MCP, InvestGlass pomaga zintegrować zaawansowane modele i klientów w znormalizowanym protokole, torując drogę do bardziej wydajnych, usprawnionych aplikacji LLM - dzięki czemu możesz śmiało skupić się na innowacjach.

Ramy sztucznej inteligencji, Przetwarzanie danych, Uczenie maszynowe