स्थानीय स्तर पर एलएलएम कैसे चलाएं: सेल्फ-होस्टेड एआई मॉडल के लिए 2025 की संपूर्ण गाइड

The ऐ क्रांतिकारी बदलाव हो रहा है, लेकिन इसका लाभ उठाने के लिए आपको अपना संवेदनशील डेटा क्लाउड सेवाओं पर भेजने या मासिक सदस्यता शुल्क का भुगतान करने की आवश्यकता नहीं है। अपने कंप्यूटर पर स्थानीय रूप से बड़े भाषा मॉडल चलाने से आपको अपनी एआई इंटरैक्शन पर पूर्ण नियंत्रण मिलता है, साथ ही पूर्ण गोपनीयता बनी रहती है और निरंतर लागत समाप्त हो जाती है।.

इस व्यापक गाइड में, आपको स्थानीय स्तर पर एलएलएम चलाने के लिए आवश्यक सभी जानकारी मिलेगी, जिसमें सही टूल और मॉडल चुनने से लेकर अपने हार्डवेयर पर प्रदर्शन को अनुकूलित करना शामिल है। चाहे आप कोडिंग सहायता चाहने वाले डेवलपर हों या कोई व्यवसाय की रक्षा चाहे संवेदनशील डेटा हो, या कोई एआई उत्साही व्यक्ति जो ऑफ़लाइन पहुंच चाहता हो, स्थानीय एलएलएम क्लाउड-आधारित विकल्पों की तुलना में कई आकर्षक लाभ प्रदान करते हैं।.

हम 2025 के लिए सर्वश्रेष्ठ उपकरणों और हार्डवेयर आवश्यकताओं पर चर्चा करेंगे जो आपके सिस्टम को बाधित नहीं करेंगे। किनारा, साथ ही, कुछ ही मिनटों में अपना पहला स्थानीय एलएलएम (लोकल लायन लर्निंग प्रोग्राम) शुरू करने के लिए चरण-दर-चरण ट्यूटोरियल भी दिए गए हैं। अंत तक, आप यह समझ जाएंगे कि अपनी गोपनीयता या बजट से समझौता किए बिना अत्याधुनिक भाषा मॉडलों की शक्ति का उपयोग कैसे करें।.

आप क्या सीखेंगे

- स्थानीय स्तर पर एलएलएम चलाने का क्या अर्थ है और यह कैसे काम करता है

- सेल्फ-होस्टेड एआई बनाम क्लाउड एआई के लाभ

- 2025 के सर्वश्रेष्ठ उपकरण (एलएम स्टूडियो, ओलामा, जीपीटी4ऑल, जैन, ल्लामाफाइल, ल्लामा.सीपीपी)

- 2B से 70B+ तक के मॉडलों के लिए हार्डवेयर आवश्यकताएँ पैरामीटर

- अपने पहले मॉडल को कैसे स्थापित करें और चलाएं

- सुरक्षित स्थानीय एपीआई सर्वर कैसे बनाएं

- व्यक्तिगत और व्यावसायिक वर्कफ़्लो के लिए वास्तविक दुनिया के उपयोग के उदाहरण

- प्रदर्शन संबंधी सुझाव, समस्या निवारण और लागत तुलना

लार्ज लैंग्वेज मॉडल्स का परिचय

बड़े भाषा मॉडल (एलएलएम) क्रांतिकारी हैं। कृत्रिम होशियारी ये सिस्टम आपके प्रौद्योगिकी के साथ बातचीत करने के तरीके को बदल देते हैं, इन्हें अभूतपूर्व दक्षता के साथ मानवीय भाषा को समझने, उत्पन्न करने और उसमें हेरफेर करने के लिए डिज़ाइन किया गया है। टेक्स्ट के विशाल डेटासेट पर प्रशिक्षण प्राप्त करके, ये क्रांतिकारी बड़े भाषा मॉडल सुसंगत, संदर्भ-जागरूक प्रतिक्रियाएँ प्रदान करते हैं जो आपके कार्यप्रवाह में क्रांति लाते हैं, जिससे ये चैटबॉट और वर्चुअल असिस्टेंट से लेकर भाषा अनुवाद, टेक्स्ट सारांश और रचनात्मक सामग्री निर्माण तक, जो उपयोगकर्ताओं को प्रसन्न करती है और परिणाम देती है, जैसे अनुप्रयोगों की एक अविश्वसनीय श्रृंखला के लिए अत्यंत आवश्यक बन जाते हैं।.

अपने कंप्यूटर पर बड़े भाषा मॉडल (LLM) को स्थानीय रूप से चलाने से ऐसे असाधारण लाभ मिलते हैं जो क्लाउड सेवाओं से संभव नहीं हैं। जब आप LLM को स्थानीय रूप से चलाते हैं, तो आप अपने संवेदनशील डेटा पर पूर्ण नियंत्रण बनाए रखते हैं, यह सुनिश्चित करते हुए कि गोपनीय जानकारी कभी भी आपके डिवाइस से बाहर न जाए। यह गोपनीयता-प्रथम दृष्टिकोण विश्वास पैदा करता है। यह शक्तिशाली रणनीति न केवल सुरक्षा और मानसिक शांति को बढ़ाती है, बल्कि बाहरी प्रदाताओं पर निर्भरता को भी समाप्त करती है और आवर्ती सदस्यता शुल्क को शून्य कर देती है। परिणामस्वरूप, समझदार व्यक्ति और दूरदर्शी संगठन LLM को स्थानीय रूप से चलाने का विकल्प चुन रहे हैं, और सुरक्षा से समझौता किए बिना या निरंतर लागतों को बढ़ाए बिना, व्यावसायिक स्वचालन से लेकर व्यक्तिगत उत्पादकता तक, हर चीज के लिए इन मॉडलों की पूरी क्षमता का लाभ उठा रहे हैं।.

चाहे आप अत्याधुनिक मॉडलों के साथ प्रयोग करने के शौकीन हों, अपनी सफलता को बढ़ाने वाले कस्टम एआई-संचालित टूल बनाने के इच्छुक हों, या बस अधिक निजी और तीव्र एआई अनुभव की तलाश में हों, स्थानीय रूप से एलएलएम चलाने से अत्याधुनिक भाषा मॉडलों की क्षमताएं सीधे आपके हाथों में आ जाती हैं, जिससे आप तेजी से नवाचार कर सकते हैं, सुरक्षित रह सकते हैं और असाधारण परिणाम दे सकते हैं।.

स्थानीय स्तर पर एलएलएम चलाने का क्या अर्थ है?

बड़े भाषा मॉडल को स्थानीय रूप से चलाने का मतलब है कि आप ChatGPT, Claude या Gemini जैसी क्लाउड सेवाओं पर निर्भर रहने के बजाय, परिष्कृत AI मॉडल को सीधे अपने कंप्यूटर या स्थानीय मशीन पर संचालित कर सकते हैं। जब आप llm को स्थानीय रूप से चलाते हैं, तो पूरी अनुमान प्रक्रिया आपके अपने हार्डवेयर पर होती है, और कोई भी डेटा इंटरनेट के माध्यम से बाहरी सर्वरों पर प्रसारित नहीं होता है।.

स्थानीय एलएलएम के मुख्य लाभों में पूर्ण डेटा गोपनीयता, प्रारंभिक सेटअप के बाद शून्य सदस्यता शुल्क और इंटरनेट कनेक्शन के बिना काम करने की ऑफ़लाइन कार्यक्षमता शामिल हैं। आपका संवेदनशील डेटा कभी भी आपके डिवाइस से बाहर नहीं जाता है, जिससे गोपनीय जानकारी संभालने वाले व्यवसायों, मालिकाना कोड पर काम करने वाले डेवलपर्स या गोपनीयता को लेकर चिंतित व्यक्तियों के लिए स्थानीय अनुमान विशेष रूप से मूल्यवान हो जाता है।.

क्लाउड-आधारित एआई सेवाओं के विपरीत, जिनमें एपीआई कुंजी की आवश्यकता होती है और प्रति अनुरोध शुल्क लिया जाता है, स्थानीय मॉडल एक बार GitHub या Hugging Face जैसे रिपॉजिटरी या स्रोतों से मॉडल डाउनलोड करने और मॉडल फ़ाइल को अपने कंप्यूटर पर सहेजने के बाद असीमित उपयोग प्रदान करते हैं। इससे लागत का अनुमान लगाना आसान हो जाता है और एपीआई दर सीमाओं या सेवा रुकावटों के कारण आपके कार्यप्रवाह पर पड़ने वाले प्रभाव की चिंता समाप्त हो जाती है।.

एक व्यावहारिक तुलना इस अंतर को स्पष्ट करती है: चैटजीपीटी का उपयोग करते समय, आपके प्रश्न उत्तर प्राप्त करने से पहले प्रसंस्करण के लिए ओपनएआई के सर्वरों तक जाते हैं। आपके कंप्यूटर पर चलने वाले लामा 3.2 जैसे स्थानीय एलएलएम के साथ, सब कुछ आपके उपभोक्ता हार्डवेयर पर होता है। क्लाउड सेवाएं सुविधा और अत्याधुनिक मॉडल प्रदान करती हैं, जबकि स्थानीय एआई गोपनीयता, नियंत्रण और लागत की पूर्वानुमान क्षमता प्रदान करता है, जो कई उपयोगकर्ताओं को आकर्षक लगता है।.

आम गलतफहमियों में यह धारणा शामिल है कि स्थानीय स्तर पर एलएलएम चलाने के लिए महंगे जीपीयू हार्डवेयर या जटिल तकनीकी सेटअप की आवश्यकता होती है। एलएम स्टूडियो और जीपीटी4ऑल जैसे आधुनिक उपकरणों ने इस प्रक्रिया को काफी सरल बना दिया है, और कई छोटे मॉडल पर्याप्त रैम वाले मानक डेस्कटॉप कंप्यूटरों पर प्रभावी ढंग से चलते हैं।.

स्थानीय वातावरण की स्थापना

स्थानीय एलएलएम के साथ शुरुआत करने के लिए, अपने कंप्यूटर को एक शक्तिशाली एआई पावरहाउस में बदलना होगा जो आपकी उंगलियों पर असाधारण प्रदर्शन प्रदान करता है। पहला कदम यह सुनिश्चित करना है कि आपका ऑपरेटिंग सिस्टम, चाहे वह विंडोज, मैकओएस या लिनक्स हो, एलएम स्टूडियो, ओलामा या जीपीटी4ऑल जैसे अत्याधुनिक टूल के लिए एक आदर्श आधार बने। ये सभी गेम-चेंजिंग प्लेटफॉर्म स्थानीय मॉडल को प्रबंधित करने और उनके साथ इंटरैक्ट करने के लिए एक सुव्यवस्थित, उपयोगकर्ता-अनुकूल दृष्टिकोण प्रदान करते हैं, जिससे उन्नत एआई सभी के लिए सुलभ हो जाता है, यहां तक कि उन लोगों के लिए भी जो इस रोमांचक क्षेत्र में अपने पहले कदम रख रहे हैं। कृत्रिम बुद्धिमत्ता की दुनिया.

इसके बाद, आप अपने हार्डवेयर की पूरी क्षमता का उपयोग करके शानदार परफॉर्मेंस हासिल करना चाहेंगे। हालांकि कई छोटे मॉडल स्टैंडर्ड डेस्कटॉप या लैपटॉप पर भी प्रभावशाली परिणाम देते हैं, लेकिन एक आधुनिक CPU, पर्याप्त RAM और, आदर्श रूप से, एक डेडिकेटेड GPU होने से आपका अनुभव और भी बेहतर हो जाएगा और आप बड़े, अधिक परिष्कृत मॉडल को भी बेहतरीन तरीके से चला पाएंगे। अपने सिस्टम को अपने चुने हुए टूल और मॉडल की न्यूनतम आवश्यकताओं को पूरा करके, आप अद्वितीय AI क्षमताओं के लिए खुद को तैयार कर रहे हैं।.

एक बार जब आपका हार्डवेयर और ऑपरेटिंग सिस्टम पूरी तरह से अनुकूल हो जाएं, तो आप अपना पसंदीदा टूल इंस्टॉल कर सकते हैं और कमाल देख सकते हैं। उदाहरण के लिए, LM Studio एक सहज ग्राफिकल इंटरफ़ेस प्रदान करता है जो मॉडल प्रबंधन को बेहद सरल बना देता है, जबकि Ollama एक कमांड लाइन अनुभव प्रदान करता है जो डेवलपर्स को उन्नत नियंत्रण प्रदान करता है। इंस्टॉलेशन के बाद, आपको अपने स्थानीय कंप्यूटर पर संगत मॉडल ब्राउज़ करने, डाउनलोड करने और चलाने की पूरी आज़ादी होगी, जिससे आपको अपने AI अनुभव पर पूर्ण नियंत्रण प्राप्त होगा।.

सही टूल का सावधानीपूर्वक चयन करके और अपने वातावरण को कुशलतापूर्वक कॉन्फ़िगर करके, आप स्थानीय रूप से एलएलएम चलाने और एआई में नवीनतम प्रगति की पूरी शक्ति का लाभ उठाने के लिए आवश्यक सभी चीज़ों से लैस होंगे। आपको न केवल स्थानीय एआई क्षमताएं मिलती हैं, बल्कि पूर्ण स्वतंत्रता, बेहतर गोपनीयता और तीव्र प्रदर्शन भी मिलता है जो कृत्रिम बुद्धिमत्ता के साथ आपके काम करने के तरीके को बदल देता है।.

त्वरित शुरुआत: 2025 में स्थानीय स्तर पर एलएलएम चलाने के लिए सर्वश्रेष्ठ उपकरण

स्थानीय एलएलएम चलाने के लिए उपकरणों का परिदृश्य नाटकीय रूप से विकसित हो गया है, जो उपयोगकर्ता के अनुकूल विकल्प प्रदान करता है और अधिकांश तकनीकी बाधाओं को दूर करता है। यहां शीर्ष पांच प्लेटफॉर्म दिए गए हैं जो हर कौशल स्तर के उपयोगकर्ताओं के लिए स्थानीय रूप से मॉडल चलाना आसान बनाते हैं, जिनमें स्थानीय उपयोग के लिए लामा और डीपसीक आर1 जैसे लोकप्रिय मॉडल तक पहुंच शामिल है:

LM Studio अपने सहज ग्राफिकल इंटरफेस और बिल्ट-इन मॉडल ब्राउज़र के साथ शुरुआती लोगों के लिए सबसे सुविधाजनक विकल्प के रूप में उत्कृष्ट प्रदर्शन करता है। इसे यहां से डाउनलोड करें। lmstudio.ai और विंडोज 11, मैकओएस वेंचुरा+ और उबंटू 22.04+ पर निर्बाध मॉडल प्रबंधन का आनंद लें।.

GPT4All गोपनीयता को प्राथमिकता देने वाली AI पर केंद्रित है और अपने LocalDocs फीचर के माध्यम से उत्कृष्ट दस्तावेज़ चैट क्षमता प्रदान करता है। सभी प्रमुख ऑपरेटिंग सिस्टमों के लिए gpt4all.io पर उपलब्ध, यह 50 से अधिक संगत मॉडलों के साथ एक क्यूरेटेड मॉडल मार्केटप्लेस प्रदान करता है।.

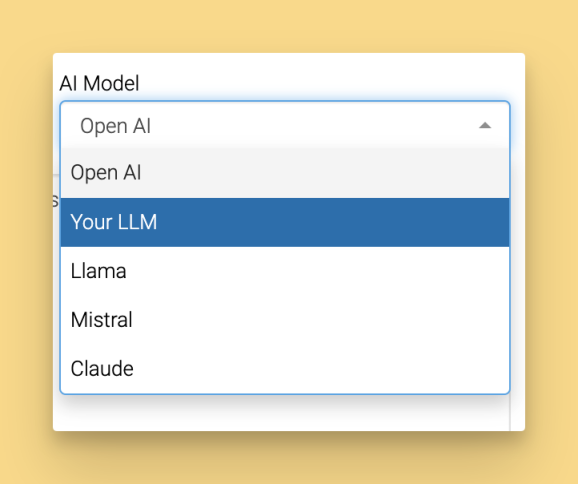

Jan, ChatGPT का एक ओपन सोर्स विकल्प प्रदान करता है जिसमें विस्तार योग्य आर्किटेक्चर और हाइब्रिड लोकल/क्लाउड क्षमताएं हैं। शुरुआत करने के लिए यहां क्लिक करें। jan.ai कस्टम एक्सटेंशन और रिमोट एपीआई एकीकरण के लिए समर्थन के साथ।.

ओलामा डेवलपर्स के लिए पसंदीदा कमांड लाइन टूल है, जो सरल मॉडल प्रबंधन और उत्कृष्ट API एकीकरण प्रदान करता है। ओलामा को इंस्टॉल करना आसान है: अपने ऑपरेटिंग सिस्टम के लिए इंस्टॉलर डाउनलोड करें और चलाएं, फिर सेटअप पूरा करने के लिए निर्देशों का पालन करें। ओलामा इंस्टॉल हो जाने के बाद, आप कमांड लाइन टूल का उपयोग करके मॉडल को प्रबंधित और चला सकते हैं। इसकी एक प्रमुख विशेषता पुल कमांड है, जो आपको टर्मिनल से सीधे विशिष्ट मॉडल डाउनलोड या अपडेट करने और तुरंत उपयोग करने की सुविधा देती है।.

llamafile पोर्टेबल AI को सिंगल-फाइल एक्जीक्यूटेबल के माध्यम से उपलब्ध कराता है, जो बिना इंस्टॉलेशन के कहीं भी चल सकता है। यह त्वरित परीक्षण या तैनाती के उन परिदृश्यों के लिए एकदम सही है जहां न्यूनतम सेटअप महत्वपूर्ण है।.

शुरुआती लोगों के लिए, LM Studio अपने विज़ुअल इंटरफ़ेस और स्वचालित GPU एक्सेलरेशन के साथ सबसे आसान ऑनबोर्डिंग अनुभव प्रदान करता है। डेवलपर्स आमतौर पर Ollama को इसकी लचीलता और मौजूदा विकास वर्कफ़्लो के साथ एकीकरण क्षमताओं के कारण पसंद करते हैं।.

ये उपकरण शुरुआती और उन्नत दोनों प्रकार के उपयोगकर्ताओं के लिए उपयोगकर्ता के अनुकूल अनुभव प्रदान करने के लिए डिज़ाइन किए गए हैं।.

स्थानीय एलएलएम के लिए हार्डवेयर आवश्यकताएँ

हार्डवेयर संबंधी आवश्यकताओं को समझने से आपको अपने सिस्टम के लिए उपयुक्त मॉडल चुनने और प्रदर्शन संबंधी यथार्थवादी अपेक्षाएँ निर्धारित करने में मदद मिलती है। अच्छी बात यह है कि आधुनिक लोकल एलएलएम सामान्य लैपटॉप से लेकर उच्च-स्तरीय वर्कस्टेशन तक, हार्डवेयर कॉन्फ़िगरेशन की एक विस्तृत श्रृंखला पर काम करते हैं।.

छोटे मॉडल चलाने के लिए न्यूनतम स्पेसिफिकेशन में 16GB रैम, इंटेल i5-8400 या AMD रायज़ेन 5 2600 जैसा आधुनिक CPU और कम से कम 50GB उपलब्ध स्टोरेज शामिल हैं। ये स्पेसिफिकेशन अधिकांश उपयोग मामलों के लिए स्वीकार्य प्रदर्शन के साथ 7B पैरामीटर तक के मॉडल को संभाल सकते हैं।.

सर्वोत्तम प्रदर्शन के लिए अनुशंसित स्पेसिफिकेशन में 8GB वीडियो रैम, 32GB सिस्टम रैम और कई मॉडलों के लिए 100GB+ स्टोरेज के साथ NVIDIA RTX 4060 शामिल है। यह कॉन्फ़िगरेशन बड़े मॉडलों के लिए सुचारू इन्फ़रेंस प्रदान करता है और एक साथ कई मॉडल चलाने में सक्षम बनाता है।.

स्टोरेज की आवश्यकता मॉडल के आकार के अनुसार अलग-अलग होती है: Phi-3-mini जैसे छोटे मॉडल के लिए 2-4GB की आवश्यकता होती है, जबकि Llama 3.1 70B जैसे बड़े मॉडल के लिए क्वांटाइजेशन के आधार पर 40-80GB की आवश्यकता होती है। यदि आपके पास सीमित संसाधन हैं, तो स्टोरेज और मेमोरी के उपयोग को कम करने के लिए Gemma 2B Instruct जैसे सबसे छोटे उपलब्ध मॉडल को डाउनलोड करना बेहतर होगा। यदि आप विभिन्न आकारों के कई मॉडलों के साथ प्रयोग करना चाहते हैं, तो 50-100GB स्टोरेज की आवश्यकता होगी।.

यहां विभिन्न हार्डवेयर कॉन्फ़िगरेशन के लिए प्रति सेकंड टोकन की संख्या दर्शाने वाला प्रदर्शन तुलनात्मक चित्र दिया गया है:

हार्डवेयर की समाकृति | फाई-3-मिनी (3बी) | लामा 3.1 8बी | मिस्ट्रल 7बी | कोड लामा 34बी |

|---|---|---|---|---|

केवल सीपीयू (16 जीबी रैम) | 8-12 टोकन/सेकंड | 4-6 टोकन/सेकंड | 3-5 टोकन/सेकंड | सिफारिश नहीं की गई |

आरटीएक्स 4060 (8 जीबी वीआरएएम) | 45-60 टोकन/सेकंड | 25-35 टोकन/सेकंड | 30-40 टोकन/सेकंड | 8-12 टोकन/सेकंड |

आरटीएक्स 4090 (24 जीबी वीआरएएम) | 80-120 टोकन/सेकंड | 60-80 टोकन/सेकंड | 70-90 टोकन/सेकंड | 35-45 टोकन/सेकंड |

एप्पल एम2 प्रो (32 जीबी) | 35-50 टोकन/सेकंड | 20-30 टोकन/सेकंड | 25-35 टोकन/सेकंड | 15-20 टोकन/सेकंड |

GPU एक्सेलरेशन से परफॉर्मेंस में काफी सुधार होता है, लेकिन GPU रिसोर्स उपलब्ध न होने पर छोटे मॉडल्स के लिए CPU-ओनली इन्फरेंस भी कारगर रहता है। सबसे अच्छा परफॉर्मेंस तब मिलता है जब मॉडल का आकार आपके उपलब्ध वीडियो रैम या सिस्टम रैम के अनुसार हो।.

स्थानीय स्तर पर चलाने के लिए सर्वश्रेष्ठ ओपन सोर्स मॉडल

सही मॉडल का चयन आपके हार्डवेयर की क्षमताओं, इच्छित उपयोग के मामलों और गुणवत्ता संबंधी आवश्यकताओं पर निर्भर करता है। ओपन सोर्स मॉडल स्थानीय स्तर पर उपयोग के लिए सुलभ रहते हुए भी गुणवत्ता के प्रभावशाली स्तर तक पहुंच चुके हैं। ओलामा और llama.cpp जैसे ओपन सोर्स एलएलएम प्रोजेक्ट्स का बढ़ता दायरा, समुदाय-संचालित विकास की शक्ति और अग्रणी एआई संगठनों द्वारा जारी किए गए मॉडलों की बढ़ती उपलब्धता को दर्शाता है।.

छोटे मॉडल (8GB से कम) बुनियादी कार्यों के लिए उत्कृष्ट दक्षता प्रदान करते हैं:

- Phi-3-mini (3.8B पैरामीटर) एक कॉम्पैक्ट 2.3GB पैकेज में मजबूत तर्क क्षमता प्रदान करता है, जो सीमित रैम वाले परिदृश्यों के लिए आदर्श है।

- Gemma 2B, Google की प्रशिक्षण गुणवत्ता को एक अत्यंत हल्के 1.4GB मॉडल फ़ाइल में प्रस्तुत करता है।

- Llama 3.2 3B, Meta के नवीनतम आर्किटेक्चर ऑप्टिमाइजेशन के साथ संतुलित प्रदर्शन और दक्षता प्रदान करता है।

मध्यम आकार के मॉडल (8-16GB) क्षमता और संसाधन आवश्यकताओं के बीच सर्वोत्तम संतुलन स्थापित करते हैं:

- लामा 3.1 8B मजबूत तर्क क्षमता और कोड जनरेशन के साथ सामान्य प्रयोजन कार्यों के लिए सर्वश्रेष्ठ मानक के रूप में कार्य करता है।

- मिस्ट्रल 7बी निर्देशों का सटीक पालन करने और जटिल तर्क कार्यों को संभालने में उत्कृष्ट है।

- DeepSeek-Coder 6.7B 80 से अधिक प्रोग्रामिंग भाषाओं के समर्थन के साथ कोड जनरेशन में विशेषज्ञता रखता है।

बड़े मॉडल (16GB+) पर्याप्त हार्डवेयर वाले उपयोगकर्ताओं के लिए अधिकतम क्षमता प्रदान करते हैं:

- Llama 3.1 70B जटिल तर्क और विश्लेषण कार्यों के लिए GPT-4 श्रेणी का प्रदर्शन प्रदान करता है।

- कोड लामा 34बी सॉफ्टवेयर इंजीनियरिंग अवधारणाओं की गहरी समझ के साथ असाधारण कोडिंग सहायता प्रदान करता है।

सभी मॉडल Hugging Face के माध्यम से "microsoft/Phi-3-mini-4k-instruct" या "meta-llama/Meta-Llama-3.1-8B-Instruct" जैसे मॉडल आईडी के साथ उपलब्ध हैं। प्रदर्शन बेंचमार्क दर्शाते हैं कि 8B पैरामीटर मॉडल आमतौर पर अधिकांश उपयोगकर्ताओं के लिए सर्वोत्तम मूल्य प्रदान करते हैं, जो 85-90% की बड़ी मॉडल क्षमता प्रदान करते हैं और साथ ही काफी कम संसाधनों की आवश्यकता होती है।.

एलएम स्टूडियो: शुरुआत करने का सबसे आसान तरीका

एलएम स्टूडियो तकनीकी जटिलता को दूर करते हुए उपयोगकर्ता के अनुकूल ग्राफिकल इंटरफ़ेस प्रदान करके स्थानीय एआई की पहुंच में क्रांतिकारी बदलाव लाता है। एलएम स्टूडियो और इसी तरह के उपकरण ग्राफिकल और वेब-आधारित विकल्पों सहित उपयोगकर्ता इंटरफ़ेस प्रदान करते हैं, जो मॉडल प्रबंधन और इंटरैक्शन को सरल बनाते हैं। एलएम स्टूडियो एक सुविधाजनक इंटरफ़ेस भी प्रदान करता है। वेब यह UI उपयोगकर्ताओं को सीधे अपने ब्राउज़र से मॉडल को प्रबंधित करने और उनके साथ इंटरैक्ट करने की सुविधा देता है। यह उन उपयोगकर्ताओं के लिए आदर्श शुरुआती बिंदु है जो स्थानीय रूप से LLM चलाने में नए हैं।.

सबसे पहले LM Studio को डाउनलोड करें। lmstudio.ai अपने ऑपरेटिंग सिस्टम के लिए सरल इंस्टॉलेशन प्रक्रिया का पालन करें। इंस्टॉलर संगत हार्डवेयर का पता चलने पर GPU एक्सेलरेशन को स्वचालित रूप से कॉन्फ़िगर कर देता है, जिससे मैन्युअल ड्राइवर कॉन्फ़िगरेशन की आवश्यकता समाप्त हो जाती है। इंस्टॉलेशन के बाद, मुख्य इंटरफ़ेस तक पहुँचने और उपलब्ध मॉडलों को एक्सप्लोर करना शुरू करने के लिए LM Studio लॉन्च करें।.

मुख्य इंटरफ़ेस में तीन प्रमुख अनुभाग हैं: उपलब्ध मॉडल ब्राउज़ करने के लिए डिस्कवर, डाउनलोड किए गए मॉडल प्रबंधित करने के लिए माई मॉडल्स और लोड किए गए मॉडल के साथ इंटरैक्ट करने के लिए चैट। डिस्कवर टैब में, अपनी आवश्यकताओं के आधार पर विशिष्ट मॉडल को तुरंत खोजने के लिए सर्च बार का उपयोग करें। बिल्ट-इन मॉडल लाइब्रेरी स्पष्ट विवरण और हार्डवेयर आवश्यकताओं के साथ उच्च-गुणवत्ता वाले ओपन सोर्स मॉडल को संकलित करती है।.

चैट इंटरफ़ेस को सेट अप करने के लिए डाउनलोड किए गए मॉडल को लोड करना और तापमान और संदर्भ अवधि जैसे जनरेशन पैरामीटर को समायोजित करना शामिल है। इंटरफ़ेस में सहज स्लाइडर और प्रत्येक सेटिंग के लिए स्पष्टीकरण दिए गए हैं, जिससे गैर-तकनीकी उपयोगकर्ताओं के लिए प्रयोग करना आसान हो जाता है।.

डेवलपर्स के लिए, LM Studio में एक लोकल API सर्वर शामिल है जो OpenAI के अनुकूल एंडपॉइंट्स उपलब्ध कराता है। OpenAI के API फॉर्मेट को सपोर्ट करने वाले मौजूदा एप्लिकेशन के साथ लोकल मॉडल को इंटीग्रेट करने के लिए सेटिंग्स में इस फीचर को इनेबल करें।.

एलएम स्टूडियो में अपना पहला मॉडल इंस्टॉल करना

डिस्कवर टैब पर जाएं जहां आपको संगत मॉडलों की खोज योग्य लाइब्रेरी मिलेगी। मेटा के कुशल 3B पैरामीटर मॉडल को खोजने के लिए "llama-3.2-3b-instruct" खोजें, जो सामान्य हार्डवेयर पर भी अच्छी तरह से काम करता है।.

डाउनलोड प्रक्रिया शुरू करने के लिए डाउनलोड बटन पर क्लिक करें। LM Studio डाउनलोड गति और अनुमानित पूर्णता समय दर्शाने वाले प्रगति संकेतक प्रदर्शित करता है। डाउनलोड प्रबंधक रुकावटों को सुचारू रूप से संभालता है और नेटवर्क कनेक्टिविटी वापस आने पर आंशिक डाउनलोड को पुनः शुरू करता है।.

डाउनलोड पूरा होने पर, मॉडल आपके 'मेरे मॉडल' सेक्शन में दिखाई देगा। डाउनलोड की गई मॉडल फ़ाइलें आसान पहुँच और लोडिंग के लिए व्यवस्थित और संग्रहीत की जाती हैं। इसे मेमोरी में लोड करने के लिए क्लिक करें, जिसमें आमतौर पर मॉडल के आकार और स्टोरेज स्पीड के आधार पर 10-30 सेकंड लगते हैं। इंटरफ़ेस मेमोरी उपयोग दिखाता है और मॉडल के उपयोग के लिए तैयार होने पर पुष्टि करता है।.

“क्वांटम कंप्यूटिंग को सरल शब्दों में समझाएं” या “फाइबोनाची संख्याओं की गणना करने के लिए एक पायथन फ़ंक्शन लिखें” जैसे उदाहरण प्रश्नों के साथ अपने इंस्टॉलेशन का परीक्षण करें। मॉडल को कुछ ही सेकंड में प्रतिक्रिया देनी चाहिए, जिससे सफल सेटअप की पुष्टि हो जाएगी।.

डाउनलोड विफलताओं के सामान्य निवारण में उपलब्ध डिस्क स्थान की जाँच करना, इंटरनेट कनेक्शन की स्थिरता की पुष्टि करना और यह सुनिश्चित करना शामिल है कि आपका फ़ायरवॉल LM Studio नेटवर्क एक्सेस की अनुमति देता है। अंतर्निहित लॉग समस्याओं के समाधान के लिए विस्तृत त्रुटि जानकारी प्रदान करते हैं।.

GPT4All: गोपनीयता पर केंद्रित स्थानीय एआई

GPT4All गोपनीयता और उपयोग में आसानी पर ज़ोर देता है, जिससे यह डेटा सुरक्षा को प्राथमिकता देने वाले उपयोगकर्ताओं के लिए एक उत्कृष्ट विकल्प बन जाता है। मॉडल डाउनलोड हो जाने के बाद एप्लिकेशन पूरी तरह से ऑफ़लाइन चलता है, जिससे यह सुनिश्चित होता है कि आपकी बातचीत कभी भी आपके डिवाइस से बाहर न जाए।.

gpt4all.io से GPT4All डाउनलोड करें और इसे Windows, macOS या Linux पर इंस्टॉल करें। इंस्टॉलेशन प्रक्रिया के दौरान तुरंत उपयोग के लिए एक स्टार्टर मॉडल अपने आप डाउनलोड हो जाता है। पहली बार खोलने पर चैट, मॉडल और सेटिंग्स के बीच स्पष्ट नेविगेशन के साथ एक साफ-सुथरा इंटरफ़ेस दिखाई देता है। इंस्टॉलेशन के बाद, आप मॉडल्स से विभिन्न कार्यों के लिए टेक्स्ट जनरेट करने के लिए कह सकते हैं, जैसे कि सवालों के जवाब देना या कंटेंट बनाना।.

मॉडल मार्केटप्लेस में 50 से अधिक चयनित मॉडल उपलब्ध हैं, जिनमें विस्तृत विवरण, हार्डवेयर आवश्यकताएँ और उपयोगकर्ता रेटिंग शामिल हैं। मॉडलों को आकार और विशेषता के आधार पर वर्गीकृत किया गया है, जिससे उपयोगकर्ताओं को अपने उपयोग और हार्डवेयर संबंधी सीमाओं के लिए उपयुक्त विकल्प चुनने में मदद मिलती है।.

GPU एक्सेलरेशन सेटअप प्लेटफॉर्म के अनुसार अलग-अलग होता है, लेकिन आमतौर पर इसमें NVIDIA ग्राफिक्स कार्ड के लिए CUDA ड्राइवर इंस्टॉल करना या macOS पर Metal सपोर्ट सुनिश्चित करना शामिल होता है। सेटिंग्स पैनल में स्पष्ट निर्देश दिए गए हैं और यह संगत हार्डवेयर कॉन्फ़िगरेशन का स्वचालित रूप से पता लगा लेता है।.

दस्तावेज़ चैट के लिए LocalDocs को सेट अप करना

लोकलडॉक्स, GPT4All की सबसे खास विशेषता है, जो बाहरी सर्वरों पर सामग्री अपलोड किए बिना आपके निजी दस्तावेज़ों के साथ निजी बातचीत करने की सुविधा प्रदान करती है। यह कार्यक्षमता स्थानीय एलएलएम को शक्तिशाली शोध और विश्लेषण उपकरणों में बदल देती है।.

समर्पित टैब के माध्यम से LocalDocs तक पहुंचें और PDF, टेक्स्ट फ़ाइलें, मार्कडाउन दस्तावेज़ या कोड रिपॉज़िटरी वाले स्थानीय फ़ोल्डर जोड़ें। सिस्टम .pdf, .txt, .md, .docx और सोर्स कोड फ़ाइलों सहित सामान्य फ़ॉर्मेट का समर्थन करता है।.

इंडेक्सिंग प्रक्रिया दस्तावेज़ की सामग्री का विश्लेषण करके खोज योग्य एम्बेडिंग बनाती है, जो आपके डिवाइस पर स्थानीय रूप से संग्रहीत होती है। इंडेक्सिंग का समय दस्तावेज़ की मात्रा पर निर्भर करता है, लेकिन आमतौर पर यह कुछ ही मिनटों में सैकड़ों पृष्ठों को संसाधित कर लेता है। प्रगति संकेतक पूर्णता की स्थिति और अनुमानित शेष समय दिखाते हैं।.

अनुक्रमित दस्तावेज़ों के विरुद्ध उदाहरण के तौर पर कुछ प्रश्न इस प्रकार हो सकते हैं: “मेरे शोध पत्रों के मुख्य निष्कर्षों का सारांश प्रस्तुत करें” या “मेरी परियोजनाओं में सबसे अधिक बार कौन से कोडिंग पैटर्न दिखाई देते हैं?”। सिस्टम प्रतिक्रियाएँ उत्पन्न करने से पहले प्रासंगिक दस्तावेज़ अनुभागों को पुनर्प्राप्त करता है और स्रोत सहित सटीक उत्तर प्रदान करता है। उद्धरण.

गोपनीयता संबंधी लाभों में बाहरी सेवाओं को डेटा ट्रांसमिशन के बिना पूर्णतः ऑफ़लाइन प्रोसेसिंग शामिल है। आपके दस्तावेज़ पूरी प्रक्रिया के दौरान आपके स्थानीय कंप्यूटर पर ही रहते हैं, जिससे LocalDocs गोपनीय व्यावसायिक दस्तावेज़ों या व्यक्तिगत शोध सामग्री के लिए उपयुक्त है।.

जनवरी: ओपन सोर्स चैटजीपीटी विकल्प

Jan खुद को व्यावसायिक AI चैट सेवाओं के एक व्यापक ओपन सोर्स विकल्प के रूप में प्रस्तुत करता है, जो ओपन सोर्स विकास की लचीलता के साथ परिचित इंटरफेस प्रदान करता है। यह प्लेटफॉर्म अधिकतम लचीलेपन के लिए स्थानीय अनुमान और हाइब्रिड क्लाउड एकीकरण दोनों का समर्थन करता है।.

स्थापना से jan.ai इसके लिए पर्याप्त रैम और स्टोरेज स्पेस सहित सिस्टम आवश्यकताओं की जाँच करना आवश्यक है। इंस्टॉलर स्वचालित रूप से हार्डवेयर क्षमताओं का पता लगाता है और आपके विशिष्ट सेटअप के लिए सर्वोत्तम कॉन्फ़िगरेशन सेटिंग्स का सुझाव देता है।.

इंटरफ़ेस टूर से चैटजीपीटी से प्रेरित डिज़ाइन का पता चलता है, जिसमें आधुनिक यूआई तत्व और सहज नेविगेशन शामिल हैं। वार्तालाप इतिहास, मॉडल स्विचिंग और सेटिंग्स तक पहुंच परिचित पैटर्न का अनुसरण करते हैं, जिससे व्यावसायिक सेवाओं से स्विच करने वाले उपयोगकर्ताओं के लिए सीखने की प्रक्रिया आसान हो जाती है।.

मॉडल आयात करने की क्षमता LM Studio या Ollama जैसे अन्य टूल से मॉडल लाने की सुविधा देती है, जिससे अनावश्यक डाउनलोड से बचा जा सकता है। Jan किसी भी संगत बड़े भाषा मॉडल को स्थानीय या हाइब्रिड उपयोग के लिए आयात करने का समर्थन करता है। सिस्टम स्वचालित रूप से संगत मॉडल प्रारूपों का पता लगाता है और इष्टतम प्रदर्शन के लिए आवश्यकतानुसार उन्हें परिवर्तित करता है।.

एक्सटेंशन मार्केटप्लेस समुदाय द्वारा विकसित प्लगइन्स के माध्यम से कार्यक्षमता जोड़ता है, जिसमें उन्नत मॉडल प्रबंधन, विशेष चैट मोड और बाहरी उपकरणों और सेवाओं के साथ एकीकरण जैसे क्षेत्र शामिल हैं।.

रिमोट एपीआई एकीकरण हाइब्रिड परिनियोजन को सक्षम बनाता है, जहां कुछ अनुरोध स्थानीय मॉडल का उपयोग करते हैं जबकि अन्य जटिलता या प्रदर्शन आवश्यकताओं के आधार पर क्लाउड सेवाओं का लाभ उठाते हैं। यह दृष्टिकोण संवेदनशील कार्यों के लिए स्थानीय क्षमताओं को बनाए रखते हुए लागत को अनुकूलित करता है।.

ओलामा: डेवलपर-अनुकूल कमांड लाइन टूल

ओलामा एक उत्कृष्ट कमांड लाइन टूल है जिसे विशेष रूप से उन डेवलपर्स के लिए डिज़ाइन किया गया है जो प्रोग्रामेटिक नियंत्रण और एकीकरण क्षमताओं को प्राथमिकता देते हैं। इसका सरल लेकिन शक्तिशाली इंटरफ़ेस तकनीकी उपयोगकर्ताओं के लिए मॉडल प्रबंधन और परिनियोजन को आसान बनाता है।.

ऑपरेटिंग सिस्टम के अनुसार इंस्टॉलेशन का तरीका अलग-अलग होता है, लेकिन आमतौर पर macOS पर Homebrew (brew install ollama), Ubuntu पर apt (sudo apt install ollama) या Windows पर winget (winget install ollama) जैसे पैकेज मैनेजर का उपयोग किया जाता है। ये तरीके निर्भरता प्रबंधन और सिस्टम एकीकरण को सुनिश्चित करते हैं।.

स्थापना के बाद, उपयोगकर्ता मॉडल डाउनलोड करने, चलाने और प्रबंधित करने के लिए विशिष्ट टर्मिनल कमांड के माध्यम से ओलामा के साथ बातचीत कर सकते हैं, जिससे इसे पूरी तरह से कमांड लाइन से संचालित करना आसान हो जाता है।.

आवश्यक कमांड व्यापक मॉडल जीवनचक्र प्रबंधन प्रदान करते हैं:

- ollama pull llama3.1:8b आधिकारिक लाइब्रेरी से मॉडल डाउनलोड करता है

- ollama run llama3.1:8b निर्दिष्ट मॉडलों के साथ इंटरैक्टिव चैट सत्र शुरू करता है

- ollama list सभी स्थापित मॉडलों को उनके आकार और संशोधन तिथियों के साथ प्रदर्शित करता है।

- ollama rm model-name स्टोरेज स्पेस खाली करने के लिए मॉडल हटाता है

ओलामा को लोकल सर्वर या लोकल इन्फरेंस सर्वर के रूप में कॉन्फ़िगर किया जा सकता है, जिससे आप अन्य एप्लिकेशन के साथ एकीकरण के लिए मॉडल को स्थानीय रूप से होस्ट और सर्व कर सकते हैं। यह सेटअप आसान कस्टमाइज़ेशन, बेहतर प्रदर्शन और निर्बाध समस्या निवारण सहायता प्रदान करता है।.

Modelfile के माध्यम से कस्टम मॉडल बनाने से मॉडल के व्यवहार, सिस्टम प्रॉम्प्ट और पैरामीटर को बेहतर ढंग से समायोजित किया जा सकता है। यह टेक्स्ट-आधारित कॉन्फ़िगरेशन विधि वर्ज़न कंट्रोल और ऑटोमेशन वर्कफ़्लो के साथ अच्छी तरह से एकीकृत होती है।.

विकास उपकरणों के साथ एकीकरण में VS Code जैसे लोकप्रिय IDE के लिए प्लगइन्स शामिल हैं, जो विकास परिवेश के भीतर ही कोड निर्माण और विश्लेषण को सक्षम बनाते हैं। मानकीकृत API प्रारूप मौजूदा अनुप्रयोगों और सेवाओं के साथ एकीकरण को सरल बनाता है।.

ओलामा के साथ कई मॉडल चलाना

ओलामा की वास्तुकला समवर्ती मॉडल निष्पादन का समर्थन करती है, जिससे विभिन्न मॉडल एक साथ विशिष्ट कार्यों को पूरा कर सकते हैं। यह क्षमता परिष्कृत कार्यप्रवाहों को सक्षम बनाती है जहां छोटे मॉडल बुनियादी कार्यों को संभालते हैं जबकि बड़े मॉडल जटिल तर्क प्रक्रियाओं को हल करते हैं।.

अलग-अलग टर्मिनल सत्रों में ollama run mistral:7b और फिर ollama run codellama:7b जैसे सरल कमांड का उपयोग करके मॉडल को स्विच करना होता है। प्रत्येक मॉडल स्वतंत्र वार्तालाप संदर्भ और मेमोरी आवंटन बनाए रखता है।.

मेमोरी प्रबंधन उपलब्ध सिस्टम संसाधनों और मॉडल की आवश्यकताओं के आधार पर संसाधनों का आवंटन स्वचालित रूप से करता है। मेमोरी की कमी से प्रदर्शन प्रभावित होने की आशंका होने पर सिस्टम चेतावनी देता है और अनुकूलन रणनीतियों का सुझाव देता है।.

ओल्लामा सर्व के माध्यम से स्थापित एपीआई सर्वर, ओपनएआई के प्रारूप के अनुरूप HTTP एंडपॉइंट्स के ज़रिए मॉडल उपलब्ध कराता है। इससे क्लाउड एआई सेवाओं के लिए डिज़ाइन किए गए उन अनुप्रयोगों के साथ सहज एकीकरण संभव हो पाता है जो पूरी तरह से स्थानीय बुनियादी ढांचे पर चलते हैं।.

डॉकर डिप्लॉयमेंट, आधिकारिक ओलामा कंटेनरों के माध्यम से प्रोडक्शन एनवायरनमेंट को सुगम बनाता है। कंटेनरीकृत दृष्टिकोण डेवलपमेंट, स्टेजिंग और प्रोडक्शन एनवायरनमेंट में एकरूपता सुनिश्चित करता है, साथ ही डिपेंडेंसी मैनेजमेंट को सरल बनाता है।.

उन्नत उपकरण: llama.cpp और llamafile

अधिकतम नियंत्रण और बेहतर प्रदर्शन चाहने वाले उन्नत उपयोगकर्ता llama.cpp और llamafile जैसे निम्न-स्तरीय उपकरणों से लाभान्वित होते हैं। llama.cpp के साथ मॉडल चलाने के लिए, उपयोगकर्ताओं को एक gguf मॉडल फ़ाइल डाउनलोड करनी होगी, जो स्थानीय परिनियोजन के लिए आवश्यक प्रारूप है। ये उपकरण सुविधा के बदले लचीलापन और दक्षता को प्राथमिकता देते हैं, जिससे ये उत्पादन परिनियोजन और विशेष आवश्यकताओं के लिए आदर्श बन जाते हैं।.

उपयोगकर्ता-अनुकूल अनुप्रयोगों और उन्नत उपकरणों के बीच चुनाव विशिष्ट आवश्यकताओं पर निर्भर करता है। कस्टम संकलन विकल्पों, विशेष हार्डवेयर समर्थन, या बड़े सिस्टम में एकीकरण की आवश्यकता होने पर उन्नत उपकरणों का चुनाव करें, जहाँ अनुमान इंजन पर पूर्ण नियंत्रण आवश्यक हो। उपयोगकर्ता विशिष्ट कार्यों या क्षेत्रों के लिए परिष्कृत मॉडल भी चला सकते हैं, जिससे उनकी आवश्यकताओं के अनुरूप इष्टतम प्रदर्शन प्राप्त होता है।.

GPU सपोर्ट के साथ llama.cpp को कंपाइल करने के लिए विशिष्ट हार्डवेयर लक्ष्यों के लिए बिल्ड सिस्टम को कॉन्फ़िगर करना आवश्यक है। CUDA सपोर्ट के लिए NVIDIA ड्राइवर और टूलकिट इंस्टॉलेशन की आवश्यकता होती है, Apple Silicon के साथ macOS पर Metal सपोर्ट स्वचालित रूप से काम करता है, और OpenCL विभिन्न विक्रेताओं के GPU के साथ व्यापक संगतता प्रदान करता है।.

उन्नत उपकरणों के माध्यम से प्रदर्शन अनुकूलन में कस्टम क्वांटाइजेशन स्कीम, मेमोरी मैपिंग अनुकूलन और विशेषीकृत अटेंशन कार्यान्वयन शामिल हैं। ये अनुकूलन सामान्य-उद्देश्यीय समाधानों की तुलना में अनुमान गति में उल्लेखनीय सुधार कर सकते हैं और मेमोरी आवश्यकताओं को कम कर सकते हैं।.

लामाफाइल एक्जीक्यूटेबल फाइलें मॉडल और इन्फरेंस इंजन को एक ही फाइल में पैक करके पोर्टेबल एआई डिप्लॉयमेंट की सुविधा प्रदान करती हैं, जो बिना इंस्टॉलेशन के चलती हैं। यह तरीका उन डिप्लॉयमेंट परिदृश्यों को सरल बनाता है जहां पारंपरिक इंस्टॉलेशन प्रक्रियाएं संभव या वांछनीय नहीं होती हैं।.

उन्नत उपकरणों के माध्यम से उपलब्ध मॉडल क्वांटाइजेशन तकनीकों में 4-बिट, 8-बिट और मिश्रित परिशुद्धता प्रारूप शामिल हैं जो प्रदर्शन को बनाए रखते हुए मॉडल का आकार कम करते हैं। उपयोगकर्ता अपने विशिष्ट उपयोग मामलों के लिए इष्टतम संतुलन खोजने के लिए विभिन्न क्वांटाइजेशन योजनाओं के साथ प्रयोग कर सकते हैं।.

स्थानीय एपीआई सर्वर बनाना

एक स्थानीय API सर्वर आपके LLM मॉडल के लिए सर्वोत्तम एकीकरण समाधान प्रदान करता है, जो आपके डेटा और बुनियादी ढांचे पर पूर्ण नियंत्रण बनाए रखते हुए अन्य अनुप्रयोगों के साथ निर्बाध कनेक्टिविटी सुनिश्चित करता है। LM Studio और Ollama दोनों ही शक्तिशाली और सरल परिनियोजन विकल्प प्रदान करते हैं, जो उद्यम-स्तरीय क्षमताओं को सीधे आपके हाथों में लाते हैं, चाहे आप सहज ग्राफिकल इंटरफेस पसंद करें या कमांड लाइन की सटीकता।.

शुरुआत करने के लिए, अपनी पसंदीदा परिनियोजन रणनीति (LM Studio या Ollama) चुनें और इसे अपने सिस्टम पर इंस्टॉल करें। एक बार इंस्टॉल हो जाने के बाद, आप LLM मॉडल डाउनलोड करेंगे जो आपके हार्डवेयर की क्षमताओं और व्यावसायिक आवश्यकताओं से पूरी तरह मेल खाता हो, जिससे संसाधनों का अधिकतम उपयोग सुनिश्चित हो सके। महत्वपूर्ण प्रदर्शन मापदंडों जैसे कि कॉन्टेक्स्ट लेंथ को कॉन्फ़िगर करें और जब आपका सिस्टम GPU एक्सेलरेशन क्षमताओं का समर्थन करता हो, तो उन्हें अनलॉक करें, जिससे आपके एप्लिकेशन को उच्च-प्रदर्शन परिणाम प्राप्त होंगे।.

अपने स्थानीय API सर्वर को लॉन्च करना बेहद आसान है: LM Studio एक सहज सेटिंग इंटरफ़ेस के माध्यम से सर्वर सक्रियण प्रदान करता है, जबकि Ollama अधिकतम परिचालन लचीलेपन के लिए टर्मिनल-आधारित नियंत्रण प्रदान करता है। आपका API सर्वर एक समर्पित पोर्ट पर संचालित होता है, जो आपके अनुप्रयोगों से अनुरोधों को संसाधित करने और उद्यम-स्तरीय विश्वसनीयता और गति के साथ उत्पन्न टेक्स्ट प्रतिक्रियाएँ देने के लिए तैयार है।.

आपके स्थानीय API सर्वर के चालू होने से आपको कस्टम चैटबॉट बनाने, जटिल वर्कफ़्लो को स्वचालित करने और उन्नत भाषा क्षमताओं को सीधे अपने सॉफ़्टवेयर इकोसिस्टम में एकीकृत करने की स्वतंत्रता मिलती है, साथ ही डेटा की पूर्ण सुरक्षा सुनिश्चित होती है और आपका LLM मॉडल पूरी तरह से आपके नियंत्रित वातावरण में संचालित होता है। यह केवल एक तकनीकी सेटअप से कहीं अधिक है; यह स्केलेबल, सुरक्षित और परिष्कृत भाषा प्रसंस्करण क्षमताओं का आपका प्रवेश द्वार है।.

एपीआई कुंजी के साथ अपने स्थानीय एलएलएम को सुरक्षित करना

आपके स्थानीय एलएलएम तक पहुंच को सुरक्षित करना न केवल आवश्यक है, बल्कि यह वह आधार है जो आपके एआई परिनियोजन को संभावित भेद्यता से नियंत्रित नवाचार के किले में बदल देता है। जब आप कई एप्लिकेशन या उपयोगकर्ताओं को कनेक्ट कर रहे होते हैं, तो एपीआई कुंजी प्रणाली को लागू करना आपकी निर्णायक रणनीति बन जाती है, यह सुनिश्चित करते हुए कि केवल अधिकृत अनुरोध ही आपके मॉडल की शक्ति को अनलॉक कर सकें और अनधिकृत पहुंच को रोक सकें।.

अपने स्थानीय एलएलएम की क्षमताओं का उपयोग करने वाले प्रत्येक एप्लिकेशन या उपयोगकर्ता के लिए अद्वितीय एपीआई कुंजी बनाकर अपनी सुरक्षा रणनीति में बदलाव लाएं। इन डिजिटल कुंजियों को पर्यावरण चर या एन्क्रिप्टेड कॉन्फ़िगरेशन फ़ाइलों में सुरक्षित रखें, ताकि किसी भी आकस्मिक खुलासे से बचा जा सके जो आपके प्रतिस्पर्धी लाभ को खतरे में डाल सकता है। अपने स्थानीय एपीआई सर्वर को प्रत्येक अनुरोध पर एपीआई कुंजी सत्यापन की मांग करने के लिए कॉन्फ़िगर करें, जिससे एक अभेद्य अवरोध उत्पन्न हो जो अनधिकृत पहुंच के प्रयासों को आपके दरवाजे पर दस्तक देने से पहले ही रोक दे।.

अपनी सुरक्षा रणनीति को और मज़बूत बनाने के लिए, API कुंजी को नियमित रूप से बदलते रहें ताकि किसी भी संभावित सुरक्षा उल्लंघन का जोखिम कम हो सके, और उन कुंजियों को निरस्त करने के लिए निर्णायक कार्रवाई करें जिनकी अब आवश्यकता नहीं है या जिनके साथ छेड़छाड़ की गई हो सकती है। उद्योग में अग्रणी इन प्रथाओं को अपनाकर, आप न केवल नियंत्रण बनाए रखते हैं, बल्कि अपने स्थानीय LLM पर पूर्ण प्रभुत्व स्थापित करते हैं, जिससे आपके मूल्यवान मॉडल और इसके द्वारा संसाधित किए जाने वाले प्रत्येक संवेदनशील डेटा की अचूक सुरक्षा सुनिश्चित होती है।.

व्यावहारिक अनुप्रयोग और उपयोग के मामले

स्थानीय रूप से एलएलएम चलाने से पेशेवर और व्यक्तिगत संदर्भों में कई व्यावहारिक अनुप्रयोग संभव हो पाते हैं। गोपनीयता, असीमित उपयोग और ऑफ़लाइन क्षमताओं का संयोजन ऐसी संभावनाएं खोलता है जो क्लाउड सेवाएं प्रदान नहीं कर सकतीं।.

कोड जनरेशन और डिबगिंग स्थानीय कृत्रिम बुद्धिमत्ता के प्राथमिक उपयोग के उदाहरण हैं। डीपसीक-कोडर और कोड लामा जैसे मॉडल प्रोग्रामिंग संदर्भों को समझने, बॉयलरप्लेट कोड उत्पन्न करने, जटिल एल्गोरिदम को समझाने और 80 से अधिक प्रोग्रामिंग भाषाओं में बग फिक्स सुझाने में उत्कृष्ट हैं।.

स्थानीय मॉडलों की असीमित उत्पादन क्षमताओं से सामग्री निर्माण वर्कफ़्लो को लाभ मिलता है। ब्लॉग पोस्ट, ईमेल, विपणन बिना API लागत या दर सीमा के, कॉपी और सोशल मीडिया सामग्री को बार-बार तैयार किया जा सकता है। विशिष्ट लेखन शैलियों पर स्थानीय मॉडलों को बेहतर बनाने की क्षमता इसमें योगदान देती है। वैयक्तिकरण क्लाउड सेवाओं के साथ यह असंभव है।.

डेटा विश्लेषण और सारांशीकरण कार्यों में स्थानीय मॉडलों की संवेदनशील जानकारी को बाहरी प्रसारण के बिना संसाधित करने की क्षमता का लाभ उठाया जाता है। वित्तीय रिपोर्ट, कानूनी दस्तावेज, चिकित्सा रिकॉर्ड और गोपनीय शोध का विश्लेषण पूर्ण गोपनीयता बनाए रखते हुए किया जा सकता है।.

बाहरी सेवाओं के बिना भाषा अनुवाद संवेदनशील संचार की गोपनीयता सुनिश्चित करता है, साथ ही दर्जनों भाषा जोड़ियों को सपोर्ट करता है। स्थानीय मॉडल तकनीकी दस्तावेज़ अनुवाद, बहुभाषी ग्राहक सहायता और अंतर्राष्ट्रीय व्यावसायिक संचार को पूरी तरह से ऑफ़लाइन संभालते हैं।.

वास्तविक दुनिया के उदाहरणों में दस्तावेज़ विश्लेषण के लिए स्थानीय मॉडल का उपयोग करने वाली कानूनी कंपनियाँ, AI-संचालित कोडिंग सहायकों को लागू करने वाली सॉफ़्टवेयर कंपनियाँ और व्यक्तिगत लेखन उपकरण विकसित करने वाले कंटेंट क्रिएटर शामिल हैं। इनमें से प्रत्येक समाधान उपयोगकर्ता के हार्डवेयर पर स्थानीय रूप से चलता है, जिससे गोपनीयता और नियंत्रण सुनिश्चित होता है। ये अनुप्रयोग स्थानीय AI परिनियोजन की बहुमुखी प्रतिभा और व्यावहारिक मूल्य को प्रदर्शित करते हैं।.

प्रदर्शन अनुकूलन और समस्या निवारण

स्थानीय एलएलएम से अधिकतम प्रदर्शन प्राप्त करने के लिए सिस्टम संसाधनों, मॉडल विशेषताओं और अनुकूलन तकनीकों को समझना आवश्यक है। उचित कॉन्फ़िगरेशन से प्रतिक्रिया समय में काफी सुधार हो सकता है और सामान्य हार्डवेयर पर भी बड़े मॉडल को संचालित करना संभव हो सकता है।.

GPU एक्सेलरेशन सेटअप अलग-अलग वेंडर के हिसाब से भिन्न होता है, लेकिन आमतौर पर इसमें उपयुक्त ड्राइवर इंस्टॉल करना और उपलब्ध हार्डवेयर को पहचानने के लिए सॉफ़्टवेयर को कॉन्फ़िगर करना शामिल होता है। NVIDIA उपयोगकर्ताओं को CUDA टूलकिट इंस्टॉल करने की आवश्यकता होती है, जबकि AMD उपयोगकर्ताओं को समर्थित Linux डिस्ट्रीब्यूशन पर ROCm सेटअप की आवश्यकता होती है।.

मॉडल क्वांटाइजेशन, मॉडल पैरामीटर को कम परिशुद्धता स्तरों पर संग्रहीत करके मेमोरी की आवश्यकता को कम करता है। 4-बिट क्वांटाइजेशन आमतौर पर 95%+ गुणवत्ता बनाए रखते हुए मॉडल के आकार को 75% तक कम कर देता है, जिससे सीमित वीडियो रैम वाले उपभोक्ता हार्डवेयर पर बड़े मॉडल सुलभ हो जाते हैं।.

सामान्य त्रुटि संदेश और उनके समाधान इस प्रकार हैं:

- “CUDA मेमोरी से बाहर”: मॉडल का आकार कम करें, अन्य एप्लिकेशन बंद करें, या CPU ऑफ़लोडिंग सक्षम करें

- “मॉडल लोड करने में विफल”: मॉडल फ़ाइल की अखंडता और पर्याप्त डिस्क स्थान की जाँच करें

- “धीमी इन्फ़रेंस गति”: GPU एक्सेलरेशन सेटिंग्स की जाँच करें और मॉडल क्वांटिज़ेशन पर विचार करें

इन्फ़रेंस के दौरान रिसोर्स मॉनिटरिंग से बॉटलनेक की पहचान करने और कॉन्फ़िगरेशन को ऑप्टिमाइज़ करने में मदद मिलती है। विंडोज़ पर टास्क मैनेजर, macOS पर एक्टिविटी मॉनिटर या लिनक्स पर htop मॉडल निष्पादन के दौरान CPU उपयोग, मेमोरी उपयोग और GPU गतिविधि पैटर्न को प्रकट करते हैं।.

तापमान और सैंपलिंग पैरामीटर समायोजन आउटपुट की गुणवत्ता और गति को प्रभावित करते हैं। कम तापमान अधिक सुसंगत आउटपुट उत्पन्न करते हैं, जबकि उच्च मान रचनात्मकता को बढ़ाते हैं। टॉप-के और टॉप-पी सैंपलिंग पैरामीटर प्रतिक्रिया विविधता और सुसंगतता के बीच संतुलन बनाते हैं।.

कॉन्टेक्स्ट की लंबाई का अनुकूलन मेमोरी के उपयोग और बातचीत की क्षमता के बीच संतुलन बनाता है। लंबे कॉन्टेक्स्ट अधिक परिष्कृत बातचीत को सक्षम बनाते हैं, लेकिन इसके लिए आनुपातिक रूप से अधिक मेमोरी की आवश्यकता होती है। अधिकांश उपयोग के मामलों में 2048-4096 टोकन वाले कॉन्टेक्स्ट अच्छी तरह से काम करते हैं।.

स्थानीय एलएलएम सेटअप के लिए सर्वोत्तम अभ्यास

अपने स्थानीय एलएलएम से अधिकतम लाभ प्राप्त करने के लिए, आपको एक ऐसी कारगर रणनीति की आवश्यकता है जो उत्कृष्ट प्रदर्शन और अचूक सुरक्षा दोनों प्रदान करे। अपनी विशिष्ट आवश्यकताओं के लिए उपयुक्त मॉडल का चयन करके शुरुआत करें, मॉडल के मापदंडों, आकार विनिर्देशों और लक्षित अनुप्रयोगों का गहन अध्ययन करें ताकि आप अपने हार्डवेयर की क्षमताओं और विशिष्ट उपयोग की आवश्यकताओं के लिए आदर्श विकल्प खोज सकें।.

गेम में ज़बरदस्त परफॉर्मेंस पाने के लिए कॉन्टेक्स्ट लेंथ जैसे महत्वपूर्ण मॉडल पैरामीटर को फाइन-ट्यून करके और जहां भी संभव हो GPU एक्सेलरेशन को एक्टिवेट करके अपने सेटअप को और भी बेहतर बनाएं। यह सुनिश्चित करें कि आपका ऑपरेटिंग सिस्टम आपके चुने हुए टूल्स और LLM मॉडल के साथ पूरी तरह से कम्पैटिबल हो, साथ ही अपने पूरे सिस्टम और सॉफ्टवेयर स्टैक को अपडेट रखें ताकि आप नवीनतम सुविधाओं और अत्याधुनिक सुरक्षा सुधारों का लाभ उठा सकें।.

अपने सिस्टम संसाधनों की सक्रिय रूप से निगरानी करके, RAM और GPU के उपयोग को ट्रैक करके प्रदर्शन संबंधी बाधाओं से बचें, खासकर बड़े मॉडल तैनात करते समय या एक साथ कई मॉडल चलाते समय। LM Studio या GPT4All जैसे सहज ग्राफिकल इंटरफेस के साथ अपने वर्कफ़्लो को बदलें, जिससे मॉडल प्रबंधन और सेटिंग्स अनुकूलन बेहद सरल हो जाता है।.

सबसे महत्वपूर्ण चीज़ों की सुरक्षा करें, संवेदनशील डेटा को हमेशा अपने स्थानीय परिवेश में ही सुरक्षित रखें और गोपनीय जानकारी को इंटरनेट चैनलों के माध्यम से प्रसारित करने का जोखिम कभी न लें। विभिन्न मॉडलों का लगातार परीक्षण और मूल्यांकन करें ताकि यह सुनिश्चित हो सके कि आप अपने विशिष्ट अनुप्रयोग के लिए सर्वोत्तम समाधान का लाभ उठा रहे हैं, और अपनी आवश्यकताओं के बढ़ने और विकसित होने के साथ-साथ नए मॉडलों को अपनाने या उनमें सुधार करने की सुविधा का लाभ उठाएं।.

इन सिद्ध सर्वोत्तम प्रथाओं को लागू करके, आप एक सुरक्षित, अत्यंत तीव्र और सटीक रूप से कैलिब्रेटेड स्थानीय एलएलएम वातावरण बनाएंगे जो आपकी विशिष्ट आवश्यकताओं से कहीं अधिक उत्कृष्ट परिणाम प्रदान करेगा और असाधारण परिणाम सुनिश्चित करेगा।.

लागत विश्लेषण: स्थानीय बनाम क्लाउड एआई सेवाएं

स्थानीय और क्लाउड एआई सेवाओं की आर्थिक स्थिति को समझना बुनियादी ढांचे में निवेश के बारे में सोच-समझकर निर्णय लेने में सहायक होता है। इस विश्लेषण में हार्डवेयर की प्रारंभिक लागत, निरंतर होने वाले खर्च और उपयोग के पैटर्न के आधार पर लाभ-हानि की गणना शामिल है।.

सक्षम स्थानीय एआई सिस्टम के लिए प्रारंभिक हार्डवेयर निवेश मध्य-श्रेणी के कॉन्फ़िगरेशन के लिए $800-1,500 से लेकर उच्च-स्तरीय सेटअप के लिए $3,000-5,000 तक होता है। इन लागतों में आधुनिक सीपीयू, पर्याप्त रैम, सक्षम जीपीयू और कई मॉडलों के लिए पर्याप्त स्टोरेज शामिल हैं।.

क्लाउड एआई सेवाओं की मासिक सदस्यता लागत में काफी भिन्नता पाई जाती है: चैटजीपीटी प्लस की कीमत $20/माह है, क्लाउड प्रो की कीमत $20/माह है, और एपीआई उपयोग की लागत मात्रा के आधार पर $10 से 500+ मासिक तक हो सकती है। एंटरप्राइज़ प्लान की लागत अक्सर $100/माह प्रति उपयोगकर्ता से अधिक होती है।.

ब्रेक-ईवन विश्लेषण से पता चलता है कि मध्यम से भारी उपयोग करने वाले उपयोगकर्ता आमतौर पर 6-18 महीनों के भीतर हार्डवेयर निवेश की वसूली कर लेते हैं। संवेदनशील डेटा संसाधित करने वाले या 24/7 उपलब्धता की आवश्यकता वाले उपयोगकर्ता अक्सर लागत संबंधी विचारों की परवाह किए बिना स्थानीय बुनियादी ढांचे को उचित ठहराते हैं।.

स्थानीय मॉडलों को लगातार चलाने की ऊर्जा लागत से बिजली बिल में प्रति माह लगभग 1.430-100 पाउंड की वृद्धि होती है, जो हार्डवेयर की दक्षता और स्थानीय बिजली दरों पर निर्भर करती है। आधुनिक जीपीयू में बिजली प्रबंधन सुविधाएँ शामिल होती हैं जो निष्क्रिय अवधि के दौरान खपत को कम करती हैं।.

दो-तीन वर्षों में स्वामित्व की कुल लागत की गणना करते समय आम तौर पर स्थानीय समाधानों को प्राथमिकता दी जाती है:

- मध्यम से लेकर उच्च स्तर के एआई उपयोग पैटर्न वाले उपयोगकर्ता

- डेटा गोपनीयता अनुपालन की आवश्यकता वाले संगठन

- जिन आवेदनों के लिए उपलब्धता की गारंटी आवश्यक है

- असीमित प्रयोग क्षमता चाहने वाली टीमें

क्लाउड सेवाएं इन लोगों के लिए किफायती बनी हुई हैं:

- कभी-कभार उपयोग करने वाले उपयोगकर्ता जिनका मासिक उपयोग न्यूनतम होता है

- अत्याधुनिक मॉडल तक पहुंच की आवश्यकता वाली टीमें

- आईटी बुनियादी ढांचे की विशेषज्ञता के बिना संगठन

- ऐसे अनुप्रयोग जिन्हें निर्बाध स्केलिंग क्षमताओं की आवश्यकता होती है

इस निर्णय में अक्सर गैर-वित्तीय कारक शामिल होते हैं, जिनमें गोपनीयता संबंधी आवश्यकताएं भी शामिल हैं।, डेटा संप्रभुता, इंटरनेट कनेक्टिविटी की विश्वसनीयता और संगठनात्मक नियंत्रण संबंधी प्राथमिकताएं, उच्च प्रारंभिक लागत के बावजूद स्थानीय तैनाती की ओर झुकाव पैदा करती हैं।.

स्थानीय बड़े भाषा मॉडल, लोकतांत्रिक, निजी और लागत-प्रभावी एआई तैनाती की दिशा में एक मौलिक बदलाव का प्रतिनिधित्व करते हैं। जैसे-जैसे मॉडल अधिक कुशल होते जाते हैं और उपकरण अधिक उपयोगकर्ता-अनुकूल होते जाते हैं, प्रवेश की बाधा कम होती जाती है जबकि क्षमताएं तेजी से बढ़ती जाती हैं।.

चाहे आप कोडिंग में सहायता चाहने वाले डेवलपर हों, संवेदनशील डेटा की सुरक्षा करने वाला व्यवसाय हों, या एआई की संभावनाओं को तलाशने वाले उत्साही हों, स्थानीय रूप से एलएलएम चलाने से आपको अपने एआई अनुभव पर अभूतपूर्व नियंत्रण मिलता है। एलएम स्टूडियो या जीपीटी4ऑल जैसे उपयोगकर्ता-अनुकूल टूल से शुरुआत करें, क्षमता और प्रदर्शन के आदर्श संतुलन को खोजने के लिए विभिन्न मॉडलों के साथ प्रयोग करें, और जैसे-जैसे आपकी ज़रूरतें विकसित हों, धीरे-धीरे अपने सेटअप का विस्तार करें।.

कृत्रिम बुद्धिमत्ता का भविष्य केवल विशाल डेटा केंद्रों तक ही सीमित नहीं है, बल्कि आपके अपने हार्डवेयर पर, आपके पूर्ण नियंत्रण में है। आज ही अपना पहला स्थानीय मॉडल डाउनलोड करें और स्वयं-होस्टेड कृत्रिम बुद्धिमत्ता की स्वतंत्रता का अनुभव करें।.

स्थानीय एआई का परिचय

लोकल एआई (लोकल एआई) व्यक्तियों और संगठनों द्वारा कृत्रिम बुद्धिमत्ता के उपयोग के तरीके में क्रांतिकारी बदलाव ला रहा है, क्योंकि यह बड़े भाषा मॉडलों की पूरी क्षमता को सीधे आपके कंप्यूटर पर लाता है। क्लाउड-आधारित सेवाओं पर निर्भर रहने के बजाय, स्थानीय रूप से एलएलएम (लॉन्ग-लॉन्ग इंटेलिजेंस) चलाने का मतलब है कि सभी प्रोसेसिंग आपके डिवाइस पर होती है, जिससे आपको मॉडल पैरामीटर और आपके संवेदनशील डेटा को संभालने के तरीके पर पूरा नियंत्रण मिलता है। यह दृष्टिकोण न केवल गोपनीयता बढ़ाता है - क्योंकि आपका डेटा कभी भी आपके कंप्यूटर से बाहर नहीं जाता - बल्कि विलंबता को भी कम करता है, जिससे प्रतिक्रियाएं पहले से कहीं अधिक तेज़ और विश्वसनीय हो जाती हैं।.

स्थानीय एआई की मदद से, आप बड़े भाषा मॉडलों को अपनी विशिष्ट आवश्यकताओं के अनुरूप बेहतर बना सकते हैं, चाहे आप विशिष्ट कार्यों के लिए अनुकूलन कर रहे हों या विभिन्न कॉन्फ़िगरेशन के साथ प्रयोग कर रहे हों। स्थानीय रूप से एलएलएम चलाने से आपको मॉडल को अनुकूलित करने, अपडेट प्रबंधित करने और अपने वर्कफ़्लो के लिए पूरी तरह से तैयार किए गए समाधानों को तैनात करने की सुविधा मिलती है, साथ ही आपकी जानकारी पूरी तरह से सुरक्षित रहती है। जैसे-जैसे अधिक उपयोगकर्ता स्थानीय परिनियोजन के क्रांतिकारी मूल्य को समझ रहे हैं, उपकरणों और मॉडलों का पारिस्थितिकी तंत्र तेजी से विस्तार कर रहा है, जिससे अत्याधुनिक बड़े भाषा मॉडल (एलएलएम) की क्षमताओं का उपयोग सीधे अपने कंप्यूटर पर करना पहले से कहीं अधिक आसान हो गया है।.

स्थानीय एलएलएम के साथ शुरुआत करना

अब आपके लिए स्थानीय LLM (लाइसेंस्ड लायन मैनेजमेंट प्रोग्राम) की शुरुआत करना बेहद आसान हो गया है—गेम-चेंजिंग टूल्स और शक्तिशाली मॉडल्स के बढ़ते इकोसिस्टम की बदौलत। LM Studio या Ollama जैसे प्लेटफॉर्म चुनकर शुरुआत करें, ये दोनों ही प्लेटफॉर्म आपकी मशीन पर सीधे LLM चलाने की प्रक्रिया को सरल और सुव्यवस्थित बनाने के लिए डिज़ाइन किए गए हैं। ये समाधान आपकी पसंद के अनुसार उपयोगकर्ता-अनुकूल अनुभव प्रदान करते हैं—LM Studio अपने सहज ग्राफिकल इंटरफ़ेस के साथ और Ollama अपने कुशल कमांड लाइन दृष्टिकोण के साथ—ताकि आप अपनी तकनीकी दक्षता के अनुरूप कार्यप्रवाह चुन सकें।.

अपना पसंदीदा प्लेटफ़ॉर्म इंस्टॉल करने के बाद, Hugging Face जैसे विश्वसनीय रिपॉज़िटरी से उपलब्ध मॉडलों को आसानी से ब्राउज़ करने के लिए एकीकृत खोज सुविधा का लाभ उठाएँ। अपनी चुनी हुई मॉडल फ़ाइल को सीधे अपने स्थानीय सेटअप पर डाउनलोड करें, जिसमें हार्डवेयर संगतता की गारंटी पहले से ही मौजूद है। एक बार कॉन्फ़िगर हो जाने के बाद, आप स्थानीय इन्फ़रेंस सर्वर को सक्रिय कर सकते हैं, जिससे आप ग्राफ़िकल इंटरफ़ेस या कमांड लाइन संचालन के माध्यम से अपने मॉडल के साथ इंटरैक्ट कर सकते हैं। यह शक्तिशाली सेटअप आपको कई मॉडलों के साथ प्रयोग करने, अपने स्थानीय LLM इकोसिस्टम को कुशलतापूर्वक प्रबंधित करने और बाहरी क्लाउड इंफ्रास्ट्रक्चर पर निर्भरता के बिना स्थानीय प्रोसेसिंग के सभी लाभों का आनंद लेने की सुविधा प्रदान करता है।.

स्थानीय अनुमान सर्वर स्थापित करना

लोकल इन्फरेंस सर्वर, लोकल एलएलएम चलाने का एक महत्वपूर्ण आधार है, जो आपको अपने चुने हुए मॉडलों को बेहद कुशल और सुरक्षित वातावरण में तैनात करने, प्रबंधित करने और उनके साथ इंटरैक्ट करने की सुविधा देता है। एलएम स्टूडियो और ओलामा जैसे क्रांतिकारी टूल लोकल इन्फरेंस सर्वर सेटअप को बेहद सरल बनाते हैं—यहां तक कि एआई में बिल्कुल नए उपयोगकर्ता भी शानदार परिणाम प्राप्त कर सकते हैं। इस क्षमता का पूरा लाभ उठाने के लिए, बस अपनी इच्छित मॉडल फ़ाइल चुनें और कॉन्टेक्स्ट लेंथ जैसे आवश्यक पैरामीटर कॉन्फ़िगर करें, और उपलब्ध होने पर, ज़बरदस्त परफॉर्मेंस लाभ के लिए जीपीयू एक्सेलरेशन को सक्षम करें।.

ओलामा जीपीयू एक्सेलरेशन जैसी उन्नत सुविधाएँ प्रदान करता है, जो संगत हार्डवेयर पर मॉडल इन्फरेंस को काफी तेज कर सकता है और आपके वर्कफ़्लो को पूरी तरह से बदल सकता है। आप अपने इन्फरेंस सर्वर के लिए सटीक पोर्ट निर्दिष्ट करके पूर्ण नियंत्रण प्राप्त करते हैं, जिससे यह वेब यूआई के माध्यम से आसानी से सुलभ हो जाता है या अधिकतम लचीलेपन के लिए अन्य अनुप्रयोगों के साथ सहजता से एकीकृत हो जाता है। एलएम स्टूडियो भी उतना ही सरल सेटअप प्रदान करता है, जिससे आप एक सहज, उपयोगकर्ता-अनुकूल इंटरफ़ेस के माध्यम से मॉडल और सर्वर सेटिंग्स को प्रबंधित कर सकते हैं। आपके स्थानीय इन्फरेंस सर्वर के चालू होने के साथ, आपके पास स्थानीय रूप से एलएलएम चलाने और अपने चुने हुए मॉडलों की पूर्ण, अप्रतिबंधित क्षमताओं का लाभ उठाने के लिए एक शक्तिशाली, पूरी तरह से निजी वातावरण होगा।.

लोकप्रिय उपकरणों का उपयोग करके स्थानीय स्तर पर एलएलएम चलाना

स्थानीय रूप से एलएलएम चलाते समय एक सहज अनुभव प्राप्त करने के लिए सही टूल का चयन करना महत्वपूर्ण है। एलएम स्टूडियो, ओलामा और जीपीटी4ऑल सबसे भरोसेमंद समाधानों में से हैं, जिनमें से प्रत्येक आपकी विशिष्ट कार्यप्रवाह आवश्यकताओं के अनुरूप अद्वितीय क्षमताएं प्रदान करता है। एलएम स्टूडियो अपने सहज ग्राफिकल इंटरफ़ेस के साथ आपको सशक्त बनाता है, जिससे आप कई मॉडलों को आसानी से प्रबंधित कर सकते हैं, उनके बीच आसानी से स्विच कर सकते हैं और अपनी परियोजनाओं के लिए आवश्यक सर्वोत्तम परिणाम प्राप्त करने के लिए सेटिंग्स को ठीक कर सकते हैं। टर्मिनल वातावरण में काम करने वालों के लिए, ओलामा एक सशक्त कमांड लाइन अनुभव प्रदान करता है जो आपके उन्नत कार्यप्रवाहों का समर्थन करता है और आपके विकास पारिस्थितिकी तंत्र के साथ सहजता से एकीकृत होता है।.

GPT4All आपके टूलकिट में एक और शक्तिशाली विकल्प प्रस्तुत करता है, जो Mistral 7B जैसे लोकप्रिय विकल्पों सहित मॉडलों की एक विस्तृत श्रृंखला का समर्थन करता है, साथ ही आपके स्थानीय AI के साथ इंटरैक्ट करने के लिए एक सुव्यवस्थित इंटरफ़ेस प्रदान करता है। ये प्लेटफ़ॉर्म केवल मॉडल ही नहीं चलाते; ये आपको API सर्वर आसानी से स्थापित करने की सुविधा देते हैं, जिससे आपके मौजूदा एप्लिकेशन और सेवाओं के साथ सहज एकीकरण संभव हो जाता है। चाहे आप कई मॉडलों का प्रबंधन कर रहे हों, फाइन ट्यूनिंग के साथ प्रयोग कर रहे हों, या स्थानीय LLM के साथ अपनी यात्रा की शुरुआत कर रहे हों, ये प्लेटफ़ॉर्म आपको अपने स्थानीय AI की क्षमता को अधिकतम करने के लिए आवश्यक लचीलापन और शक्ति प्रदान करते हैं।.

स्थानीय एपीआई सर्वर बनाना

स्थानीय एपीआई सर्वर स्थापित करना उन सभी के लिए क्रांतिकारी साबित हो सकता है जो अपने बड़े भाषा मॉडल को एप्लिकेशन और वर्कफ़्लो में एकीकृत करना चाहते हैं! LM Studio और Ollama जैसे शक्तिशाली टूल की मदद से, अपना व्यक्तिगत स्थानीय एपीआई सर्वर बनाना बेहद आसान हो जाता है: बस अपनी चुनी हुई मॉडल फ़ाइल निर्दिष्ट करें, अधिकतम सुरक्षा के लिए अपनी सुरक्षित एपीआई कुंजी सेट करें और सर्वर को अपने पसंदीदा पोर्ट पर चलाने के लिए कॉन्फ़िगर करें। यह अत्याधुनिक सेटअप आपको एक सहज वेब यूआई के माध्यम से या एपीआई सर्वर के ज़रिए प्रोग्रामेटिक रूप से अपने मॉडल तक पहुंचने की सुविधा देता है, जिससे आपके काम करने के तरीके को बदलने वाले अनगिनत व्यावहारिक अनुप्रयोग खुल जाते हैं।.

ओलामा सहज एपीआई सर्वर एकीकरण की सुविधा देता है, जिससे आपके स्थानीय एलएलएम को अन्य टूल्स और प्लेटफॉर्म से जोड़ना आसान हो जाता है और अधिकतम दक्षता प्राप्त होती है। एलएम स्टूडियो भी उतनी ही प्रभावशाली क्षमताएं प्रदान करता है, जिससे आप एक सुंदर और उपयोगकर्ता के अनुकूल इंटरफ़ेस के माध्यम से अपने स्थानीय एपीआई सर्वर को प्रबंधित कर सकते हैं और पूर्ण नियंत्रण प्राप्त कर सकते हैं। अपना खुद का स्थानीय एपीआई सर्वर बनाकर, आप वास्तविक दुनिया के परिदृश्यों में मॉडल तैनात करने, जटिल कार्यों को स्वचालित करने और अपनी आवश्यकताओं के अनुरूप कस्टम समाधान बनाने में अद्वितीय लचीलापन प्राप्त करते हैं—यह सब करते हुए आपका बहुमूल्य डेटा पूरी तरह से सुरक्षित और आपके पूर्ण नियंत्रण में रहता है। चाहे आप अभूतपूर्व एप्लिकेशन विकसित कर रहे हों या मौजूदा वर्कफ़्लो को बेहतर बना रहे हों, एक स्थानीय एपीआई सर्वर आपके स्थानीय एआई इन्फ्रास्ट्रक्चर की असाधारण क्षमता को अनलॉक करने की कुंजी है।.