Sådan kører du LLM'er lokalt: Komplet 2025-guide til selvhostede AI-modeller

Den AI Revolutionen er i gang, men du behøver ikke at sende dine følsomme data til cloud-tjenester eller betale månedlige abonnementsgebyrer for at få gavn af den. Ved at køre store sprogmodeller lokalt på din egen computer får du fuld kontrol over dine AI-interaktioner, samtidig med at du opretholder absolut privatliv og eliminerer løbende omkostninger.

I denne omfattende guide finder du alt, hvad du skal bruge for at køre llms lokalt, lige fra at vælge de rigtige værktøjer og modeller til at optimere ydeevnen på din hardware. Uanset om du er en udvikler, der søger hjælp til kodning, en virksomhed beskyttelse følsomme data, eller en AI-entusiast, der ønsker offline-adgang, tilbyder lokale systemer overbevisende fordele i forhold til cloud-baserede alternativer.

Vi gennemgår de bedste værktøjer til 2025, hardwarekrav, der ikke ødelægger økonomien. Bank, og trinvise vejledninger til at få din første lokale llm til at køre på få minutter. Til sidst vil du forstå, hvordan du kan udnytte kraften i de nyeste sprogmodeller uden at gå på kompromis med dit privatliv eller dit budget.

Hvad du vil lære

- Hvad “at køre LLM'er lokalt” betyder, og hvordan det fungerer

- Fordelene ved selv-hostet AI vs. cloud AI

- De bedste værktøjer i 2025 (LM Studio, Ollama, GPT4All, Jan, llamafile, llama.cpp)

- Hardwarekrav til modeller fra 2B til 70B+ parametre

- Sådan installerer og kører du din første model

- Sådan opretter du en sikker lokal API-server

- Virkelige brugsscenarier for personlige og forretningsmæssige arbejdsgange

- Tips til ydeevne, fejlfinding og omkostningssammenligninger

Introduktion til store sprogmodeller

Store sprogmodeller (LLM'er) er revolutionerende kunstig intelligens systemer, der forandrer, hvordan du interagerer med teknologi, og som er designet til at forstå, generere og manipulere menneskeligt sprog med hidtil uset raffinement. Ved at træne på massive datasæt med tekst leverer disse banebrydende store sprogmodeller sammenhængende, kontekstbevidste svar, der revolutionerer din arbejdsgang, hvilket gør dem helt afgørende for en utrolig række applikationer, fra chatbots og virtuelle assistenter til sprogoversættelse, tekstresumé og kreativ indholdsgenerering, der glæder brugerne og skaber resultater.

At køre store sprogmodeller lokalt på din egen computer giver enestående fordele, som cloud-tjenester simpelthen ikke kan matche. Når du kører LLM'er lokalt, bevarer du fuld kontrol over dine følsomme data og sikrer, at fortrolige oplysninger aldrig forlader din enhed - en tilgang, der sætter privatlivets fred først og skaber tillid. Denne stærke strategi øger ikke kun sikkerheden og trygheden, men eliminerer også afhængigheden af eksterne udbydere og reducerer de tilbagevendende abonnementsgebyrer til nul. Som følge heraf vælger smarte enkeltpersoner og fremsynede organisationer at køre LLM'er lokalt og udnytte den fulde kraft i disse modeller til alt fra forretningsautomatisering til personlig produktivitet uden at gå på kompromis med sikkerheden eller brænde igennem løbende omkostninger.

Uanset om du brænder for at eksperimentere med banebrydende modeller, bygge tilpassede AI-drevne værktøjer, der skalerer din succes, eller blot ønsker en mere privat og lynhurtig AI-oplevelse, giver lokal kørsel af LLM'er dig mulighed for at udnytte de nyeste sprogmodeller direkte, så du kan innovere hurtigere, være sikker og levere enestående resultater.

Hvad betyder det at køre LLM'er lokalt?

At køre store sprogmodeller lokalt betyder at køre sofistikerede AI-modeller direkte på din egen computer eller lokale maskine i stedet for at være afhængig af cloud-tjenester som ChatGPT, Claude eller Gemini. Når du kører llm lokalt, sker hele inferensprocessen på din egen hardware, uden at data sendes over internettet til eksterne servere.

De vigtigste fordele ved local llms er fuldstændig databeskyttelse, ingen abonnementsomkostninger efter den første opsætning og offline-funktionalitet, der fungerer uden internetforbindelse. Dine følsomme data forlader aldrig din enhed, hvilket gør lokal inferens særligt værdifuld for virksomheder, der håndterer fortrolige oplysninger, udviklere, der arbejder med beskyttet kode, eller enkeltpersoner, der er bekymrede for privatlivets fred.

I modsætning til skybaserede AI-tjenester, der kræver API-nøgler og opkræver betaling pr. anmodning, giver lokale modeller ubegrænset brug, når du har downloadet modellen fra arkiver eller kilder som GitHub eller Hugging Face og gemt modelfilen på din computer. Det skaber forudsigelige omkostninger og eliminerer bekymringer om API-takstgrænser eller serviceafbrydelser, der påvirker dit workflow.

En praktisk sammenligning illustrerer forskellen: Når du bruger ChatGPT, sendes dine spørgsmål til OpenAI's servere for at blive behandlet, før de returneres. Med en lokal lm som Llama 3.2, der kører på din maskine, sker alt på din forbrugerhardware. Mens cloud-tjenester tilbyder bekvemmelighed og avancerede modeller, giver lokal AI privatliv, kontrol og omkostningsforudsigelighed, som mange brugere finder overbevisende.

Almindelige misforståelser omfatter troen på, at det kræver dyr GPU-hardware eller kompleks teknisk opsætning at køre llms lokalt. Moderne værktøjer som LM Studio og GPT4All har forenklet processen betydeligt, og mange mindre modeller kører effektivt på almindelige stationære computere med tilstrækkelig RAM.

Opsætning af et lokalt miljø

At komme i gang med local llms begynder med at omdanne din computer til et kraftfuldt AI-kraftværk, der leverer enestående ydeevne lige ved hånden. Det første skridt er at sikre, at dit operativsystem, uanset om det er Windows, macOS eller Linux, bliver det perfekte fundament for de banebrydende værktøjer, du vil bruge, såsom LM Studio, Ollama eller GPT4All. Hver af disse banebrydende platforme tilbyder en strømlinet, brugervenlig tilgang til at administrere og interagere med lokale modeller, hvilket gør avanceret AI tilgængelig for alle, selv dem, der tager deres første skridt ind i det spændende område. verden af kunstig intelligens.

Dernæst skal du maksimere dit hardwarepotentiale for at opnå utrolige præstationsgevinster. Mange mindre modeller leverer imponerende resultater på almindelige stationære eller bærbare computere, men hvis du har en moderne CPU, tilstrækkeligt med RAM og ideelt set en dedikeret GPU, bliver din oplevelse endnu bedre, og du kan køre større og mere sofistikerede modeller med bemærkelsesværdig smidighed. Ved at sikre, at dit system opfylder minimumskravene til det valgte værktøj og den valgte model, giver du dig selv mulighed for at opnå uovertrufne AI-muligheder.

Når din hardware og dit operativsystem er perfekt afstemt, kan du installere dit foretrukne værktøj og se magien ske. LM Studio har f.eks. en intuitiv grafisk grænseflade, der gør modelstyring ubesværet enkel, mens Ollama tilbyder en kommandolinjeoplevelse, der giver udviklere avanceret kontrol. Efter installationen har du frihed til at gennemse, downloade og køre kompatible modeller direkte på din lokale maskine, hvilket giver dig fuld kontrol over din AI-oplevelse.

Ved omhyggeligt at vælge det rigtige værktøj og sikre, at dit miljø er konfigureret af eksperter, får du alt, hvad du behøver for at køre llms lokalt og udnytte den fulde effekt af de seneste fremskridt inden for AI. Du får ikke bare lokale AI-funktioner, du får total uafhængighed, forbedret privatliv og lynhurtig ydeevne, der forandrer, hvordan du arbejder med kunstig intelligens.

Hurtig start: De bedste værktøjer til at afholde LLM'er lokalt i 2025

Landskabet af værktøjer til at køre lokale llms er modnet dramatisk og tilbyder brugervenlige muligheder, der eliminerer de fleste tekniske barrierer. Her er de fem bedste platforme, der gør det muligt at køre modeller lokalt for brugere på alle niveauer, herunder adgang til populære modeller som Llama og DeepSeek R1 til lokal brug:

LM Studio udmærker sig som den mest begyndervenlige løsning med sin intuitive grafiske grænseflade og indbyggede modelbrowser. Download fra lmstudio.ai og få glæde af problemfri modelstyring på tværs af Windows 11, macOS Ventura+ og Ubuntu 22.04+.

GPT4All fokuserer på AI med fokus på privatlivets fred med fremragende dokumentchatfunktioner via LocalDocs-funktionen. Den er tilgængelig på gpt4all.io til alle større operativsystemer og tilbyder en kurateret modelmarkedsplads med over 50 kompatible modeller.

Jan er et open source-alternativ til ChatGPT med udvidelig arkitektur og hybride lokale/skyfunktioner. Kom i gang på jan.ai med understøttelse af brugerdefinerede udvidelser og ekstern API-integration.

Ollama er det foretrukne kommandolinjeværktøj for udviklere og tilbyder enkel modelstyring og fremragende API-integration. Det er ligetil at installere Ollama: Download og kør installationsprogrammet til dit operativsystem, og følg derefter anvisningerne for at fuldføre installationen. Når du har installeret Ollama, kan du bruge kommandolinjeværktøjet til at administrere og køre modeller. En vigtig funktion er pull-kommandoen, som giver dig mulighed for at downloade eller opdatere specifikke modeller direkte fra terminalen til øjeblikkelig brug.

llamafile leverer bærbar AI gennem eksekverbare filer med én fil, der kan køre hvor som helst uden installation. Perfekt til hurtig testning eller udrulningsscenarier, hvor minimal opsætning er afgørende.

For nybegyndere giver LM Studio den nemmeste onboarding-oplevelse med sin visuelle grænseflade og automatiske GPU-acceleration. Udviklere foretrækker typisk Ollama på grund af dens fleksibilitet og integrationsmuligheder med eksisterende udviklingsworkflows.

Disse værktøjer er designet til at give en brugervenlig oplevelse for både begyndere og avancerede brugere.

Hardwarekrav til lokale LLM'er

At forstå hardwarekravene hjælper dig med at vælge passende modeller til dit system og sætte realistiske forventninger til ydeevnen. Den gode nyhed er, at moderne lokale computere fungerer på en bred vifte af hardwarekonfigurationer, fra beskedne bærbare computere til avancerede arbejdsstationer.

Minimumsspecifikationer for at køre mindre modeller omfatter 16 GB RAM, en moderne CPU som Intel i5-8400 eller AMD Ryzen 5 2600 og mindst 50 GB tilgængelig lagerplads. Disse specifikationer håndterer modeller med op til 7B parametre med acceptabel performance i de fleste tilfælde.

Anbefalede specifikationer for optimal ydeevne omfatter en NVIDIA RTX 4060 med 8 GB video-ram, 32 GB system-RAM og 100 GB+ lagerplads til flere modeller. Denne konfiguration giver jævn inferens for større modeller og gør det muligt at køre flere modeller samtidigt.

Lagringskravene varierer efter modelstørrelse: mindre modeller som Phi-3-mini kræver 2-4 GB, mens større modeller som Llama 3.1 70B kræver 40-80 GB afhængigt af kvantisering. Hvis du har begrænsede ressourcer, kan det være en god idé at downloade den mindste tilgængelige model, som Gemma 2B Instruct, for at minimere lager- og hukommelsesforbruget. Planlæg 50-100 GB, hvis du vil eksperimentere med flere modeller i forskellige størrelser.

Her er en sammenligning af ydeevne, der viser tokens pr. sekund for forskellige hardwarekonfigurationer:

Hardware-konfiguration | Phi-3-mini (3B) | Llama 3.1 8B | Mistral 7B | Kode Llama 34B |

|---|---|---|---|---|

Kun CPU (16 GB RAM) | 8-12 tokens/sek. | 4-6 tokens/sek. | 3-5 tokens/sek. | Anbefales ikke |

RTX 4060 (8 GB VRAM) | 45-60 symboler/sek. | 25-35 tokens/sek. | 30-40 tokens/sek. | 8-12 tokens/sek. |

RTX 4090 (24 GB VRAM) | 80-120 tokens/sek. | 60-80 tokens/sek. | 70-90 tokens/sek. | 35-45 tokens/sek. |

Apple M2 Pro (32 GB) | 35-50 symboler/sek. | 20-30 tokens/sek. | 25-35 tokens/sek. | 15-20 tokens/sek. |

GPU-acceleration forbedrer ydeevnen betydeligt, men CPU-only inferens er stadig levedygtig for mindre modeller, når GPU-ressourcer ikke er tilgængelige. Den optimale ydeevne opnås ved at tilpasse modelstørrelsen til den tilgængelige video-ram eller system-RAM.

De bedste open source-modeller til at køre lokalt

Valg af den rigtige model afhænger af dine hardwarekapaciteter, planlagte brugsscenarier og kvalitetskrav. Open source-modeller har nået imponerende kvalitetsniveauer, samtidig med at de er tilgængelige for lokal udrulning. Det voksende landskab af open source llm-projekter, såsom Ollama og llama.cpp, fremhæver styrken ved community-drevet udvikling og den stigende tilgængelighed af modeller, der er udgivet af førende AI-organisationer.

Små modeller (under 8 GB) giver fremragende effektivitet til grundlæggende opgaver:

- Phi-3-mini (3,8B parametre) giver stærke ræsonnementsmuligheder i en kompakt 2,3GB-pakke, ideel til scenarier med begrænset ram.

- Gemma 2B leverer Googles træningskvalitet i en ultralet modelfil på 1,4 GB

- Llama 3.2 3B tilbyder Metas seneste arkitekturoptimeringer med afbalanceret ydeevne og effektivitet

Mellemstore modeller (8-16 GB) giver den bedste balance mellem kapacitet og ressourcekrav:

- Llama 3.1 8B er guldstandarden for generelle opgaver med stærk ræsonnering og kodegenerering.

- Mistral 7B udmærker sig ved at følge instruktioner præcist og håndtere komplekse ræsonneringsopgaver

- DeepSeek-Coder 6.7B er specialiseret i kodegenerering med understøttelse af 80+ programmeringssprog

Store modeller (16 GB+) giver maksimal kapacitet for brugere med tilstrækkelig hardware:

- Llama 3.1 70B giver ydeevne i GPT-4-klassen til komplekse ræsonnements- og analyseopgaver

- Code Llama 34B leverer enestående kodningshjælp med dyb forståelse af software engineering-koncepter

Alle modeller er tilgængelige via Hugging Face med model-ID'er som “microsoft/Phi-3-mini-4k-instruct” eller “meta-llama/Meta-Llama-3.1-8B-Instruct”. Benchmarks for ydeevne viser, at 8B-parametermodeller typisk giver den bedste værdi for de fleste brugere, idet de tilbyder 85-90% af en større models kapacitet, samtidig med at de kræver betydeligt færre ressourcer.

LM Studio: Den nemmeste måde at starte på

LM Studio revolutionerer den lokale ai-tilgængelighed ved at levere en brugervenlig grafisk grænseflade, der fjerner den tekniske kompleksitet. LM Studio og lignende værktøjer tilbyder brugergrænseflader, herunder grafiske og webbaserede muligheder, der forenkler modelstyring og interaktion. LM Studio tilbyder også en praktisk web ui, så brugerne kan administrere og interagere med modeller direkte fra deres browser. Det gør det til det ideelle udgangspunkt for brugere, der ikke er vant til at køre llms lokalt.

Begynd med at downloade LM Studio fra lmstudio.ai og følge den enkle installationsproces for dit operativsystem. Installationsprogrammet konfigurerer automatisk GPU-acceleration, når der registreres kompatibel hardware, hvilket eliminerer manuel driverkonfiguration. Efter installationen skal du starte LM Studio for at få adgang til hovedgrænsefladen og begynde at udforske tilgængelige modeller.

Hovedgrænsefladen har tre vigtige sektioner: Discover til at gennemse tilgængelige modeller, My Models til at administrere downloadede modeller og Chat til at interagere med indlæste modeller. I Discover-fanen kan du bruge søgefeltet til hurtigt at finde specifikke modeller baseret på dine krav. Det indbyggede modelbibliotek samler open source-modeller af høj kvalitet med klare beskrivelser og hardwarekrav.

Opsætning af chatgrænsefladen indebærer indlæsning af en downloadet model og justering af generationsparametre som temperatur og kontekstlængde. Grænsefladen har intuitive skydere og forklaringer til hver indstilling, hvilket gør eksperimenter tilgængelige for ikke-tekniske brugere.

For udviklere indeholder LM Studio en lokal api-server, der udstiller OpenAI-kompatible slutpunkter. Aktivér denne funktion i indstillingerne for at integrere lokale modeller med eksisterende programmer, der understøtter OpenAI's API-format.

Installation af din første model i LM Studio

Gå til fanen Discover, hvor du finder et søgbart bibliotek med kompatible modeller. Søg efter “llama-3.2-3b-instruct” for at finde Metas effektive 3B-parametermodel, der fungerer godt på beskeden hardware.

Klik på download-knappen for at starte processen. LM Studio viser fremdriftsindikatorer, der viser downloadhastigheden og den forventede afslutningstid. Downloadmanageren håndterer afbrydelser på en elegant måde og genoptager delvise downloads, når netværksforbindelsen vender tilbage.

Når downloadet er færdigt, vises modellen i sektionen Mine modeller. De downloadede modelfiler administreres og gemmes, så de er nemme at få adgang til og indlæse. Klik for at indlæse den i hukommelsen, hvilket typisk tager 10-30 sekunder afhængigt af modelstørrelse og lagerhastighed. Interfacet viser hukommelsesforbruget og bekræfter, når modellen er klar til interaktion.

Test din installation med eksempler på opgaver som “Forklar kvantecomputere i enkle vendinger” eller “Skriv en Python-funktion til at beregne fibonacci-tal”. Modellen bør svare inden for få sekunder og bekræfte en vellykket opsætning.

Almindelig fejlfinding i forbindelse med downloadfejl omfatter kontrol af ledig diskplads, kontrol af internetforbindelsens stabilitet og sikring af, at din firewall tillader LM Studio-netværksadgang. De indbyggede logfiler giver detaljerede fejloplysninger til løsning af problemer.

GPT4All: Privatlivsfokuseret lokal AI

GPT4All lægger vægt på privatlivets fred og brugervenlighed, hvilket gør det til et fremragende valg for brugere, der prioriterer datasikkerhed. Programmet kører helt offline, når modellerne er downloadet, hvilket sikrer, at dine samtaler aldrig forlader din enhed.

Download GPT4All fra gpt4all.io og installer på Windows, macOS eller Linux. Installationsprocessen downloader automatisk en startmodel for at sikre øjeblikkelig funktionalitet. Den første lancering viser en ren grænseflade med tydelig navigation mellem chat, modeller og indstillinger. Efter installationen kan du bede modellerne om at generere tekst til en række forskellige opgaver, f.eks. at besvare spørgsmål eller skabe indhold.

Modelmarkedet tilbyder 50+ kuraterede modeller med detaljerede beskrivelser, hardwarekrav og brugervurderinger. Modellerne er kategoriseret efter størrelse og specialitet, hvilket hjælper brugerne med at vælge passende muligheder til deres brugsscenarier og hardwarebegrænsninger.

Opsætning af GPU-acceleration varierer fra platform til platform, men involverer generelt installation af CUDA-drivere til NVIDIA-grafikkort eller sikring af Metal-understøttelse på macOS. Indstillingspanelet giver klare instruktioner og automatisk registrering af kompatible hardwarekonfigurationer.

Opsætning af LocalDocs til dokumentchat

LocalDocs er GPT4Alls mest fremtrædende funktion, som muliggør private samtaler med dine personlige dokumenter uden at uploade indhold til eksterne servere. Denne funktion forvandler lokale dokumenter til effektive forsknings- og analyseværktøjer.

Få adgang til LocalDocs via den dedikerede fane og tilføj lokale mapper, der indeholder PDF'er, tekstfiler, markdown-dokumenter eller kodelagre. Systemet understøtter almindelige formater, herunder .pdf, .txt, .md, .docx og kildekodefiler.

Indekseringsprocessen analyserer dokumentindhold for at skabe søgbare indlejringer, der er gemt lokalt på din enhed. Indekseringstiden afhænger af dokumentmængden, men typisk behandles hundredvis af sider på få minutter. Fremdriftsindikatorer viser status for færdiggørelse og anslået resterende tid.

Eksempler på forespørgsler mod indekserede dokumenter kan være “Sammenfat de vigtigste resultater fra mine forskningsartikler” eller “Hvilke kodningsmønstre optræder hyppigst i mine projekter?”. Systemet henter relevante dokumentafsnit, før det genererer svar, hvilket giver velbegrundede svar med kildeangivelse. Citater.

Fordelene ved beskyttelse af personlige oplysninger omfatter fuldstændig offline-behandling uden dataoverførsel til eksterne tjenester. Dine dokumenter forbliver på din lokale maskine under hele processen, hvilket gør LocalDocs velegnet til fortrolige forretningsdokumenter eller personligt forskningsmateriale.

Jan: Open Source ChatGPT-alternativ

Jan positionerer sig som et omfattende open source-alternativ til kommercielle AI-chattjenester og tilbyder velkendte grænseflader med open source-udviklingens fleksibilitet. Platformen understøtter både lokal inferens og hybrid cloud-integration for maksimal fleksibilitet.

Installation fra jan.ai kræver verificering af systemkrav, herunder tilstrækkelig RAM og lagerplads. Installationsprogrammet registrerer automatisk hardwarefunktioner og foreslår optimale konfigurationsindstillinger til din specifikke opsætning.

Rundvisningen i brugerfladen afslører et ChatGPT-inspireret design med moderne brugerfladeelementer og intuitiv navigation. Samtalehistorik, modelskift og adgang til indstillinger følger velkendte mønstre, der reducerer indlæringskurver for brugere, der skifter fra kommercielle tjenester.

Modelimportfunktioner gør det muligt at bringe modeller fra andre værktøjer som LM Studio eller Ollama, så man undgår overflødige downloads. Jan understøtter import af alle kompatible store sprogmodeller til lokal eller hybrid brug. Systemet registrerer automatisk kompatible modelformater og konverterer dem efter behov for at opnå optimal ydeevne.

Markedet for udvidelser tilføjer funktionalitet gennem community-udviklede plugins, der dækker områder som forbedret modelstyring, specialiserede chattilstande og integration med eksterne værktøjer og tjenester.

Remote API-integration muliggør hybride implementeringer, hvor nogle anmodninger bruger lokale modeller, mens andre udnytter cloud-tjenester baseret på kompleksitet eller krav til ydeevne. Denne tilgang optimerer omkostningerne, samtidig med at man bevarer lokale muligheder for følsomme opgaver.

Ollama: Udviklervenligt kommandolinjeværktøj

Ollama udmærker sig som et kommandolinjeværktøj, der er designet specielt til udviklere, som foretrækker programmatisk kontrol og integrationsmuligheder. Den enkle, men kraftfulde grænseflade gør modelstyring og implementering ligetil for tekniske brugere.

Installationen varierer fra operativsystem til operativsystem, men bruger typisk pakkehåndteringer som Homebrew på macOS (brew install ollama), apt på Ubuntu (sudo apt install ollama) eller winget på Windows (winget install ollama). Disse metoder sikrer korrekt afhængighedsstyring og systemintegration.

Efter installationen kan brugerne interagere med Ollama via specifikke terminalkommandoer til at downloade, køre og administrere modeller, hvilket gør det nemt at arbejde helt fra kommandolinjen.

Vigtige kommandoer giver omfattende styring af modellens livscyklus:

- ollama pull llama3.1:8b downloader modeller fra det officielle bibliotek

- ollama run llama3.1:8b starter interaktive chatsessioner med angivne modeller

- ollama-listen viser alle installerede modeller med størrelser og ændringsdatoer

- ollama rm model-name fjerner modeller for at frigøre lagerplads

Ollama kan konfigureres som en lokal server eller en lokal inferensserver, så du kan hoste og servere modeller lokalt til integration med andre programmer. Denne opsætning muliggør nem tilpasning, forbedret ydeevne og problemfri support til fejlfinding.

Oprettelse af brugerdefinerede modeller via Modelfile gør det muligt at finjustere modeladfærd, systemprompter og parametre. Denne tekstbaserede konfigurationsmetode passer godt sammen med versionsstyring og automatiseringsworkflows.

Integration med udviklingsværktøjer omfatter plugins til populære IDE'er som VS Code, hvilket muliggør generering og analyse af kode direkte i udviklingsmiljøer. Det standardiserede API-format forenkler integrationen med eksisterende programmer og tjenester.

Kørsel af flere modeller med Ollama

Ollamas arkitektur understøtter samtidig modeleksekvering, så forskellige modeller kan udføre specialiserede opgaver samtidigt. Denne funktion muliggør sofistikerede arbejdsgange, hvor mindre modeller håndterer grundlæggende opgaver, mens større modeller håndterer komplekse ræsonnementer.

Skift mellem modeller kræver en simpel kommandosyntaks som ollama run mistral:7b efterfulgt af ollama run codellama:7b i separate terminalsessioner. Hver model opretholder en uafhængig samtalekontekst og hukommelsesallokering.

Hukommelsesstyring håndterer automatisk ressourceallokering baseret på tilgængelige systemressourcer og modelkrav. Systemet giver advarsler, når hukommelsesbegrænsninger kan påvirke ydeevnen, og foreslår optimeringsstrategier.

API-serveropsætning gennem ollama serve udstiller modeller via HTTP-slutpunkter, der er kompatible med OpenAI's format. Dette muliggør problemfri integration med applikationer designet til cloud AI-tjenester, der udelukkende kører på lokal infrastruktur.

Docker-implementering letter produktionsmiljøer gennem officielle Ollama-containere. Den containeriserede tilgang sikrer ensartet adfærd på tværs af udviklings-, staging- og produktionsmiljøer, samtidig med at afhængighedsstyringen forenkles.

Avancerede værktøjer: llama.cpp og llamafile

Avancerede brugere, der ønsker maksimal kontrol og optimering af ydeevnen, har gavn af værktøjer på lavere niveau som llama.cpp og llamafile. For at køre modeller med llama.cpp skal brugerne downloade en gguf-modelfil, som er det nødvendige format til lokal implementering. Disse værktøjer ofrer bekvemmelighed for fleksibilitet og effektivitet, hvilket gør dem ideelle til produktionsudrulninger og specialiserede krav.

Beslutningen mellem brugervenlige programmer og avancerede værktøjer afhænger af specifikke behov. Vælg avancerede værktøjer, når du har brug for tilpassede kompileringsmuligheder, specialiseret hardwaresupport eller integration i større systemer, hvor fuld kontrol over inferensmotoren er nødvendig. Brugere kan også køre finjusterede modeller til specifikke opgaver eller domæner og opnå optimal ydeevne, der er skræddersyet til deres krav.

Kompilering af llama.cpp med GPU-understøttelse involverer konfiguration af build-systemer til specifikke hardwaremål. CUDA-understøttelse kræver NVIDIA-drivere og installation af værktøjssæt, Metal-understøttelse fungerer automatisk på macOS med Apple Silicon, og OpenCL giver bredere GPU-kompatibilitet på tværs af leverandører.

Optimering af ydeevne gennem avancerede værktøjer omfatter brugerdefinerede kvantiseringsskemaer, optimering af hukommelseskortlægning og specialiserede opmærksomhedsimplementeringer. Disse optimeringer kan forbedre slutningshastigheden betydeligt og reducere hukommelseskravene sammenlignet med generelle løsninger.

Eksekverbare llamafiler giver bærbar AI-implementering ved at pakke modeller og inferensmotorer i enkeltfiler, der kører uden installation. Denne tilgang forenkler implementeringsscenarier, hvor traditionelle installationsprocesser ikke er mulige eller ønskelige.

Modelkvantiseringsteknikker, der er tilgængelige via avancerede værktøjer, omfatter 4-bit, 8-bit og blandede præcisionsformater, der reducerer modelstørrelsen og samtidig bevarer den bedste ydeevne. Brugere kan eksperimentere med forskellige kvantiseringsskemaer for at finde den optimale balance til deres specifikke brug.

Oprettelse af en lokal API-server

En lokal API-server leverer den ultimative integrationsløsning til din llm-model og giver problemfri forbindelse til andre programmer, samtidig med at du bevarer fuld kontrol over dine data og din infrastruktur. Både LM Studio og Ollama tilbyder kraftfulde, enkle implementeringsmuligheder, der giver dig funktioner i virksomhedsklasse direkte i hænderne, uanset om du foretrækker intuitive grafiske grænseflader eller præcision på kommandolinjen.

For at komme i gang skal du vælge din foretrukne implementeringsstrategi, LM Studio eller Ollama, og installere den på din infrastruktur. Når den er implementeret, downloader du den LM-model, der passer perfekt til dine hardwarefunktioner og forretningskrav, hvilket sikrer optimal ressourceudnyttelse. Konfigurer kritiske ydelsesparametre som kontekstlængde og lås op for GPU-accelerationsfunktioner, når dit system understøtter det, så du kan levere de højtydende resultater, dine applikationer kræver.

Det kunne ikke være nemmere at starte din lokale API-server: LM Studio giver serveraktivering via en intuitiv indstillingsgrænseflade, mens Ollama tilbyder terminalbaseret kontrol for maksimal driftsfleksibilitet. Din API-server fungerer på en dedikeret port, klar til at behandle anmodninger fra dine applikationer og levere genererede tekstsvar med pålidelighed og hastighed på virksomhedsniveau.

Når din lokale API-server er i drift, får du frihed til at bygge brugerdefinerede chatbots, automatisere komplekse arbejdsgange og integrere avancerede sprogfunktioner direkte i dit softwareøkosystem, samtidig med at du opretholder fuld datasikkerhed og sikrer, at din llm-model fungerer helt inden for dit kontrollerede miljø. Dette er mere end bare en teknisk opsætning; det er din gateway til skalerbare, sikre og sofistikerede sprogbehandlingsfunktioner.

Sikring af din lokale LLM med en API-nøgle

Det er ikke bare vigtigt at sikre adgangen til din lokale llm, det er også det fundament, der forvandler din AI-implementering fra en potentiel sårbarhed til en fæstning af kontrolleret innovation. Når du forbinder flere applikationer eller brugere, bliver implementering af et api-nøglesystem din afgørende strategi, der sikrer, at kun autoriserede anmodninger kan låse op for kraften i din model, samtidig med at uautoriseret adgang holdes på afstand.

Forvandl din sikkerhedstilgang ved at generere unikke api-nøgler til hver applikation eller bruger, der udnytter din lokale llm's muligheder. Gem disse digitale nøgler som værdifulde aktiver i miljøvariabler eller krypterede konfigurationsfiler, så du forhindrer enhver utilsigtet eksponering, der kan kompromittere din konkurrencefordel. Konfigurer din lokale api-server til at kræve validering af api-nøgler ved hver eneste anmodning, så du skaber en uigennemtrængelig barriere, der blokerer for uautoriserede adgangsforsøg, før de overhovedet kan banke på din dør.

Løft din sikkerhedsstrategi ved regelmæssigt at rotere dine api-nøgler for at reducere risikoen for et potentielt brud, og tag afgørende skridt til at tilbagekalde nøgler, der ikke længere er nødvendige, eller som kan være blevet kompromitteret. Ved at anvende disse brancheførende fremgangsmåder bevarer du ikke bare kontrollen, du etablerer fuldstændig dominans over din lokale llm og beskytter både din værdifulde model og alle de følsomme data, den behandler, med kompromisløs præcision.

Praktiske anvendelser og use cases

At køre llms lokalt muliggør mange praktiske anvendelser på tværs af professionelle og personlige sammenhænge. Kombinationen af privatliv, ubegrænset brug og offline-funktioner åbner muligheder, som cloud-tjenester ikke kan tilbyde.

Generering af kode og fejlfinding er de primære anvendelsesområder for lokal AI. Modeller som DeepSeek-Coder og Code Llama udmærker sig ved at forstå programmeringssammenhænge, generere standardkode, forklare komplekse algoritmer og foreslå fejlrettelser på tværs af mere end 80 programmeringssprog.

Arbejdsgange til oprettelse af indhold drager fordel af lokale modellers ubegrænsede genereringsmuligheder. Blogindlæg, e-mails, Markedsføring og indhold til sociale medier kan genereres iterativt uden API-omkostninger eller takstbegrænsninger. Muligheden for at finjustere lokale modeller på specifikke skrivestile tilføjer Personalisering umuligt med cloud-tjenester.

Dataanalyse- og opsummeringsopgaver udnytter lokale modellers evne til at behandle følsomme oplysninger uden ekstern transmission. Finansielle rapporter, juridiske dokumenter, lægejournaler og proprietær forskning kan analyseres, samtidig med at der opretholdes fuld fortrolighed.

Sprogoversættelse uden eksterne tjenester sikrer privatlivets fred for følsom kommunikation og understøtter samtidig dusinvis af sprogpar. Lokale modeller håndterer oversættelse af teknisk dokumentation, flersproget kundesupport og international forretningskommunikation helt offline.

Eksempler fra den virkelige verden omfatter advokatfirmaer, der bruger lokale modeller til dokumentanalyse, softwarevirksomheder, der implementerer AI-drevne kodningsassistenter, og indholdsskabere, der udvikler personaliserede skriveværktøjer. Hver af disse løsninger kører lokalt på brugerens hardware, hvilket sikrer privatlivets fred og kontrol. Disse applikationer demonstrerer alsidigheden og den praktiske værdi af lokal ai-implementering.

Optimering af ydeevne og fejlfinding

Maksimering af ydeevnen fra lokale llms kræver forståelse af systemressourcer, modelegenskaber og optimeringsteknikker. Korrekt konfiguration kan forbedre svartiderne dramatisk og muliggøre større modeller på beskeden hardware.

Opsætning af GPU-acceleration varierer fra leverandør til leverandør, men indebærer generelt installation af passende drivere og konfiguration af software til at genkende tilgængelig hardware. NVIDIA-brugere skal installere CUDA-værktøjssættet, mens AMD-brugere skal installere ROCm på understøttede Linux-distributioner.

Modelkvantisering reducerer hukommelseskravene ved at lagre modelparametre på lavere præcisionsniveauer. 4-bit kvantisering reducerer typisk modelstørrelsen med 75%, mens kvaliteten bevares på 95%+, hvilket gør store modeller tilgængelige på forbrugerhardware med begrænset video-ram.

Almindelige fejlmeddelelser og deres løsninger omfatter:

- “CUDA er løbet tør for hukommelse”: Reducer modelstørrelsen, luk andre programmer, eller aktiver CPU-offloading

- “Indlæsning af model mislykkedes”: Kontrollér modelfilens integritet og tilstrækkelig diskplads

- “Langsom inferenshastighed”: Tjek GPU-accelerationsindstillinger, og overvej modelkvantisering

Ressourceovervågning under inferens hjælper med at identificere flaskehalse og optimere konfigurationer. Task Manager på Windows, Activity Monitor på macOS eller htop på Linux afslører CPU-anvendelse, hukommelsesforbrug og GPU-aktivitetsmønstre under modeludførelse.

Justering af temperatur- og samplingsparametre påvirker outputkvalitet og -hastighed. Lavere temperaturer giver mere ensartet output, mens højere værdier øger kreativiteten. Top-k og top-p samplingsparametre afbalancerer responsdiversitet med kohærens.

Optimering af kontekstens længde afbalancerer hukommelsesforbruget med samtalekapaciteten. Længere kontekster muliggør mere sofistikerede interaktioner, men kræver forholdsmæssigt mere hukommelse. De fleste brugsscenarier fungerer godt med 2048-4096 token-kontekster.

Bedste praksis for lokal LLM-opsætning

For at få maksimal værdi ud af din lokale llm har du brug for en vinderstrategi, der både leverer topydelse og skudsikker sikkerhed. Start med at vælge den perfekte model til dine unikke behov, dyk dybt ned i modelparametre, størrelsesspecifikationer og målrettede applikationer for at finde det ideelle match til dine hardwarefunktioner og specifikke krav til brugssager.

Superlad din opsætning ved at finjustere kritiske modelparametre som kontekstlængde og aktivere GPU-acceleration, hvor det er muligt, for at opnå spilændrende ydelsesniveauer. Sørg for, at dit operativsystem leverer fejlfri kompatibilitet med dine valgte værktøjer og llm-modeller, mens du holder hele dit system og din softwarestak opdateret for at udnytte de seneste banebrydende funktioner og banebrydende sikkerhedsforbedringer.

Vær på forkant med flaskehalse ved aktivt at overvåge dine systemressourcer, spore RAM- og GPU-udnyttelse for at forhindre blokeringer i ydeevnen, især når du implementerer større modeller eller kører flere modeller parallelt. Forvandl din arbejdsgang med intuitive grafiske grænseflader som LM Studio eller GPT4All for at få en ubesværet brugeroplevelse, der gør modelstyring og optimering af indstillinger utrolig enkel.

Beskyt det, der betyder mest, bevar altid følsomme data i dit lokale miljø, og risikér aldrig at sende fortrolige oplysninger via internetkanaler. Test og evaluer løbende forskellige modeller for at sikre, at du bruger den optimale løsning til din specifikke applikation, og vær fleksibel nok til at finjustere eller skifte til nye modeller, efterhånden som dine krav vokser og udvikler sig.

Ved at implementere disse gennemprøvede best practices kan du skabe et lokalt llm-miljø, der er sikkert, lynhurtigt og præcist kalibreret til at levere fremragende resultater, der overgår dine unikke krav og skaber enestående resultater.

Analyse af omkostninger: Lokale vs. cloud AI-tjenester

At forstå økonomien i lokale AI-tjenester kontra cloud-tjenester hjælper med at træffe informerede beslutninger om infrastrukturinvesteringer. Analysen omfatter hardwareomkostninger på forhånd, løbende udgifter og break-even-beregninger baseret på brugsmønstre.

Investeringen i hardware på forhånd for dygtige lokale ai-systemer varierer fra $800-1.500 for mellemklassekonfigurationer til $3.000-5.000 for avancerede opsætninger. Disse omkostninger omfatter moderne CPU'er, tilstrækkelig RAM, effektive GPU'er og tilstrækkelig lagerplads til flere modeller.

De månedlige abonnementsomkostninger for cloud AI-tjenester varierer meget: ChatGPT Plus koster $20/måned, Claude Pro koster $20/måned, og API-brug kan variere fra $10-500+ månedligt afhængigt af volumen. Virksomhedsplaner koster ofte mere end $100/måned pr. bruger.

Break-even-analyser viser, at moderate til tunge brugere typisk tjener hardwareinvesteringerne hjem inden for 6-18 måneder. Brugere, der behandler følsomme data eller kræver tilgængelighed 24/7, retfærdiggør ofte lokal infrastruktur uanset rene omkostningsovervejelser.

Energiomkostningerne til at køre lokale modeller tilføjer løbende ca. $30-100 månedligt til elregningen, afhængigt af hardwarens effektivitet og de lokale forsyningspriser. Moderne GPU'er omfatter strømstyringsfunktioner, der reducerer forbruget i perioder med inaktivitet.

Beregninger af de samlede ejeromkostninger over 2-3 år favoriserer generelt lokale løsninger til:

- Brugere med moderate til tunge AI-brugsmønstre

- Organisationer, der kræver overholdelse af databeskyttelse

- Applikationer med behov for garanteret tilgængelighed

- Teams, der ønsker ubegrænsede muligheder for at eksperimentere

Cloud-tjenester er fortsat økonomiske:

- Lejlighedsvise brugere med minimal månedlig volumen

- Teams, der har brug for adgang til banebrydende modeller

- Organisationer uden ekspertise inden for IT-infrastruktur

- Applikationer med behov for problemfri skalering

Beslutningen involverer ofte ikke-økonomiske faktorer, herunder krav til privatlivets fred, Datasuverænitet, internetforbindelsens pålidelighed og organisatoriske kontrolpræferencer, der tipper balancen mod lokal udrulning på trods af højere startomkostninger.

Lokale, store sprogmodeller repræsenterer et grundlæggende skift i retning af demokratiseret, privat og omkostningseffektiv anvendelse af AI. I takt med at modellerne bliver mere effektive og værktøjerne mere brugervenlige, bliver adgangsbarrieren stadig mindre, mens mulighederne vokser hurtigt.

Uanset om du er en udvikler, der søger hjælp til kodning, en virksomhed, der beskytter følsomme data, eller en entusiast, der udforsker AI-muligheder, giver lokal kørsel af llms en hidtil uset kontrol over din AI-oplevelse. Start med brugervenlige værktøjer som LM Studio eller GPT4All, eksperimenter med forskellige modeller for at finde din ideelle balance mellem kapacitet og ydeevne, og udvid gradvist din opsætning, efterhånden som behovene udvikler sig.

Fremtiden for AI hører ikke kun hjemme i store datacentre, men på din egen hardware, under din fulde kontrol. Download din første lokale model i dag, og oplev friheden ved selv-hostet kunstig intelligens.

Introduktion til lokal AI

Lokal AI revolutionerer den måde, hvorpå enkeltpersoner og organisationer udnytter kunstig intelligens, ved at bringe den fulde kraft af store sprogmodeller direkte ind på din egen computer. I stedet for at være afhængig af cloud-baserede tjenester betyder det at køre llms lokalt, at al behandling sker på din enhed, hvilket giver dig fuld kontrol over modelparametre, og hvordan dine følsomme data håndteres. Denne tilgang forbedrer ikke bare privatlivets fred - da dine data aldrig forlader din maskine - men reducerer også ventetiden, hvilket gør svarene hurtigere og mere pålidelige end nogensinde før.

Med lokal ai kan du finjustere store sprogmodeller, så de passer til dine unikke behov, uanset om du optimerer til specifikke opgaver eller eksperimenterer med forskellige konfigurationer. Ved at køre llms lokalt kan du tilpasse modeller, styre opdateringer og implementere løsninger, der er skræddersyet perfekt til din arbejdsgang, samtidig med at dine oplysninger er helt sikre. Efterhånden som flere brugere opdager den afgørende værdi af lokal implementering, fortsætter økosystemet af værktøjer og modeller med at udvide sig hurtigt, hvilket gør det nemmere end nogensinde at udnytte mulighederne i de nyeste store sprogmodeller llms direkte på din egen computer.

Kom godt i gang med lokale LLM'er

Det har aldrig været mere tilgængeligt at starte din lokale LLM-rejse - takket være banebrydende værktøjer og et voksende økosystem af kraftfulde modeller lige ved hånden. Start med at vælge en platform som LM Studio eller Ollama, der begge er udviklet til at forenkle og strømline processen med at køre LLM'er direkte på din maskine. Disse løsninger leverer brugervenlige oplevelser, der er skræddersyet til dine præferencer - LM Studio med sin intuitive grafiske grænseflade og Ollama med sin effektive kommandolinjetilgang - så du kan vælge den arbejdsgang, der passer perfekt til din tekniske komfortzone.

Når du har installeret din foretrukne platform, kan du bruge den integrerede søgefunktion til nemt at gennemse tilgængelige modeller fra pålidelige arkiver som Hugging Face. Download din valgte modelfil direkte til din lokale opsætning med garanteret hardwarekompatibilitet indbygget. Når den er konfigureret, kan du aktivere den lokale inferensserver, så du kan interagere med din model via enten den grafiske grænseflade eller kommandolinjen. Denne kraftfulde opsætning giver fleksibilitet til at eksperimentere med flere modeller, effektivt styre dit lokale LLM-økosystem og nyde alle fordelene ved lokal behandling uden nogen afhængighed af ekstern cloud-infrastruktur.

Opsætning af den lokale inferensserver

En lokal inferensserver er rygraden i at køre llms lokalt og giver dig mulighed for at implementere, administrere og interagere med dine valgte modeller i et dramatisk effektivt og sikkert miljø. Revolutionerende værktøjer som LM Studio og Ollama gør opsætningen af en lokal inferensserver utrolig strømlinet - selv brugere, der er helt nye inden for AI, kan opnå stærke resultater. For at frigøre dette potentiale skal du blot vælge den ønskede modelfil og konfigurere vigtige parametre som f.eks. kontekstlængde, og når det er tilgængeligt, skal du aktivere GPU-acceleration for at opnå eksplosive præstationsgevinster.

Ollama leverer avancerede funktioner som GPU-acceleration, som dramatisk kan accelerere modelinferens på kompatibel hardware - og helt ændre dit workflow. Du får fuld kontrol ved at angive den nøjagtige port til din inferensserver, hvilket gør den ubesværet tilgængelig via web-ui eller problemfri integration med andre applikationer for maksimal fleksibilitet. LM Studio tilbyder en lige så strømlinet opsætning, der giver dig mulighed for at administrere modeller og serverindstillinger via en intuitiv, brugervenlig grænseflade. Når din lokale inferensserver er i drift, har du et kraftfuldt, helt privat miljø til at køre llms lokalt og udnytte de fulde, ubegrænsede muligheder i dine valgte modeller.

Lokal kørsel af LLM'er med populære værktøjer

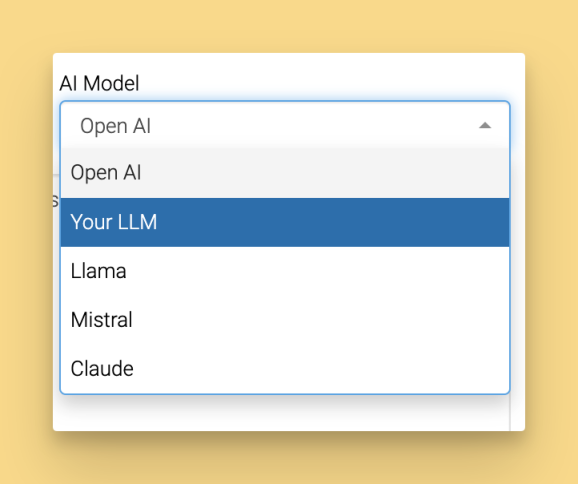

At vælge det rigtige værktøj er nøglen til at få en problemfri oplevelse, når du kører llms lokalt. LM Studio, Ollama og GPT4All er blandt de mest pålidelige løsninger, som hver især leverer unikke funktioner, der er designet til at passe til dine specifikke workflow-behov. LM Studio styrker dig med sin intuitive grafiske grænseflade, der gør det nemt for dig at administrere flere modeller, skifte mellem dem uden problemer og finjustere indstillingerne for at opnå optimale resultater, der betyder noget for dine projekter. For dem, der trives i terminalmiljøer, leverer Ollama en robust kommandolinjeoplevelse, der understøtter dine avancerede arbejdsgange og integreres fejlfrit med dit udviklingsøkosystem.

GPT4All er endnu et stærkt valg i din værktøjskasse, som understøtter et stort udvalg af modeller - herunder populære modeller som Mistral 7B - og samtidig giver dig en strømlinet grænseflade til at interagere med din lokale ai. Disse platforme kører ikke bare modeller; de giver dig mulighed for at opsætte api-servere uden besvær, hvilket muliggør problemfri integration med dine eksisterende applikationer og tjenester. Uanset om du administrerer flere modeller, eksperimenterer med finjustering eller lige er begyndt på din rejse med local llms, giver disse platforme dig den fleksibilitet og kraft, du har brug for til at maksimere dit local ai-potentiale.

Oprettelse af en lokal API-server

Opsætning af en lokal api-server er den ultimative game-changer for alle, der ønsker at revolutionere deres integration af store sprogmodeller i applikationer og workflows! Med kraftfulde værktøjer som LM Studio og Ollama bliver det utroligt ligetil at oprette din personlige lokale api-server: Du skal blot angive din valgte modelfil, indstille din sikre api-nøgle for maksimal beskyttelse og konfigurere serveren til at køre på din foretrukne port. Denne banebrydende opsætning giver dig mulighed for at få adgang til dine modeller via et intuitivt web-ui eller programmatisk via api-serveren, hvilket åbner op for ubegrænsede praktiske anvendelser, der forvandler din måde at arbejde på.

Ollama leverer problemfri api-serverintegration lige ud af boksen, hvilket gør det ubesværet at forbinde din lokale llms med andre værktøjer og platforme for maksimal effektivitet. LM Studio tilbyder lige så imponerende muligheder, så du kan administrere din lokale api-server gennem en smuk brugervenlig grænseflade, der giver dig fuld kontrol. Ved at oprette din egen lokale api-server får du uovertruffen fleksibilitet til at implementere modeller i virkelige scenarier, automatisere komplekse opgaver og opbygge tilpassede løsninger, der passer perfekt til dine behov - alt sammen mens dine værdifulde data er helt sikre og under din absolutte kontrol. Uanset om du udvikler banebrydende applikationer eller forbedrer eksisterende arbejdsgange, er en lokal api-server din nøgle til at frigøre det ekstraordinære potentiale i din lokale ai-infrastruktur.