LLM'ler Yerel Olarak Nasıl Çalıştırılır? Kendi Kendine Barındırılan YZ Modelleri için Eksiksiz 2025 Kılavuzu

Bu YAPAY ZEKA devrim gerçekleşiyor, ancak bundan faydalanmak için hassas verilerinizi bulut hizmetlerine göndermenize veya aylık abonelik ücretleri ödemenize gerek yok. Büyük dil modellerini kendi bilgisayarınızda yerel olarak çalıştırmak, mutlak gizliliği korurken ve devam eden maliyetleri ortadan kaldırırken yapay zeka etkileşimleriniz üzerinde tam kontrol sahibi olmanızı sağlar.

Bu kapsamlı kılavuzda, doğru araçları ve modelleri seçmekten donanımınızdaki performansı optimize etmeye kadar llms'yi yerel olarak çalıştırmak için ihtiyacınız olan her şeyi keşfedeceksiniz. İster kodlama yardımı arayan bir geliştirici olun, ister bir işletme koruyan hassas veriler veya çevrimdışı erişim isteyen bir yapay zeka meraklısı için yerel llm'ler, bulut tabanlı alternatiflere göre cazip avantajlar sunar.

2025'e yönelik en iyi araçları, bütçenizi sarsmayacak donanım gereksinimlerini ve banka, ve ilk yerel llm'nizi dakikalar içinde çalıştırmak için adım adım öğreticiler. Sonunda, gizliliğinizden veya bütçenizden ödün vermeden son teknoloji dil modellerinin gücünden nasıl yararlanacağınızı anlayacaksınız.

Ne Öğreneceksiniz

- “LLM'leri yerel olarak çalıştırmak” ne anlama gelir ve nasıl çalışır?

- Kendi kendine barındırılan yapay zeka ile bulut yapay zekanın avantajları

- 2025'in en iyi araçları (LM Studio, Ollama, GPT4All, Jan, llamafile, llama.cpp)

- 2B'den 70B+ parametrelere kadar modeller için donanım gereksinimleri

- İlk modelinizi nasıl kurar ve çalıştırırsınız

- Güvenli bir yerel API sunucusu nasıl oluşturulur?

- Kişisel ve ticari iş akışları için gerçek dünya kullanım örnekleri

- Performans ipuçları, sorun giderme ve maliyet karşılaştırmaları

Büyük Dil Modellerine Giriş

Büyük dil modelleri (LLM'ler) devrim niteliğindedir yapay zeka teknoloji ile etkileşiminizi dönüştüren, insan dilini anlamak, üretmek ve benzeri görülmemiş bir karmaşıklıkla manipüle etmek için tasarlanmış sistemler. Devasa metin veri kümeleri üzerinde eğitim alarak, bu ezber bozan büyük dil modelleri, iş akışınızda devrim yaratan tutarlı, bağlama duyarlı yanıtlar sunarak, sohbet robotları ve sanal asistanlardan dil çevirisine, metin özetlemeye ve kullanıcıları memnun eden ve sonuçları yönlendiren yaratıcı içerik oluşturmaya kadar inanılmaz bir uygulama yelpazesi için kesinlikle gerekli hale getirir.

Büyük dil modellerini kendi bilgisayarınızda yerel olarak çalıştırmak, bulut hizmetlerinin sağlayamayacağı olağanüstü avantajlar sunar. LLM'leri yerel olarak çalıştırdığınızda, hassas verileriniz üzerinde tam kontrol sahibi olursunuz ve gizli bilgilerin cihazınızdan asla çıkmamasını sağlayarak güven oluşturan gizlilik öncelikli bir yaklaşıma sahip olursunuz. Bu güçlü strateji yalnızca güvenliği ve gönül rahatlığını artırmakla kalmaz, aynı zamanda harici sağlayıcılara bağımlılığı ortadan kaldırır ve yinelenen abonelik ücretlerini sıfıra indirir. Sonuç olarak, akıllı bireyler ve ileri görüşlü kuruluşlar LLM'leri yerel olarak çalıştırmayı tercih ediyor ve güvenlikten ödün vermeden veya devam eden maliyetleri düşürmeden iş otomasyonundan kişisel üretkenliğe kadar her şey için bu modellerin tüm gücünden yararlanıyor.

İster en yeni modelleri denemek, ister başarınızı ölçeklendiren özel yapay zeka destekli araçlar oluşturmak, ister sadece daha özel ve ışık hızında bir yapay zeka deneyimi aramak konusunda tutkulu olun, LLM'leri yerel olarak çalıştırmak, son teknoloji dil modellerinin yeteneklerini doğrudan elinize vererek daha hızlı yenilik yapmanızı, güvende kalmanızı ve olağanüstü sonuçlar sunmanızı sağlar.

LLM'lerin Yerel Olarak Yürütülmesi Ne Anlama Geliyor?

Büyük dil modellerini yerel olarak çalıştırmak, gelişmiş yapay zeka modellerini ChatGPT, Claude veya Gemini gibi bulut hizmetlerine güvenmek yerine doğrudan kendi bilgisayarınızda veya yerel makinenizde çalıştırmak anlamına gelir. llm'yi yerel olarak çalıştırdığınızda, tüm çıkarım süreci kendi donanımınızda gerçekleşir ve internet üzerinden harici sunuculara veri aktarılmaz.

Yerel llms'in temel avantajları arasında tam veri gizliliği, ilk kurulumdan sonra sıfır abonelik maliyeti ve internet bağlantısı olmadan çalışan çevrimdışı işlevsellik yer alır. Hassas verileriniz cihazınızdan asla çıkmaz, bu da yerel çıkarımı gizli bilgileri işleyen işletmeler, özel kod üzerinde çalışan geliştiriciler veya gizlilik konusunda endişeli bireyler için özellikle değerli kılar.

API anahtarları gerektiren ve istek başına ücret alan bulut tabanlı yapay zeka hizmetlerinin aksine yerel modeller, modeli GitHub veya Hugging Face gibi depolardan veya kaynaklardan indirip model dosyasını bilgisayarınıza kaydettiğinizde sınırsız kullanım sağlar. Bu, öngörülebilir maliyetler yaratır ve API ücret sınırları veya iş akışınızı etkileyen hizmet kesintileri ile ilgili endişeleri ortadan kaldırır.

Pratik bir karşılaştırma farkı göstermektedir: ChatGPT kullanırken, sorularınız yanıtları döndürmeden önce işlenmek üzere OpenAI'nin sunucularına gider. Makinenizde çalışan Llama 3.2 gibi yerel bir llm ile her şey tüketici donanımınızda gerçekleşir. Bulut hizmetleri kolaylık ve son teknoloji modeller sunarken, yerel yapay zeka birçok kullanıcının cazip bulduğu gizlilik, kontrol ve maliyet öngörülebilirliği sağlar.

Yaygın yanlış inanışlar arasında llms'yi yerel olarak çalıştırmanın pahalı GPU donanımı veya karmaşık teknik kurulum gerektirdiğine dair inanışlar yer almaktadır. LM Studio ve GPT4All gibi modern araçlar süreci önemli ölçüde basitleştirmiştir ve birçok küçük model yeterli RAM'e sahip standart masaüstü bilgisayarlarda etkili bir şekilde çalışmaktadır.

Yerel Ortamın Kurulması

Yerel llms ile çalışmaya başlamak, bilgisayarınızı parmaklarınızın ucunda olağanüstü performans sunan güçlü bir yapay zeka güç merkezine dönüştürmekle başlar. İlk adım, Windows, macOS veya Linux işletim sisteminizin LM Studio, Ollama veya GPT4All gibi yararlanacağınız son teknoloji araçlar için mükemmel bir temel oluşturmasını sağlamaktır. Oyunun kurallarını değiştiren bu platformların her biri, yerel modelleri yönetmek ve bunlarla etkileşim kurmak için kolaylaştırılmış, kullanıcı dostu bir yaklaşım sunarak gelişmiş yapay zekayı herkes için erişilebilir hale getiriyor. yapay zeka dünyası.

Ardından, inanılmaz performans kazanımlarının kilidini açmak için donanım potansiyelinizi en üst düzeye çıkarmak isteyeceksiniz. Birçok küçük model standart masaüstü veya dizüstü bilgisayarlarda etkileyici sonuçlar sunarken, modern bir CPU, yeterli RAM ve ideal olarak özel bir GPU'ya sahip olmak deneyiminizi güçlendirecek ve daha büyük, daha sofistike modelleri olağanüstü bir akıcılıkla çalıştırmanızı sağlayacaktır. Sisteminizin seçtiğiniz araç ve model için minimum gereksinimleri karşıladığından emin olarak, kendinizi benzersiz AI yetenekleri için hazırlarsınız.

Donanımınız ve işletim sisteminiz mükemmel bir şekilde hizalandıktan sonra, tercih ettiğiniz aracı kurabilir ve sihrin gerçekleşmesini izleyebilirsiniz. Örneğin LM Studio, model yönetimini zahmetsizce basitleştiren sezgisel bir grafik arayüz sağlarken, Ollama geliştiricileri gelişmiş kontrolle güçlendiren bir komut satırı deneyimi sunar. Kurulumdan sonra, uyumlu modellere doğrudan yerel makinenizde göz atma, indirme ve çalıştırma özgürlüğüne sahip olacaksınız, bu da size AI deneyiminiz üzerinde tam kontrol sağlar.

Doğru aracı dikkatlice seçerek ve ortamınızın ustalıkla yapılandırılmasını sağlayarak, llms'yi yerel olarak çalıştırmak ve yapay zekadaki en son gelişmelerin tüm gücünden yararlanmak için ihtiyacınız olan her şeyle donatılmış olacaksınız. Sadece yerel yapay zeka yeteneklerine sahip olmakla kalmaz, yapay zeka ile çalışma şeklinizi dönüştüren tam bağımsızlık, gelişmiş gizlilik ve ışık hızında performans elde edersiniz.

Hızlı Başlangıç: 2025'te LLM'leri Yerel Olarak Yürütmek için En İyi Araçlar

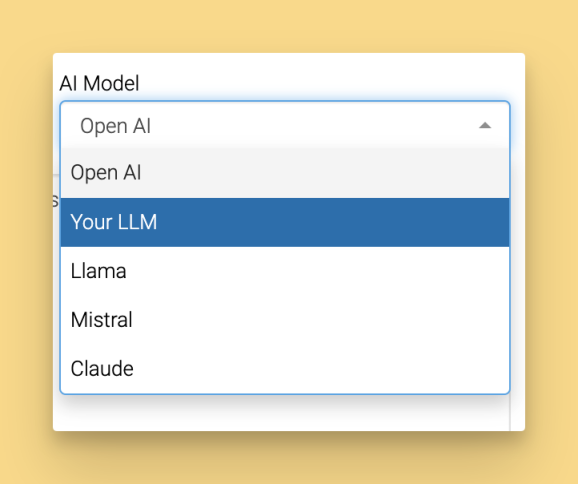

Yerel llm'leri çalıştırmak için kullanılan araçlar önemli ölçüde olgunlaştı ve çoğu teknik engeli ortadan kaldıran kullanıcı dostu seçenekler sunuyor. İşte yerel kullanım için Llama ve DeepSeek R1 gibi popüler modellere erişim de dahil olmak üzere, modelleri yerel olarak çalıştırmayı her beceri düzeyindeki kullanıcılar için erişilebilir kılan ilk beş platform:

LM Studio, sezgisel grafik arayüzü ve yerleşik model tarayıcısı ile en acemi dostu seçenek olarak öne çıkıyor. Şu adresten indirin lmstudio.ai ve Windows 11, macOS Ventura+ ve Ubuntu 22.04+ üzerinde sorunsuz model yönetiminin keyfini çıkarın.

GPT4All, LocalDocs özelliği aracılığıyla mükemmel belge sohbet yetenekleriyle gizlilik öncelikli yapay zekaya odaklanır. Tüm büyük işletim sistemleri için gpt4all.io adresinde mevcut olan sistem, 50'den fazla uyumlu model ile seçilmiş bir model pazarı sunuyor.

Jan, genişletilebilir mimarisi ve hibrit yerel/bulut özellikleriyle ChatGPT'ye açık kaynaklı bir alternatif sunar. Başlamak için jan.ai özel uzantılar ve uzaktan API entegrasyonu desteği ile.

Ollama, basit model yönetimi ve mükemmel API entegrasyonu sunarak geliştiriciler için tercih edilen komut satırı aracı olarak hizmet vermektedir. Ollama'nın kurulumu basittir: işletim sisteminiz için yükleyiciyi indirin ve çalıştırın, ardından kurulumu tamamlamak için istemleri izleyin. Ollama'yı kurduktan sonra, modelleri yönetmek ve çalıştırmak için komut satırı aracını kullanabilirsiniz. Önemli bir özellik, belirli modelleri anında kullanmak üzere doğrudan terminalden indirmenize veya güncellemenize olanak tanıyan çekme komutudur.

llamafile, kurulum gerektirmeden her yerde çalışan tek dosyalı yürütülebilir dosyalar aracılığıyla taşınabilir yapay zeka sunar. Minimum kurulumun çok önemli olduğu hızlı test veya dağıtım senaryoları için mükemmeldir.

Yeni başlayanlar için LM Studio, görsel arayüzü ve otomatik GPU hızlandırması ile en sorunsuz başlangıç deneyimini sağlar. Geliştiriciler genellikle esnekliği ve mevcut geliştirme iş akışlarıyla entegrasyon yetenekleri nedeniyle Ollama'yı tercih eder.

Bu araçlar hem yeni başlayanlar hem de ileri düzey kullanıcılar için kullanıcı dostu bir deneyim sağlamak üzere tasarlanmıştır.

Yerel LLM'ler için Donanım Gereksinimleri

Donanım gereksinimlerini anlamak, sisteminiz için uygun modelleri seçmenize ve gerçekçi performans beklentileri belirlemenize yardımcı olur. İyi haber şu ki, modern yerel llm'ler mütevazı dizüstü bilgisayarlardan üst düzey iş istasyonlarına kadar çok çeşitli donanım yapılandırmalarında çalışır.

Daha küçük modelleri çalıştırmak için minimum özellikler arasında 16GB RAM, Intel i5-8400 veya AMD Ryzen 5 2600 gibi modern bir CPU ve en az 50GB kullanılabilir depolama alanı bulunur. Bu özellikler, çoğu kullanım durumu için kabul edilebilir performansla 7B parametresine kadar olan modelleri idare eder.

Optimum performans için önerilen özellikler arasında 8 GB video ram'li bir NVIDIA RTX 4060, 32 GB sistem RAM'i ve birden fazla model için 100 GB+ depolama alanı bulunur. Bu yapılandırma, daha büyük modeller için sorunsuz çıkarım sağlar ve aynı anda birden fazla modelin çalıştırılmasına olanak tanır.

Depolama gereksinimleri model boyutuna göre değişir: Phi-3-mini gibi daha küçük modeller 2-4GB gerektirirken, Llama 3.1 70B gibi daha büyük modeller nicelemeye bağlı olarak 40-80GB'a ihtiyaç duyar. Sınırlı kaynaklarınız varsa, depolama ve bellek kullanımını en aza indirmek için Gemma 2B Instruct gibi mevcut en küçük modeli indirmek isteyebilirsiniz. Farklı boyutlarda birden fazla modelle deneme yapmak istiyorsanız 50-100 GB için plan yapın.

İşte farklı donanım yapılandırmaları için saniye başına jetonları gösteren bir performans karşılaştırması:

Donanım Yapılandırması | Phi-3-mini (3B) | Llama 3.1 8B | Mistral 7B | Kod Llama 34B |

|---|---|---|---|---|

Yalnızca CPU (16GB RAM) | 8-12 belirteç/sn | 4-6 belirteç/sn | 3-5 belirteç/sn | Tavsiye edilmez |

RTX 4060 (8GB VRAM) | 45-60 belirteç/sn | 25-35 belirteç/sn | 30-40 belirteç/sn | 8-12 belirteç/sn |

RTX 4090 (24GB VRAM) | 80-120 belirteç/sn | 60-80 belirteç/sn | 70-90 belirteç/sn | 35-45 belirteç/sn |

Apple M2 Pro (32GB) | 35-50 belirteç/sn | 20-30 belirteç/sn | 25-35 belirteç/sn | 15-20 belirteç/sn |

GPU hızlandırma performansı önemli ölçüde artırır, ancak GPU kaynakları mevcut olmadığında daha küçük modeller için yalnızca CPU çıkarımı uygulanabilir kalır. En iyi performans, model boyutunu mevcut video ram'iniz veya sistem RAM'inizle eşleştirmekten gelir.

Yerel Olarak Çalıştırılacak En İyi Açık Kaynak Modelleri

Doğru modeli seçmek donanım kapasitenize, kullanım amaçlarınıza ve kalite gereksinimlerinize bağlıdır. Açık kaynak modelleri, yerel dağıtım için erişilebilir kalırken etkileyici kalite seviyelerine ulaşmıştır. Ollama ve llama.cpp gibi açık kaynak llm projelerinin büyüyen manzarası, topluluk odaklı geliştirmenin gücünü ve önde gelen AI kuruluşları tarafından yayınlanan modellerin artan kullanılabilirliğini vurgulamaktadır.

Küçük modeller (8GB'ın altında) temel görevler için mükemmel verimlilik sunar:

- Phi-3-mini (3.8B parametre), sınırlı ram senaryoları için ideal olan 2.3GB'lık kompakt bir pakette güçlü muhakeme yetenekleri sağlar

- Gemma 2B, Google'ın eğitim kalitesini ultra hafif 1,4 GB model dosyada sunuyor

- Llama 3.2 3B, dengeli performans ve verimlilik ile Meta'nın en son mimari optimizasyonlarını sunar

Orta modeller (8-16 GB), kapasite ve kaynak gereksinimleri arasında en iyi dengeyi kurar:

- Llama 3.1 8B, güçlü muhakeme ve kod üretimi ile genel amaçlı görevler için altın standart olarak hizmet vermektedir

- Mistral 7B, talimatları tam olarak takip etme ve karmaşık muhakeme görevlerini yerine getirme konusunda mükemmeldir

- DeepSeek-Coder 6.7B, 80'den fazla programlama dilini destekleyerek kod üretiminde uzmanlaşmıştır

Büyük modeller (16GB+) yeterli donanıma sahip kullanıcılar için maksimum kapasite sağlar:

- Llama 3.1 70B, karmaşık muhakeme ve analiz görevleri için GPT-4 sınıfı performans sunar

- Code Llama 34B, yazılım mühendisliği kavramlarını derinlemesine anlayarak olağanüstü kodlama yardımı sunar

Tüm modeller “microsoft/Phi-3-mini-4k-instruct” veya “meta-llama/Meta-Llama-3.1-8B-Instruct” gibi model kimlikleriyle Hugging Face üzerinden temin edilebilir. Performans kıyaslamaları, 8B parametreli modellerin çoğu kullanıcı için tipik olarak en iyi değer teklifini sunduğunu ve önemli ölçüde daha az kaynak gerektirirken daha büyük model kapasitesinin 85-90%'sini sunduğunu göstermektedir.

LM Stüdyo: Başlamanın En Kolay Yolu

LM Studio, teknik karmaşıklığı ortadan kaldıran kullanıcı dostu bir grafik arayüz sağlayarak yerel yapay zeka erişilebilirliğinde devrim yaratıyor. LM Studio ve benzeri araçlar, model yönetimini ve etkileşimini basitleştiren grafik ve web tabanlı seçenekler de dahil olmak üzere kullanıcı arayüzleri sunar. LM Studio ayrıca kullanışlı bir web ui, kullanıcıların modelleri doğrudan tarayıcılarından yönetmelerine ve etkileşimde bulunmalarına olanak tanır. Bu, llms'yi yerel olarak çalıştırmaya yeni başlayan kullanıcılar için ideal bir başlangıç noktasıdır.

LM Studio'yu şu adresten indirerek başlayın lmstudio.ai ve işletim sisteminiz için basit kurulum sürecini takip edin. Yükleyici, uyumlu donanım algılandığında GPU hızlandırmayı otomatik olarak yapılandırarak manuel sürücü yapılandırmasını ortadan kaldırır. Kurulumdan sonra, ana arayüze erişmek ve mevcut modelleri keşfetmeye başlamak için LM Studio'yu başlatın.

Ana arayüz üç temel bölüm sunar: Mevcut modellere göz atmak için Keşfet, indirilen modelleri yönetmek için Modellerim ve yüklü modellerle etkileşim için Sohbet. Keşfet sekmesinde, gereksinimlerinize göre belirli modelleri hızlı bir şekilde bulmak için arama çubuğunu kullanın. Yerleşik model kütüphanesi, net açıklamalara ve donanım gereksinimlerine sahip yüksek kaliteli açık kaynak modellerini derler.

Sohbet arayüzünün kurulumu, indirilen bir modelin yüklenmesini ve sıcaklık ve bağlam uzunluğu gibi üretim parametrelerinin ayarlanmasını içerir. Arayüz, her ayar için sezgisel kaydırıcılar ve açıklamalar sağlayarak, teknik olmayan kullanıcılar için deneyleri erişilebilir hale getirir.

Geliştiriciler için LM Studio, OpenAI uyumlu uç noktaları ortaya çıkaran yerel bir api sunucusu içerir. Yerel modelleri OpenAI'nin API formatını destekleyen mevcut uygulamalarla entegre etmek için ayarlardan bu özelliği etkinleştirin.

LM Studio'da İlk Modelinizi Kurma

Uyumlu modellerin aranabilir bir kütüphanesini bulacağınız Keşfet sekmesine gidin. Meta'nın mütevazı donanımlarda iyi çalışan verimli 3B parametre modelini bulmak için “llama-3.2-3b-instruct” araması yapın.

İşlemi başlatmak için indirme düğmesine tıklayın. LM Studio, indirme hızını ve tahmini tamamlanma süresini gösteren ilerleme göstergelerini görüntüler. İndirme yöneticisi, ağ bağlantısı geri geldiğinde kısmi indirmeleri devam ettirerek kesintileri zarif bir şekilde ele alır.

İndirme işlemi tamamlandığında, model Modellerim bölümünüzde görünür. İndirilen model dosyaları kolay erişim ve yükleme için yönetilir ve saklanır. Belleğe yüklemek için tıklayın, bu işlem model boyutuna ve depolama hızına bağlı olarak genellikle 10-30 saniye sürer. Arayüz bellek kullanımını gösterir ve modelin etkileşime hazır olduğunu onaylar.

Kurulumunuzu “Kuantum hesaplamayı basit terimlerle açıklayın” veya “Fibonacci sayılarını hesaplamak için bir Python işlevi yazın” gibi örnek istemlerle test edin. Model, başarılı kurulumu onaylayarak saniyeler içinde yanıt vermelidir.

İndirme hataları için yaygın sorun giderme yöntemleri arasında kullanılabilir disk alanını kontrol etmek, internet bağlantısının kararlılığını doğrulamak ve güvenlik duvarınızın LM Studio ağ erişimine izin verdiğinden emin olmak yer alır. Yerleşik günlükler, sorunları çözmek için ayrıntılı hata bilgileri sağlar.

GPT4All: Gizlilik Odaklı Yerel Yapay Zeka

GPT4All gizlilik ve kullanım kolaylığını vurgulayarak veri güvenliğine öncelik veren kullanıcılar için mükemmel bir seçimdir. Uygulama, modeller indirildikten sonra tamamen çevrimdışı çalışır ve konuşmalarınızın cihazınızdan hiç çıkmamasını sağlar.

GPT4All'u gpt4all.io adresinden indirin ve Windows, macOS veya Linux'a yükleyin. Kurulum işlemi, anında işlevsellik sağlamak için otomatik olarak bir başlangıç modeli indirir. İlk açılışta sohbet, modeller ve ayarlar arasında net bir gezinme sağlayan temiz bir arayüz sunulur. Kurulumdan sonra, modellerden soruları yanıtlama veya içerik oluşturma gibi çeşitli görevler için metin oluşturmalarını isteyebilirsiniz.

Model pazarı, ayrıntılı açıklamalar, donanım gereksinimleri ve kullanıcı derecelendirmeleri içeren 50'den fazla seçilmiş model sunar. Modeller, boyut ve uzmanlık alanlarına göre kategorize edilerek kullanıcıların kullanım durumları ve donanım kısıtlamaları için uygun seçenekleri seçmelerine yardımcı olur.

GPU hızlandırma kurulumu platforma göre değişir ancak genellikle NVIDIA grafik kartları için CUDA sürücülerinin yüklenmesini veya macOS'ta Metal desteğinin sağlanmasını içerir. Ayarlar paneli, uyumlu donanım yapılandırmaları için net talimatlar ve otomatik algılama sağlar.

LocalDocs'u Belge Sohbeti için Ayarlama

LocalDocs, GPT4All'un öne çıkan özelliğini temsil eder ve içeriği harici sunuculara yüklemeden kişisel belgelerinizle özel görüşmelere olanak tanır. Bu işlevsellik, yerel llm'leri güçlü araştırma ve analiz araçlarına dönüştürür.

LocalDocs'a özel sekme aracılığıyla erişin ve PDF'ler, metin dosyaları, markdown belgeleri veya kod havuzları içeren yerel klasörler ekleyin. Sistem .pdf, .txt, .md, .docx ve kaynak kod dosyaları gibi yaygın formatları destekler.

İndeksleme işlemi, cihazınızda yerel olarak depolanan aranabilir katıştırmalar oluşturmak için belge içeriklerini analiz eder. İndeksleme süresi belge hacmine bağlıdır ancak genellikle yüzlerce sayfayı dakikalar içinde işler. İlerleme göstergeleri tamamlanma durumunu ve tahmini kalan süreyi gösterir.

İndekslenmiş belgelere yönelik örnek sorgular arasında “Araştırma makalelerimdeki temel bulguları özetleyin” veya “Projelerimde en sık hangi kodlama kalıpları görülüyor?” yer alabilir. Sistem, yanıtları oluşturmadan önce ilgili belge bölümlerini alır ve kaynaklarla temellendirilmiş yanıtlar sağlar. alıntılar.

Gizlilik avantajları arasında harici hizmetlere veri aktarımı olmadan tam çevrimdışı işleme yer alır. Belgeleriniz tüm süreç boyunca yerel makinenizde kalır, bu da LocalDocs'u gizli iş belgeleri veya kişisel araştırma materyalleri için uygun hale getirir.

Jan: Açık Kaynak ChatGPT Alternatifi

Jan kendisini ticari yapay zeka sohbet hizmetlerine kapsamlı bir açık kaynak alternatifi olarak konumlandırıyor ve açık kaynak geliştirme esnekliği ile tanıdık arayüzler sunuyor. Platform, maksimum esneklik için hem yerel çıkarımı hem de hibrit bulut entegrasyonunu destekliyor.

Kurulumdan jan.ai yeterli RAM ve depolama alanı dahil olmak üzere sistem gereksinimlerinin doğrulanmasını gerektirir. Yükleyici, donanım özelliklerini otomatik olarak algılar ve özel kurulumunuz için en uygun yapılandırma ayarlarını önerir.

Arayüz turu, modern kullanıcı arayüzü öğeleri ve sezgisel navigasyon ile ChatGPT'den ilham alan bir tasarımı ortaya koyuyor. Görüşme geçmişi, model değiştirme ve ayarlara erişim, ticari hizmetlerden geçiş yapan kullanıcılar için öğrenme eğrilerini azaltan tanıdık kalıpları takip eder.

Model içe aktarma özellikleri, LM Studio veya Ollama gibi diğer araçlardan modellerin getirilmesine izin vererek gereksiz indirmeleri önler. Jan, yerel veya hibrit kullanım için uyumlu herhangi bir büyük dil modelinin içe aktarılmasını destekler. Sistem, uyumlu model formatlarını otomatik olarak algılar ve optimum performans için bunları gerektiği şekilde dönüştürür.

Eklenti pazarı, gelişmiş model yönetimi, özel sohbet modları ve harici araç ve hizmetlerle entegrasyon gibi alanları kapsayan topluluk tarafından geliştirilen eklentiler aracılığıyla işlevsellik ekler.

Uzaktan API entegrasyonu, bazı taleplerin yerel modelleri kullandığı, diğerlerinin ise karmaşıklık veya performans gereksinimlerine göre bulut hizmetlerinden yararlandığı hibrit dağıtımlara olanak tanır. Bu yaklaşım, hassas görevler için yerel yetenekleri korurken maliyetleri optimize eder.

Ollama: Geliştirici Dostu Komut Satırı Aracı

Ollama, özellikle programatik kontrol ve entegrasyon yeteneklerini tercih eden geliştiriciler için tasarlanmış bir komut satırı aracı olarak mükemmeldir. Basit ancak güçlü arayüzü, teknik kullanıcılar için model yönetimini ve dağıtımını kolaylaştırır.

Kurulum işletim sistemine göre değişir ancak genellikle macOS'ta Homebrew (brew install ollama), Ubuntu'da apt (sudo apt install ollama) veya Windows'ta winget (winget install ollama) gibi paket yöneticileri kullanılır. Bu yöntemler uygun bağımlılık yönetimi ve sistem entegrasyonu sağlar.

Kurulumdan sonra, kullanıcılar modelleri indirmek, çalıştırmak ve yönetmek için belirli terminal komutları aracılığıyla Ollama ile etkileşime girebilir ve bu da tamamen komut satırından çalışmayı kolaylaştırır.

Temel komutlar kapsamlı model yaşam döngüsü yönetimi sağlar:

- ollama pull llama3.1:8b resmi kütüphaneden modelleri indirir

- ollama run llama3.1:8b belirtilen modellerle etkileşimli sohbet oturumları başlatır

- ollama listesi, kurulu tüm modelleri boyutları ve değişiklik tarihleriyle birlikte görüntüler

- ollama rm model-adı, depolama alanını boşaltmak için modelleri kaldırır

Ollama, diğer uygulamalarla entegrasyon için modelleri yerel olarak barındırmanıza ve sunmanıza olanak tanıyan yerel bir sunucu veya yerel çıkarım sunucusu olarak yapılandırılabilir. Bu kurulum kolay özelleştirme, gelişmiş performans ve sorunsuz sorun giderme desteği sağlar.

Modelfile aracılığıyla özel modeller oluşturmak, model davranışına, sistem istemlerine ve parametrelere ince ayar yapılmasını sağlar. Bu metin tabanlı yapılandırma yaklaşımı, sürüm kontrolü ve otomasyon iş akışlarıyla iyi bir şekilde entegre olur.

Geliştirme araçlarıyla entegrasyon, VS Code gibi popüler IDE'ler için eklentiler içerir ve doğrudan geliştirme ortamlarında kod oluşturmaya ve analiz etmeye olanak tanır. Standartlaştırılmış API formatı, mevcut uygulamalar ve hizmetlerle entegrasyonu kolaylaştırır.

Ollama ile Çoklu Model Çalıştırma

Ollama'nın mimarisi eşzamanlı model yürütmeyi destekleyerek farklı modellerin aynı anda özel görevlere hizmet etmesini sağlar. Bu özellik, daha küçük modellerin temel görevleri yerine getirdiği, daha büyük modellerin ise karmaşık muhakemeleri ele aldığı sofistike iş akışlarına olanak tanır.

Modeller arasında geçiş yapmak için ayrı terminal oturumlarında ollama run mistral:7b ve ardından ollama run codellama:7b gibi basit komut sözdizimi gerekir. Her model bağımsız konuşma bağlamını ve bellek tahsisini korur.

Bellek yönetimi, mevcut sistem kaynaklarına ve model gereksinimlerine göre kaynak tahsisini otomatik olarak gerçekleştirir. Sistem, bellek kısıtlamalarının performansı etkileyebileceği durumlarda uyarılar sağlar ve optimizasyon stratejileri önerir.

ollama serve aracılığıyla API sunucusu kurulumu, modelleri OpenAI formatıyla uyumlu HTTP uç noktaları aracılığıyla sunar. Bu, tamamen yerel altyapı üzerinde çalışan bulut yapay zeka hizmetleri için tasarlanmış uygulamalarla sorunsuz entegrasyon sağlar.

Docker dağıtımı, resmi Ollama konteynerleri aracılığıyla üretim ortamlarını kolaylaştırır. Konteynerleştirilmiş yaklaşım, bağımlılık yönetimini basitleştirirken geliştirme, hazırlama ve üretim ortamlarında tutarlı davranış sağlar.

Gelişmiş Araçlar: llama.cpp ve llamafile

Maksimum kontrol ve performans optimizasyonu arayan ileri düzey kullanıcılar, llama.cpp ve llamafile gibi daha düşük seviyeli araçlardan yararlanır. Modelleri llama.cpp ile çalıştırmak için kullanıcıların yerel dağıtım için gerekli format olan bir gguf model dosyası indirmeleri gerekir. Bu araçlar esneklik ve verimlilik için kolaylıktan ödün verir, bu da onları üretim dağıtımları ve özel gereksinimler için ideal hale getirir.

Kullanıcı dostu uygulamalar ile gelişmiş araçlar arasındaki karar özel ihtiyaçlara bağlıdır. Özel derleme seçenekleri, özel donanım desteği veya çıkarım motoru üzerinde tam kontrolün gerekli olduğu daha büyük sistemlere entegrasyon gerektiğinde gelişmiş araçları seçin. Kullanıcılar ayrıca belirli görevler veya etki alanları için ince ayarlı modeller çalıştırabilir ve gereksinimlerine göre uyarlanmış optimum performans elde edebilir.

GPU desteği ile llama.cpp derlemek, belirli donanım hedefleri için derleme sistemlerini yapılandırmayı gerektirir. CUDA desteği NVIDIA sürücüleri ve araç seti kurulumu gerektirir, Metal desteği Apple Silicon ile macOS'ta otomatik olarak çalışır ve OpenCL, satıcılar arasında daha geniş GPU uyumluluğu sağlar.

Gelişmiş araçlarla performans optimizasyonu, özel niceleme şemalarını, bellek eşleme optimizasyonlarını ve özel dikkat uygulamalarını içerir. Bu optimizasyonlar, genel amaçlı çözümlere kıyasla çıkarım hızını önemli ölçüde artırabilir ve bellek gereksinimlerini azaltabilir.

llamafile yürütülebilir dosyaları, modelleri ve çıkarım motorlarını kurulum gerektirmeden çalışan tek dosyalar halinde paketleyerek taşınabilir yapay zeka dağıtımı sağlar. Bu yaklaşım, geleneksel kurulum süreçlerinin uygulanabilir olmadığı veya arzu edilmediği dağıtım senaryolarını basitleştirir.

Gelişmiş araçlar aracılığıyla kullanılabilen model niceleme teknikleri, en yüksek performansı korurken model boyutunu azaltan 4 bit, 8 bit ve karışık hassasiyetli formatları içerir. Kullanıcılar, kendi özel kullanım durumları için en uygun dengeleri bulmak amacıyla farklı niceleme şemalarını deneyebilirler.

Yerel API Sunucusu Oluşturma

Yerel bir API sunucusu, llm modeliniz için nihai entegrasyon çözümünü sunar ve verileriniz ve altyapınız üzerinde tam kontrol sağlarken diğer uygulamalarla sorunsuz bağlantı sağlar. Hem LM Studio hem de Ollama, ister sezgisel grafik arayüzleri ister komut satırı hassasiyetini tercih edin, kurumsal düzeyde yetenekleri doğrudan ellerinize veren güçlü ve basit dağıtım seçenekleri sunar.

Başlamak, tercih ettiğiniz dağıtım stratejisini (LM Studio veya Ollama) seçmek ve altyapınıza kurmak anlamına gelir. Dağıtıldıktan sonra, donanım yeteneklerinize ve iş gereksinimlerinize mükemmel şekilde uyan llm modelini indirecek ve optimum kaynak kullanımı sağlayacaksınız. Bağlam uzunluğu gibi kritik performans parametrelerini yapılandırın ve sisteminiz desteklediğinde GPU hızlandırma özelliklerinin kilidini açarak uygulamalarınızın talep ettiği yüksek performanslı sonuçları sunun.

Yerel API sunucunuzu başlatmak daha kolay olamazdı: LM Studio, sezgisel bir ayarlar arayüzü aracılığıyla sunucu aktivasyonu sağlarken, Ollama maksimum operasyonel esneklik için terminal tabanlı kontrol sunar. API sunucunuz, uygulamalarınızdan gelen istekleri işlemeye ve oluşturulan metin yanıtlarını kurumsal düzeyde güvenilirlik ve hız ile sunmaya hazır özel bir bağlantı noktasında çalışır.

Yerel API sunucunuz çalışır durumdayken, tam veri güvenliğini korurken ve llm modelinizin tamamen kontrollü ortamınızda çalışmasını sağlarken, özel sohbet botları oluşturma, karmaşık iş akışlarını otomatikleştirme ve gelişmiş dil yeteneklerini doğrudan yazılım ekosisteminize entegre etme özgürlüğü kazanırsınız. Bu sadece teknik bir kurulumdan daha fazlasıdır; ölçeklenebilir, güvenli ve sofistike dil işleme yeteneklerine açılan kapınızdır.

Yerel LLM'nizi API Anahtarı ile Güvenli Hale Getirme

Yerel llm'nize erişimi güvence altına almak sadece gerekli değildir, aynı zamanda yapay zeka dağıtımınızı potansiyel bir güvenlik açığından kontrollü bir inovasyon kalesine dönüştüren temeldir. Birden fazla uygulama veya kullanıcıyı birbirine bağladığınızda, bir api anahtar sistemi uygulamak oyunun kurallarını değiştiren stratejiniz haline gelir ve yetkisiz erişimi uzak tutarken yalnızca yetkili taleplerin modelinizin gücünü ortaya çıkarmasını sağlar.

Yerel llm'nizin yeteneklerinden yararlanacak her uygulama veya kullanıcı için benzersiz api anahtarları oluşturarak güvenlik yaklaşımınızı dönüştürün. Bu dijital anahtarları değerli varlıklar gibi ortam değişkenlerinde veya şifrelenmiş yapılandırma dosyalarında saklayarak rekabet avantajınızı tehlikeye atabilecek herhangi bir kazara açığa çıkmayı önleyin. Yerel api sunucunuzu her bir istekte api anahtarı doğrulaması talep edecek şekilde yapılandırarak yetkisiz erişim girişimlerini daha kapınızı çalmadan engelleyen aşılmaz bir bariyer oluşturun.

Herhangi bir potansiyel ihlal riskini azaltmak için api anahtarlarınızı düzenli olarak döndürerek güvenlik stratejinizi yükseltin ve artık ihtiyaç duyulmayan veya tehlikeye girmiş olabilecek anahtarları iptal etmek için kararlı bir şekilde harekete geçin. Bu endüstri lideri uygulamaları benimseyerek sadece kontrolü elinizde tutmakla kalmaz, yerel llm'niz üzerinde tam bir hakimiyet kurarak hem değerli modelinizi hem de işlediği her hassas veri parçasını tavizsiz bir hassasiyetle korursunuz.

Pratik Uygulamalar ve Kullanım Örnekleri

llms'i yerel olarak çalıştırmak, profesyonel ve kişisel bağlamlarda çok sayıda pratik uygulama sağlar. Gizlilik, sınırsız kullanım ve çevrimdışı özelliklerin birleşimi, bulut hizmetlerinin sağlayamayacağı olanaklar sunar.

Kod oluşturma ve hata ayıklama, yerel yapay zeka için birincil kullanım durumlarını temsil eder. DeepSeek-Coder ve Code Llama gibi modeller, programlama bağlamlarını anlama, şablon kod üretme, karmaşık algoritmaları açıklama ve 80'den fazla programlama dilinde hata düzeltmeleri önerme konusunda mükemmeldir.

İçerik oluşturma iş akışları, yerel modellerin sınırsız üretim yeteneklerinden yararlanır. Blog gönderileri, e-postalar, pazarlama kopya ve sosyal medya içeriği API maliyetleri veya ücret sınırları olmadan yinelemeli olarak oluşturulabilir. Belirli yazı stilleri üzerinde yerel modellere ince ayar yapma yeteneği şunları ekler KİŞİSELLEŞTİRME bulut hizmetleri ile imkansız.

Veri analizi ve özetleme görevleri, yerel modellerin hassas bilgileri harici iletim olmadan işleme yeteneğinden yararlanır. Finansal raporlar, yasal belgeler, tıbbi kayıtlar ve özel araştırmalar tam gizlilik korunarak analiz edilebilir.

Harici hizmetler olmadan dil çevirisi, düzinelerce dil çiftini desteklerken hassas iletişimler için gizlilik sağlar. Yerel modeller teknik dokümantasyon çevirisi, çok dilli müşteri desteği ve uluslararası iş iletişimlerini tamamen çevrimdışı olarak gerçekleştirir.

Gerçek dünya örnekleri arasında belge analizi için yerel modeller kullanan hukuk firmaları, yapay zeka destekli kodlama asistanları uygulayan yazılım şirketleri ve kişiselleştirilmiş yazma araçları geliştiren içerik oluşturucular yer almaktadır. Bu çözümlerin her biri kullanıcının donanımında yerel olarak çalışarak gizlilik ve kontrol sağlar. Bu uygulamalar, yerel yapay zeka dağıtımının çok yönlülüğünü ve pratik değerini göstermektedir.

Performans Optimizasyonu ve Sorun Giderme

Yerel llm'lerden maksimum performans elde etmek için sistem kaynaklarını, model özelliklerini ve optimizasyon tekniklerini anlamak gerekir. Doğru yapılandırma, yanıt sürelerini önemli ölçüde iyileştirebilir ve mütevazı donanımlarda daha büyük modellere olanak sağlayabilir.

GPU hızlandırma kurulumu satıcıya göre farklılık gösterir ancak genellikle uygun sürücülerin yüklenmesini ve yazılımın mevcut donanımı tanıyacak şekilde yapılandırılmasını içerir. NVIDIA kullanıcıları CUDA araç seti kurulumuna ihtiyaç duyarken, AMD kullanıcıları desteklenen Linux dağıtımlarında ROCm kurulumuna ihtiyaç duyar.

Model niceleme, model parametrelerini daha düşük hassasiyet seviyelerinde depolayarak bellek gereksinimlerini azaltır. 4 bit niceleme, 95%+ kalitesini korurken model boyutunu tipik olarak 75% azaltır ve sınırlı video ram'li tüketici donanımlarında büyük modellerin erişilebilir olmasını sağlar.

Yaygın hata mesajları ve çözümleri şunlardır:

- “CUDA bellek yetersiz”: Model boyutunu küçültün, diğer uygulamaları kapatın veya CPU boşaltmayı etkinleştirin

- “Model yükleme başarısız oldu”: Model dosyası bütünlüğünü ve yeterli disk alanını doğrulayın

- “Yavaş çıkarım hızı”: GPU hızlandırma ayarlarını kontrol edin ve model nicelemeyi göz önünde bulundurun

Çıkarım sırasında kaynak izleme, darboğazların belirlenmesine ve yapılandırmaların optimize edilmesine yardımcı olur. Windows'ta Task Manager, macOS'ta Activity Monitor veya Linux'ta htop, model yürütme sırasında CPU kullanımı, bellek kullanımı ve GPU etkinlik modellerini ortaya çıkarır.

Sıcaklık ve örnekleme parametresi ayarları çıktı kalitesini ve hızını etkiler. Daha düşük sıcaklıklar daha tutarlı çıktılar üretirken, daha yüksek değerler yaratıcılığı artırır. Top-k ve top-p örnekleme parametreleri yanıt çeşitliliği ile tutarlılığı dengeler.

Bağlam uzunluğu optimizasyonu, bellek kullanımı ile konuşma kapasitesini dengeler. Daha uzun bağlamlar daha karmaşık etkileşimler sağlar ancak orantılı olarak daha fazla bellek gerektirir. Çoğu kullanım durumu 2048-4096 token bağlamlarıyla iyi çalışır.

Yerel LLM Kurulumu için En İyi Uygulamalar

Yerel llm'nizden maksimum değer elde etmek için hem en yüksek performansı hem de kurşun geçirmez güvenliği sağlayan bir kazanma stratejisine ihtiyacınız vardır. Benzersiz ihtiyaçlarınız için mükemmel modeli seçerek başlayın, donanım yetenekleriniz ve özel kullanım durumu gereksinimleriniz için ideal eşleşmeyi keşfetmek için model parametrelerini, boyut özelliklerini ve hedeflenen uygulamaları derinlemesine inceleyin.

Bağlam uzunluğu gibi kritik model parametrelerinde ince ayarlar yaparak ve mümkün olan her yerde GPU hızlandırmayı etkinleştirerek oyunun kurallarını değiştiren performans seviyelerine ulaşmak için kurulumunuzu güçlendirin. İşletim sisteminizin seçtiğiniz araçlar ve llm modelleriyle kusursuz uyumluluk sağladığından emin olurken, en yeni çığır açan özelliklerden ve son teknoloji güvenlik geliştirmelerinden yararlanmak için tüm sisteminizi ve yazılım yığınınızı güncel tutun.

Sistem kaynaklarınızı aktif olarak izleyerek, RAM ve GPU kullanımını takip ederek, özellikle daha büyük modelleri dağıtırken veya birden fazla modeli paralel olarak çalıştırırken performans engellerini önlemek için darboğazların önüne geçin. Model yönetimi ve ayar optimizasyonunu inanılmaz derecede basitleştiren zahmetsiz bir kullanıcı deneyimi için LM Studio veya GPT4All gibi sezgisel grafik arayüzlerle iş akışınızı dönüştürün.

En önemli şeyleri koruyun, hassas verileri her zaman yerel ortamınızda tutun ve gizli bilgileri internet kanalları üzerinden iletme riskini asla almayın. Özel uygulamanız için en uygun çözümü kullandığınızdan emin olmak için farklı modelleri sürekli olarak test edin ve değerlendirin ve gereksinimleriniz arttıkça ve geliştikçe ince ayar yapma veya yeni modellere geçme esnekliğini benimseyin.

Bu kanıtlanmış en iyi uygulamaları uygulayarak, güvenli, ışık hızında ve benzersiz gereksinimlerinizi aşan olağanüstü sonuçlar sunmak ve olağanüstü sonuçlar elde etmek için hassas bir şekilde kalibre edilmiş yerel bir llm ortamı oluşturacaksınız.

Maliyet Analizi: Yerel ve Bulut Yapay Zeka Hizmetleri

Yerel ve bulut yapay zeka hizmetlerinin ekonomisini anlamak, altyapı yatırımları hakkında bilinçli kararlar alınmasına yardımcı olur. Analiz, ön donanım maliyetlerini, devam eden giderleri ve kullanım modellerine dayalı başa baş hesaplamalarını içerir.

Yetenekli yerel ai sistemleri için ön donanım yatırımı, orta sınıf yapılandırmalar için $800-1.500 ile üst düzey kurulumlar için $3.000-5.000 arasında değişmektedir. Bu maliyetler modern CPU'ları, yeterli RAM'i, yetenekli GPU'ları ve birden fazla model için yeterli depolama alanını içerir.

Bulut yapay zeka hizmetleri için aylık abonelik maliyetleri büyük ölçüde değişmektedir: ChatGPT Plus $20/ay, Claude Pro $20/ay ve API kullanımı hacme bağlı olarak aylık $10-500+ arasında değişebilir. Kurumsal planlar genellikle kullanıcı başına aylık $100'ü aşıyor.

Başa baş analizi, orta ila ağır kullanıcıların donanım yatırımlarını genellikle 6-18 ay içinde geri kazandığını ortaya koymaktadır. Hassas verileri işleyen veya 7/24 erişilebilirliğe ihtiyaç duyan kullanıcılar, saf maliyet değerlendirmelerinden bağımsız olarak genellikle yerel altyapıyı haklı çıkarır.

Yerel modelleri sürekli çalıştırmak için gereken enerji maliyetleri, donanım verimliliğine ve yerel kamu hizmeti oranlarına bağlı olarak elektrik faturalarına aylık yaklaşık $30-100 ekler. Modern GPU'lar, boşta kalma süreleri boyunca tüketimi azaltan güç yönetimi özellikleri içerir.

2-3 yıllık toplam sahip olma maliyeti hesaplamaları genellikle yerel çözümleri tercih etmektedir:

- Orta ila yoğun yapay zeka kullanım alışkanlığına sahip kullanıcılar

- Veri gizliliği uyumluluğu gerektiren kuruluşlar

- Garantili kullanılabilirlik gerektiren uygulamalar

- Sınırsız deneme yeteneği isteyen ekipler

Bulut hizmetleri için ekonomik olmaya devam ediyor:

- Minimum aylık hacme sahip ara sıra kullanıcılar

- Son teknoloji modellere erişim gerektiren ekipler

- BT altyapı uzmanlığı olmayan kuruluşlar

- Sorunsuz ölçeklendirme yeteneklerine ihtiyaç duyan uygulamalar

Karar genellikle gizlilik gereklilikleri de dahil olmak üzere finansal olmayan faktörleri içerir, veri egemenliği, internet bağlantı güvenilirliği ve daha yüksek başlangıç maliyetlerine rağmen dengeyi yerel dağıtıma doğru çeviren kurumsal kontrol tercihleri.

Yerel büyük dil modelleri, demokratikleştirilmiş, özel ve uygun maliyetli yapay zeka dağıtımına doğru temel bir değişimi temsil etmektedir. Modeller daha verimli ve araçlar daha kullanıcı dostu hale geldikçe, yetenekler hızla genişlerken giriş engeli azalmaya devam ediyor.

İster kodlama yardımı arayan bir geliştirici, ister hassas verileri koruyan bir işletme veya yapay zeka olanaklarını keşfeden bir meraklı olun, llms'yi yerel olarak çalıştırmak yapay zeka deneyiminiz üzerinde benzeri görülmemiş bir kontrol sağlar. LM Studio veya GPT4All gibi kullanıcı dostu araçlarla başlayın, ideal yetenek ve performans dengenizi bulmak için farklı modellerle denemeler yapın ve ihtiyaçlar geliştikçe kurulumunuzu kademeli olarak genişletin.

Yapay zekanın geleceği sadece devasa veri merkezlerinde değil, tamamen sizin kontrolünüz altında, kendi donanımınızda. İlk yerel modelinizi bugün indirin ve kendi kendine barındırılan yapay zekanın özgürlüğünü deneyimleyin.

Yerel Yapay Zekaya Giriş

Yerel Yapay Zeka, büyük dil modellerinin tüm gücünü doğrudan kendi bilgisayarınıza getirerek bireylerin ve kuruluşların yapay zekadan yararlanma biçiminde devrim yaratıyor. Bulut tabanlı hizmetlere bağlı kalmak yerine llms'yi yerel olarak çalıştırmak, tüm işlemlerin cihazınızda gerçekleşmesi anlamına gelir ve size model parametreleri ve hassas verilerinizin nasıl işleneceği üzerinde tam kontrol sağlar. Bu yaklaşım, verileriniz asla makinenizden ayrılmadığı için yalnızca gizliliği artırmakla kalmaz, aynı zamanda gecikmeyi de azaltarak yanıtları her zamankinden daha hızlı ve daha güvenilir hale getirir.

Yerel ai ile, ister belirli görevler için optimize ediyor ister farklı yapılandırmalarla denemeler yapıyor olun, büyük dil modellerini benzersiz ihtiyaçlarınıza uyacak şekilde hassas bir şekilde ayarlayabilirsiniz. llms'yi yerel olarak çalıştırmak, bilgilerinizi tamamen güvende tutarken modelleri özelleştirmenizi, güncellemeleri yönetmenizi ve iş akışınıza mükemmel şekilde uyarlanmış çözümleri dağıtmanızı sağlar. Daha fazla kullanıcı yerel dağıtımın oyunun kurallarını değiştiren değerini keşfettikçe, araç ve model ekosistemi hızla genişlemeye devam ediyor ve llms'in son teknoloji ürünü büyük dil modellerinin yeteneklerinden doğrudan kendi bilgisayarınızda yararlanmayı her zamankinden daha kolay hale getiriyor.

Yerel LLM'lere Başlarken

Ezber bozan araçlar ve parmaklarınızın ucundaki güçlü modellerden oluşan genişleyen ekosistem sayesinde yerel LLM yolculuğunuzu başlatmak hiç bu kadar erişilebilir olmamıştı. Her ikisi de LLM'leri doğrudan makinenizde çalıştırma sürecini basitleştirmek ve kolaylaştırmak için tasarlanmış olan LM Studio veya Ollama gibi bir platform seçerek başlayın. Bu çözümler tercihlerinize göre uyarlanmış kullanıcı dostu deneyimler sunar - sezgisel grafik arayüzü ile LM Studio ve verimli komut satırı yaklaşımı ile Ollama - böylece teknik konfor alanınıza mükemmel şekilde uyan iş akışını seçebilirsiniz.

Tercih ettiğiniz platformu kurduktan sonra, Hugging Face gibi güvenilir depolardan mevcut modellere zahmetsizce göz atmak için entegre arama işlevinden yararlanın. Seçtiğiniz model dosyasını doğrudan yerel kurulumunuza indirin, garantili donanım uyumluluğu doğrudan yerleşiktir. Yapılandırıldıktan sonra, yerel çıkarım sunucusunu etkinleştirerek modelinizle grafik arayüz veya komut satırı işlemleri aracılığıyla etkileşim kurabilirsiniz. Bu güçlü kurulum, birden fazla modelle deneme yapma, yerel LLM ekosisteminizi verimli bir şekilde yönetme ve harici bulut altyapısına bağımlı olmadan yerel işlemenin tüm avantajlarından yararlanma esnekliği sunar.

Yerel Çıkarım Sunucusunun Kurulması

Yerel bir çıkarım sunucusu, llms'yi yerel olarak çalıştırmanın ezber bozan bel kemiğidir ve seçtiğiniz modelleri önemli ölçüde verimli ve güvenli bir ortamda dağıtmanıza, yönetmenize ve bunlarla etkileşime girmenize olanak tanır. LM Studio ve Ollama gibi devrim niteliğindeki araçlar, yerel bir çıkarım sunucusu kurmayı inanılmaz derecede kolaylaştırır; yapay zeka konusunda tamamen yeni olan kullanıcılar bile güçlü sonuçlar elde edebilir. Bu potansiyeli ortaya çıkarmak için, istediğiniz model dosyasını seçin ve bağlam uzunluğu gibi temel parametreleri yapılandırın ve mevcut olduğunda, patlayıcı performans kazanımları için GPU hızlandırmayı etkinleştirin.

Ollama, uyumlu donanımlarda model çıkarımını önemli ölçüde hızlandırabilen GPU hızlandırma gibi gelişmiş özellikler sunar ve iş akışınızı tamamen dönüştürür. Çıkarım sunucunuz için tam bağlantı noktasını belirleyerek, web arayüzü üzerinden zahmetsizce erişilebilir hale getirerek veya maksimum esneklik için diğer uygulamalarla sorunsuz bir şekilde entegre ederek tam kontrol elde edersiniz. LM Studio, sezgisel, kullanıcı dostu bir arayüz aracılığıyla modelleri ve sunucu ayarlarını yönetmenizi sağlayan eşit derecede kolaylaştırılmış bir kurulum sunar. Yerel çıkarım sunucunuz çalışır durumdayken, llms'yi yerel olarak çalıştırmak ve seçtiğiniz modellerin tam, sınırsız yeteneklerinden yararlanmak için güçlü, tamamen özel bir ortama sahip olacaksınız.

LLM'leri Popüler Araçlarla Yerel Olarak Çalıştırma

Doğru aracı seçmek, llms'yi yerel olarak çalıştırırken sorunsuz bir deneyimin kilidini açmanın anahtarıdır. LM Studio, Ollama ve GPT4All en güvenilir çözümler arasında yer alır ve her biri özel iş akışı ihtiyaçlarınıza uyacak şekilde tasarlanmış benzersiz özellikler sunar. LM Studio, sezgisel grafik arayüzü ile sizi güçlendirir, birden fazla modeli yönetmenizi, aralarında sorunsuz bir şekilde geçiş yapmanızı ve projeleriniz için önemli olan en iyi sonuçları elde etmek için ayarlarda ince ayar yapmanızı kolaylaştırır. Terminal ortamlarında başarılı olanlar için Ollama, gelişmiş iş akışlarınızı destekleyen ve geliştirme ekosisteminizle kusursuz bir şekilde entegre olan sağlam bir komut satırı deneyimi sunar.

GPT4All, Mistral 7B gibi popüler seçenekler de dahil olmak üzere geniş bir model yelpazesini desteklerken, yerel ai'nizle etkileşim kurmanız için size kolaylaştırılmış bir arayüz sunan araç setinizdeki bir başka güçlü seçeneği temsil eder. Bu platformlar sadece modelleri çalıştırmakla kalmaz; api sunucularını zahmetsizce kurmanızı sağlayarak mevcut uygulamalarınız ve hizmetlerinizle sorunsuz entegrasyon sağlar. İster birden fazla modeli yönetiyor olun, ister ince ayar denemeleri yapıyor olun, ister yerel llms ile yolculuğunuza yeni başlıyor olun, bu platformlar yerel ai potansiyelinizi en üst düzeye çıkarmak için ihtiyacınız olan esnekliği ve gücü sağlar.

Yerel API Sunucusu Oluşturma

Yerel bir api sunucusu kurmak, uygulamalara ve iş akışlarına büyük dil modeli entegrasyonunda devrim yaratmak isteyen herkes için oyunun kurallarını değiştiren nihai unsurdur! LM Studio ve Ollama gibi güçlü araçlarla, kişiselleştirilmiş yerel api sunucunuzu oluşturmak inanılmaz derecede basit hale gelir: seçtiğiniz model dosyasını belirtin, maksimum koruma için güvenli api anahtarınızı ayarlayın ve sunucuyu tercih ettiğiniz bağlantı noktasında çalışacak şekilde yapılandırın. Bu son teknoloji kurulum, modellerinize sezgisel bir web arayüzü aracılığıyla veya api sunucusu aracılığıyla programlı olarak erişmenizi sağlayarak çalışma şeklinizi dönüştüren sınırsız pratik uygulamaların kilidini açar.

Ollama, kutudan çıkar çıkmaz sorunsuz api sunucu entegrasyonu sağlayarak yerel llm'lerinizi maksimum verimlilik için diğer araçlara ve platformlara bağlamayı zahmetsiz hale getirir. LM Studio, aynı derecede etkileyici yetenekler sunarak, yerel api sunucunuzu, kontrolü tamamen size veren güzel ve kullanıcı dostu bir arayüz aracılığıyla yönetmenize olanak tanır. Kendi yerel api sunucunuzu oluşturarak, değerli verilerinizi tamamen güvende ve mutlak kontrolünüz altında tutarken, modelleri gerçek dünya senaryolarında dağıtmak, karmaşık görevleri otomatikleştirmek ve ihtiyaçlarınıza mükemmel şekilde uyan özel çözümler oluşturmak için benzersiz bir esneklik kazanırsınız. İster çığır açan uygulamalar geliştiriyor ister mevcut iş akışlarını iyileştiriyor olun, yerel bir api sunucusu, yerel ai altyapınızın olağanüstü potansiyelini ortaya çıkarmanın anahtarıdır.