Lokale LLM's uitvoeren: Complete 2025 gids voor zelfgehoste AI-modellen

De AI revolutie plaatsvindt, maar je hoeft je gevoelige gegevens niet naar cloudservices te sturen of maandelijkse abonnementskosten te betalen om ervan te profiteren. Door grote taalmodellen lokaal op je eigen computer uit te voeren, heb je volledige controle over je AI-interacties, terwijl je absolute privacy behoudt en geen lopende kosten hebt.

In deze uitgebreide gids ontdek je alles wat je nodig hebt om llms lokaal te draaien, van het kiezen van de juiste tools en modellen tot het optimaliseren van de prestaties op je hardware. Of je nu een ontwikkelaar bent die hulp zoekt bij het coderen, een bedrijf beschermen gevoelige gegevens, of een AI-enthousiasteling die offline toegang wil, bieden lokale llms overtuigende voordelen ten opzichte van cloudgebaseerde alternatieven.

We bespreken de beste tools voor 2025, hardwarevereisten die je niet in de steek laten. bank, en stap-voor-stap tutorials om je eerste lokale llm binnen een paar minuten aan de praat te krijgen. Aan het eind zul je begrijpen hoe je de kracht van geavanceerde taalmodellen kunt benutten zonder je privacy of budget in gevaar te brengen.

Wat je zult leren

- Wat “LLM's lokaal uitvoeren” betekent en hoe het werkt

- De voordelen van zelfgehoste AI vs. AI in de cloud

- De beste tools van 2025 (LM Studio, Ollama, GPT4All, Jan, llamafile, llama.cpp)

- Hardwarevereisten voor modellen met parameters van 2B tot 70B+

- Je eerste model installeren en uitvoeren

- Een veilige lokale API-server maken

- Praktijkvoorbeelden voor persoonlijke en zakelijke workflows

- Prestatietips, probleemoplossing en kostenvergelijkingen

Inleiding tot grote taalmodellen

Grote taalmodellen (LLM's) zijn revolutionair kunstmatige intelligentie Systemen die uw interactie met technologie transformeren, ontworpen om menselijke taal te begrijpen, genereren en manipuleren met ongekende verfijning. Door te trainen op enorme datasets met tekst, leveren deze baanbrekende grote taalmodellen samenhangende, contextbewuste antwoorden die uw workflow revolutioneren, waardoor ze absoluut essentieel zijn voor een ongelooflijke reeks toepassingen, van chatbots en virtuele assistenten tot taalvertalingen, samenvattingen en creatieve content die gebruikers verrukt en resultaten oplevert.

Het lokaal uitvoeren van grote taalmodellen op uw eigen computer biedt uitzonderlijke voordelen waar clouddiensten simpelweg niet aan kunnen tippen. Wanneer u LLM's lokaal uitvoert, behoudt u de volledige controle over uw gevoelige gegevens en zorgt u ervoor dat vertrouwelijke informatie uw apparaat nooit verlaat. Deze krachtige strategie verbetert niet alleen de beveiliging en gemoedsrust, maar maakt je ook niet langer afhankelijk van externe providers en brengt terugkerende abonnementskosten terug tot nul. Als gevolg hiervan kiezen slimme individuen en vooruitstrevende organisaties ervoor om LLM's lokaal uit te voeren en de volledige kracht van deze modellen te benutten voor alles van bedrijfsautomatisering tot persoonlijke productiviteit, zonder in te boeten op beveiliging of doorlopende kosten.

Of u nu gepassioneerd bent over het experimenteren met geavanceerde modellen, het bouwen van aangepaste AI-aangedreven tools die uw succes schalen, of gewoon op zoek bent naar een meer besloten en bliksemsnelle AI-ervaring, het lokaal uitvoeren van LLM's geeft u de mogelijkheden van geavanceerde taalmodellen direct in handen, zodat u sneller kunt innoveren, veiliger kunt blijven en uitzonderlijke resultaten kunt leveren.

Wat betekent het lokaal organiseren van LLM's?

Grote taalmodellen lokaal uitvoeren betekent dat je geavanceerde AI-modellen direct op je eigen computer of lokale machine uitvoert in plaats van te vertrouwen op clouddiensten zoals ChatGPT, Claude of Gemini. Als je llm lokaal draait, vindt het hele inferentieproces plaats op je eigen hardware, zonder gegevens die via het internet naar externe servers worden gestuurd.

De belangrijkste voordelen van local llms zijn volledige gegevensprivacy, geen abonnementskosten na de eerste installatie en offline functionaliteit die werkt zonder internetverbinding. Uw gevoelige gegevens verlaten nooit uw apparaat, waardoor lokale inferentie bijzonder waardevol is voor bedrijven die vertrouwelijke informatie verwerken, ontwikkelaars die werken aan bedrijfseigen code, of individuen die zich zorgen maken over privacy.

In tegenstelling tot cloudgebaseerde AI-services die API-sleutels vereisen en kosten per verzoek in rekening brengen, bieden lokale modellen onbeperkt gebruik zodra je het model downloadt van repositories of bronnen zoals GitHub of Hugging Face en het modelbestand opslaat op je computer. Dit zorgt voor voorspelbare kosten en elimineert zorgen over API-tarieflimieten of uitval van services die je workflow beïnvloeden.

Een praktische vergelijking illustreert het verschil: wanneer je ChatGPT gebruikt, reizen je vragen naar OpenAI's servers voor verwerking voordat ze antwoorden terugsturen. Met een lokale llm zoals Llama 3.2 die op jouw machine draait, gebeurt alles op jouw consumentenhardware. Terwijl cloudservices gemak en geavanceerde modellen bieden, biedt lokale ai privacy, controle en voorspelbaarheid van kosten die veel gebruikers aantrekkelijk vinden.

Veelvoorkomende misvattingen zijn onder andere de overtuiging dat het lokaal uitvoeren van llms dure GPU-hardware of een complexe technische setup vereist. Moderne tools zoals LM Studio en GPT4All hebben het proces aanzienlijk vereenvoudigd en veel kleinere modellen draaien effectief op standaard desktopcomputers met voldoende RAM.

Een lokale omgeving opzetten

Aan de slag gaan met lokale llms begint met het transformeren van je computer in een krachtige AI-krachtcentrale die uitzonderlijke prestaties levert binnen handbereik. De eerste stap is ervoor zorgen dat uw besturingssysteem, of het nu Windows, macOS of Linux is, de perfecte basis wordt voor de geavanceerde tools die u zult gebruiken, zoals LM Studio, Ollama of GPT4All. Elk van deze baanbrekende platformen biedt een gestroomlijnde, gebruiksvriendelijke aanpak voor het beheren van en communiceren met lokale modellen, waardoor geavanceerde AI toegankelijk wordt voor iedereen, zelfs voor degenen die hun eerste stappen zetten in de opwindende wereld van AI. wereld van kunstmatige intelligentie.

Vervolgens wil je je hardwarepotentieel maximaliseren om ongelooflijke prestatieverbeteringen te ontgrendelen. Veel kleinere modellen leveren indrukwekkende resultaten op standaard desktops of laptops, maar een moderne CPU, voldoende RAM en, idealiter, een speciale GPU zullen je ervaring een boost geven en je in staat stellen om grotere, geavanceerdere modellen met een opmerkelijke soepelheid uit te voeren. Door ervoor te zorgen dat je systeem voldoet aan de minimale vereisten voor de tool en het model van je keuze, bereid je jezelf voor op ongeëvenaarde AI-mogelijkheden.

Zodra uw hardware en besturingssysteem perfect op elkaar zijn afgestemd, kunt u de tool van uw voorkeur installeren en de magie zien gebeuren. LM Studio biedt bijvoorbeeld een intuïtieve grafische interface die modelbeheer moeiteloos eenvoudig maakt, terwijl Ollama een commandoregelervaring biedt die ontwikkelaars geavanceerde controle geeft. Na de installatie hebt u de vrijheid om te bladeren, te downloaden en compatibele modellen direct op uw lokale machine uit te voeren, waardoor u volledige controle hebt over uw AI-ervaring.

Door zorgvuldig de juiste tool te kiezen en ervoor te zorgen dat je omgeving deskundig is geconfigureerd, ben je uitgerust met alles wat je nodig hebt om llms lokaal te draaien en de volledige kracht van de nieuwste ontwikkelingen op het gebied van AI te benutten. Je krijgt niet alleen lokale AI-mogelijkheden, maar ook totale onafhankelijkheid, verbeterde privacy en bliksemsnelle prestaties die je manier van werken met kunstmatige intelligentie transformeren.

Snel aan de slag: Beste tools voor lokale LLM's in 2025

Het landschap van tools voor het uitvoeren van lokale llms is enorm gegroeid en biedt nu gebruiksvriendelijke opties die de meeste technische barrières wegnemen. Hier zijn de top vijf platforms die het lokaal uitvoeren van modellen toegankelijk maken voor gebruikers op elk vaardigheidsniveau, inclusief toegang tot populaire modellen zoals Llama en DeepSeek R1 voor lokaal gebruik:

LM Studio blinkt uit als de meest beginnersvriendelijke optie met zijn intuïtieve grafische interface en ingebouwde modelbrowser. Downloaden van lmstudio.ai en geniet van naadloos modelbeheer in Windows 11, macOS Ventura+ en Ubuntu 22.04+.

GPT4All richt zich op privacy-eerst AI met uitstekende document chat mogelijkheden via de LocalDocs functie. GPT4All is beschikbaar op gpt4all.io voor alle grote besturingssystemen en biedt een gecureerde modellenmarktplaats met meer dan 50 compatibele modellen.

Jan biedt een open source alternatief voor ChatGPT met een uitbreidbare architectuur en hybride lokale/cloud mogelijkheden. Aan de slag bij jan.ai met ondersteuning voor aangepaste extensies en API-integratie op afstand.

Ollama is de favoriete commandoregeltool voor ontwikkelaars en biedt eenvoudig modelbeheer en uitstekende API-integratie. Het installeren van Ollama is eenvoudig: download het installatieprogramma voor je besturingssysteem, voer het uit en volg de aanwijzingen om de installatie te voltooien. Zodra je Ollama hebt geïnstalleerd, kun je de commandoregeltool gebruiken om modellen te beheren en uit te voeren. Een belangrijke functie is het pull commando, waarmee je specifieke modellen direct vanaf de terminal kunt downloaden of bijwerken voor direct gebruik.

llamafile levert draagbare AI door middel van uitvoerbare bestanden die overal kunnen worden uitgevoerd zonder installatie. Perfect voor snelle test- of implementatiescenario's waarbij een minimale installatie cruciaal is.

Voor complete beginners biedt LM Studio de soepelste instapervaring met zijn visuele interface en automatische GPU-versnelling. Ontwikkelaars geven meestal de voorkeur aan Ollama vanwege de flexibiliteit en integratiemogelijkheden met bestaande ontwikkelworkflows.

Deze tools zijn ontworpen om zowel beginners als gevorderden een gebruiksvriendelijke ervaring te bieden.

Hardwarevereisten voor lokale LLM's

Inzicht in de hardwarevereisten helpt je de juiste modellen voor je systeem te kiezen en realistische prestatieverwachtingen te stellen. Het goede nieuws is dat moderne lokale llms werken op een breed scala aan hardwareconfiguraties, van bescheiden laptops tot high-end werkstations.

De minimale specificaties voor kleinere modellen zijn 16 GB RAM, een moderne CPU zoals Intel i5-8400 of AMD Ryzen 5 2600 en minimaal 50 GB beschikbare opslagruimte. Deze specificaties kunnen modellen tot 7B parameters aan met acceptabele prestaties voor de meeste gebruikssituaties.

Aanbevolen specificaties voor optimale prestaties zijn een NVIDIA RTX 4060 met 8 GB video-ram, 32 GB systeem-RAM en 100 GB+ opslag voor meerdere modellen. Deze configuratie biedt soepele inferentie voor grotere modellen en maakt het mogelijk om meerdere modellen tegelijk uit te voeren.

De opslagvereisten variëren per modelgrootte: kleinere modellen zoals Phi-3-mini hebben 2-4GB nodig, terwijl grotere modellen zoals Llama 3.1 70B 40-80GB nodig hebben, afhankelijk van de kwantisatie. Als je beperkte middelen hebt, wil je misschien het kleinste beschikbare model downloaden, zoals Gemma 2B Instruct, om opslag en geheugengebruik te minimaliseren. Reken op 50-100GB als je wilt experimenteren met meerdere modellen van verschillende groottes.

Hier is een prestatievergelijking met tokens per seconde voor verschillende hardwareconfiguraties:

Hardwareconfiguratie | Phi-3-mini (3B) | Lama 3.1 8B | Mistral 7B | Code Llama 34B |

|---|---|---|---|---|

Alleen CPU (16 GB RAM) | 8-12 tokens/sec | 4-6 tokens/sec | 3-5 tokens/sec | Niet aanbevolen |

RTX 4060 (8GB VRAM) | 45-60 tokens/sec | 25-35 tokens/sec | 30-40 tokens/sec | 8-12 tokens/sec |

RTX 4090 (24GB VRAM) | 80-120 tokens/sec | 60-80 tokens/sec | 70-90 tokens/sec | 35-45 tokens/sec |

Apple M2 Pro (32 GB) | 35-50 lopers/sec | 20-30 tokens/sec | 25-35 tokens/sec | 15-20 tokens/sec |

GPU-versnelling verbetert de prestaties aanzienlijk, maar inferentie met alleen CPU blijft bruikbaar voor kleinere modellen als er geen GPU-bronnen beschikbaar zijn. De optimale prestaties worden verkregen door de grootte van het model af te stemmen op het beschikbare video- of systeemRAM.

Beste Open Source Modellen om lokaal uit te voeren

Het kiezen van het juiste model hangt af van je hardwaremogelijkheden, beoogde gebruikssituaties en kwaliteitseisen. Open source modellen hebben indrukwekkende kwaliteitsniveaus bereikt en zijn toch toegankelijk gebleven voor lokale implementatie. Het groeiende landschap van open source llm-projecten, zoals Ollama en llama.cpp, benadrukt de kracht van community-gedreven ontwikkeling en de toenemende beschikbaarheid van modellen uitgebracht door toonaangevende AI-organisaties.

Kleine modellen (minder dan 8 GB) bieden een uitstekende efficiëntie voor basistaken:

- Phi-3-mini (3,8B parameters) biedt sterke redeneercapaciteiten in een compact pakket van 2,3 GB, ideaal voor beperkte ramscenario's

- Gemma 2B levert de trainingskwaliteit van Google in een ultralicht modelbestand van 1,4 GB

- Llama 3.2 3B biedt Meta's nieuwste architectuuroptimalisaties met uitgebalanceerde prestaties en efficiëntie

Middelgrote modellen (8-16 GB) vormen de beste balans tussen mogelijkheden en vereisten voor bronnen:

- Llama 3.1 8B dient als de gouden standaard voor algemene taken met sterke redenering en codegeneratie

- Mistral 7B blinkt uit in het nauwkeurig opvolgen van instructies en het uitvoeren van complexe redeneertaken.

- DeepSeek-Coder 6.7B is gespecialiseerd in het genereren van code met ondersteuning voor 80+ programmeertalen

Grote modellen (16GB+) bieden maximale mogelijkheden voor gebruikers met voldoende hardware:

- Llama 3.1 70B biedt prestaties van GPT-4-klasse voor complexe redeneer- en analysetaken

- Code Llama 34B levert uitzonderlijke codeerhulp met diepgaand begrip van software-engineeringconcepten

Alle modellen zijn beschikbaar via Hugging Face met model ID's zoals “microsoft/Phi-3-mini-4k-instruct” of “meta-llama/Meta-Llama-3.1-8B-Instruct”. Prestatiebenchmarks tonen aan dat 8B parametermodellen meestal de beste waardepropositie bieden voor de meeste gebruikers, met 85-90% aan grotere modelcapaciteiten terwijl er aanzienlijk minder bronnen nodig zijn.

LM Studio: De gemakkelijkste manier om te beginnen

LM Studio brengt een revolutie teweeg in de toegankelijkheid van lokale ai door een gebruiksvriendelijke grafische interface te bieden die technische complexiteit wegneemt. LM Studio en vergelijkbare tools bieden gebruikersinterfaces, waaronder grafische en webgebaseerde opties, die modelbeheer en interactie vereenvoudigen. LM Studio biedt ook een handige web ui, waardoor gebruikers modellen direct vanuit hun browser kunnen beheren en ermee kunnen werken. Dit maakt het een ideaal startpunt voor gebruikers die nieuw zijn met het lokaal draaien van llms.

Begin met het downloaden van LM Studio van lmstudio.ai en volg het eenvoudige installatieproces voor je besturingssysteem. Het installatieprogramma configureert automatisch de GPU-versnelling wanneer compatibele hardware wordt gedetecteerd, zodat er geen handmatige driverconfiguratie nodig is. Start na de installatie LM Studio om de hoofdinterface te openen en de beschikbare modellen te verkennen.

De hoofdinterface heeft drie hoofdsecties: Discover voor het bladeren door beschikbare modellen, My Models voor het beheren van gedownloade modellen en Chat voor interactie met geladen modellen. Op het tabblad Ontdekken kunt u de zoekbalk gebruiken om snel specifieke modellen te vinden op basis van uw vereisten. De ingebouwde modelbibliotheek verzamelt open source modellen van hoge kwaliteit met duidelijke beschrijvingen en hardwarevereisten.

Het instellen van de chatinterface bestaat uit het laden van een gedownload model en het aanpassen van generatieparameters zoals temperatuur en contextlengte. De interface biedt intuïtieve schuifregelaars en uitleg voor elke instelling, waardoor experimenteren toegankelijk wordt voor niet-technische gebruikers.

Voor ontwikkelaars bevat LM Studio een lokale api-server die OpenAI-compatibele eindpunten blootstelt. Schakel deze functie in de instellingen in om lokale modellen te integreren met bestaande applicaties die OpenAI's API-indeling ondersteunen.

Uw eerste model installeren in LM Studio

Navigeer naar het tabblad Discover waar je een doorzoekbare bibliotheek met compatibele modellen vindt. Zoek naar “llama-3.2-3b-instruct” om Meta's efficiënte 3B-parametermodel te vinden dat goed werkt op bescheiden hardware.

Klik op de downloadknop om het proces te starten. LM Studio geeft voortgangsindicatoren weer die de downloadsnelheid en geschatte voltooiingstijd weergeven. De downloadmanager gaat netjes om met onderbrekingen en hervat gedeeltelijke downloads zodra de netwerkverbinding is hersteld.

Zodra het downloaden is voltooid, verschijnt het model in de sectie Mijn modellen. De gedownloade modelbestanden worden beheerd en opgeslagen voor eenvoudige toegang en laden. Klik om het model in het geheugen te laden, wat meestal 10-30 seconden duurt, afhankelijk van de grootte van het model en de opslagsnelheid. De interface toont het geheugengebruik en bevestigt wanneer het model klaar is voor interactie.

Test je installatie met voorbeeldvragen zoals “Leg quantum computing uit in eenvoudige bewoordingen” of “Schrijf een Python-functie om fibonacci-getallen te berekenen”. Het model zou binnen enkele seconden moeten reageren, wat bevestigt dat de installatie geslaagd is.

Veel voorkomende probleemoplossingen voor mislukte downloads zijn het controleren van de beschikbare schijfruimte, het controleren van de stabiliteit van de internetverbinding en ervoor zorgen dat uw firewall LM Studio netwerktoegang toestaat. De ingebouwde logboeken bieden gedetailleerde foutinformatie voor het oplossen van problemen.

GPT4All: privacygerichte lokale AI

GPT4All legt de nadruk op privacy en gebruiksgemak, waardoor het een uitstekende keuze is voor gebruikers die gegevensbeveiliging belangrijk vinden. De applicatie draait volledig offline zodra modellen zijn gedownload, zodat je gesprekken je apparaat nooit verlaten.

Download GPT4All van gpt4all.io en installeer het op Windows, macOS of Linux. Tijdens het installatieproces wordt automatisch een instapmodel gedownload, zodat je meteen aan de slag kunt. Bij de eerste keer opstarten zie je een schone interface met duidelijke navigatie tussen chat, modellen en instellingen. Na de installatie kun je de modellen vragen om tekst te genereren voor verschillende taken, zoals het beantwoorden van vragen of het maken van content.

De modellenmarktplaats biedt meer dan 50 gecureerde modellen met gedetailleerde beschrijvingen, hardwarevereisten en gebruikersbeoordelingen. Modellen worden gecategoriseerd op grootte en specialiteit, zodat gebruikers de juiste opties kunnen selecteren voor hun gebruikssituaties en hardwarebeperkingen.

Het instellen van GPU-versnelling verschilt per platform, maar omvat over het algemeen het installeren van CUDA-stuurprogramma's voor NVIDIA grafische kaarten of het zorgen voor Metal-ondersteuning op macOS. Het instellingenpaneel biedt duidelijke instructies en automatische detectie voor compatibele hardwareconfiguraties.

LocalDocs instellen voor documentchatten

LocalDocs is de meest opvallende functie van GPT4All en maakt privégesprekken met je persoonlijke documenten mogelijk zonder inhoud te uploaden naar externe servers. Deze functionaliteit transformeert lokale llms in krachtige onderzoeks- en analyse-instrumenten.

Ga naar LocalDocs via het speciale tabblad en voeg lokale mappen toe met PDF's, tekstbestanden, markdown-documenten of codeopslagplaatsen. Het systeem ondersteunt veelgebruikte indelingen zoals .pdf, .txt, .md, .docx en broncodebestanden.

Het indexeringsproces analyseert de inhoud van documenten om doorzoekbare insluitingen te maken die lokaal op je apparaat zijn opgeslagen. De indexeertijd is afhankelijk van het documentvolume, maar verwerkt doorgaans honderden pagina's binnen enkele minuten. Voortgangsindicatoren geven de status van de voltooiing en de geschatte resterende tijd aan.

Voorbeeldvragen tegen geïndexeerde documenten kunnen zijn: “Vat de belangrijkste bevindingen uit mijn onderzoekspapers samen” of “Welke coderingspatronen komen het vaakst voor in mijn projecten?”. Het systeem haalt relevante secties van documenten op voordat het antwoorden genereert en geeft onderbouwde antwoorden met bronvermeldingen. citaten.

Privacyvoordelen zijn onder andere volledige offline verwerking zonder gegevensoverdracht naar externe services. Je documenten blijven tijdens het hele proces op je lokale machine staan, waardoor LocalDocs geschikt is voor vertrouwelijke zakelijke documenten of persoonlijk onderzoeksmateriaal.

Jan: Open Source ChatGPT Alternatief

Jan positioneert zichzelf als een uitgebreid open source alternatief voor commerciële AI-chatdiensten en biedt vertrouwde interfaces met de flexibiliteit van open source ontwikkeling. Het platform ondersteunt zowel lokale inferentie als hybride cloudintegratie voor maximale flexibiliteit.

Installatie vanaf jan.ai vereist het controleren van de systeemvereisten, inclusief voldoende RAM en opslagruimte. Het installatieprogramma detecteert automatisch de hardwaremogelijkheden en stelt optimale configuratie-instellingen voor je specifieke opstelling voor.

De interface laat een op ChatGPT geïnspireerd ontwerp zien met moderne UI-elementen en intuïtieve navigatie. De gespreksgeschiedenis, het wisselen van model en de toegang tot instellingen volgen bekende patronen die de leercurve verkleinen voor gebruikers die overstappen van commerciële diensten.

Modelimportmogelijkheden maken het mogelijk om modellen mee te nemen vanuit andere tools zoals LM Studio of Ollama, waardoor overbodige downloads worden vermeden. Jan ondersteunt het importeren van elk compatibel groot taalmodel voor lokaal of hybride gebruik. Het systeem detecteert automatisch compatibele modelformaten en converteert ze indien nodig voor optimale prestaties.

De uitbreidingsmarktplaats voegt functionaliteit toe via door de gemeenschap ontwikkelde plugins op gebieden zoals verbeterd modelbeheer, gespecialiseerde chatmodi en integratie met externe tools en diensten.

API-integratie op afstand maakt hybride implementaties mogelijk waarbij sommige verzoeken lokale modellen gebruiken terwijl andere cloudservices gebruiken op basis van complexiteit of prestatievereisten. Deze aanpak optimaliseert de kosten terwijl de lokale mogelijkheden voor gevoelige taken behouden blijven.

Ollama: ontwikkelaar-vriendelijke commandoregel-tool

Ollama blinkt uit als een opdrachtregeltool die speciaal is ontworpen voor ontwikkelaars die de voorkeur geven aan programmatische besturing en integratiemogelijkheden. De eenvoudige maar krachtige interface maakt modelbeheer en implementatie eenvoudig voor technische gebruikers.

De installatie varieert per besturingssysteem, maar meestal worden pakketbeheerders gebruikt zoals Homebrew op macOS (brew install ollama), apt op Ubuntu (sudo apt install ollama), of winget op Windows (winget install ollama). Deze methoden zorgen voor een goed beheer van afhankelijkheden en systeemintegratie.

Na de installatie kunnen gebruikers communiceren met Ollama door middel van specifieke terminal commando's voor het downloaden, uitvoeren en beheren van modellen, waardoor het eenvoudig is om volledig vanaf de commandoregel te werken.

Essentiële opdrachten bieden uitgebreid beheer van de levenscyclus van modellen:

- ollama pull llama3.1:8b downloadt modellen uit de officiële bibliotheek

- ollama run llama3.1:8b start interactieve chatsessies met opgegeven modellen

- ollama-lijst toont alle geïnstalleerde modellen met afmetingen en wijzigingsdatums

- ollama rm model-naam verwijdert modellen om opslagruimte vrij te maken

Ollama kan worden geconfigureerd als een lokale server of lokale inferentieserver, zodat je modellen lokaal kunt hosten en serveren voor integratie met andere toepassingen. Deze opstelling maakt eenvoudige aanpassing, verbeterde prestaties en naadloze ondersteuning bij het oplossen van problemen mogelijk.

Door aangepaste modellen te maken met Modelfile kunnen modelgedrag, systeemprompts en parameters nauwkeurig worden ingesteld. Deze op tekst gebaseerde configuratiebenadering integreert goed met versiebeheer en automatiseringsworkflows.

Integratie met ontwikkeltools omvat plugins voor populaire IDE's zoals VS Code, waardoor code direct binnen ontwikkelomgevingen kan worden gegenereerd en geanalyseerd. Het gestandaardiseerde API-formaat vereenvoudigt de integratie met bestaande applicaties en diensten.

Meerdere modellen uitvoeren met Ollama

De architectuur van Ollama ondersteunt gelijktijdige modeluitvoering, waardoor verschillende modellen tegelijkertijd gespecialiseerde taken kunnen uitvoeren. Dit maakt geavanceerde workflows mogelijk waarbij kleinere modellen basistaken afhandelen terwijl grotere modellen complexe redeneringen aanpakken.

Schakelen tussen modellen vereist een eenvoudige commando syntaxis zoals ollama run mistral:7b gevolgd door ollama run codellama:7b in aparte terminal sessies. Elk model onderhoudt een onafhankelijke conversatiecontext en geheugentoewijzing.

Geheugenbeheer regelt automatisch de toewijzing van bronnen op basis van beschikbare systeembronnen en modelvereisten. Het systeem waarschuwt wanneer geheugenbeperkingen de prestaties kunnen beïnvloeden en stelt optimalisatiestrategieën voor.

API server setup via ollama serve stelt modellen bloot via HTTP endpoints die compatibel zijn met het OpenAI formaat. Dit maakt naadloze integratie mogelijk met toepassingen die zijn ontworpen voor AI-cloudservices en die volledig op lokale infrastructuur draaien.

Docker implementatie faciliteert productieomgevingen door middel van officiële Ollama containers. De gecontaineriseerde aanpak zorgt voor consistent gedrag in ontwikkel-, staging- en productieomgevingen en vereenvoudigt het beheer van afhankelijkheden.

Geavanceerd gereedschap: llama.cpp en llamafile

Gevorderde gebruikers die op zoek zijn naar maximale controle en prestatieoptimalisatie hebben baat bij tools op een lager niveau, zoals llama.cpp en llamafile. Om modellen uit te voeren met llama.cpp, moeten gebruikers een gguf modelbestand downloaden, wat het vereiste formaat is voor lokale implementatie. Deze gereedschappen offeren gemak op voor flexibiliteit en efficiëntie, waardoor ze ideaal zijn voor productie implementaties en gespecialiseerde vereisten.

De keuze tussen gebruiksvriendelijke toepassingen en geavanceerde hulpmiddelen hangt af van specifieke behoeften. Kies voor geavanceerde tools als aangepaste compilatieopties, gespecialiseerde hardwareondersteuning of integratie in grotere systemen nodig zijn, waarbij volledige controle over de inferentie-engine nodig is. Gebruikers kunnen ook fijn afgestemde modellen draaien voor specifieke taken of domeinen, om optimale prestaties te bereiken die zijn afgestemd op hun eisen.

Het compileren van llama.cpp met GPU ondersteuning vereist het configureren van bouwsystemen voor specifieke hardwaredoelen. CUDA ondersteuning vereist NVIDIA stuurprogramma's en installatie van de toolkit, Metal ondersteuning werkt automatisch op macOS met Apple Silicon, en OpenCL biedt een bredere GPU compatibiliteit tussen verschillende leveranciers.

Prestatieoptimalisatie met behulp van geavanceerde hulpmiddelen omvat aangepaste kwantiseringsschema's, optimalisaties van geheugenmapping en gespecialiseerde aandachtsimplementaties. Deze optimalisaties kunnen de inferentiesnelheid aanzienlijk verbeteren en de geheugenvereisten verminderen in vergelijking met algemene oplossingen.

llamafile uitvoerbare bestanden bieden draagbare AI-implementatie door modellen en inferentie-engines te verpakken in afzonderlijke bestanden die zonder installatie worden uitgevoerd. Deze aanpak vereenvoudigt implementatiescenario's waar traditionele installatieprocessen niet haalbaar of wenselijk zijn.

Modelkwantisatietechnieken die beschikbaar zijn via geavanceerde gereedschappen zijn onder andere 4-bits, 8-bits en gemengde-precisieformaten die de modelgrootte verkleinen met behoud van de meeste prestaties. Gebruikers kunnen experimenteren met verschillende kwantisatieschema's om een optimale balans te vinden voor hun specifieke gebruikssituaties.

Een lokale API-server maken

Een lokale API-server biedt de ultieme integratieoplossing voor uw llm-model en zorgt voor naadloze connectiviteit met andere applicaties, terwijl u volledige controle behoudt over uw gegevens en infrastructuur. Zowel LM Studio als Ollama bieden krachtige, ongecompliceerde implementatieopties waarmee u de mogelijkheden van enterprise-grade direct in handen hebt, of u nu de voorkeur geeft aan intuïtieve grafische interfaces of commandoregelprecisie.

Aan de slag gaan betekent dat u de implementatiestrategie van uw voorkeur kiest, LM Studio of Ollama, en deze op uw infrastructuur installeert. Eenmaal geïmplementeerd, downloadt u het llm-model dat perfect aansluit bij uw hardwaremogelijkheden en bedrijfsvereisten, zodat resources optimaal worden benut. Configureer kritieke prestatieparameters zoals contextlengte en ontgrendel GPU-versnellingsmogelijkheden wanneer uw systeem dit ondersteunt, om de hoogwaardige resultaten te leveren die uw toepassingen vereisen.

Het starten van uw lokale API-server kan niet eenvoudiger: LM Studio biedt server activatie via een intuïtieve instellingen interface, terwijl Ollama terminal-gebaseerde controle biedt voor maximale operationele flexibiliteit. Uw API-server werkt op een speciale poort, klaar om verzoeken van uw applicaties te verwerken en gegenereerde tekstreacties te leveren met betrouwbaarheid en snelheid op bedrijfsniveau.

Als je lokale API-server operationeel is, krijg je de vrijheid om aangepaste chatbots te bouwen, complexe workflows te automatiseren en geavanceerde taalmogelijkheden rechtstreeks in je software-ecosysteem te integreren, en dat alles met behoud van volledige gegevensbeveiliging en met de garantie dat je llm-model volledig binnen je eigen gecontroleerde omgeving werkt. Dit is meer dan alleen een technische installatie; het is uw toegangspoort tot schaalbare, veilige en geavanceerde taalverwerkingsmogelijkheden.

Uw lokale LLM beveiligen met een API-sleutel

Het beveiligen van de toegang tot je lokale llm is niet alleen essentieel, het is de basis die je AI-implementatie verandert van een potentiële kwetsbaarheid in een fort van gecontroleerde innovatie. Als je meerdere applicaties of gebruikers met elkaar verbindt, wordt het implementeren van een api-sleutelsysteem je strategie die het spel verandert. Zo zorg je ervoor dat alleen geautoriseerde verzoeken de kracht van je model kunnen ontsluiten en houd je ongeautoriseerde toegang op afstand.

Verander uw beveiligingsaanpak door unieke api-sleutels te genereren voor elke applicatie of gebruiker die de mogelijkheden van uw lokale llm benutten. Bewaar deze digitale sleutels als kostbare activa in omgevingsvariabelen of versleutelde configuratiebestanden en voorkom zo dat ze per ongeluk openbaar worden gemaakt, waardoor je concurrentievoordeel in gevaar komt. Configureer je lokale api-server om api-sleutelvalidatie te vragen bij elke aanvraag, zodat er een ondoordringbare barrière ontstaat die pogingen tot ongeautoriseerde toegang blokkeert nog voordat ze bij je aan de deur kunnen kloppen.

Verhoog je beveiligingsstrategie door je api-sleutels regelmatig te roteren om het risico op een mogelijke inbreuk te verkleinen, en neem doortastende maatregelen om sleutels in te trekken die je niet meer nodig hebt of die mogelijk gecompromitteerd zijn. Door deze toonaangevende praktijken te omarmen, behoudt u niet alleen de controle, maar verkrijgt u volledige controle over uw lokale llm, waarbij zowel uw waardevolle model als elk stukje gevoelige gegevens die het met compromisloze precisie verwerkt, worden beschermd.

Praktische toepassingen en gebruikscases

Het lokaal draaien van llms maakt talloze praktische toepassingen mogelijk in professionele en persoonlijke contexten. De combinatie van privacy, onbeperkt gebruik en offline mogelijkheden opent mogelijkheden die clouddiensten niet kunnen bieden.

Het genereren van code en debuggen zijn primaire use cases voor lokale ai. Modellen zoals DeepSeek-Coder en Code Llama blinken uit in het begrijpen van programmeercontexten, het genereren van boilerplate-code, het uitleggen van complexe algoritmen en het voorstellen van bugfixes in meer dan 80 programmeertalen.

Workflows voor het maken van inhoud profiteren van de onbeperkte generatiemogelijkheden van lokale modellen. Blogberichten, e-mails, marketing kopij en sociale media-inhoud kan iteratief worden gegenereerd zonder API-kosten of tariefbeperkingen. De mogelijkheid om lokale modellen nauwkeurig af te stemmen op specifieke schrijfstijlen voegt personalisatie onmogelijk met cloudservices.

Taken voor gegevensanalyse en -samenvatting maken gebruik van het vermogen van lokale modellen om gevoelige informatie te verwerken zonder externe overdracht. Financiële rapporten, juridische documenten, medische dossiers en eigen onderzoek kunnen worden geanalyseerd met behoud van volledige vertrouwelijkheid.

Taalvertaling zonder externe diensten biedt privacy voor gevoelige communicatie terwijl tientallen talenparen worden ondersteund. Lokale modellen verwerken de vertaling van technische documentatie, meertalige klantenondersteuning en internationale bedrijfscommunicatie volledig offline.

Voorbeelden uit de praktijk zijn advocatenkantoren die lokale modellen gebruiken voor documentanalyse, softwarebedrijven die AI-gestuurde codeerassistenten implementeren en contentmakers die gepersonaliseerde schrijftools ontwikkelen. Elk van deze oplossingen draait lokaal op de hardware van de gebruiker, waardoor privacy en controle gewaarborgd zijn. Deze toepassingen tonen de veelzijdigheid en praktische waarde van lokale ai inzet.

Prestatieoptimalisatie en probleemoplossing

Het maximaliseren van de prestaties van lokale llms vereist inzicht in systeembronnen, modeleigenschappen en optimalisatietechnieken. Een juiste configuratie kan de reactietijden drastisch verbeteren en grotere modellen op bescheiden hardware mogelijk maken.

Het instellen van GPU-versnelling verschilt per leverancier, maar omvat over het algemeen het installeren van de juiste stuurprogramma's en het configureren van software om de beschikbare hardware te herkennen. NVIDIA gebruikers moeten CUDA toolkit installeren, terwijl AMD gebruikers ROCm moeten installeren op ondersteunde Linux distributies.

Modelkwantisatie vermindert de geheugenvereisten door modelparameters op lagere precisieniveaus op te slaan. 4-bits kwantisatie vermindert de modelgrootte met 75% met behoud van 95%+ kwaliteit, waardoor grote modellen toegankelijk worden op consumentenhardware met beperkt video-ram.

Veelvoorkomende foutmeldingen en hun oplossingen zijn onder andere:

- “CUDA heeft geen geheugen meer: Model verkleinen, andere toepassingen sluiten of CPU offloading inschakelen

- “Laden van model mislukt: Controleer de integriteit van het modelbestand en voldoende schijfruimte

- “Trage inferentiesnelheid”: GPU-acceleratie-instellingen controleren en modelkwantisering overwegen

Het monitoren van bronnen tijdens inferentie helpt bij het identificeren van knelpunten en het optimaliseren van configuraties. Task Manager op Windows, Activity Monitor op macOS of htop op Linux onthullen CPU-gebruik, geheugengebruik en GPU-activiteitspatronen tijdens het uitvoeren van het model.

Aanpassingen aan de temperatuur en de samplingparameters beïnvloeden de uitvoerkwaliteit en -snelheid. Lagere temperaturen produceren consistentere uitvoer, terwijl hogere waarden de creativiteit verhogen. Top-k en top-p bemonsteringsparameters zorgen voor een balans tussen responsdiversiteit en coherentie.

Optimalisatie van de lengte van de context balanceert geheugengebruik met conversatiemogelijkheden. Langere contexten maken geavanceerdere interacties mogelijk, maar vereisen verhoudingsgewijs meer geheugen. De meeste gebruikssituaties werken goed met contexten van 2048-4096 token.

Beste praktijken voor lokale LLM-instellingen

Om maximale waarde uit uw lokale llm te halen, hebt u een winnende strategie nodig die zowel topprestaties als kogelvrije beveiliging levert. Begin met het selecteren van het perfecte model voor uw unieke behoeften, duik diep in de modelparameters, formaatspecificaties en gerichte toepassingen om de ideale match voor uw hardwaremogelijkheden en specifieke gebruikseisen te ontdekken.

Verbeter je installatie door kritieke modelparameters zoals contextlengte nauwkeurig af te stellen en GPU-versnelling waar mogelijk te activeren om prestatieniveaus te bereiken die de game veranderen. Zorg ervoor dat je besturingssysteem vlekkeloos compatibel is met de door jou gekozen tools en llm-modellen, terwijl je je hele systeem en software-stack up-to-date houdt om gebruik te maken van de nieuwste baanbrekende functies en geavanceerde beveiligingsverbeteringen.

Blijf knelpunten voor door actief uw systeembronnen te controleren, RAM en GPU gebruik bij te houden om prestatieversperringen te voorkomen, vooral bij het implementeren van grotere modellen of het parallel uitvoeren van meerdere modellen. Transformeer uw workflow met intuïtieve grafische interfaces zoals LM Studio of GPT4All voor een moeiteloze gebruikerservaring die modelbeheer en optimalisatie van instellingen ongelooflijk eenvoudig maakt.

Bescherm wat belangrijk is, bewaar gevoelige gegevens altijd binnen uw lokale omgeving en loop nooit het risico vertrouwelijke informatie via internetkanalen te verzenden. Test en evalueer voortdurend verschillende modellen om te garanderen dat u de optimale oplossing voor uw specifieke toepassing gebruikt en omarm de flexibiliteit om af te stemmen of over te stappen op nieuwe modellen naarmate uw vereisten groeien en evolueren.

Door deze bewezen best practices te implementeren, creëer je een lokale llm-omgeving die veilig, bliksemsnel en nauwkeurig gekalibreerd is om uitstekende resultaten te leveren die jouw unieke vereisten overtreffen en uitzonderlijke resultaten stimuleren.

Kostenanalyse: Lokale vs. Cloud AI-diensten

Inzicht in de economische aspecten van lokale versus cloud AI-diensten helpt om weloverwogen beslissingen te nemen over investeringen in infrastructuur. De analyse omvat initiële hardwarekosten, doorlopende kosten en break-evenberekeningen op basis van gebruikspatronen.

De initiële investering in hardware voor capabele lokale ai systemen varieert van $800-1.500 voor mid-range configuraties tot $3.000-5.000 voor high-end setups. Deze kosten omvatten moderne CPU's, voldoende RAM, geschikte GPU's en voldoende opslagruimte voor meerdere modellen.

De maandelijkse abonnementskosten voor cloud AI-diensten variëren sterk: ChatGPT Plus kost $20/maand, Claude Pro kost $20/maand, en API-gebruik kan variëren van $10-500+ per maand, afhankelijk van het volume. Enterprise-plannen overschrijden vaak $100/maand per gebruiker.

Een break-even analyse laat zien dat matige tot zware gebruikers hardware-investeringen meestal binnen 6-18 maanden terugverdienen. Gebruikers die gevoelige gegevens verwerken of 24/7 beschikbaarheid vereisen, rechtvaardigen vaak een lokale infrastructuur, ongeacht pure kostenoverwegingen.

De energiekosten voor het draaien van lokale modellen zijn ongeveer $30-100 maandelijks hoger dan de elektriciteitsrekening, afhankelijk van de hardware-efficiëntie en de lokale energietarieven. Moderne GPU's hebben energiebeheerfuncties die het verbruik tijdens inactieve perioden verminderen.

Berekeningen van de totale eigendomskosten over 2-3 jaar geven over het algemeen de voorkeur aan lokale oplossingen voor:

- Gebruikers met matige tot zware AI-gebruikspatronen

- Organisaties die de privacy van gegevens moeten naleven

- Toepassingen met gegarandeerde beschikbaarheid

- Teams die onbeperkt willen kunnen experimenteren

Clouddiensten blijven voordelig voor:

- Incidentele gebruikers met een minimaal maandelijks volume

- Teams die toegang nodig hebben tot geavanceerde modellen

- Organisaties zonder IT-infrastructuurexpertise

- Toepassingen die naadloos moeten kunnen schalen

Bij de beslissing spelen vaak niet-financiële factoren een rol, zoals privacyvereisten, gegevenssoevereiniteit, betrouwbaarheid van internetverbindingen en organisatorische controlevoorkeuren die de balans doen doorslaan naar lokale implementatie ondanks hogere initiële kosten.

Lokale grote taalmodellen vertegenwoordigen een fundamentele verschuiving naar een gedemocratiseerde, particuliere en kosteneffectieve inzet van AI. Naarmate de modellen efficiënter worden en de tools gebruiksvriendelijker, neemt de drempel voor toegang steeds verder af terwijl de mogelijkheden snel toenemen.

Of u nu een ontwikkelaar bent die hulp zoekt bij het coderen, een bedrijf dat gevoelige gegevens beschermt of een enthousiasteling die de AI-mogelijkheden verkent, het lokaal draaien van llms biedt ongekende controle over uw AI-ervaring. Begin met gebruiksvriendelijke tools zoals LM Studio of GPT4All, experimenteer met verschillende modellen om uw ideale balans tussen mogelijkheden en prestaties te vinden en breid uw set-up geleidelijk uit naarmate de behoeften veranderen.

De toekomst van AI hoort niet alleen thuis in enorme datacenters, maar op je eigen hardware, onder jouw volledige controle. Download vandaag nog uw eerste lokale model en ervaar de vrijheid van zelf gehoste kunstmatige intelligentie.

Inleiding tot lokale AI

Local AI is een revolutie in de manier waarop individuen en organisaties kunstmatige intelligentie gebruiken door de volledige kracht van grote taalmodellen direct op je eigen computer te zetten. In plaats van afhankelijk te zijn van cloud-gebaseerde diensten, betekent het lokaal uitvoeren van llms dat alle verwerking op je apparaat gebeurt, waardoor je volledige controle hebt over de modelparameters en hoe er met je gevoelige data wordt omgegaan. Deze aanpak verbetert niet alleen de privacy, omdat uw gegevens nooit uw machine verlaten, maar vermindert ook de latentie, waardoor reacties sneller en betrouwbaarder zijn dan ooit tevoren.

Met lokale ai kun je grote taalmodellen afstemmen op jouw unieke behoeften, of je nu optimaliseert voor specifieke taken of experimenteert met verschillende configuraties. Door llms lokaal uit te voeren, kunt u modellen aanpassen, updates beheren en oplossingen inzetten die perfect op uw workflow zijn afgestemd, terwijl uw informatie volledig veilig blijft. Naarmate meer gebruikers de waarde van lokale implementatie ontdekken, blijft het ecosysteem van tools en modellen zich snel uitbreiden, waardoor het eenvoudiger dan ooit wordt om de mogelijkheden van state-of-the-art grote taalmodellen te gebruiken op je eigen computer.

Aan de slag met lokale LLM's

Het starten van uw lokale LLM reis is nog nooit zo toegankelijk geweest, dankzij de baanbrekende tools en een groeiend ecosysteem van krachtige modellen binnen handbereik. Begin met het kiezen van een platform zoals LM Studio of Ollama, beide ontwikkeld om het proces van het uitvoeren van LLM's direct op uw machine te vereenvoudigen en te stroomlijnen. Deze oplossingen bieden gebruiksvriendelijke ervaringen op maat van uw voorkeuren - LM Studio met zijn intuïtieve grafische interface en Ollama met zijn efficiënte opdrachtregelaanpak - zodat u de workflow kunt kiezen die perfect aansluit bij uw technische comfortzone.

Nadat je het platform van je voorkeur hebt geïnstalleerd, maak je gebruik van de geïntegreerde zoekfunctie om moeiteloos te bladeren door beschikbare modellen uit vertrouwde repositories zoals Hugging Face. Download het door u gekozen modelbestand rechtstreeks naar uw lokale opstelling, met gegarandeerde ingebouwde hardwarecompatibiliteit. Eenmaal geconfigureerd kun je de lokale inferentieserver activeren, zodat je met je model kunt werken via de grafische interface of via de opdrachtregel. Deze krachtige opstelling biedt de flexibiliteit om met meerdere modellen te experimenteren, uw lokale LLM ecosysteem efficiënt te beheren en te profiteren van alle voordelen van lokale verwerking zonder afhankelijk te zijn van externe cloudinfrastructuur.

De lokale inferentieserver instellen

Een lokale inferentieserver is de baanbrekende ruggengraat van het lokaal draaien van llms, die u in staat stelt om uw gekozen modellen in te zetten, te beheren en ermee te werken in een dramatisch efficiënte en veilige omgeving. Revolutionaire tools zoals LM Studio en Ollama maken het opzetten van een lokale inferentieserver ongelooflijk gestroomlijnd - zelfs gebruikers die helemaal nieuw zijn met AI kunnen krachtige resultaten behalen. Om dit potentieel te ontketenen, selecteert u gewoon het gewenste modelbestand en configureert u essentiële parameters zoals contextlengte en, indien beschikbaar, schakelt u GPU-versnelling in voor explosieve prestatieverbeteringen.

Ollama biedt geavanceerde functies zoals GPU-versnelling, die modelinferentie op compatibele hardware drastisch kan versnellen en uw workflow volledig kan veranderen. U krijgt volledige controle door de exacte poort voor uw inferentieserver op te geven, waardoor deze moeiteloos toegankelijk is via web ui of naadloos integreert met andere toepassingen voor maximale flexibiliteit. LM Studio biedt een net zo gestroomlijnde setup, waarmee u modellen en serverinstellingen kunt beheren via een intuïtieve, gebruiksvriendelijke interface. Als uw lokale inferentieserver operationeel is, beschikt u over een krachtige, volledig private omgeving om llms lokaal uit te voeren en de volledige, onbeperkte mogelijkheden van de door u gekozen modellen te benutten.

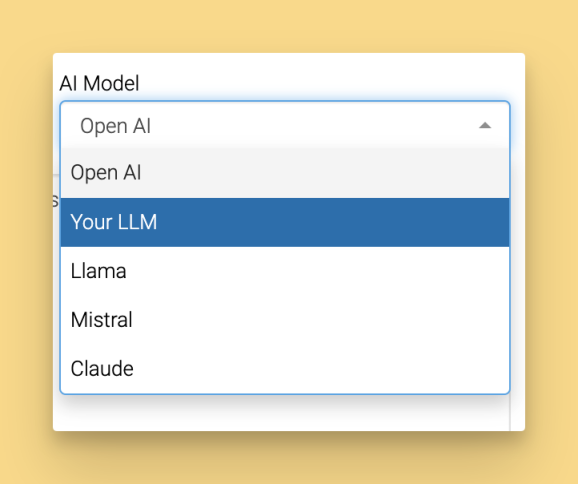

Lokaal LLM's uitvoeren met populaire tools

Het kiezen van de juiste tool is de sleutel tot het ontsluiten van een naadloze ervaring wanneer u llms lokaal uitvoert. LM Studio, Ollama en GPT4All behoren tot de meest vertrouwde oplossingen, elk met unieke mogelijkheden die zijn ontworpen om aan uw specifieke workflowbehoeften te voldoen. LM Studio stelt u in staat met zijn intuïtieve grafische interface, waardoor u moeiteloos meerdere modellen kunt beheren, naadloos tussen ze kunt schakelen en instellingen kunt afstemmen om optimale resultaten te bereiken die belangrijk zijn voor uw projecten. Voor degenen die goed gedijen in terminalomgevingen levert Ollama een robuuste opdrachtregelervaring die uw geavanceerde workflows ondersteunt en feilloos integreert met uw ontwikkelecosysteem.

GPT4All is een andere krachtige keuze in je gereedschapskist en ondersteunt een uitgebreide reeks modellen, waaronder populaire opties zoals Mistral 7B, terwijl het je een gestroomlijnde interface biedt voor interactie met je lokale ai. Deze platforms draaien niet alleen modellen, maar stellen je ook in staat om moeiteloos api-servers op te zetten, zodat een naadloze integratie met je bestaande applicaties en services mogelijk is. Of je nu meerdere modellen beheert, experimenteert met fijnafstemming of net begint met lokale helpsystemen, deze platforms bieden de flexibiliteit en kracht die je nodig hebt om het maximale uit je lokale ai te halen.

Een lokale API-server maken

Het opzetten van een lokale api-server is de ultieme game-changer voor iedereen die op zoek is naar een revolutie in de integratie van grote taalmodellen in applicaties en workflows! Met krachtige tools zoals LM Studio en Ollama wordt het creëren van uw gepersonaliseerde lokale api-server ongelooflijk eenvoudig: specificeer gewoon het door u gekozen modelbestand, stel uw beveiligde api-sleutel in voor maximale bescherming en configureer de server op de door u gewenste poort. Deze geavanceerde setup geeft u toegang tot uw modellen via een intuïtieve webinterface of programmatisch via de api-server, en ontsluit een onbeperkt aantal praktische toepassingen die uw manier van werken transformeren.

Ollama levert naadloze api server integratie direct uit de doos, waardoor het moeiteloos is om uw lokale llms te verbinden met andere tools en platformen voor maximale efficiëntie. LM Studio biedt even indrukwekkende mogelijkheden, waardoor u uw lokale api server kunt beheren via een prachtige gebruiksvriendelijke interface die u de volledige controle geeft. Door uw eigen lokale api-server te maken, krijgt u een ongeëvenaarde flexibiliteit om modellen in te zetten in echte scenario's, complexe taken te automatiseren en aangepaste oplossingen te bouwen die perfect passen bij uw behoeften - en dat alles terwijl uw waardevolle gegevens volledig veilig en onder uw absolute controle blijven. Of u nu baanbrekende toepassingen ontwikkelt of bestaande workflows verbetert, een lokale api-server is de sleutel tot het ontsluiten van het buitengewone potentieel van uw lokale ai infrastructuur.